TikTok 也曾经很在乎那一万个新增用户

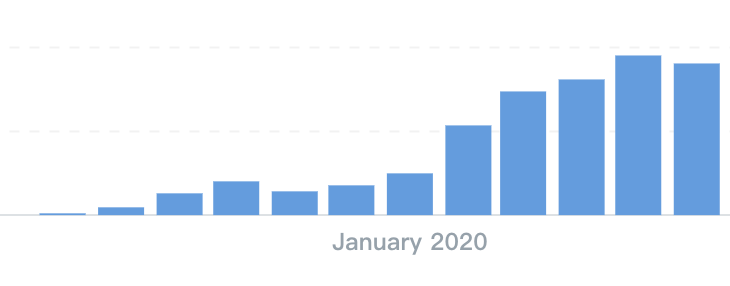

我们团队的 Piaf 在 2017 年的时候在字节工作过,那时候抖音刚刚起步,Tiktok 的 DAU 则和现在的独响一样多,或者说一样少。她负责了 TikTok 在多个国家的整体工作,因此,从足够立体的视角,她几乎完全见证了 TikTok 从 0 到千万日活的那个时期,对绝大部分互联网从业者来说,有这样的经验绝非易事,事实上,过去几年,能够从 0 开始,最终成长为 TikTok 和抖音这样体量的产品,一只手都数得过来。

风起青萍之末,我对那段时期的 TikTok 充满好奇,所以老爱问 Piaf 那个时期到底发生了什么,每天工作是什么,几点下班,公司管不管饭之类的问题。

我得到了很多回答,也从这些回答中拼凑出一个遥远又模糊的印象,那是字节从头条构筑的坡道起跳,跃出前所未有的第二曲线的初始时刻,无数的流量,无数的用户,都是从那个时刻开始的。

经常会有人试图分析抖音和 TikTok 的成功,这常常出现两种论调,一种认为字节的成功是大力出奇迹的结果,再加上好的运气,没有什么特别的地方,谁拿着这么多钱去烧都可以,另一种则正好相反,认为其成功充满了天才的设计,巧妙的运筹,以及极致的理性分析,换言之,使用这个策略,并把推荐算法做到极致,那么就一定可以做成。

事实如何,我当然没有资格评判。但我总会想到我和 Piaf 的一次聊天,那次快下班了,我问她,当年做了什么事情让 TikTok 有了很大的增长,她想了一下,说对口型算一个。

我对这个事情也有一些记忆,当年还有类似小咖秀之类的短视频产品,是有那么一阵儿,对口型的视频风靡,从国内到国外,很多人都爱拍对口型的视频,然后发到短视频平台。

我继续问她,那带来了多少用户,她回答,差不多一天有一万的新增用户。

我有点吃惊,向她确认,确实是一万的新增,不是一百万,或者五十万。作为 TikTok 多个国家的负责人,她认为这一天一万的新增很重要,八年过去了,依然记忆犹新。

我理智上很清楚,任何产品获得一万的日新增,都不是一件特别容易的事情,但那是 TikTok,一个现在每天有十亿人在使用的产品,几年前,那一万的新增依然对它很重要。

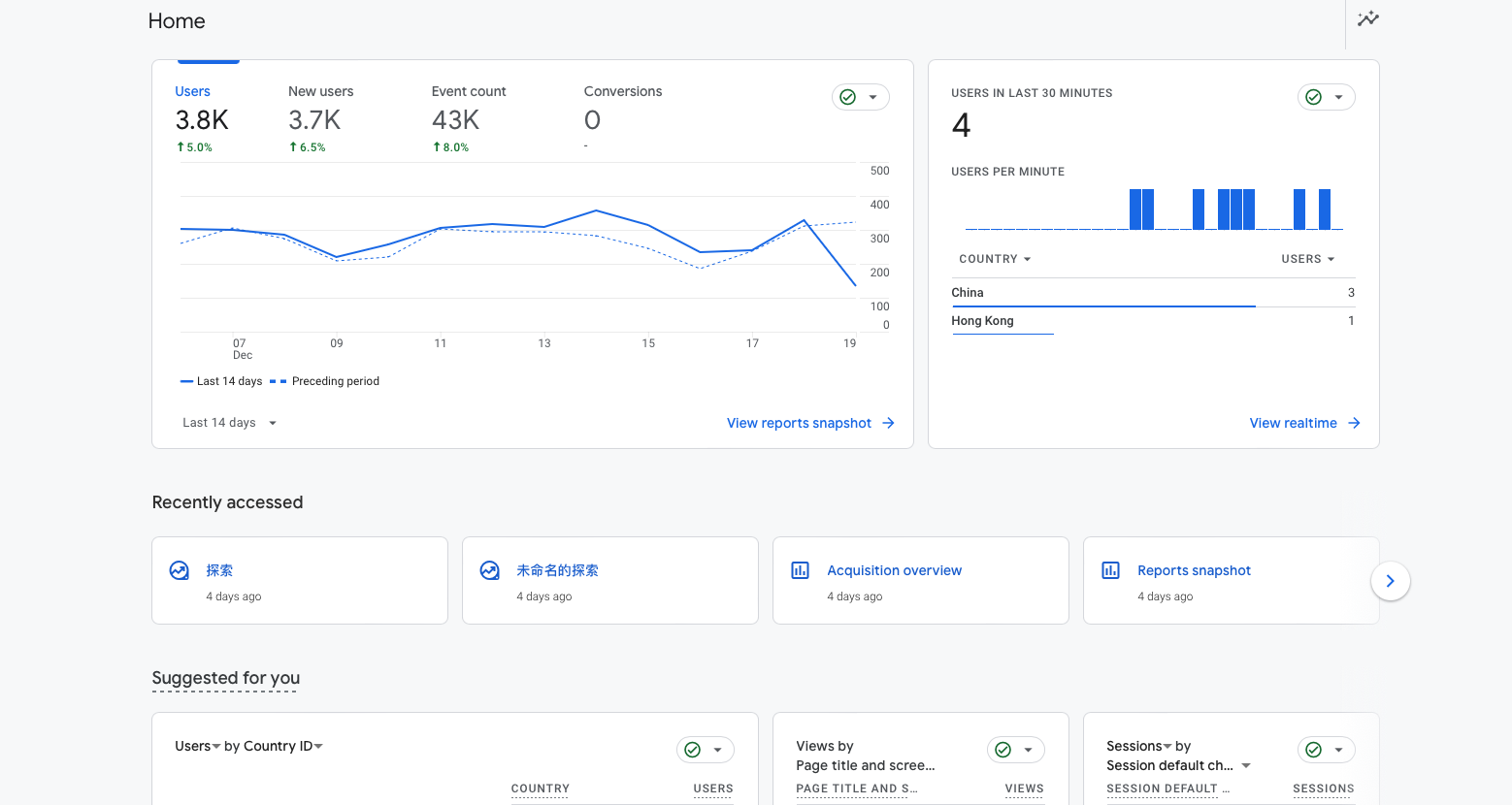

我们自己做到过很多次自然增长单日过万的时候,在今天的 AI 赛道,大一个或者几个量级的增长也在媒体的文章中屡见不鲜,以至于我们似乎都习惯了一发冲天,一朝闻名,一腔热血以及一命呜呼。

我像关心皇帝怎么用金锄头锄地的老农民,继续询问当时她和团队还做了什么,为什么 TikTok 后面涨的那么好?在字节从 0 到 1 是什么感觉,她想了很久,说要再去看看当年的聊天记录,深夜,她发来了一段话:

原来当时我们那么痛苦,那么迷茫。

后来被我们称作“一飞冲天”的那段路,在当时的每一天里,走得都极其狼狈。

只是时间和结果太擅长粉饰苦难。

2017 年,我刚加入 TikTok,那时候谈不上什么全球化,也没有什么宏大叙事,整个海外业务几乎是从荒地里长出来的。两个 PM,带着一群应届生做运营,连后台的英文翻译都经常错得离谱。最早的“全球化”,其实是从给产品做英文校对开始的。

所以你们那时候是怎么做冷启动的?我在工位换了个问题问她

她扶着头笑了一下说,那时海外各国 DAU 都不到 1 万,冷启动冷到我们每天最大的工作,是从各个视频平台海量抓内容、去水印、删字幕,再重新分发。爬虫内容一度占了绝对大头。与此同时,我们一边签本土达人,一边用影子账号同步抖音、韩国 TikTok 的明星视频,小心翼翼地测试对本土生态的影响。

你们当时每天干的事情是啥呢?我继续追问

一边拉达人、做挑战、催投稿;一边在后台一条条复审视频,控制画风;一边还要盯着竞对,比如某竞对海外版今天又冲榜了,明天又挖人了。

Piaf 继续补充:而我们自己内部,也是一团糟。事情永远干不完,情绪却永远先爆。撕逼、崩溃、失眠是常态。

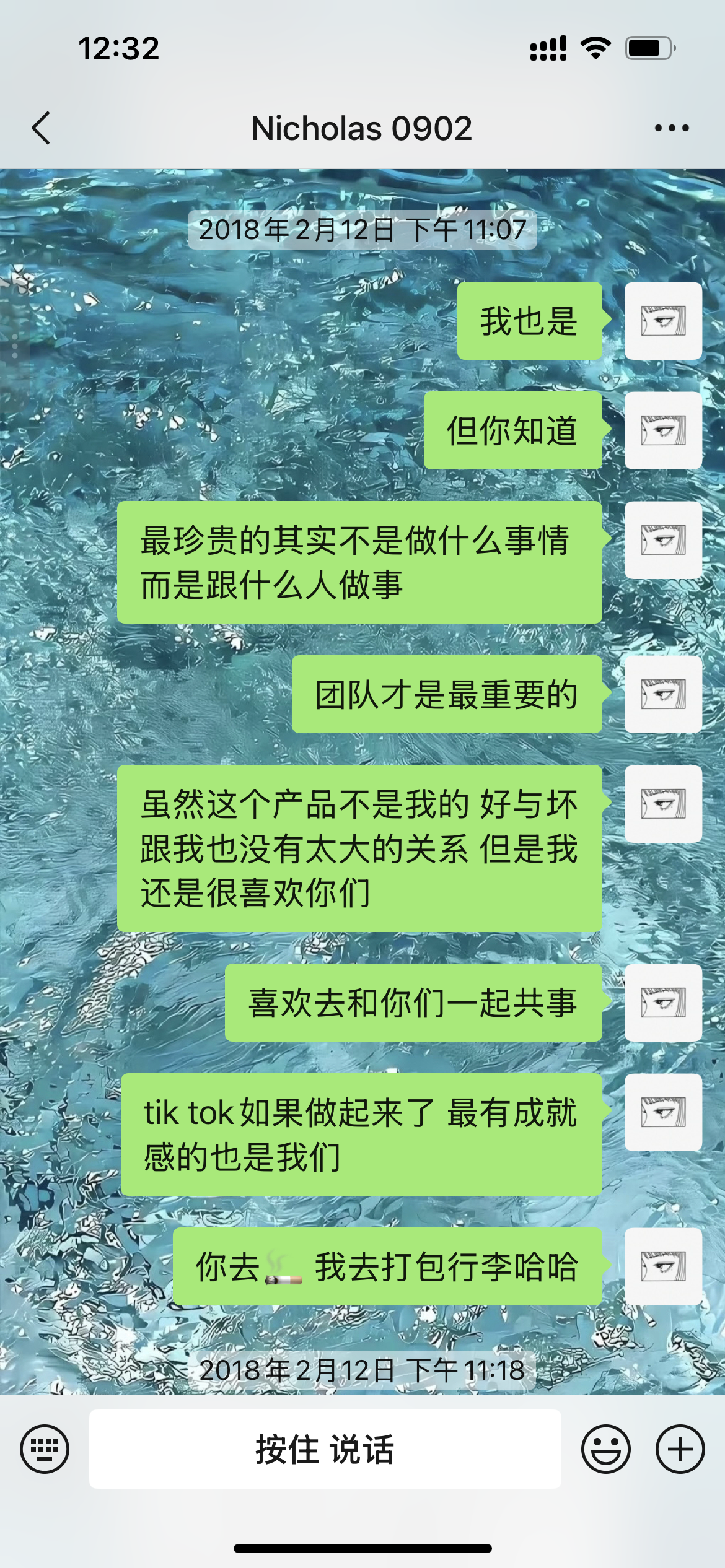

2018 年,Piaf 要去越南做调研,她的一位海外同事 Nicholas 在临行前一晚跟她说,他有点想离职了。此前,他们已经并肩作战了很久,Piaf 把当晚的聊天记录发给我了,她当时是这么对 Nicholas 说的

![]()

「后来我再也没对任何团队说过这么肉麻的话。」Piaf 补充了一下。

不久之后,越南 TikTok 的 DAU 达到了 30 万,很快又破百万,越南成为 Piaf 团队又一个「启动完成」的市场,对于这段经历,我给足了情绪价值,并且发自内心的佩服,Piaf 又开始继续说:

我们仍然没日没夜地审核视频、控画风,通过影子账号同步抖音优质达人的内容,我们明显感受到——中国流行文化对越南的影响,远远超过其他国家。

于是我们做了一个在当时很“野”的决定:

把抖音的头部达人,直接拉到越南,和本土达人线下 PK。那是 TikTok 第一次在越南办大型线下活动,也是第一次跨国 KOL 正式互动。

参与的达人里,就有当时最火的张欣尧。

我们谁都不知道,这次活动后来会成为全球 KOL 联动 PK 的开端。

活动当天异常成功。线上一整波优质内容被彻底点燃。

但我和 Nicholas 一整天都没吃上饭,直到半夜才在路边小摊坐下。

就在我们扒着粉的时候,手机弹出消息:

kwai 冲榜了。

新的战斗又要开始了。

4 月,我们上线了合拍功能,叠加一系列挑战活动,投稿率被硬生生拉了上去。

与此同时,快手海外版开始疯狂挖我们合作的每一个明星和达人,甚至包括 Nicholas。

我知道他很难。但我也知道,他对这个团队的感情,远远大于那些诱惑。

5 月,越南本土竞对 Muvik 下架。少了一个敌人,我们却并不轻松。

7 月,《延禧攻略》在国内和越南爆火。我们做了多个国家和地区的联动活动,整个暑期的内容创作被拉爆。同一时间,火山海外版Vigo 放弃东南亚市场,他们的运营并入 TikTok。

越南团队越来越大。事情却从来没有变少。

我们还是会在深夜崩溃,还是会在凌晨怀疑人生。

但就在这样的疲惫和混乱中,越南的内容生态,一点点被堆了起来。

越南留存,从 35% 一路涨到 55%,成为海外 TikTok 留存最高的国家,也在印尼下架后,成为新的增长曲线。

但那时的我们,从未抬头看这些东西。

我们只是低头往前冲。

我捕捉到一个信息,印尼下架,我总是对互联网产品的磨难充满好奇,于是开始询问她关于被下架的故事,她则再次展开了叙述。

2018 年 6 到 7 月,TikTok 在印尼被政府整整下架了两个月。

而那时候,印尼是全球增速最快、体量最大的国家。

600 万 DAU,一夜归零。

我是印尼、越南和泰国的国家产品。这个锅,我没有任何可以躲的空间。

我们查流程,查人,查机制,甚至一度怀疑是某个环节被“人为放水”,但始终没有抓到真正的源头。

等到我们彻底确认的时候,已经晚了。

而那个时候的我们连一个完整的海外政府关系团队都还没有。

于是禁令就这样下来了。

没有预告,没有缓冲,没有商量的余地。

我到现在都记得,看到消息的那一刻,我并没有太强烈的情绪,

只是突然意识到一件很残酷的事:

原来你拼了这么久搭起来的东西,在某一个你根本来不及反应的时刻,是可以被整个世界按下暂停键的。

那两个月,我几乎没怎么睡过一个完整的觉。

后来把时间拉长了看,我才慢慢承认一件事: 这一刀,或许反而救了我们。

正是从印尼被封开始, 我们第一次真正意识到—— 在海外市场,GR 和 PR 不是锦上添花,是生死线。

海外政府关系团队,就是从那时开始正式搭建的。其他国家也陆续全面收紧标准。如果没有印尼这次的代价,后面只会有更大的事故等着我们。

我们聊到此时,窗外已经一片夜色,办公室依然明亮,她停顿了很久,又继续说

只是这些是理性正确而已。那段时间,Nicholas 几乎每天都会找我聊天。

他说:“反正不管在哪个国家,我们都是在趟一条没人走过的路。”

我当时回他:“是啊,只不过有的坑,是用百万用户换来的。”

他发了一个沉默的表情。

后来很多人只记得 TikTok 在越南的高留存,在印尼的反弹,在东南亚的全面起飞。

却很少有人再提,那两个月的「消失」。

而我也很少再对别人讲起,那是我职业生涯里最无力的一段时间。

聊到此时我们都有点饿了,于是开始点了楼下的肯德基。我记得很清楚,那天肯德基出现了一个新品叫「薄脆金沙鸡翅」,我们点了几块,都觉得非常好吃,没想到第二天这个鸡翅就从肯德基下架了,直到现在依然没有上架。这是个题外话,但是我写到这里的时候依然非常想念薄脆金沙鸡翅。

后来的事情所有人都知道了,当推荐算法的巨石已经高悬山巅,滚落时的动能自然无人能挡,但那颗巨石是被推上去的,那一万个新增用户,那些全世界的奔波,以及无数手动对新视频的调整,设置,选择,共同带来了那种势能。除此之外,还有无数深夜的EMO,错乱的节奏,介于“快撑不住”和“再扛一下”的中间地带,它们统统消解于一飞冲天的成功故事的光芒余晖里。

我们看到一个结果,往往会选择美化故事,或者简化过程,所以我以前对任何复盘都带有审慎的眼光,但现在我的心态略有变化,美化也好,简化也罢,我们并不需要还原全部的真相——我也认为后来者其实无论如何都没办法真正意义上的还原真相,只要能够从中获取到某一点,这一点让人心有所感,那它就已经完成了对我们的教化。

对我而言,从 Piaf 的视角重新了解之前发生的这些事情,让我有点羡慕字节,这不是因为字节产品多厉害,多赚钱什么的,而是因为在最开始的时候,确实有一个朝气蓬勃,充满干劲,又愿意跳进水里扑腾的团队,这个团队包括 Piaf,包括卷卷,也包括现在依然在字节,而 Title 已经极高的很多人。

如今,我们身处 AI 的洪流,每天都在谈论算力、模型和涌现,似乎一切都可以被瞬间加速,事实或许确实如此,但死亡也在加速,我们走的道路和之前有所不同,但捷径也许依然不存在——我们需要的是多一点的耐心,找到最好的战友,以及踏踏实实的铆足劲,低头往前冲。

风起于青萍之末,今天依然是青萍之末。