实测豆包 Seedance 1.5 Pro:哪吒朱迪在线飙戏,复刻名场面,AI台词、音效水平大更新

![]()

AI 视频最近的玩法特别多,颇有上半年 AI 生图火起来的那种感觉。

▲ 视频来源:https://x.com/pabloprompt/status/2000706593579573301/

之前火过一遍的 AI 探班视频,随着模型能力的提升,现在又开始变成了社交媒体上的热门玩法。

不过彻底摒弃了以往复杂的工作流,有更好用的模型,甚至是简单几句提示词就能复刻,视频里的同款真实感。

视频生成模型的优化,不断地在降低,对我们人类提示词工程的依赖,同时还带来了更稳定的一致性保持。

![]()

豆包最近更新了新一代的音视频生成模型,豆包 Seedance 1.5 Pro,在音视频的生成上也有了明显的改善。现在它生成的视频,支持中文、英文、日文、韩语、西班牙语等语种的不同声韵,同时针对中文场景,还能生成四川话、粤语等方言。

不仅能说,而且还能模仿不同语言的口音。有声视频是 Seedance 1.5 Pro 的一大突破,在视频生成本身,结合音频的音画同步,以及电影级的运镜两项优化,让 AI 视频看起来更真实、更细致。

目前该模型已上线豆包 APP,只需要打开豆包,点击「照片动起来」,选择 1.5 Pro 模型,就能体验到 AI 生视频的快乐。此外,在火山引擎体验中心、即梦 AI 也可以体验。

我们也提前测试了一波,Seedance 1.5 Pro 完全可以说,是现在手边能拿起来直接用,能同时融合声音,表现最好的视频生成模型。

听听「臣妾做不到啊」的原音重现

《疯狂动物城 2 》上映之前,网友们对配音演员的选择,有很大的争议。现在 Seedance 1.5 Pro 的语音生成有多牛,我们可以看看之前网上很火的甄嬛传和让子弹飞,两个视频的配音,让它来完成是什么样。

从网上找了一张影视剧的截图,然后丢给豆包,我们甚至什么提示词都没有输入,它就能做到自动识别视频画面,生成一段有感情的台词戏。

▲在豆包 App 内,使用「照片动起来」,上传首帧,生成视频

皇后和张麻子都演得太像了,这和几个月前的视频生成模型,完全不是一个 Level。 以前那些 AI 视频,口型对不上,或者声音有机械感的问题,现在都解决了。

但普通话对它来说都是基本操作,方言的表现才是 Seedance 1.5 Pro 打败那些国外模型的独门秘籍。就像 Sora 2 和 Google Veo 3.1 虽然在画面生成上被认为是行业领先,但如果把上面这两张首帧图片丢给它们。Sora 和 Veo 3 都理解不了甄嬛传的经典台词,和张麻子这流利的四川话口音。

全运会刚结束,如果你也在广州,一定忘不了「活力大湾区,魅力新广州」这句魔性的口号。我们生成了一张站在广州塔前面的照片,然后在豆包「照片动起来」里面输入提示词。

画面里的这个男生正在面向镜头,向大家介绍他身后的广州塔,他用粤语说「活力大湾区,魅力新广州,我身后面嗰个就系广州塔喇!」

这个粤语水平怎么样,比多邻国里面的早茶四件套,虾饺、肠粉、烧卖、豉汁排骨,听着是不是要舒服一点。

而且,Seedance 1.5 Pro 有一个好处是「视听一致性」,意思是它能根据画面的内容,理解视频想要表达的故事,来自动生成对应的配音。

举个例子,当我们上传了一张明显是外国人的图片时,我们不输入任何提示词,它会自动使用英文来配音,并且让画面里的角色,说合适的台词。

即便是在中餐厅面馆里吃面的威尔·史密斯,Seedance 1.5 Pro 还是让他自动用英文来说话,而且这个吃面姿势也完全对了。

同样地,我们用它复刻了 AI 片场探班的视频,直接上传一张图片给豆包,不输入任何提示词,它会自动用中文来生成视频,还配上了台词,「哇,跟阿凡达合影啦!」

当我们重新生成时,Seedance 1.5 Pro 还把照片里的男生识别成韩国人,然后生成了一段讲韩语的视频。不过,说实话,他确实是有点韩国欧巴的感觉。

豆包视频生成还有一点特别好,是我们可以直接把生成的视频,下载为动图保存在手机。配合现在模型更强大的多模态理解能力,以及能生成更真实的画面,手机里那些静态的图片,让它们「真实地」动起来,然后发到微信朋友圈,可能真的会有人看不出来。

![]()

AI 巨人照加上无人机运镜,太酷啦

叙事是 Seedance 1.5 Pro 更新的一个关键词,它的意思是这些 AI 视频不只是单纯的生成,而是有了一定的故事感,能够对要表达的内容进行理解,让 AI 生成的视频,更像是一个有血肉的作品。

一个好的视频作品,灯光色彩、音效要出色。技术性的工作也少不了,运镜就是在音画之外,不可忽视的镜头语言。

Seedance 1.5 Pro 在这次更新里,在长镜头跟随、希区柯克变焦这些电影级运镜都有了大幅度的提升。

像是之前我们做的子弹时间,现在上传一张图片到豆包,调整一下提示词,子弹时间特效也自由了。

![]()

▲提示词:子弹时间效果。时间完全冻结。舞者悬浮在半空中,对抗重力。[定格画面]:舞者、她的头发和她的蓝色裙子绝对静止,就像时间冻结中的 3D 雕像。摄像机围绕悬浮的舞者水平轨道运行。背景建筑物改变透视(视差),而舞者保持锁定在中心。头发保持僵硬并指向上方,没有飘动。裙子布料是固体的并冻结保持不动。 电影级照明,高质量。

我们把同样的照片交给 Veo 3.1 处理时,它生成的子弹时间也很难做到保持角色一动不动。因为对大多数视频生成模型来说,识别到头发,就一定要飘动;看到裙边也要摆动;所以精准的运镜控制和调度,也是区分不同模型的一项重要能力。

还有这个前段时间很火的 AI 巨人照,现在我们也可以用超酷炫的无人机俯冲和穿越运镜,来凸显视频里的巨人。

![]()

▲提示词:电影级 FPV 无人机镜头,极致动态运镜:从高空鸟瞰开始,无人机急速俯冲向一位坐在城市街道中央的巨人,红砖建筑环绕两侧。巨人保持完全静止的姿势,身体、头部、四肢均不移动,如同雕塑般定格。无人机以特技飞行动作环绕巨人静止的身体——盘旋绕腿、从手臂下穿越、沿躯干螺旋上升,然后拉远展现巨人与微小车辆(红色双层巴士、黑色出租车)和行人的尺寸对比。超写实合成。比例 16:9,时长 5s,模型 1.5 Pro。

从参考图转视频,能更好的控制视频的输出效果。但 Seedance 1.5 Pro 的文生视频能力也毫不逊色。

![]()

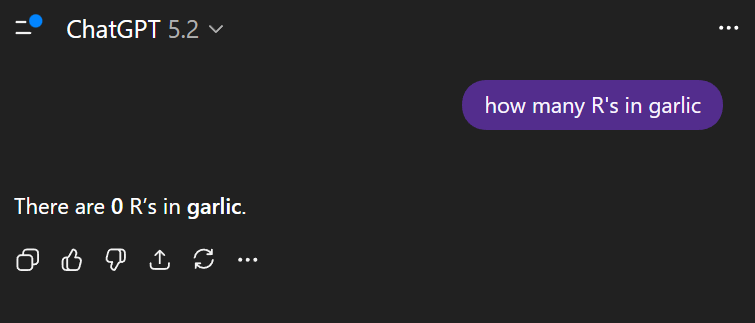

根据字节公开的 Seedance 1.5 pro,在内部基准测试 SeedVideoBench-1.5 的模型表现结果,显示无论是 T2V 文生视频,还是 I2V 首帧转视频,和可灵 2.6、Google Veo 3.1 等模型对比,Seedance 1.5 Pro 的表现都有一定优势。

尤其是在音频生成和音画同步上,Seedance 1.5 Pro 几乎是碾压性的存在。

我们尝试让疯狂动物城朱迪和哪吒一起,一个普通话,一个四川话,演了一出 10s 的小剧场。

▲提示词:[0s-4s] 朱迪指着哪吒说(普通话,语速快,严肃): “那个小孩!站住!双手抱头!根据《动物城交通法》,你刚才风火轮超速了!” • [5s-10s] 哪吒(四川话,翻白眼,语速慢,拖长音): “哎呀,莫挨老子!我是踩的风火轮,又没烧你的油。瓜娃子,管得宽!”

这个视频的风格和内容,和我们平时看的动画片风格真的很类似。当义正辞严的兔朱迪警官,抓到哪吒的时候,那严肃的表情和语气;还有哪吒用四川话说台词,也能对上嘴型。

APPSO 今年前前后后也测试了有十多款 AI 视频生成的模型,我们在使用的过程中,发现很多以前的测试案例,放到现在已经是 Out 了。

一开始是鲁迅来了,都得让他说两句英文;能生成一个 5s 流畅播放的视频,就谢天谢地。现在的模型,不仅支持中、英、日、韩等多语种,广东话、四川话这些特色方言都能同步生成。

恍然间,AI 视频的进化,已经从按年计算变成了按月计算。昨天的突破,今天就是及格线。

![]()

▲ Seedance 1.5 Pro 案例截图|来源:字节跳动 Seed 官网

Seedance 1.5 Pro 这次更新,可能又会变成新的及格线。但至少现在我们看到了,有了音画同步后更有感染力的视频;多语种和方言的支持,也让 AI 视频更有「生活味」;专业的电影级运镜和智能理解能力,让一些高难度的复杂场景,也有机会通过 AI 生成。

当技术能够理解画面背后的故事,自动匹配合适的语言和情绪,我们距离想象力和创作自由的时代,又近了一大步。

实现这一切需要什么? 一张图片或者一句提示词。

打开豆包 APP,上传/输入,生成,就这么简单。每张照片都是待激活的故事,每次上传都是创作的开始。

步骤越少,门槛越低,创作者越多,用 AI 视频实现创意就该是这样。

文章内视频可点击该链接前往观看:https://mp.weixin.qq.com/s/em_E90Q7AdydHsNwVkAMTQ

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。