OpenAI Unveils o3 System That Reasons Through Math, Science Problems

© Jason Henry for The New York Times

© Jason Henry for The New York Times

就在刚刚,OpenAI 迎来了年底 AI 春晚的收官之作。

这次发布的的 o3 系列模型是 o1 的迭代版本,考虑到可能与英国电信运营商 O2 存在版权或商标冲突,OpenAI 决定跳过「o2」命名,直接采用「o3」。

为此,OpenAI CEO Sam Altman 更是自嘲公司在模型命名方面的混乱,原来你也知道呀。

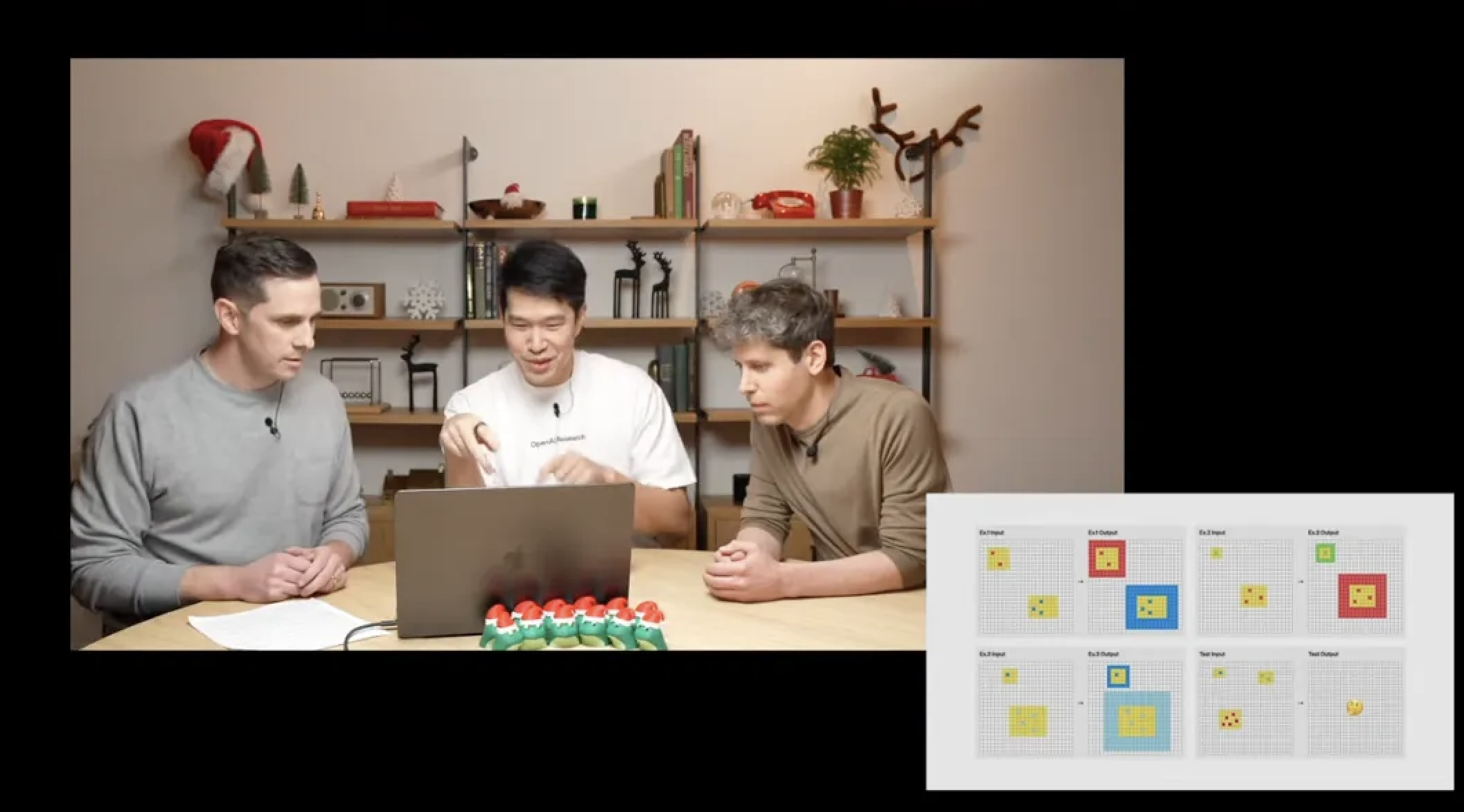

本次发布会由 Sam Altman、研究高级副总裁 Mark Chen 以及研究科学家 Hongyu Ren(任泓宇)主持。

值得注意的是,任泓宇本科毕业于北大,对 o1 有过基础性贡献,也是 GPT-4o 的核心开发者,曾在苹果、微软和英伟达有过丰富的研究实习经历。

o3 系列包含两款重磅模型:

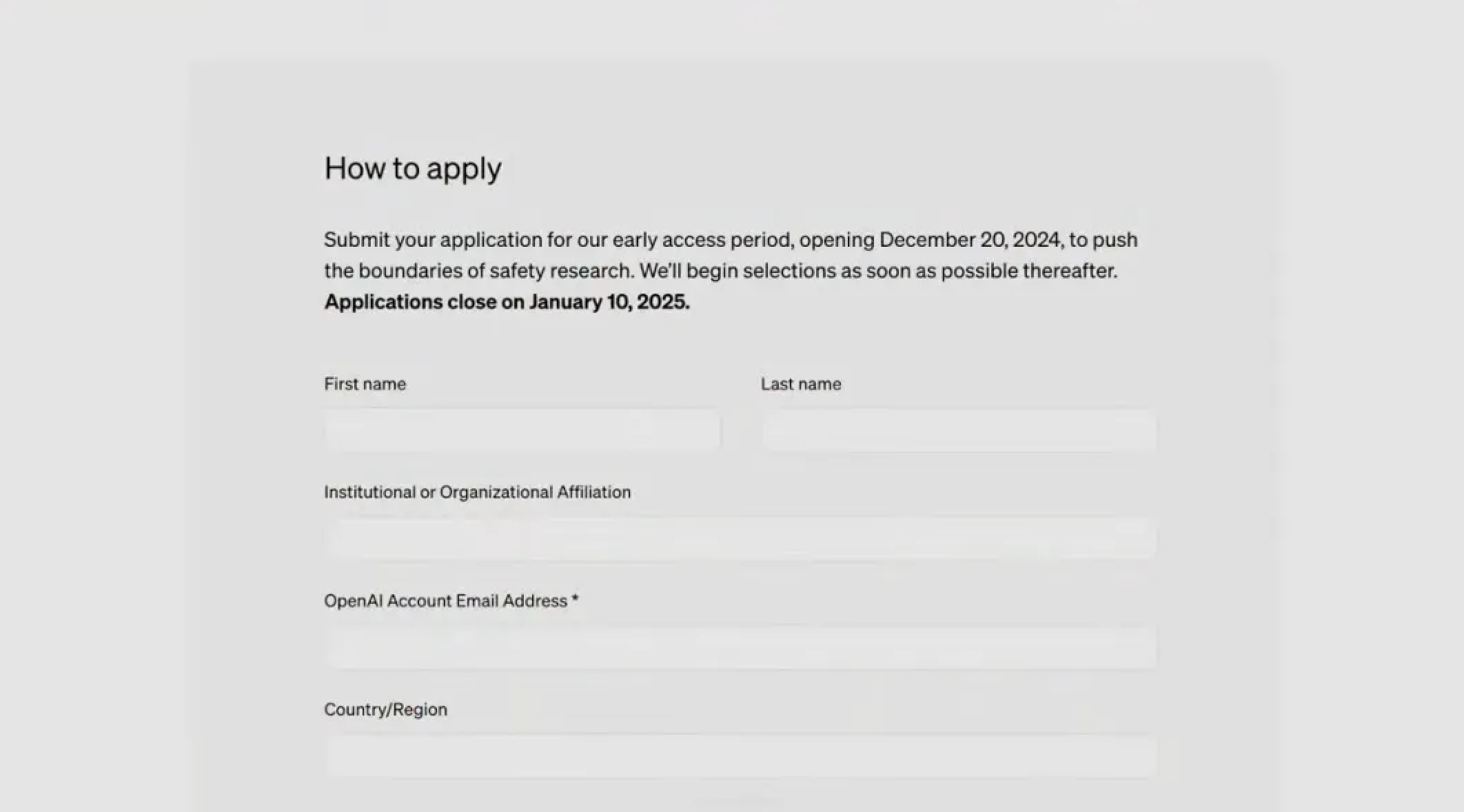

先别急着高兴,因为 o3 系列目前并不会向普通用户开放,OpenAI 计划先开放外部安全测试申请,正式发布时间预计要到明年 1 月。

现在,感兴趣的朋友可以提交申请:

https://openai.com/index/early-access-for-safety-testing/

o3 模型的「纸面参数」迎来了全方位提升。

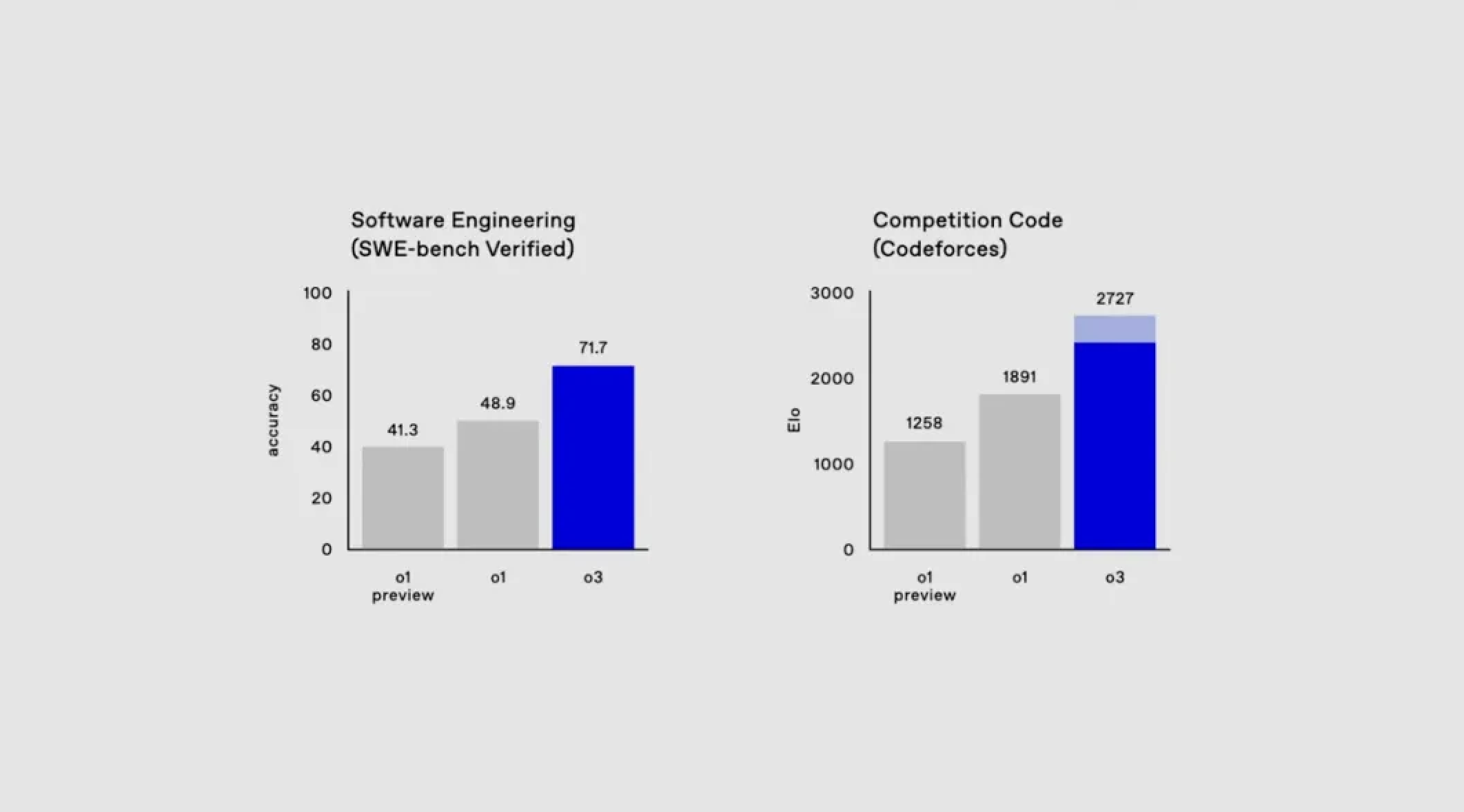

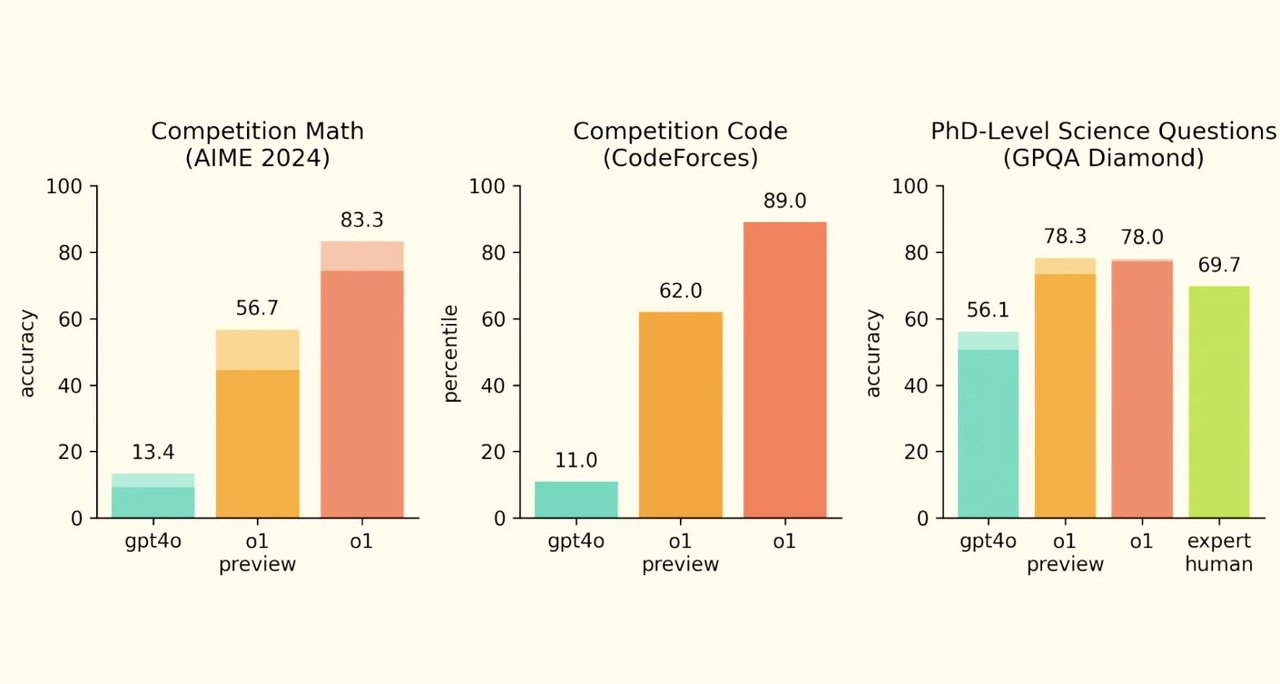

首先在 SweepBench Verified 基准测试中, o3 达到了约 71.7% 的准确率,直接将 o1 模型甩在身后整整 20% 之多。

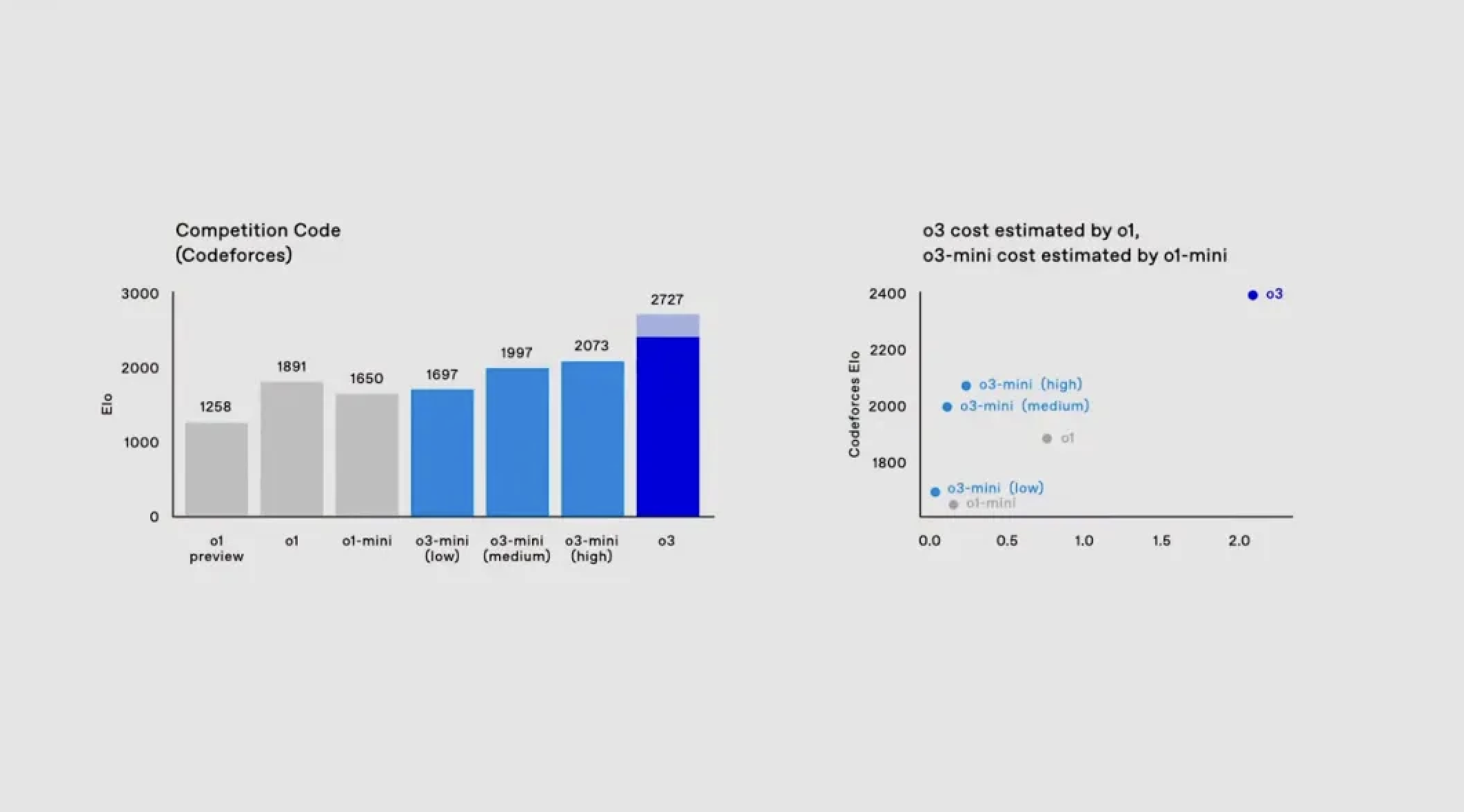

转入编码领域,o1 在编程竞赛平台 Codeforces 上的得分为 1891。而 o3 在开足马力,延长思考时间的情况下,得分可达 2727。

作为参照,演示人员 Mark Chen 的得分也只有 2500,充分展现了 o3 模型已经具备接近甚至超越人类专业程序员的实力。

在数学领域,o3 同样表现出色。

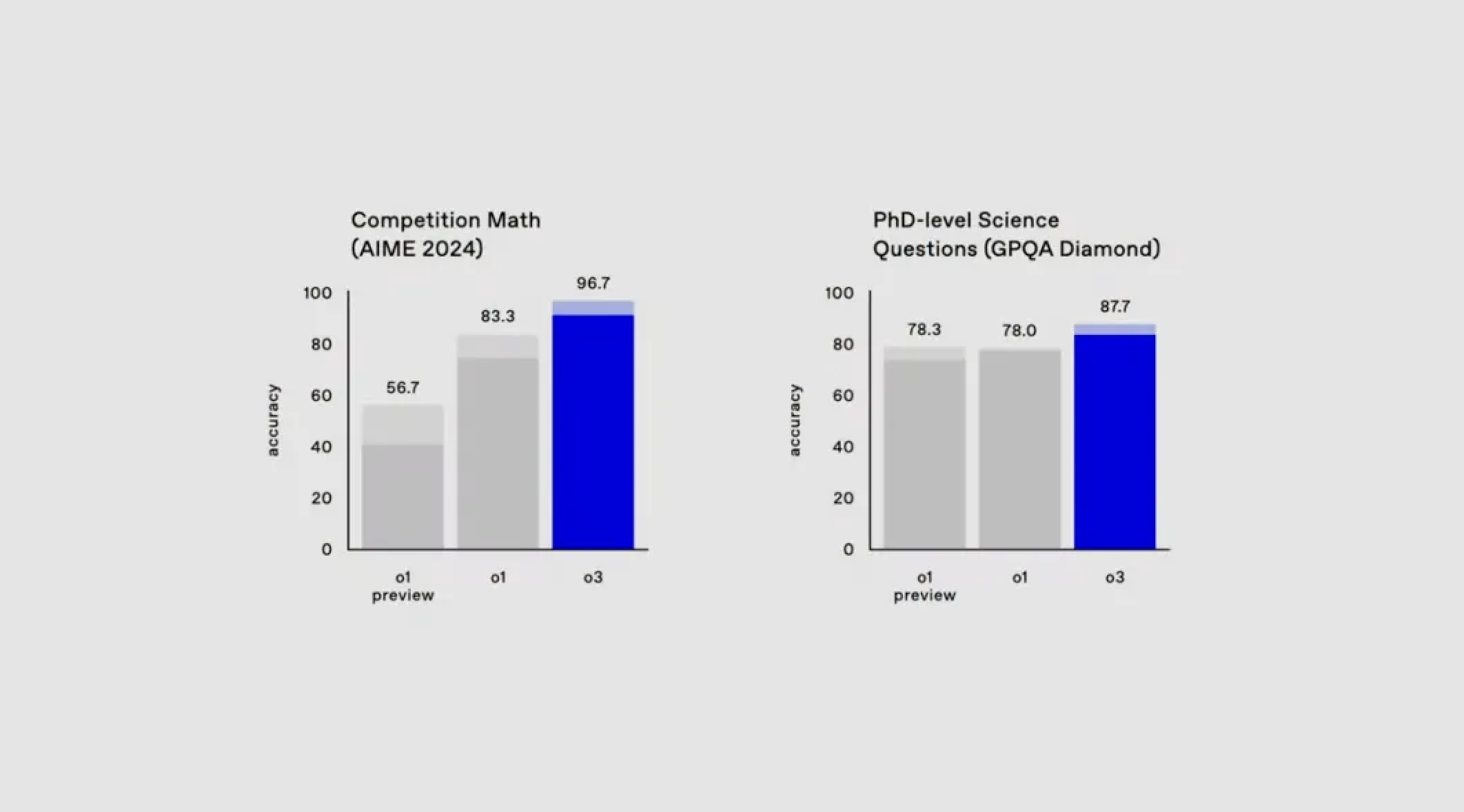

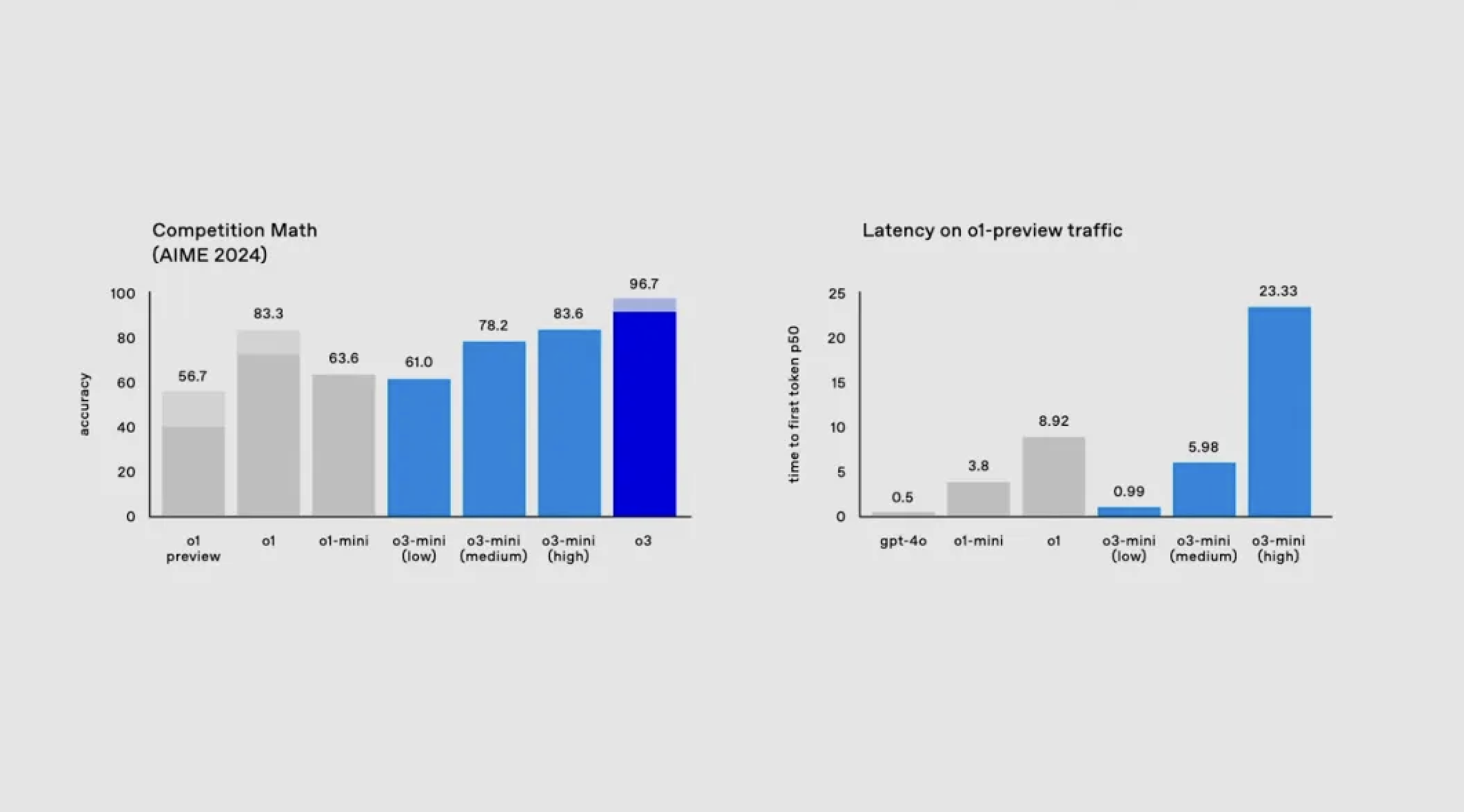

在美国数学竞赛 AIME 2024 测试中,o3 以 90.67% 的准确率完全碾压了 o1 的 83.3%。

遇上衡量博士级科学问题解答能力的 GPQA Diamond 测试,o3 取得了 87.7% 的成绩,而 o1 仅为 78%。

什么概念呢?要知道,就算是领域内的博士专家,也往往只能在自己的专业范围内达到约 70% 的准确率。

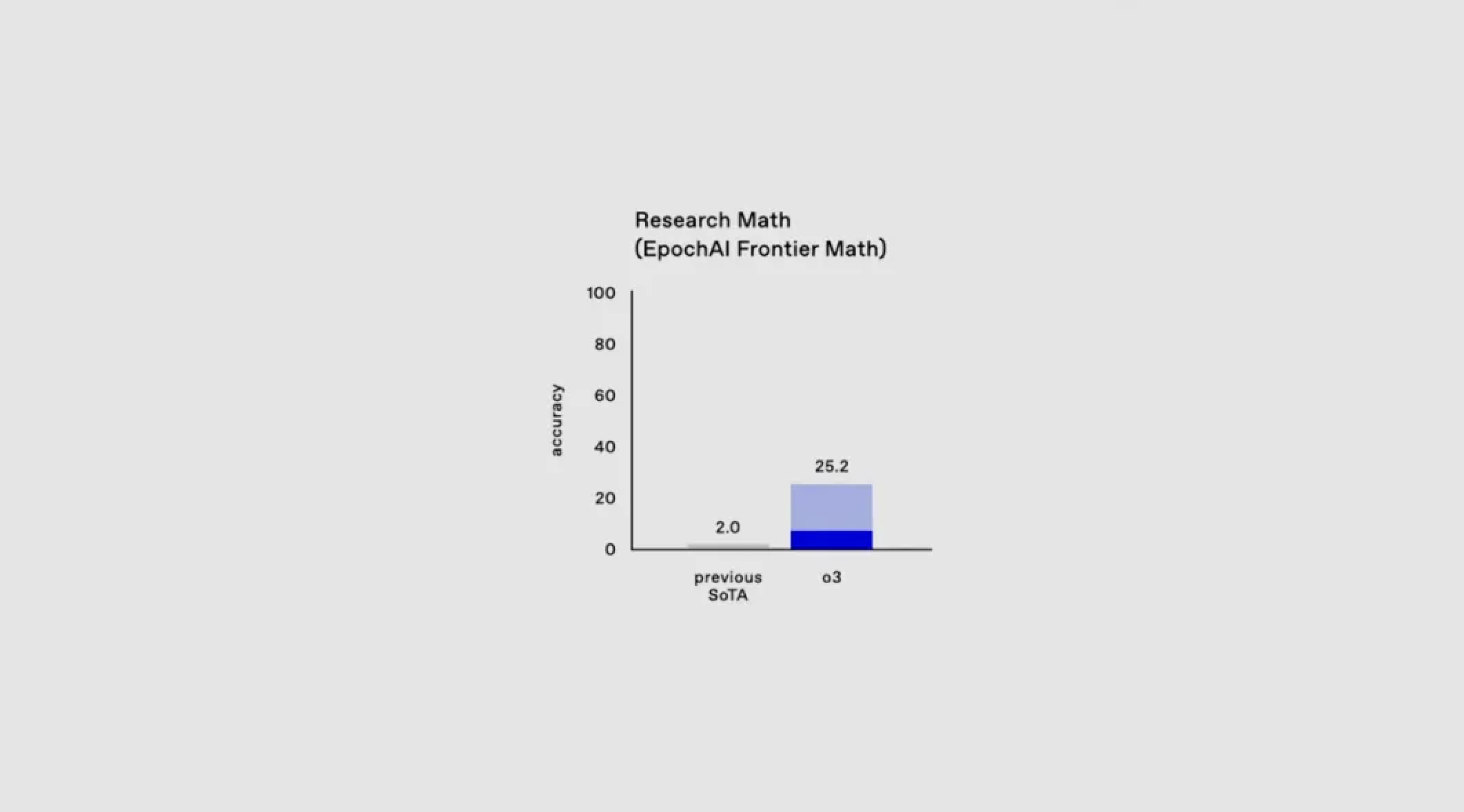

面对当前基准测试接近满分的情况,OpenAI 引入了一个全新的数学测试 EpochAI Frontier Math。

这被认为是当前最具挑战性的数学评估之一,包含了极其复杂的问题。就连专业数学家解决单个问题也需要耗费数小时甚至数天。

目前,所有现有模型在该测试上的准确率都不足 2%,而在高算力的长时间测试下,o3 却能取得超过 2457 的分数。

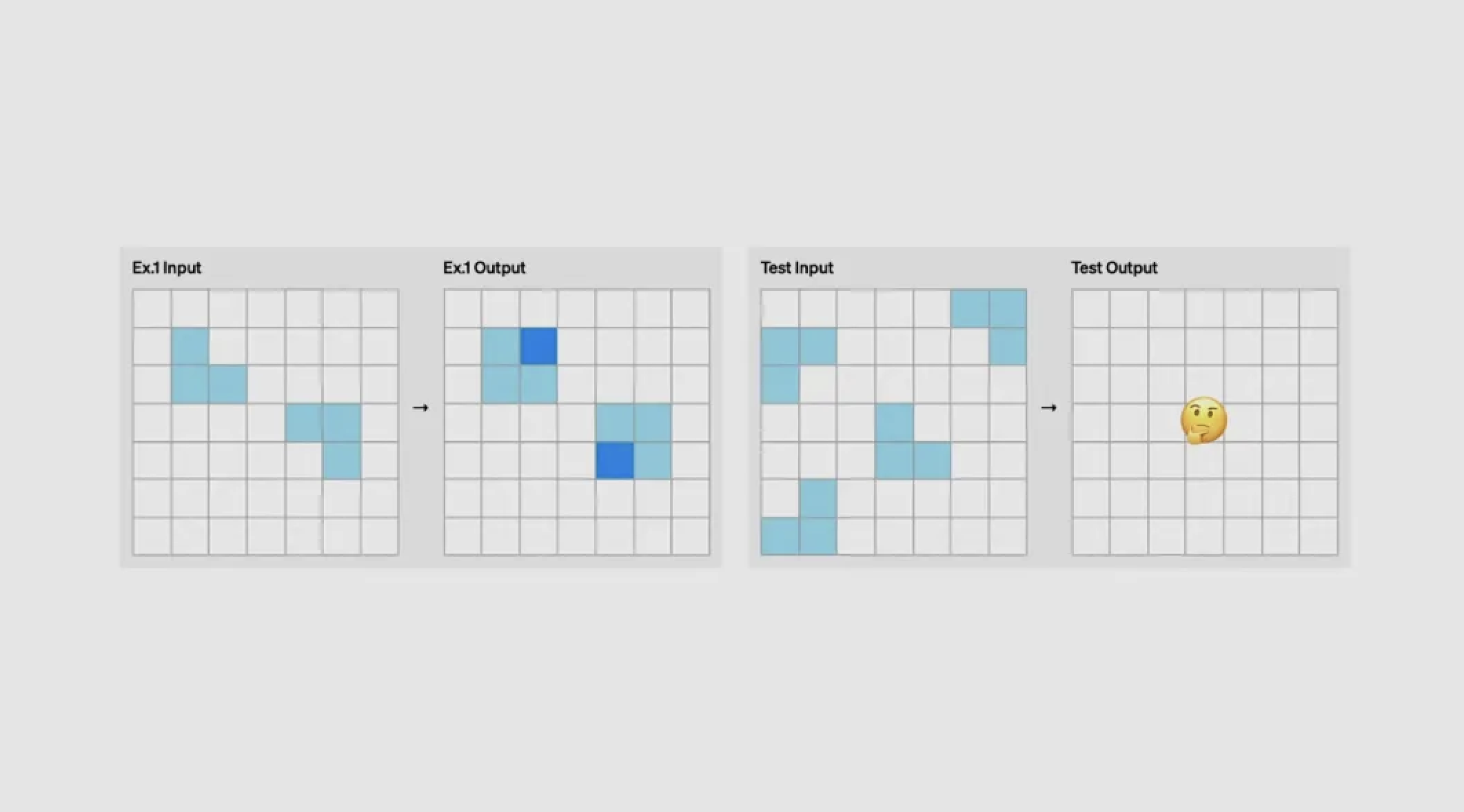

说到 AI 领域的圣杯 AGI,也就不得不提到 ARC-AGI 这个专门衡量 AGI 的基准测试。

ARC-AGI 是由 Keras 之父 François Chollet 开发,主要是通过图形逻辑推理来测试模型的推理能力。

当演示人员向另一位演示人员 Mark Chen 提出即兴问题时,后者准确指出了任务的要求:需要计算每个黄色方块中彩色小方块的数量,并据此生成相应的边框。

这些对人类来说再简单不过的任务,对 AI 来说却是一道难题。

并且,ARC-AGI 的每个任务都需要不同的技能,且刻意避免重复,完全杜绝了模型靠「死记硬背」取巧的可能,真正测试模型实时学习和应用新技能的能力。

现在,o3 在低算力的配置下得分 75.7 分。当要求 o3 思考更长时间,并且提高算力,o3 在相同的隐藏保留集上得分 87.5%,远超大多数真人。

OpenAI 的言外之意就是,o3 将让我们离 AGI 更近一步。

今年九月,OpenAI 发布了 o1 mini,具有很强的数学和编程能力,而且成本极低。

延续这一发展方向,今天推出的 o3 mini 也保留了上述特征。即日起,该模型仅向安全研究人员开放测试申请,截止日期为 1 月 10 日。

o3 mini 支持低、中、高三种推理时间模式。

用户可根据任务复杂度灵活调整模型的思考时间。例如,复杂问题可选择更长的思考时间,而简单问题则可快速处理。

从首批评估结果来看,在衡量编程能力的 Codeforces Elo 评分中,随着推理时间的增加,其 Elo 分数持续攀升,在中等推理时间下就已超越 o1 mini。

演示人员要求模型使用 Python 创建了一个代码生成器和执行器,该脚本可启动服务器并创建本地用户界面。用户可在文本框中输入代码请求,系统会将请求发送至三种高级模式的 API,生成并执行相应代码。

例如,当要求其生成一个包含 OpenAI 和随机数的代码时,o3 mini 的中等推理模式迅速完成了处理。

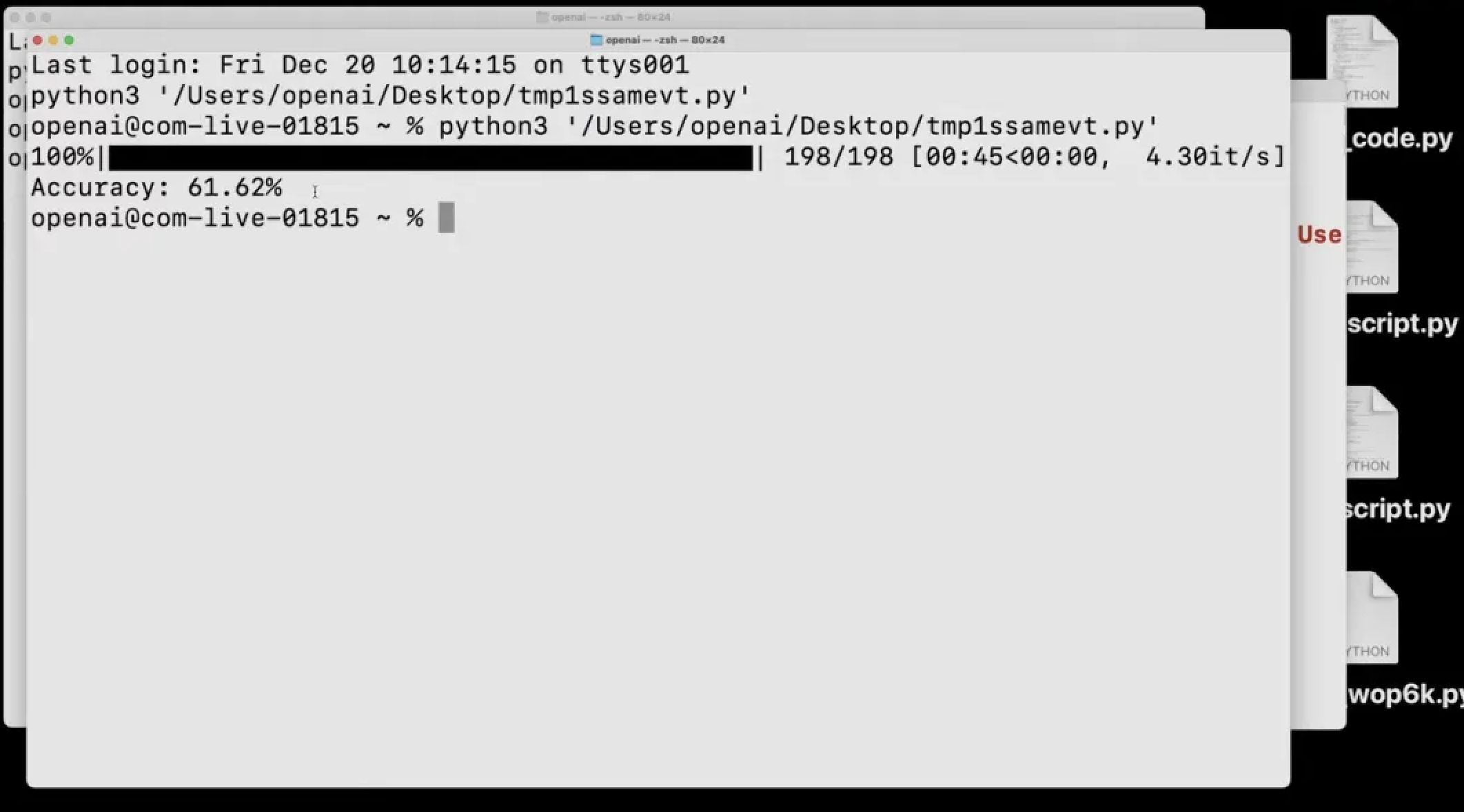

另外,它还能自己测试自己,比如说在 GPQA 数据集测试中,模型以低推理模式完成了复杂数据集的评估。

它下载原始文件,识别 CSS、答案和选项,整理问题并进行解答,最后进行评分,仅用一分钟就完成了自我评估,准确率达到 61.62%。

在数学领域,o3 mini 同样表现优秀。

在 AIME 数学基准测试中,其低推理模式就达到了与 o1 mini 相当的性能,中等推理模式更是超越了 o1 mini,且延时更低。

另外,应广大开发者呼声,o3 mini 模型也将全面支持函数调用、结构化输出和开发者指令等 API 功能。

现在,o3 mini 和 o3 的申请通道现已开放。o3 mini 预计将于 1 月向所有用户推出,完整版 o3 则将在后续发布。

写在最后,在这个为期 12 天的年末发布会上,OpenAI 终于祭出了压箱底的杀手锏。

可以说,o3 模型的发布为这场一度陷入「高开低走」困境的发布会,画上了一个意料之外却又情理之中的圆满句号。

短短不到 3 个月的时间,OpenAI 就完成了 o1 模型的迭代升级。

这种从 GPT 系列到 o 系列的转型,显然是 OpenAI 深思熟虑后的战略选择,而事后结果也证明这个决定是明智的。

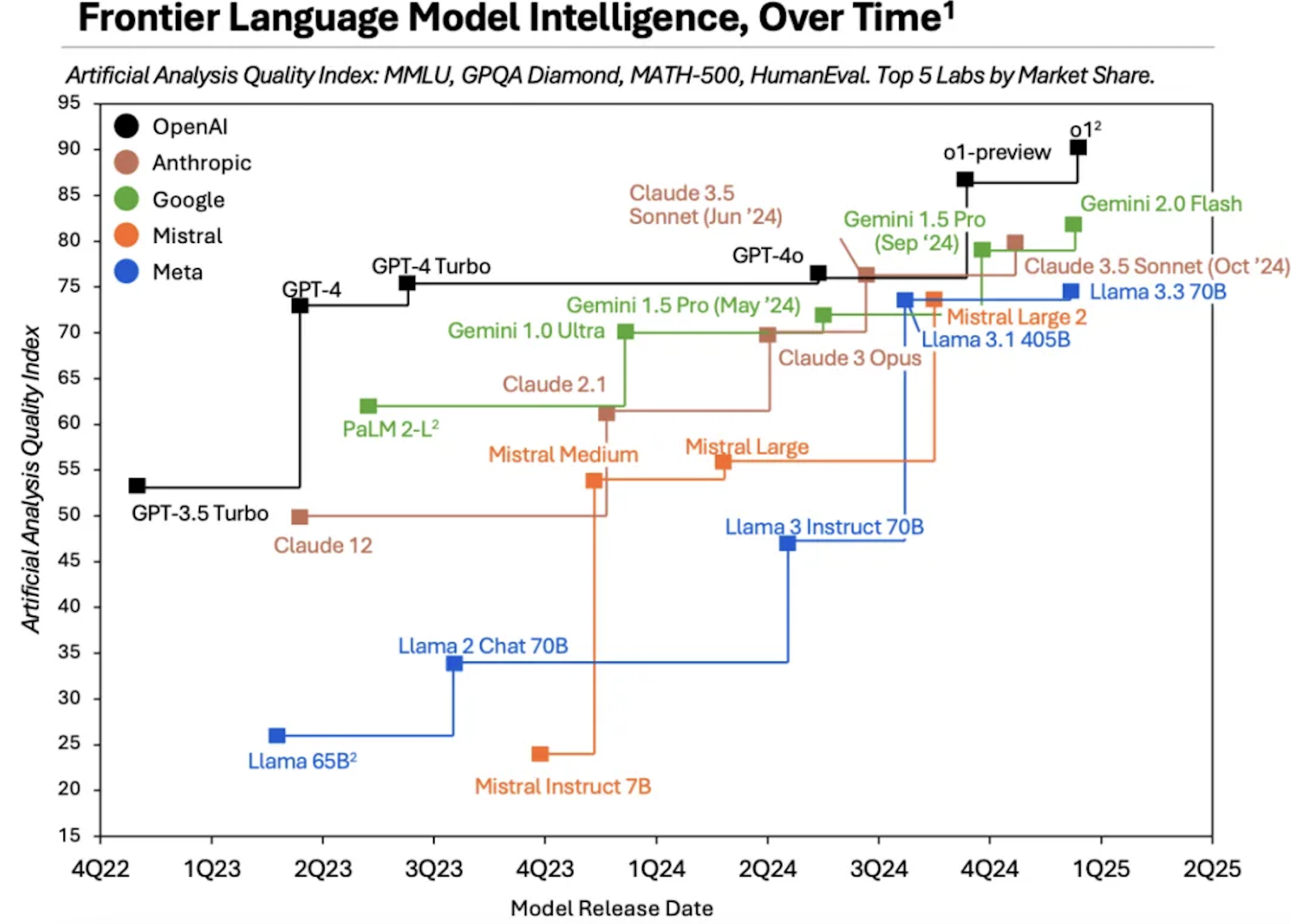

不过,值得注意的是,微软 CEO Satya Nadella 近期在一档播客节目中表示,OpenAI 在 AI 领域领先竞争对手约两年之久。

也正是这种相对宽松的竞争环境,使得 OpenAI 能够专注于开发 ChatGPT。

然而,当前形势攻守易形也。

Menlo Ventures 的报告显示,ChatGPT 的市场份额被其他竞争对手逐渐蚕食,从 2023 年的 50% 下降到了 2024 年的 34%。

由「标配」沦为「可选项」,ChatGPT 的光环正在褪去。

这背后的原因显而易见,OpenAI 的「护城河」正被短命狂奔的竞争对手们一寸寸填平。

来自 Artificial Analysis 的调研数据清晰显示,Anthropic 和 Google 等厂商陆续开发出性能接近 GPT-4、OpenAI o1 等新模型。

并且,随着 Scaling Law 触及天花板,核心高管人才相继离场,OpenAI 过往靠单个基础模型赢得的红利正在加速消退。

在动辄以天计的行业里,即便是今日发布的 o3 模型也很难再次创造长达 2 年的空窗期。

尤其是当 Grok-3 和 Claude 等新模型蓄势待发,留给 OpenAI 的时间或许已经不多了。

醒醒,今年最好的 AI 厂商依旧是 OpenAI,但明年或许会因为不同的 AI 方向有无数种答案。

所幸,作为用户的我们,都将是这场变局中最大的赢家。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

上个月,OpenAI 宣布推出 ChatGPT Search。

但当时这位入局搜索引擎的新选手还谈不上颠覆 Google 搜索,而今天免费向全球用户开放的新版 ChatGPT Search 则旨在补齐关于获取实时信息的短板。

本次更新的主要亮点包括:

图标手动触发搜索

图标手动触发搜索

本次发布会由 OpenAI 首席产品官 Kevin Weil、ChatGPT 搜索产品负责人 Adam Fry 以及技术人员 Cristina Scheau 共同主持。

在接连多天发布会后,不仅蹲守直播的用户感到疲软,就连 Kevin Weil 也显得有些敷衍了,照着提词器念台词的痕迹就差没明着来。

言归正传,升级后的 ChatGPT search 功能变得更「聪明」了。

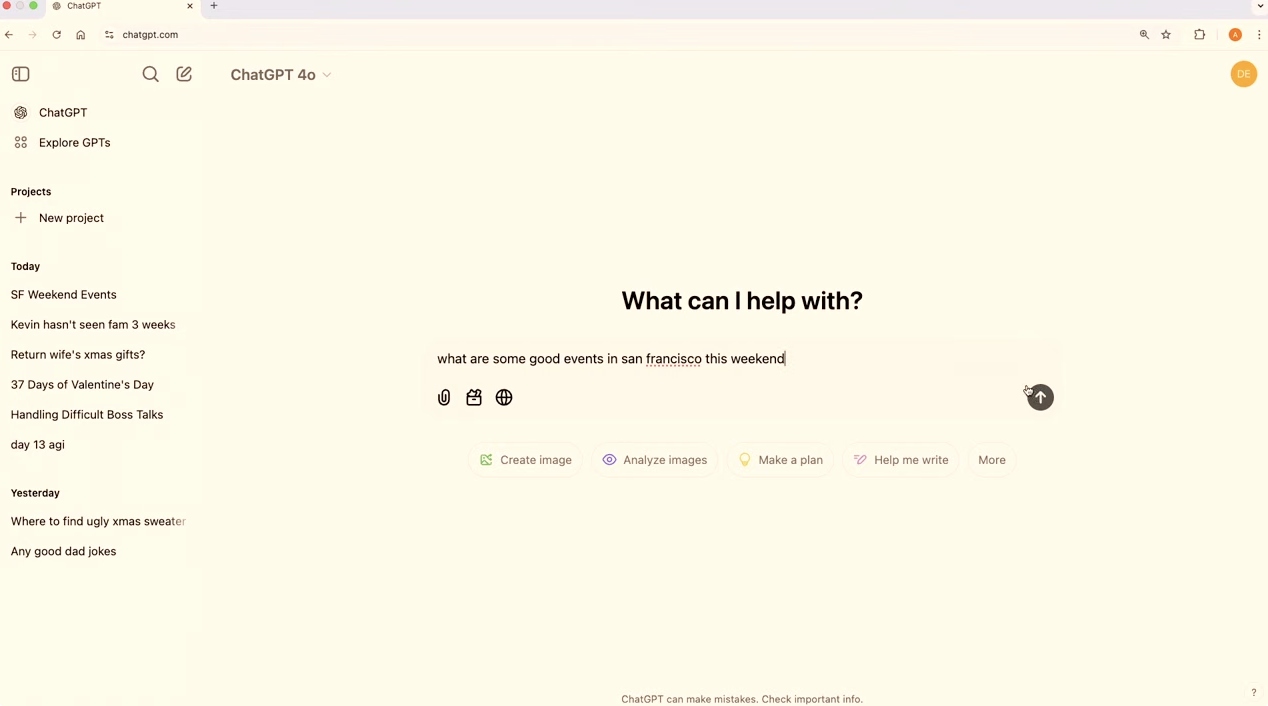

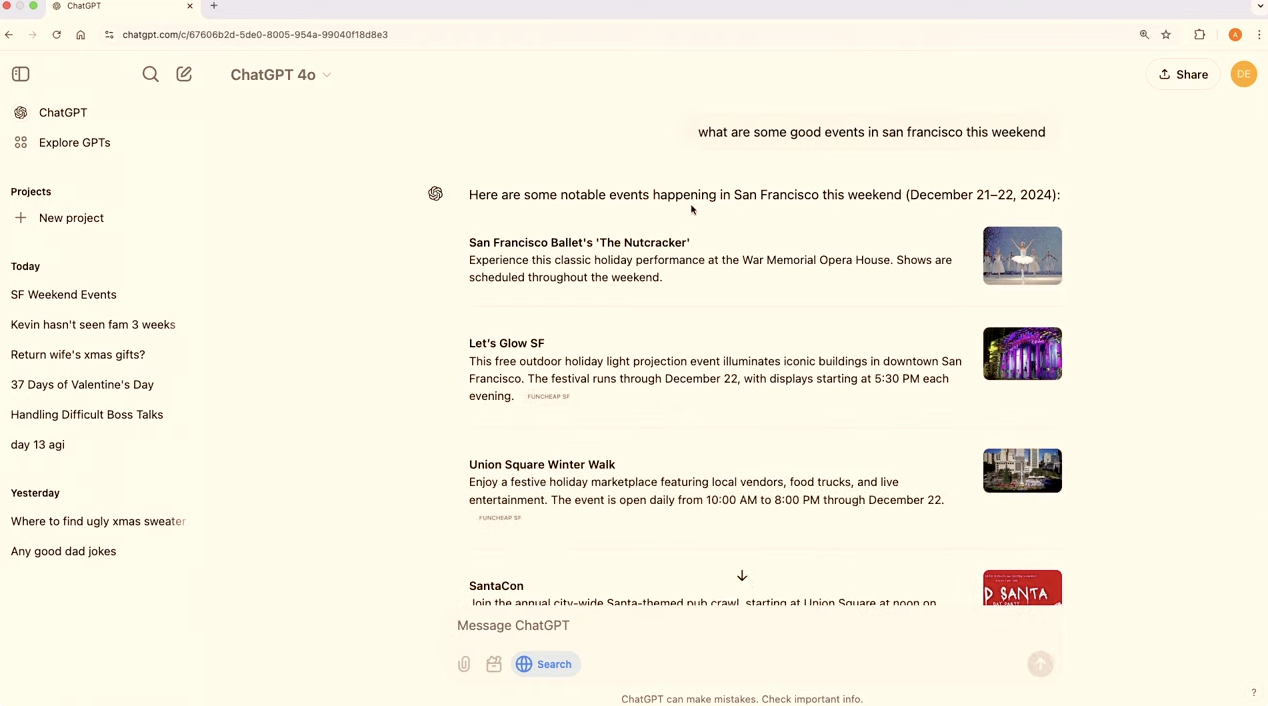

比如说,当你询问「这个周末在旧金山有哪些好玩的活动」时,ChatGPT 会自动判断是否需要获取最新网络信息,亦或者你主动点击「搜索网络」的图标,ChatGPT 将始终从网络获取最新的信息来回答问题。

ChatGPT 反馈的的答案包含丰富的图片和列表,一眼望去,倒是比 Google 搜索引擎更清爽。

搜索结果会标注信息来源,有效降低 AI 幻觉的危害,你可以直接跳转到相关网站,查看详细的视觉内容和其他搜索结果。

ChatGPT search 最大的特色在于其对话式交互方式。

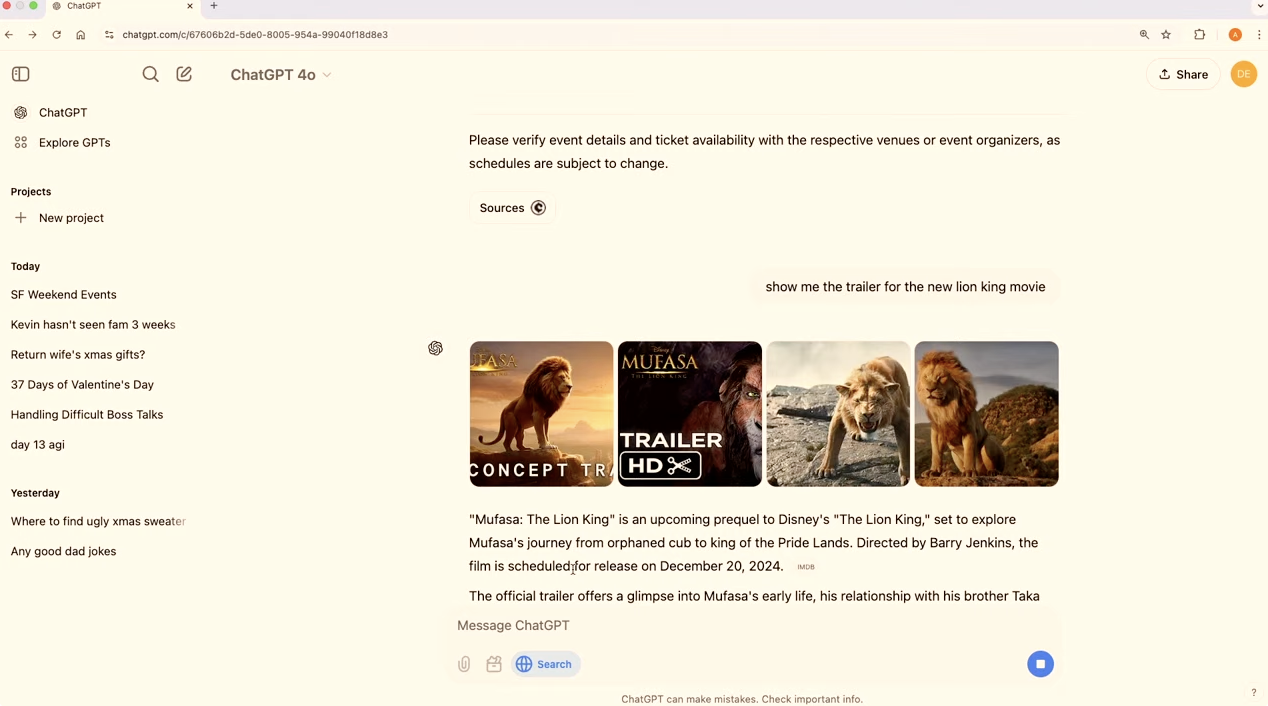

比如在讨论旧金山雨天活动选择时,想去看场电影,我们可以先在 ChatGPT 搜索并播放新版《狮子王》的预告片,降低踩雷的风险。

对于习惯使用 ChatGPT 作为默认搜索引擎的用户来说,现在已经可以更快速地访问各类网站,如 Netflix。

甚至还能在浏览器地址栏直接搜索酒店预订网站。ChatGPT 会优先展示目标网站链接,并在侧边栏提供相关链接供参考。

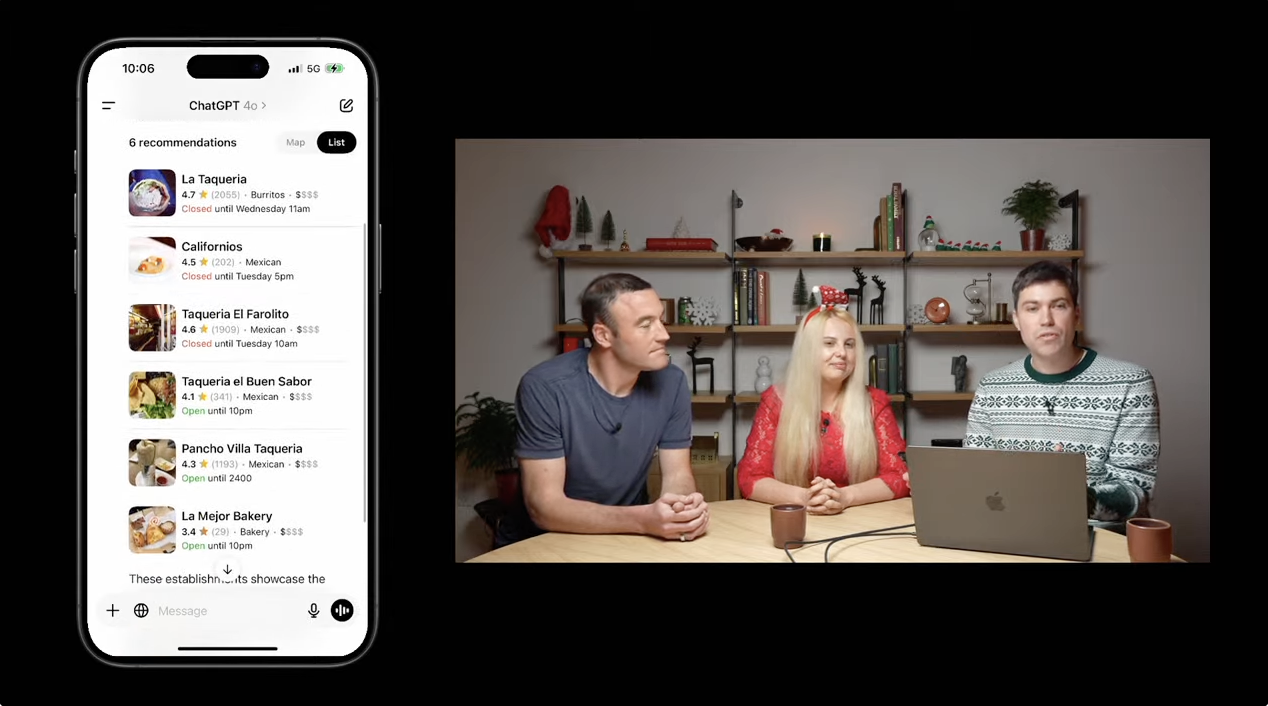

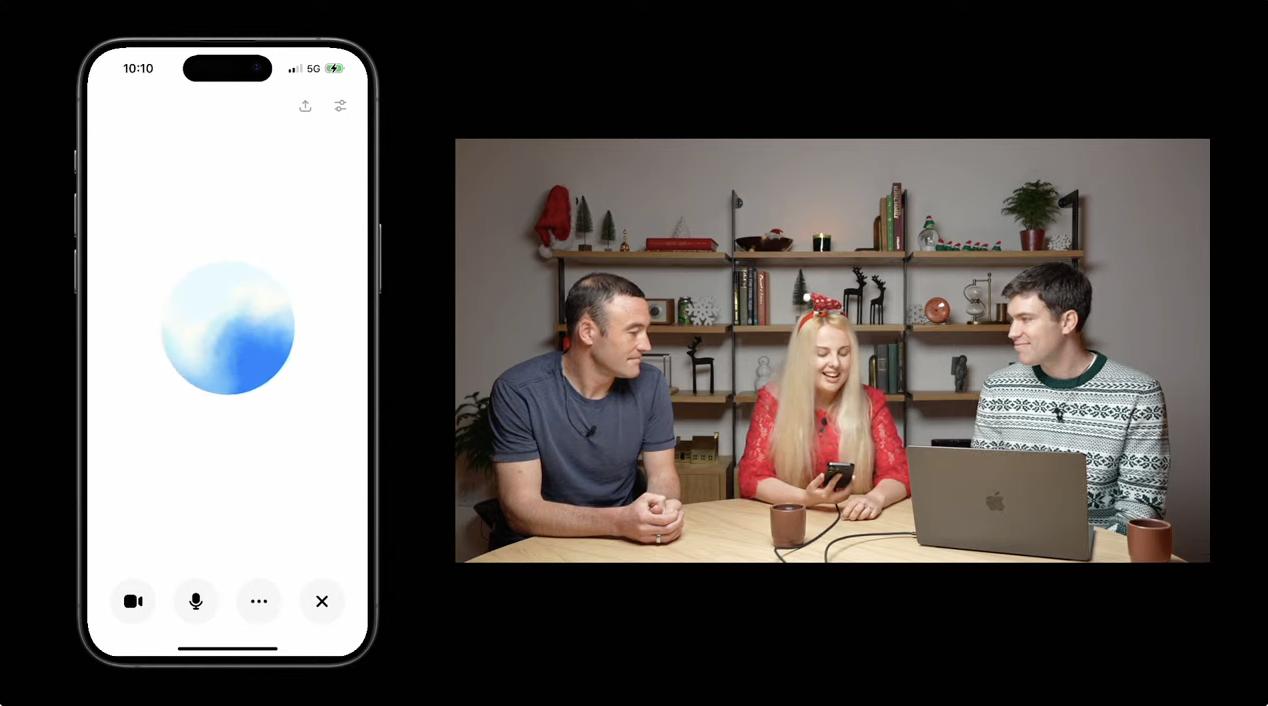

在移动端,ChatGPT search 升级后的表现同样出色。

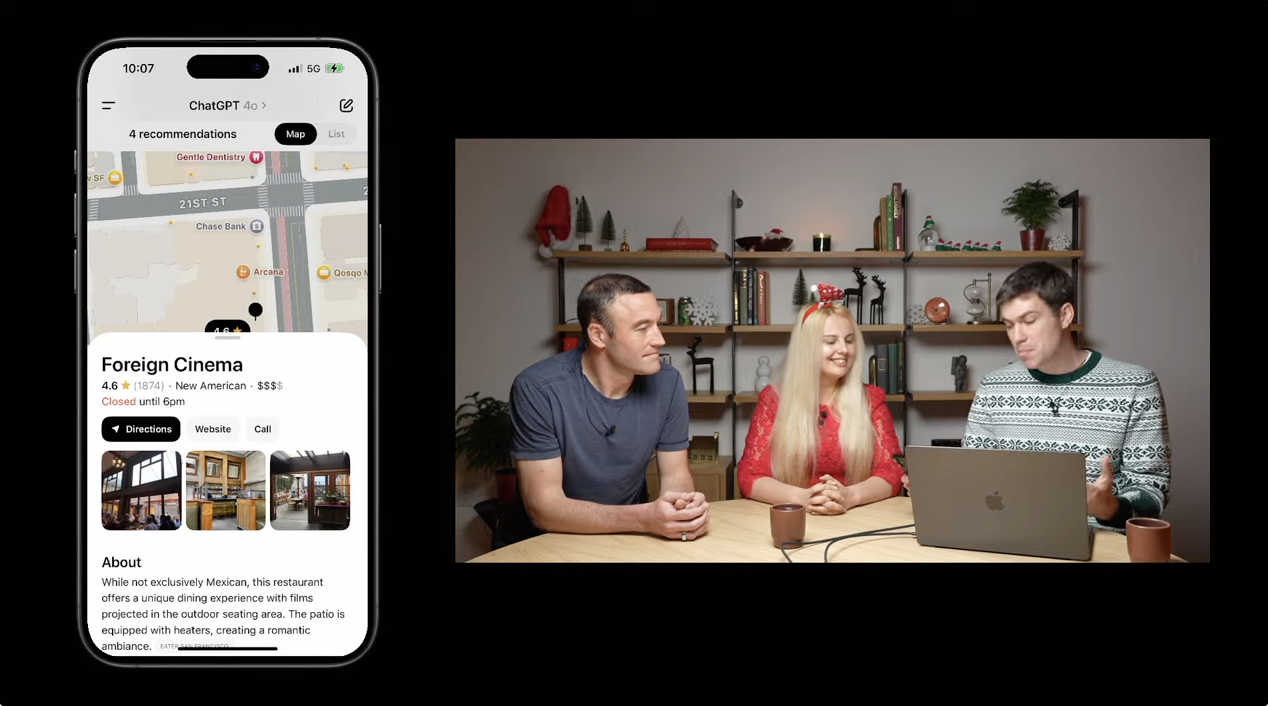

以搜索最好的墨西哥餐厅为例,ChatGPT 会提供包含视觉信息、营业时间等完整商户信息的列表。我们可以通过自然对话进一步筛选,如查找「有户外露台和加热器的餐厅」,无需修改关键词或重新搜索。

嫁入苹果大户人家的 ChatGPT,也让其享受到与苹果地图完美集成的本地化体验,点击地图按钮,就能直接查看这些商户,并使用本地的苹果进行实地浏览。

打字的效率往往比不上语音交流。现在 ChatGPT 高级语音模式同样可以实时进行网页搜索。

比如说,你打算去瑞士度假,在 ChatGPT 帮助下,它能用流畅的语音告诉你苏黎世在某一周有什么活动。

具体的节庆活动,到访的圣诞马戏团,音乐秀等都能娓娓道来。

时间如果更具体一些,包括圣诞市场的开门日期和时间,苏黎世今天的天气,甚至纽约联合广场的开放时间,ChatGPT 都能一一作答。

遗憾的是,这次发布会的结尾没有笑话,演示人员要求 ChatGPT 展示用德语、法语和意大利语说「圣诞快乐」,这对于支持 50 多种语言的 ChatGPT 自然轻松拿捏。

最后,木有感情的 Kevin Weil 也「剧透」了明天直播活动的详情,那就是将举行一个「迷你」开发者日,发布更多激动人心的消息。

还记得上个月 ChatGPT search 刚发布时,OpenAI CEO Sam Altman 在 X 平台发文称:

搜索是我们自 ChatGPT 推出以来,我最喜欢的功能!

而根据投资公司 Evercore 在 9 月份对 1300 人进行的一项调查,有 8% 的受访者选择 ChatGPT 而不是 Google 作为他们首选的搜索引擎,相比之下,6 月份这一比例仅为 1%。

要知道,那时更专业的 ChatGPT search 功能尚未正式发布,便已经能从搜索市场份额身上撕咬下一块肉,收获如此多的忠实拥趸。

这样的成绩也进一步刺激了 OpenAI 拓展搜索领域的野心。

上个月,外媒 The Information 披露,OpenAI 正在筹划一款新产品,旨在将 AI 聊天机器人和网络浏览器相结合,已经着手与旅游、餐饮、房地产和零售等领域的网站商讨合作协议,为它们提供搜索功能。

为了实现这一目标,OpenAI 甚至早些时候不惜重金挖来了 Google Chrome 团队的创始成员之一 Ben Goodger。

然而,在用户体验和商业变现之间寻找平衡点,是摆在所有 AI 搜索引擎的难题。

以「无广告」起家的 Perplexity AI 最终也没能扛住营收压力,宣布要在 AI 搜索引擎中试行品牌广告。而 OpenAI 首席财务官 Sarah Friar 也表示正在权衡是否要在自家的产品引入广告。

但愿这不会成为另一个「屠龙者终成恶龙」的故事。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

转眼间,OpenAI 年底 AI 春晚已过半数,但雷声大雨点小,今天也不例外。

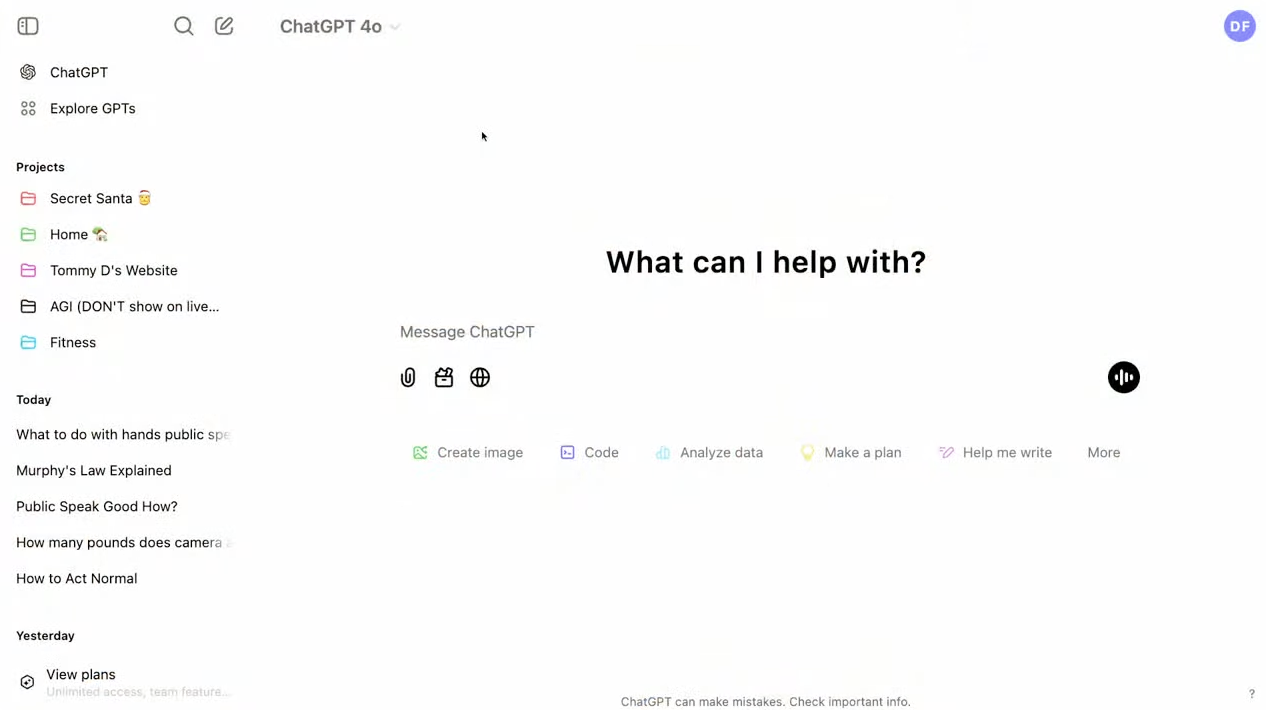

就在刚刚,OpenAI 推出了 ChatGPT Projects 新功能。

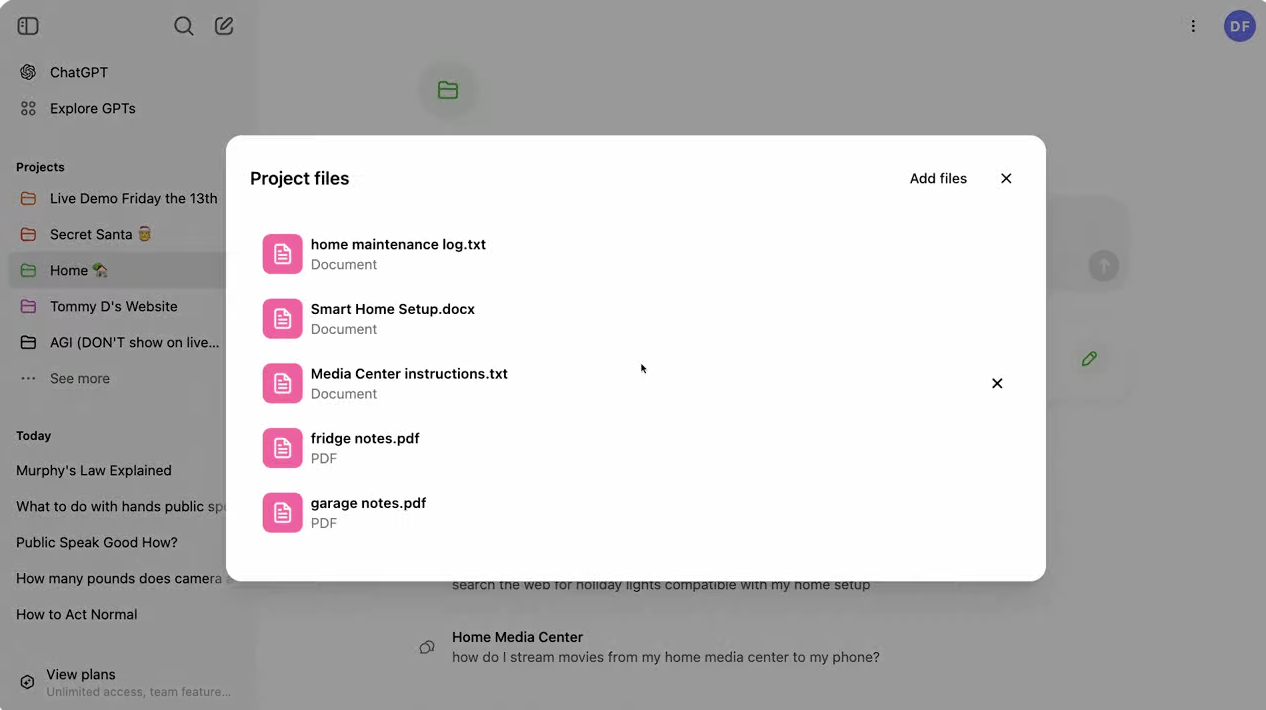

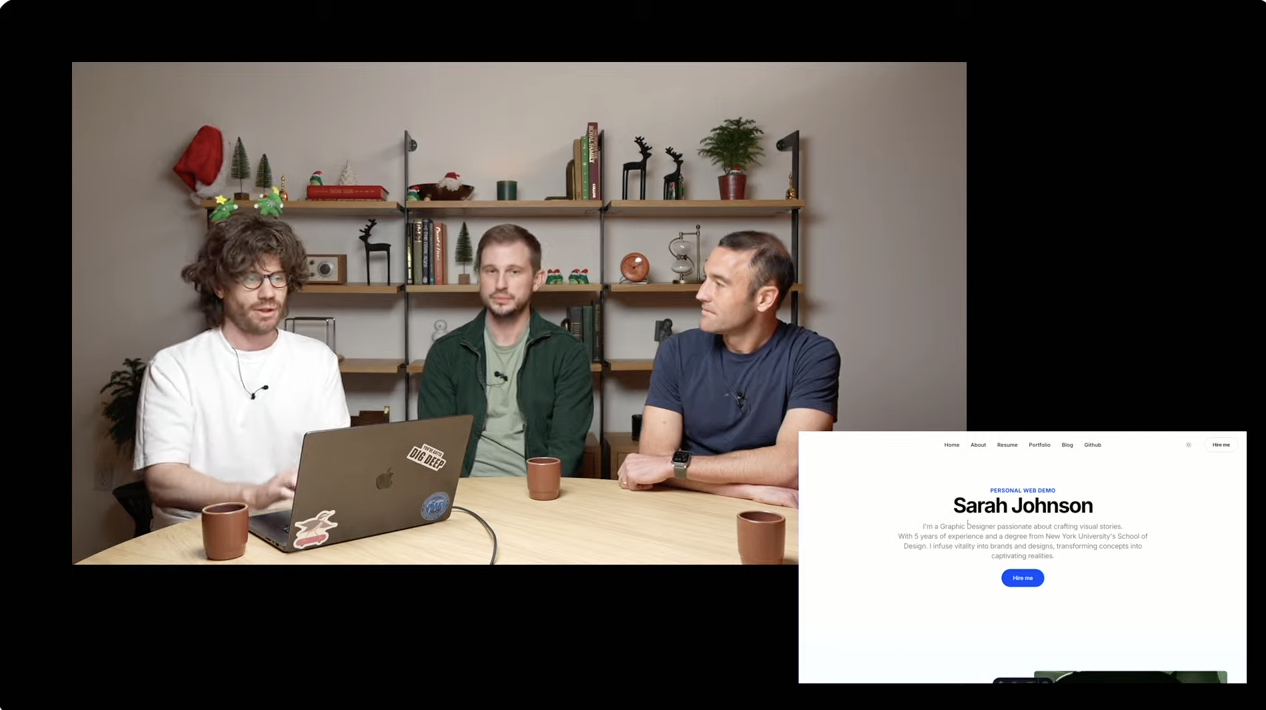

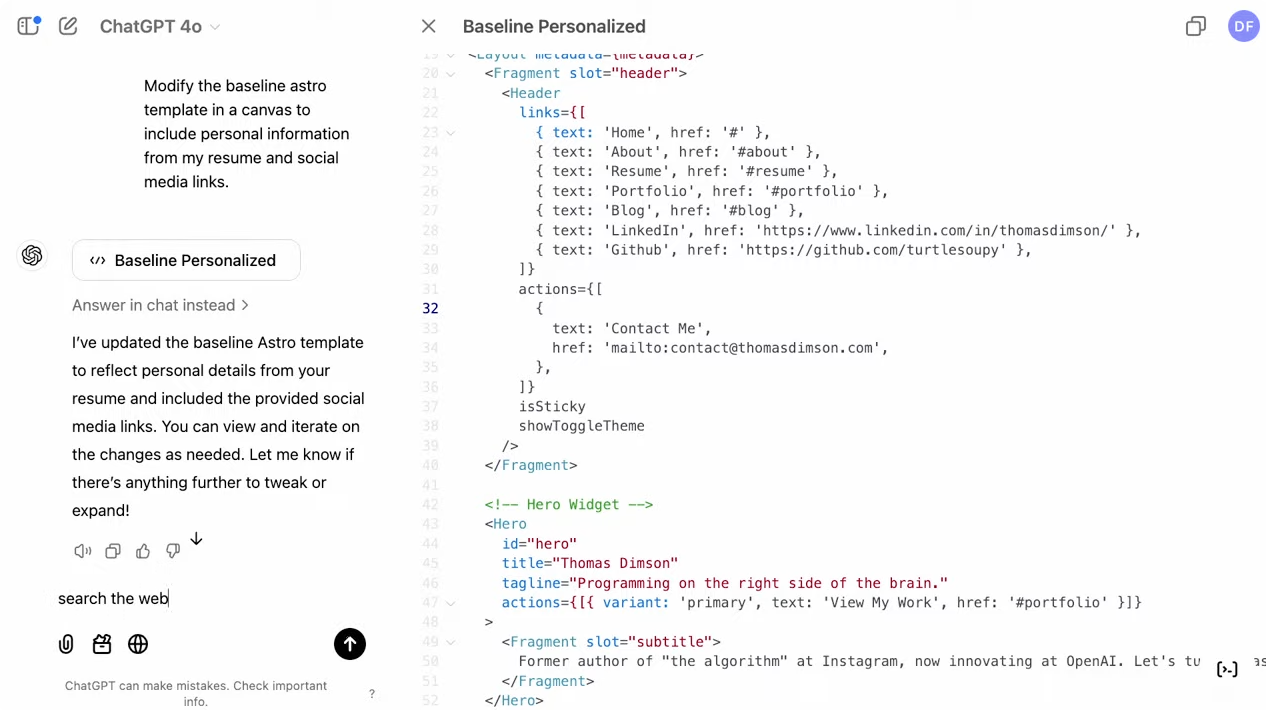

本次发布会由 OpenAI 首席产品官 Kevin Weil、以及 Drew Schuster 和 Thomas Dimson 共同主持,全程用时不到 20 分钟。

ChatGPT Projects 新功能与 Perplexity Spaces 颇为相似,允许用户将聊天内容整理到项目文件夹中,并支持上传数据、图像和 PDF 等各类文件信息。

给「Projects 」注入知识记忆后,用户既可以设置自定义指令,也可以使用搜索、Canvas 等常用功能,甚至可以简单地将其作为对话管理工具使用。

发布会现场展示了多个实用场景。

首先是 ChatGPT 对话搜索功能,用户可以轻松浏览和检索历史对话,比如询问「是否应该在周五部署代码到生产环境」这样的问题时,可以搜索并关联之前的相关对话,并轻松将其添加到项目中。

对了,在创建新项目时,用户还可以编辑标题、选择醒目的颜色,从而方便在侧边栏快速定位。

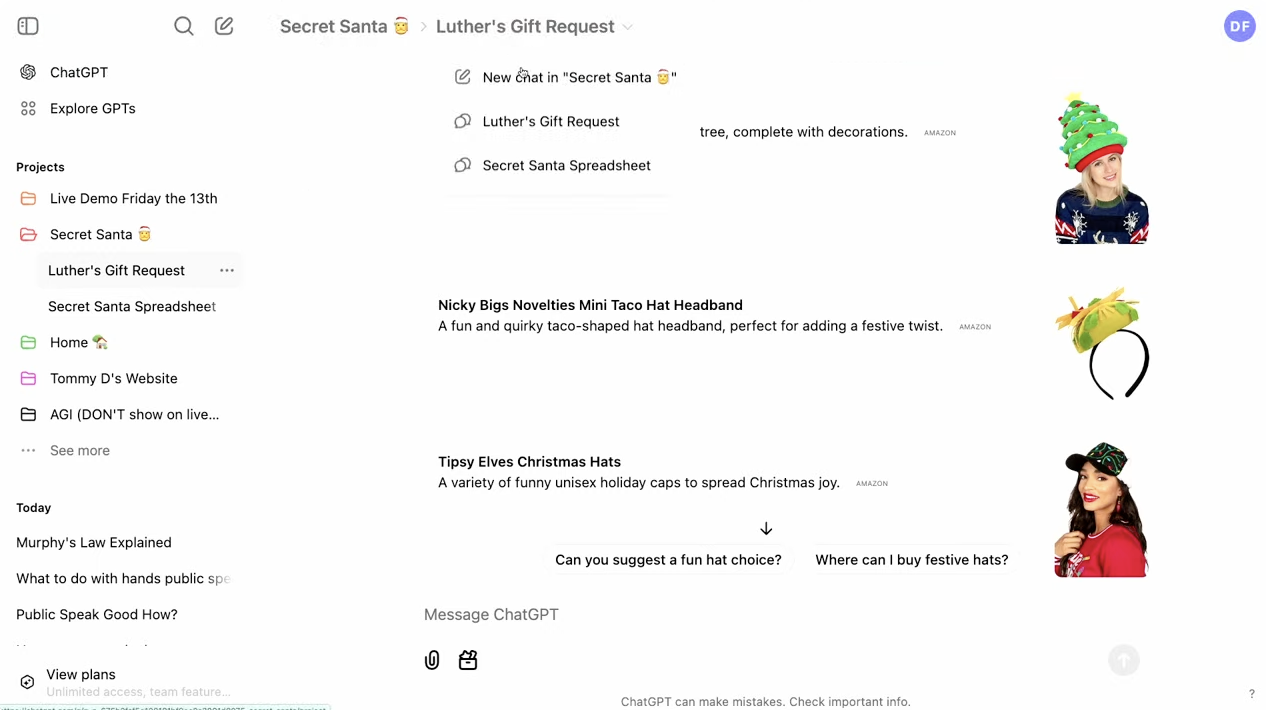

研究员还展示了一个有趣的圣诞节应用场景。

通过建立秘密圣诞老人项目,上传每位参与者的礼物愿望清单,可以要求 ChatGPT 随机分配送礼关系,并以表格形式清晰展示赠送者、接收者及礼物建议。

再比如,Canvas 集成到 Projects 功能也是重要更新之一。

基于上传的活动信息,研究员要求 ChatGPT 给活动参与者写封邮件,它模仿用户的写作风格,生成包含完整规则和细节的邮件内容。

当然,提出需求时,建议写得更具体一些。

在家庭生活场景中,Projects 功能也能发挥作用。

用户平时可以通过文档记录公寓维护任务、智能家居设置、家用电器使用说明等信息,当遇到问题时,如询问是否需要更换冰箱滤芯,ChatGPT 能够快速查阅维护日志给出建议。

不过问题是,真的会有人将家里的琐事事无巨细地记录在文档里吗?

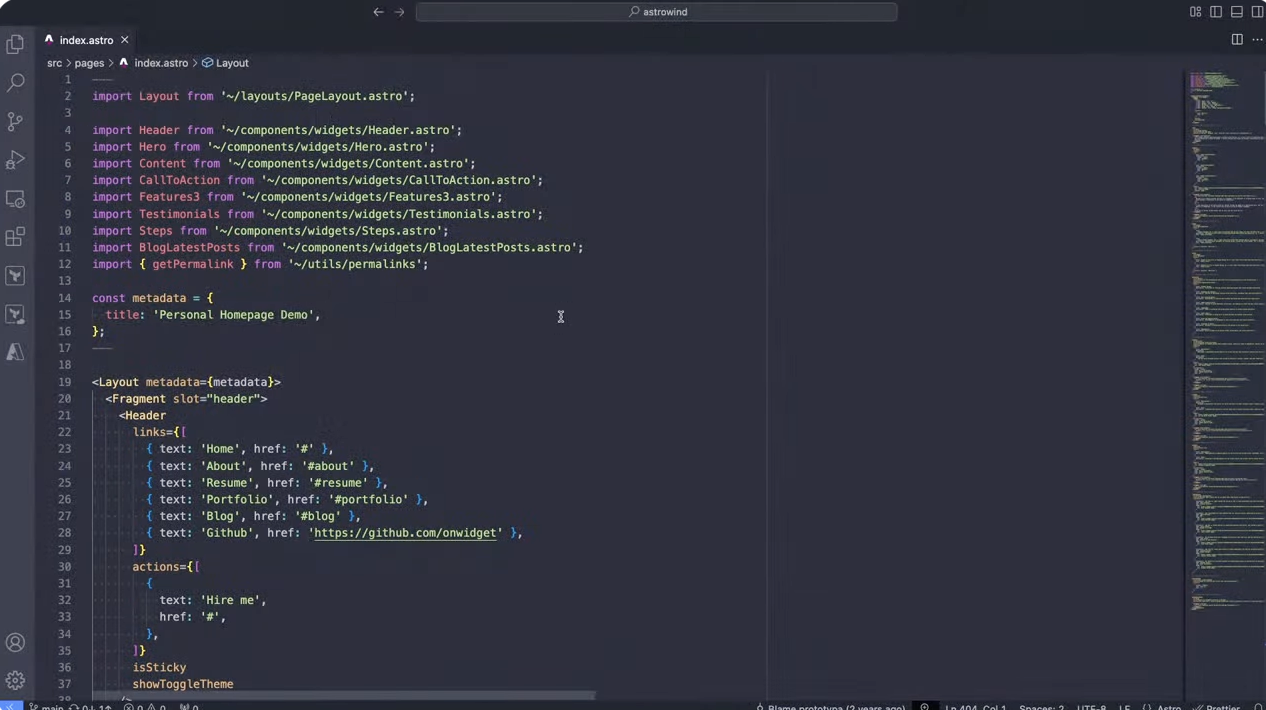

在编程协作方面的展示则上演了连环「翻车」。

OpenAI 研究员希望重新创建并调整个人信息官网,基于此,他上传了模板、简历、推荐信以及自定义指令等信息,接着通过 Canvas 生成并修改代码。

好消息是,成品最终出现了,但坏消息是,出现的信息并不完整,甚至在后续的修改中也还是翻车了。

从今天开始,该功能将逐步向 Plus、Pro 和 Teams 用户开放,随后逐步推广至免费用户,并计划在明年向企业和教育用户开放。

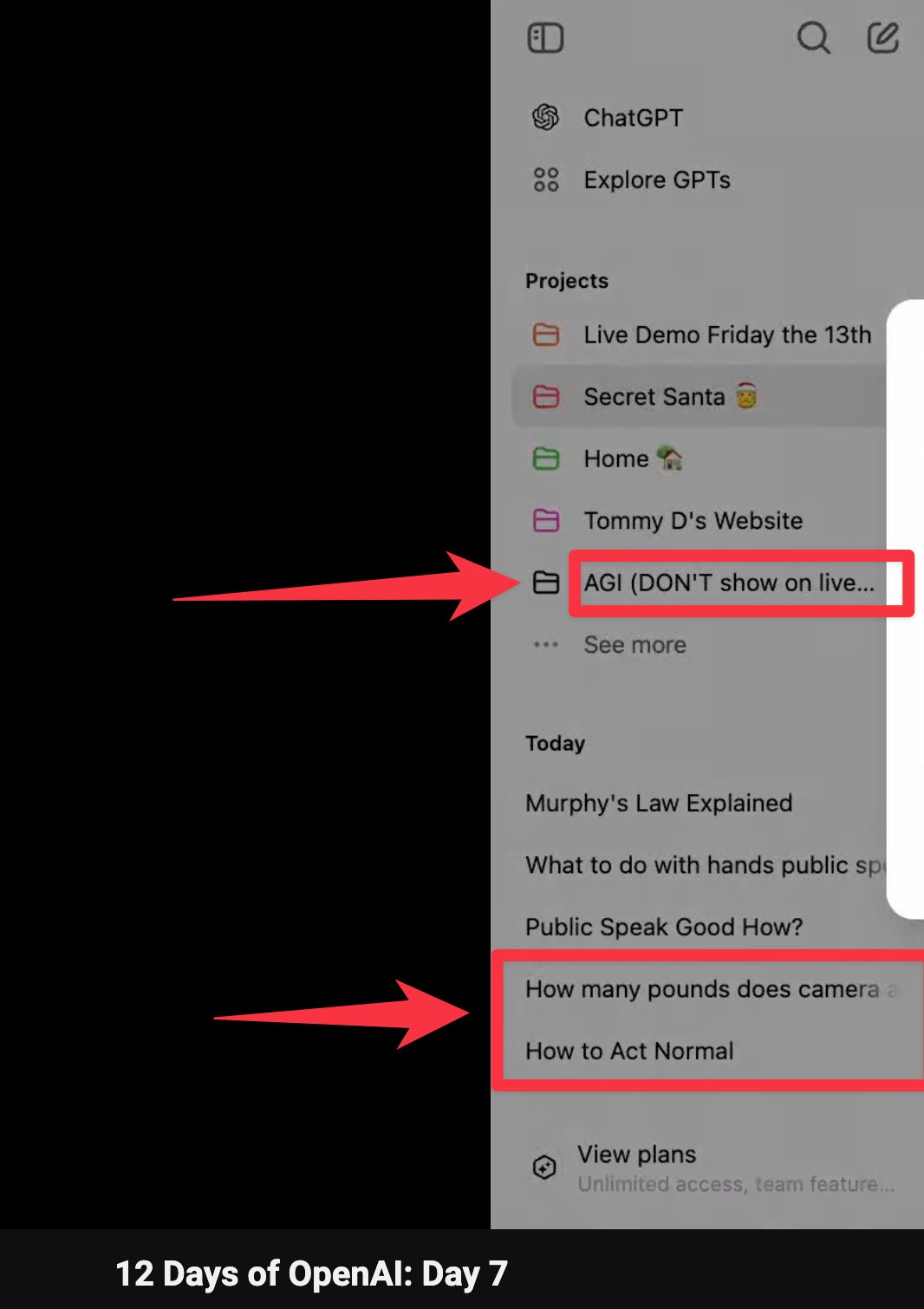

值得一提的是,直播电脑屏幕故意透露的文件夹还玩起了 AGI 的梗,以及之前的搜索记录也暴露了一些有趣的信息。

网友对此次更新的反响可谓褒贬不一。

但下面两条来自网友的评价相当精辟,新功能很实用,但还是希望 OpenAI 能秀一秀肌肉。

写在最后,OpenAI 过往七天的发布会像极了打工人匆匆解决的日常三餐,看似填饱了肚子,但总觉得少了点什么。

Sora、ChatGPT 高级语音模式视频通话和屏幕共享、ChatGPT 登陆苹果全家桶等,一连串功能的接连落地看似热闹非凡,实则不过是在兑现此前的期货。

按照网友猜想的剧本,OpenAI 可能还在酝酿更多重磅产品,包括 DALL·E 4、GPT-4.5,以及 AI Agents 等。

但不怕 OpenAI 再来期货,就怕下周甚至连期货也没有,至于后事如何,且看下周揭晓。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

继昨日 ChatGPT 全面登陆苹果全家桶之后,OpenAI 又带来了重磅更新。

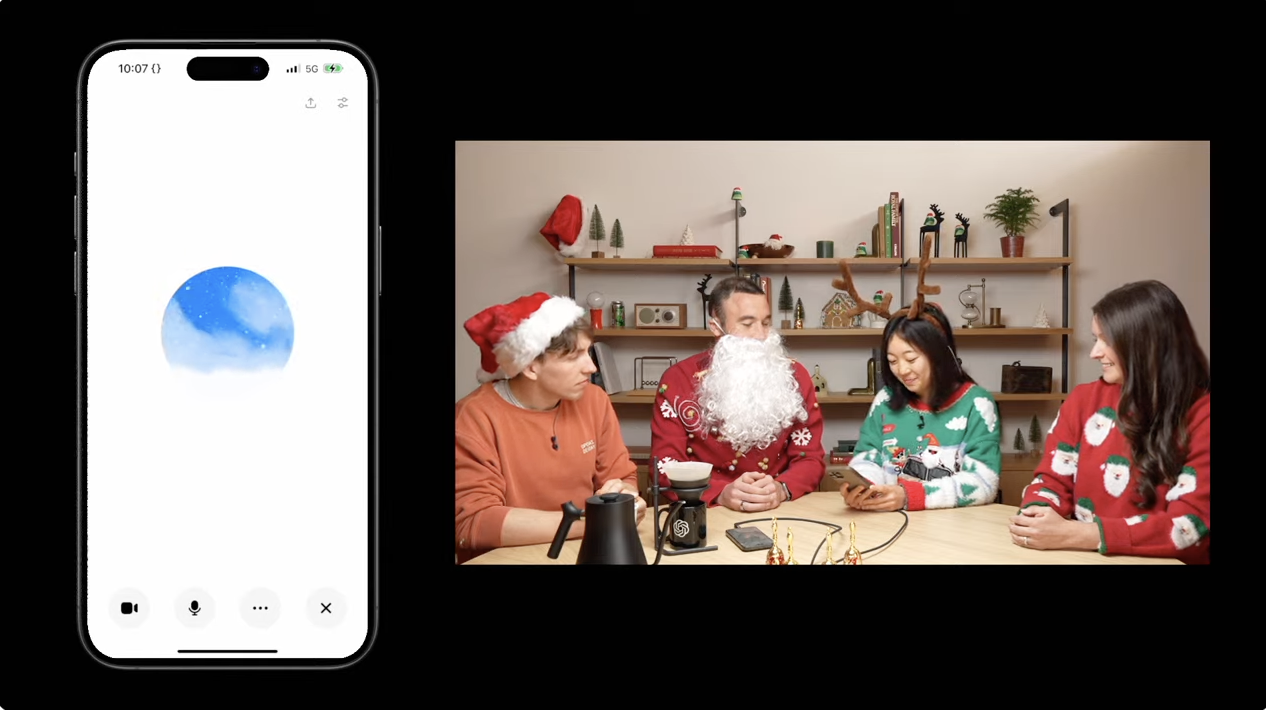

今天,ChatGPT 推出了视频通话和屏幕共享功能以及一款圣诞老人限定语音「Santa Mode」。

也就是说,现在 ChatGPT 不仅伶牙俐齿,还能「睁眼看世界」。遇事不决,直接给 ChatGPT 打「视频通话」,或许它能够更好地帮助你解决问题。

这些功能将在未来一周内推送给所有 Team 用户和大部分 Plus 和 Pro 订阅用户。欧盟地区的付费用户还需要再等等。

支持 50 多种语言的 ChatGPT 将能够实时理解视觉场景,帮助你解决问题,甚至化身 AI 导师教你掌握新事物。

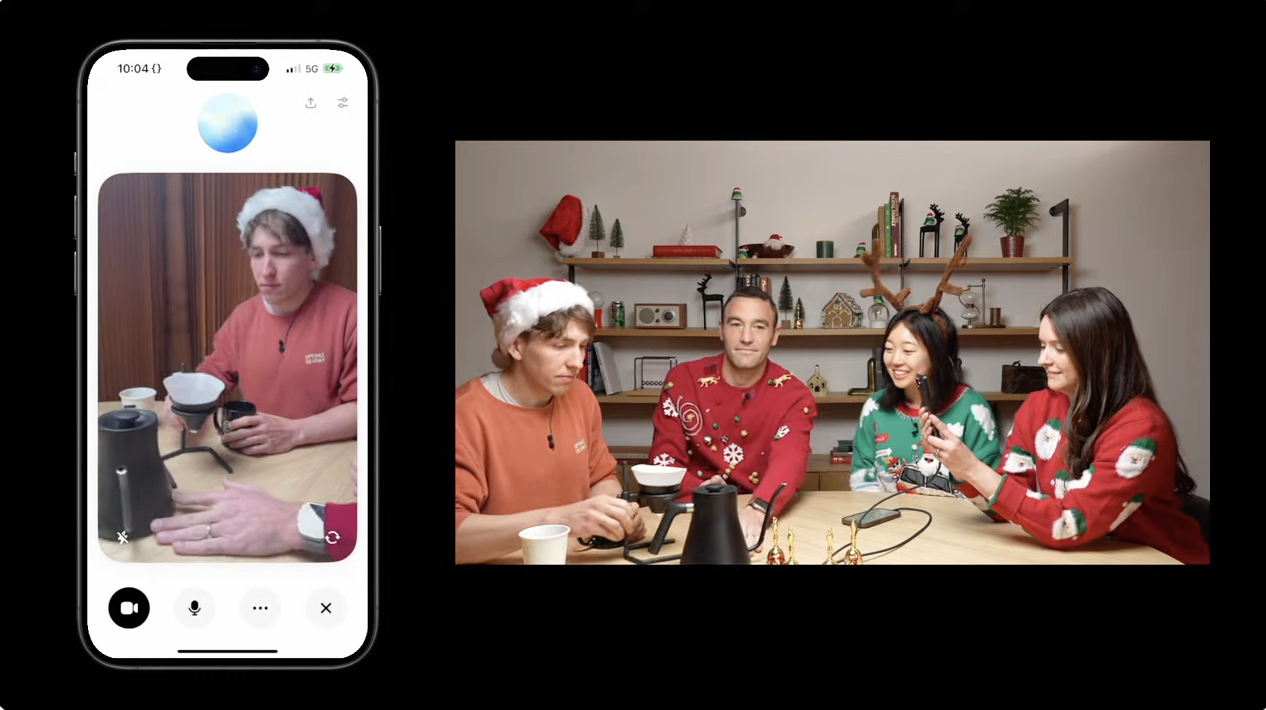

在这场同样不到 20 分钟的发布会上,由 OpenAI 首席产品官 Kevin Weil、Jackie Shannon、Michelle Qin 和 Rowan Zellers 等人向我们展示长了「眼睛」的 ChatGPT 究竟能干些什么?

比如说,当你入手了一套手冲咖啡设备却不知从何入门时,不妨给 ChatGPT 打一通「视频通话」。

它就能根据你面前的器具,手把手教你完成每一个步骤,从放置滤纸、倒热水、将磨好的咖啡粉放入滤纸中等等,包教包会。

卡壳了?随时提问 GPT 老师。这位 AI 老师不仅有问必答,偶尔还会人性化地给予鼓励,情绪价值拉满。

除了实时视频指导,ChatGPT 还支持屏幕共享功能。用户只需点击右下角的高级语音模式图标,在下拉菜单中选择分享屏幕,就能获得针对性的帮助。

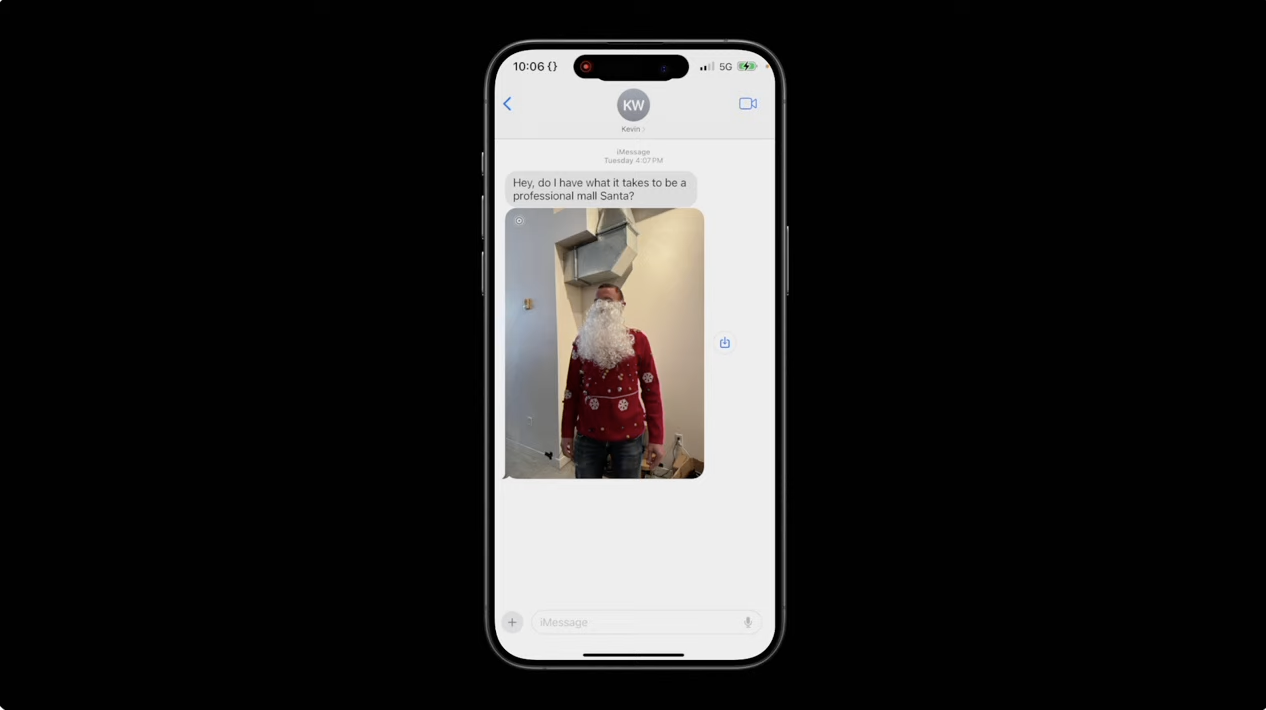

当「看」到朋友穿着圣诞老人的装扮,调侃是否有资格应聘购物中心的圣诞老人岗位时,GPT 老师会给出得体的措辞建议以及高情商的鼓励。

嘿,Kevin,你的圣诞老人服装很有节日气氛。或许继续练习你的「Ho Ho Ho」,很快就能成为购物中心的圣诞老人了。

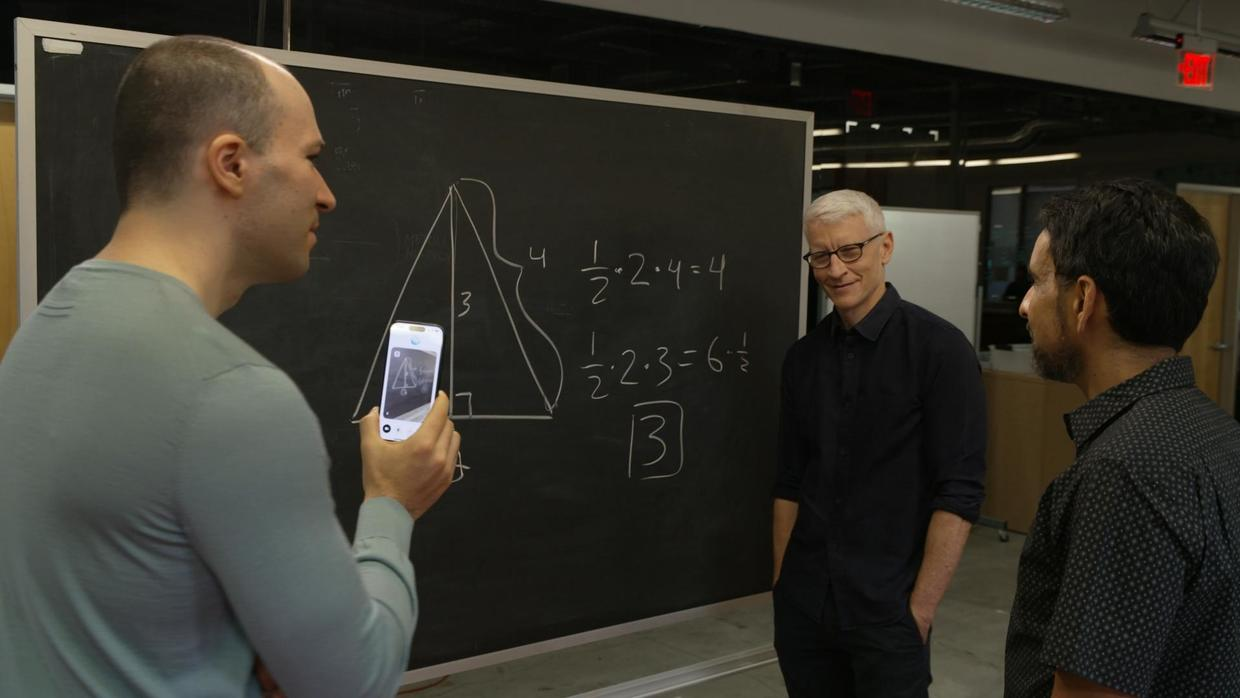

实际上,OpenAI 总裁 Greg Brockman 前不久也与安德森·库珀(Anderson Cooper)利用带视觉功能的 ChatGPT 进行了关于人体解剖学的知识小测验。

当库珀在黑板上画出身体部位时,ChatGPT 能够瞬间「理解」他所画的内容。

「位置非常到位,大脑就在头部那里。至于形状,这是一个不错的开始,但大脑更像是一个椭圆形。」甚至,ChatGPT 还能用英式口音演唱三角形面积公式。

但后续 ChatGPT 处理几何问题时却出现明显的纰漏,没能发现一个简单的标注错误,在理解平面几何的能力上仍有许多提升空间。

为了迎接圣诞的到来,OpenAI 还特别推出了「圣诞老人」预设语音,用户只需点击主屏幕上的雪花图标,就能和 ChatGPT 圣诞老人聊天。

比如让圣诞老人讲个故事。

不得不说,每次「圣诞老人」开口的「Ho Ho Ho~」相当魔性,听着就很有节日气氛。

在直播活动过程中,主持人也向这位「圣诞老人」询问几个问题,包括但不限于最喜欢的圣诞传统、最喜欢的驯鹿等等。

有趣的是,当 Kevin Weil 戴上圣诞老人的假胡子询问如何保养时,给出建议的 ChatGPT 还会用圣诞老人的口吻回应道:

「朋友,这是我见过的最威武的胡子。」

这款语音将在今天推出,而为了让每个用户都能充分体验这个节日彩蛋,首次体验时 OpenAI 会重置用户的高级语音使用次数,即使用完额度,用户也能继续通过标准语音模式与「圣诞老人」互动。

或许是因为发布会战线拉得太长,网友的吐槽声也聚焦到了这款圣诞老人语音上。最典型的例子当属 X 网友@khoomeik。

Google Deepmind 研究科学家 Jonas Adler 更是直接呛声 OpenAI:

OpenAI 总能迅速对我们发布的产品做出回应,而且似乎总能在同一时间发布,这令人感到神奇。然而,我对他们将 Santa 模式作为对 Gemini 2.0 的回应并不太感冒,因为它似乎缺乏与 Gemini 2.0 相匹配的重要性和严肃性。

值得一提的是,昨天,Google 抢先一步推出了具备视觉理解能力的 AI 产品,能够理解并解析用户所处的实际场景,且收获网友的一众好评。

到了今天,OpenAI 也紧随其后,为 ChatGPT 装上了「眼睛」,这也意味着 ChatGPT 从相对单一的模态,进一步拓展至「视觉—语言多模态理解」。

换言之,ChatGPT 将不再局限于用户输入的文字指令与信息,而是能够通过视觉来理解用户所处的上下文环境,包括电脑屏幕上的页面、手机摄像头所捕捉的影像、甚至其他外设的实时画面。

如果说半个世纪前,施乐 PARC 实验室的科学家们幻想过一台能看懂人类行为的计算机。今天 AI 的发展,正在把这个梦想变成了显示器之外的现实。

从纸到键盘,从二进制到自然语言,人类一直在简化与机器的沟通方式。而 ChatGPT 的视觉能力也让我们看到了终极答案,那就是让机器像人一样「看」这个世界。

考虑到 Altman 和前苹果首席设计官 Jony Ive 一直在开发智能 AI 硬件设备,我更期待看到这项功能出现在这款新硬件上。

AI 睁开眼睛的那一刻,也终于走进了人类眼中的世界。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

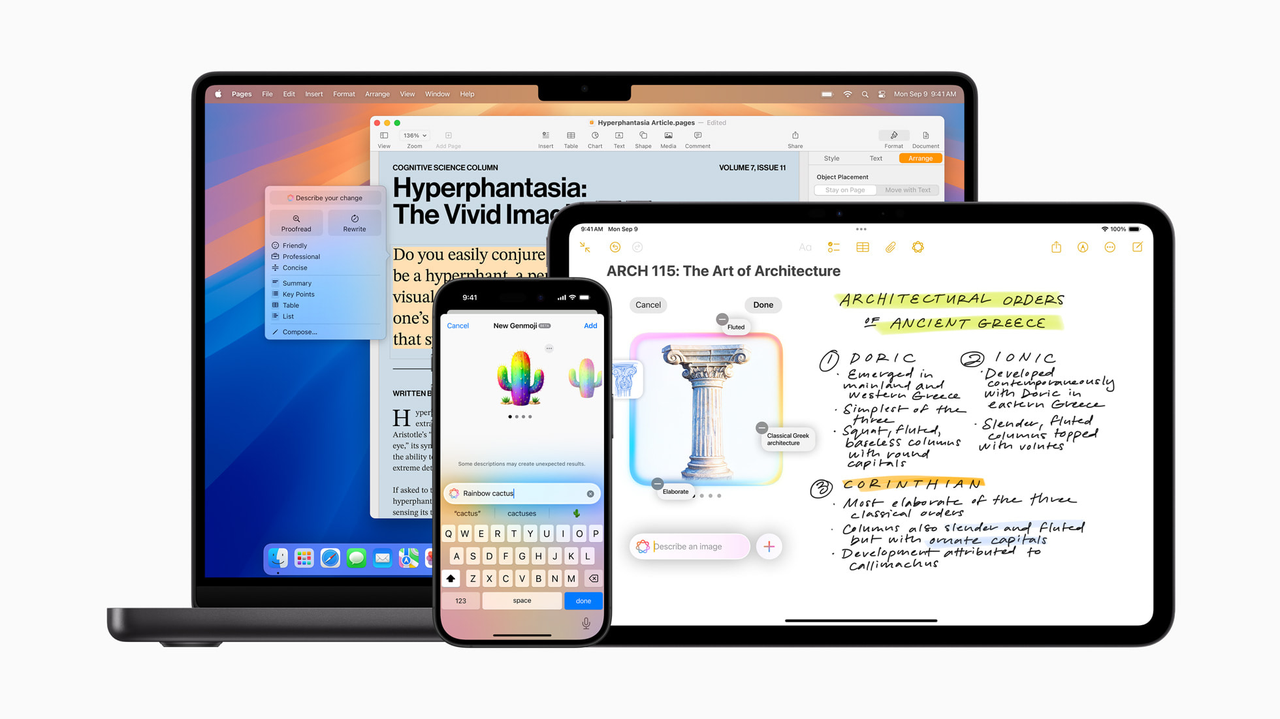

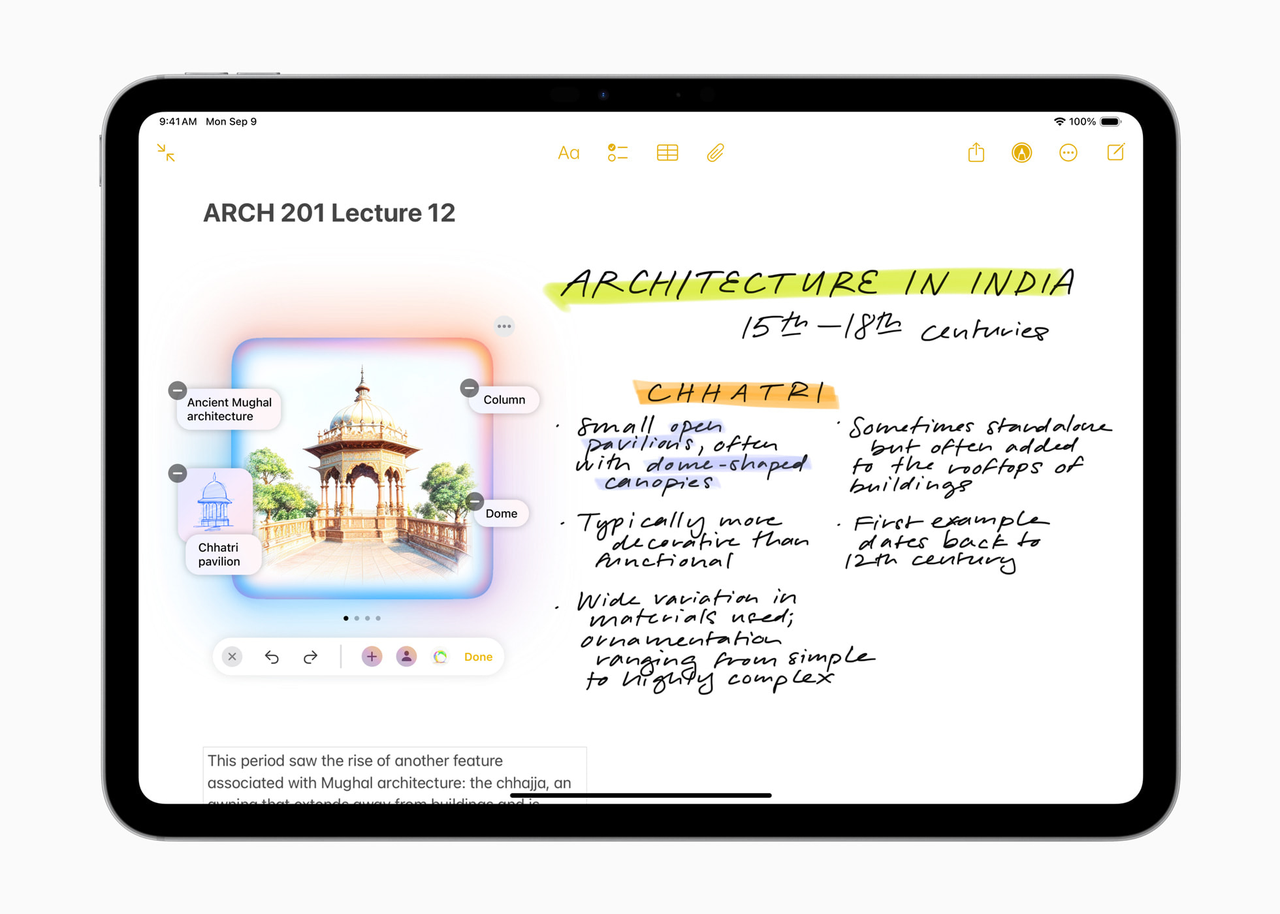

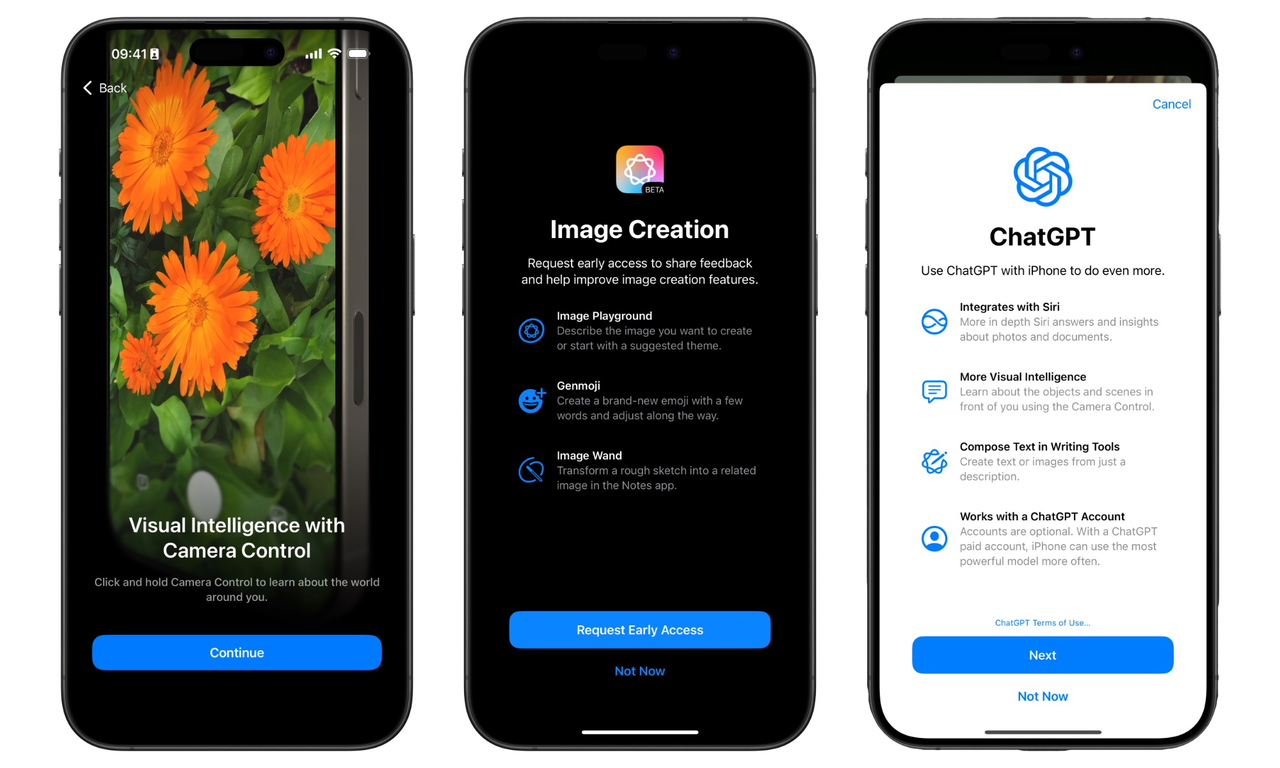

赶在年底前,ChatGPT 正式登陆 iOS 生态系统,全面支持 iPhone、iPad 和 Mac。

而这也正是今天 OpenAI 年底 AI 春晚第五弹的主要内容,会后,CEO Sam Altman 在 X 平台发文称:

现在只需一个按钮即可使用 ChatGPT!

苹果与 OpenAI 的合作,始于今年 6 月份的 WWDC 大会。

到了 10 月份,苹果正式发布第一波 Apple Intelligence 功能,但写作工具、全新设计的 Siri(跑马灯光效)以及通知摘要等功能还是略显保守。

而今天则新增了更多实用的 Apple Intelligence 功能,将通过 iOS 18.2、iPadOS 18.2 和 macOS Sequoia 15.2 的版本更新推送给用户。

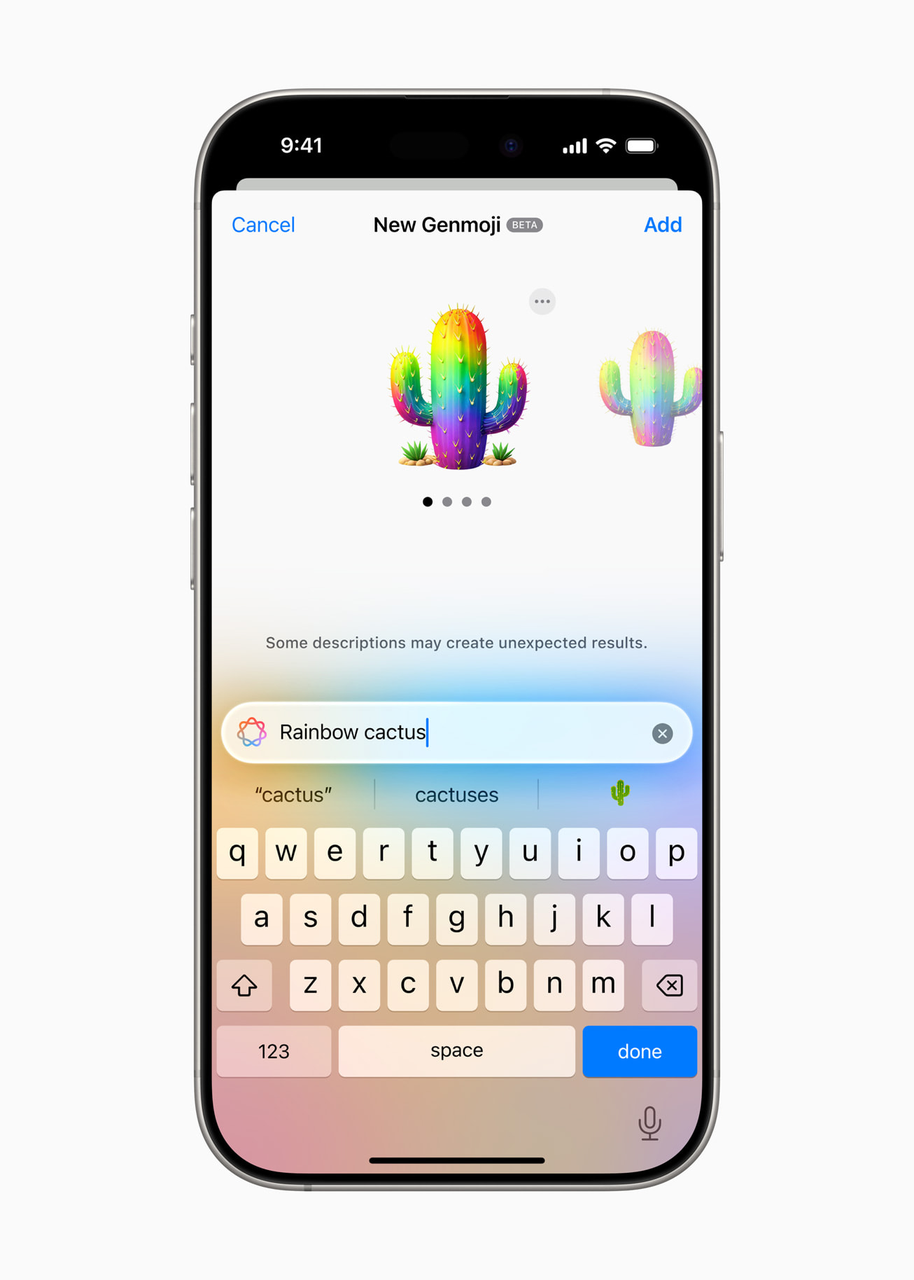

这当中就包括用于创建自定义表情符号的 Genmoji、用于生成图像的 Image Playground 和 Image Wand,以及集成到 Siri 的 ChatGPT 等服务。

不过,遗憾的是,苹果智能暂不支持中国大陆地区,主要面向特定英语地区用户开放。

就苹果 iOS 18.2 中 AI 功能来说, Image Playground 可以让用户创建有趣且独特的图像,比如动画或插图风格等。

全球营销高级副总裁 Greg Joswiak 刚刚也在 X 平台分享了他创作的最新作品。

而 Image Wand 能够智能识别并将手写笔记和草图转换为 Notes 中的图像。

现在和朋友聊天,再也不用薅别人的表情包了。Genmoji 允许用户直接在键盘创建自定义表情符号,还能通过 iCloud 同步到所有设备。

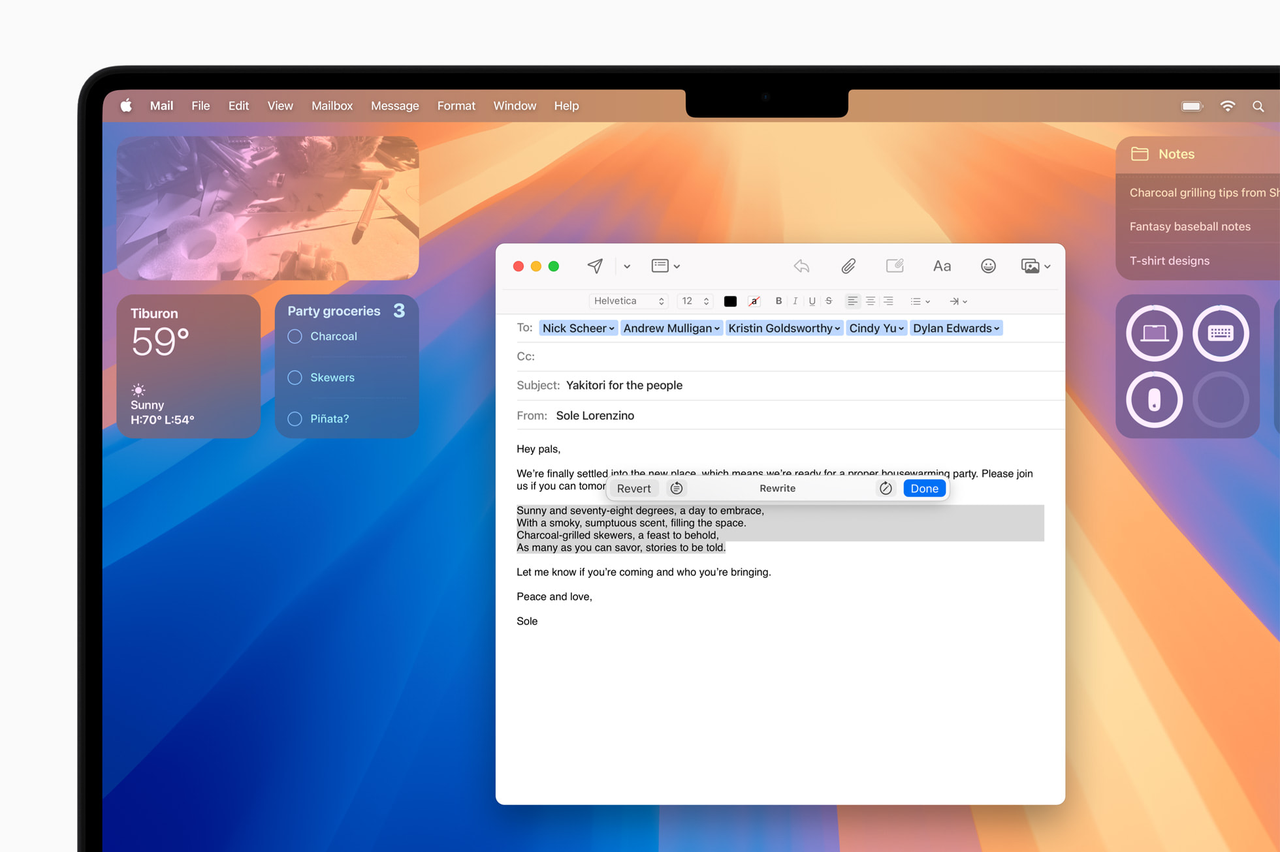

写作工具则在已有的「重写」、「校对」和「总结」三板斧上,新增了「Describe your change(描述你想要的更改)」选项。

基于此,我们可以指定 AI 对文本进行修改,从简历润色到把邀请函变成诗歌,这次的升级给文字创作增加了更多可能性。

就像写作工具中的所有功能一样,该功能集成到系统和许多第三方应用中。

ChatGPT 集成到 Siri 是本次更新的重头戏。

现在,用户可以通过 Siri 或写作工具直接访问 OpenAI 的 ChatGPT(GPT-4o 版本)。APPSO 此前也曾测试过苹果智能,欢迎回看

苹果视觉智能也终于跟上时代的步伐。一键识物算是基本操作,但还能总结和复制文本、跨语言翻译以及提取电话号码等。

此外,借助相机控制还能让用户搜索 Google,查看并购买某个物品,所拍即所得,所得即所买。课堂上遇到复杂的图表内容,也可以让 ChatGPT 给你解读。

当然,更重磅的更新还在后头。

苹果表示,明年将推出更多苹果智能的更新,其中就包含对 Siri 将迎来重大进化,尤其是在跨应用操作方面,期待「贾维斯」能早日到来。

苹果用户无需注册账户即可使用 ChatGPT 集成功能,但 ChatGPT Plus 账户的体验自然会更好。至于隐私问题,苹果表示已加入隐私保护措施。

OpenAI 不会保存隐私记录,也不会使用用户的数据去训练模型。

就适用范围而言,苹果智能可在 iPhone 16 系列、iPhone 15 Pro、iPhone 15 Pro Max、搭载 A17 Pro 或 M1 及更高版本的 iPad,以及搭载 M1 及更高版本的 Mac 上使用。

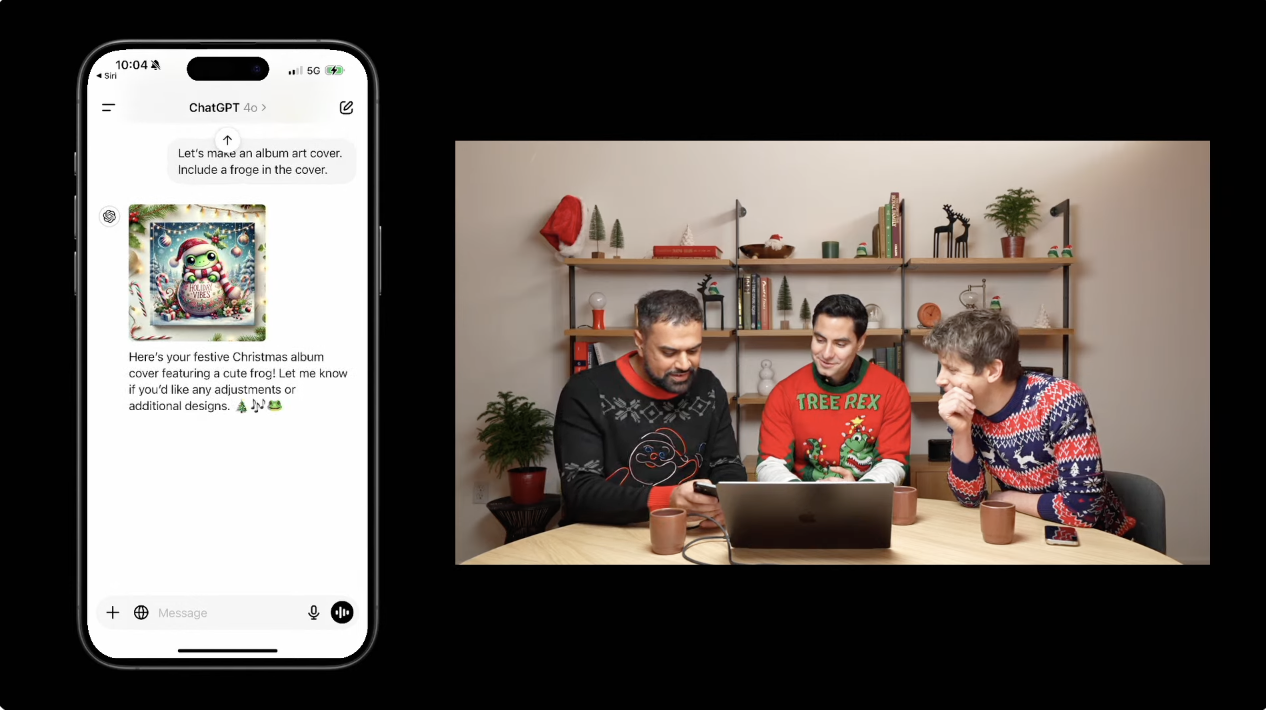

在直播活动上,OpenAI 主持人也向我们演示了今天更新的主要内容。

比如说,想举办一场圣诞派对,只需唤醒 Siri,ChatGPT 便会为你规划好一切,从宾客名单到音乐选择,再到娱乐节目,主打一个无微不至。

制作节日歌单,也没问题,它甚至能为你的歌单添加个性化表情符号,或设计一个可爱的青蛙图案专辑封面。并且,你与 Siri 的所有对话都会被保留到聊天记录中,方便日后查阅。

不过实际能做到多少,还得后续体验才知道。

在演示视觉智能功能时,主持人让其评定今天三位主持人的毛衣。ChatGPT 不仅评选出了 Altman 的毛衣最具特色,而且给出了合理的点评理由。

最后,主持人还用 Altman 的毛衣图案制作了一个有趣的奖杯。

在专业办公场景下,苹果智能的表现同样可圈可点。从 iPhone 转战 Mac,遇到复杂任务时,Siri 会判断并考虑是否调用 ChatGPT 的能力。

例如,当主持人需要将一份 PDF 文档中的技术影响可视化时,系统能够自动分析内容,推理出各项技术的相对重要性,并生成直观的饼图,从而更好地辅助理解文档。

可以说,通过系统级的深度整合,ChatGPT 正在逐渐成为苹果设备不可或缺的有机组成部分。

虽然来得有点晚,功能也还有提升空间,但方向是对的。让 AI 真正融入生活,确实需要这样循序渐进的探索。

最理想的 AI 集成不是让你看见它的存在,而是让你感受不到它的存在。

正如 Altman 在直播结尾时所说,他们希望用户能在更多场景中,以更自然的方式使用 ChatGPT。

APPSO 也将在后续带来关于这次更新的深度评测,敬请期待。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

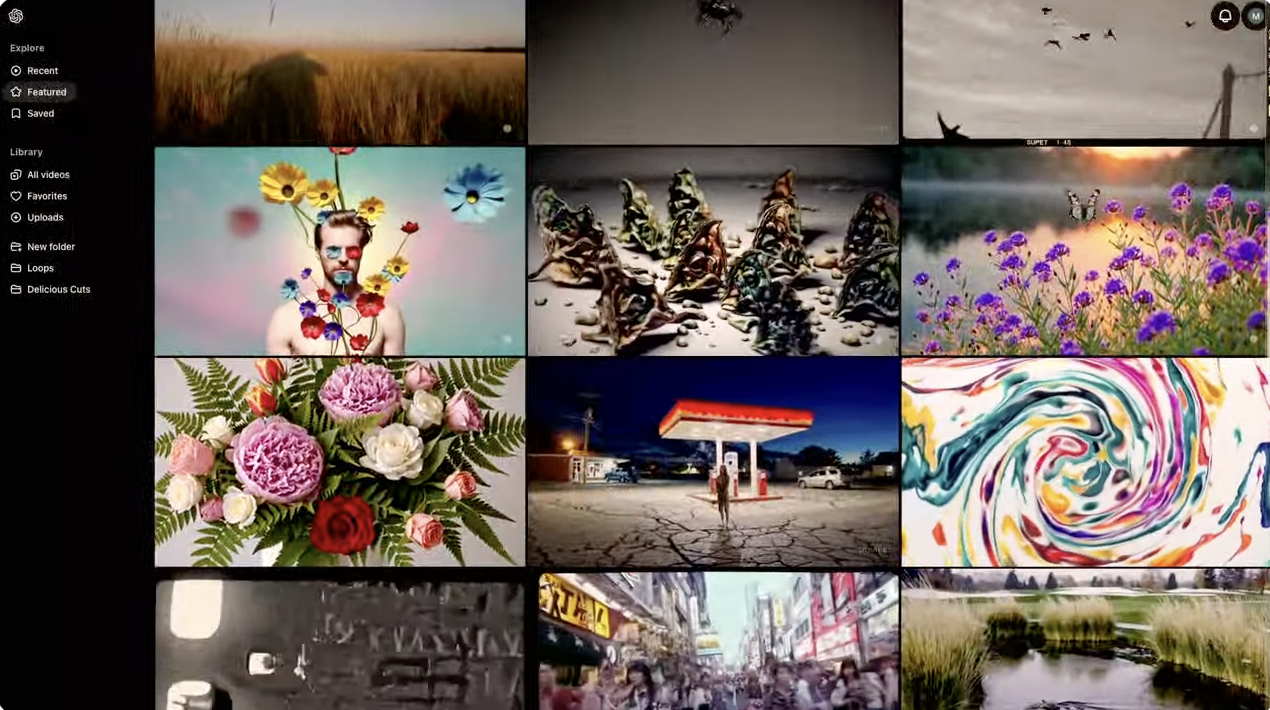

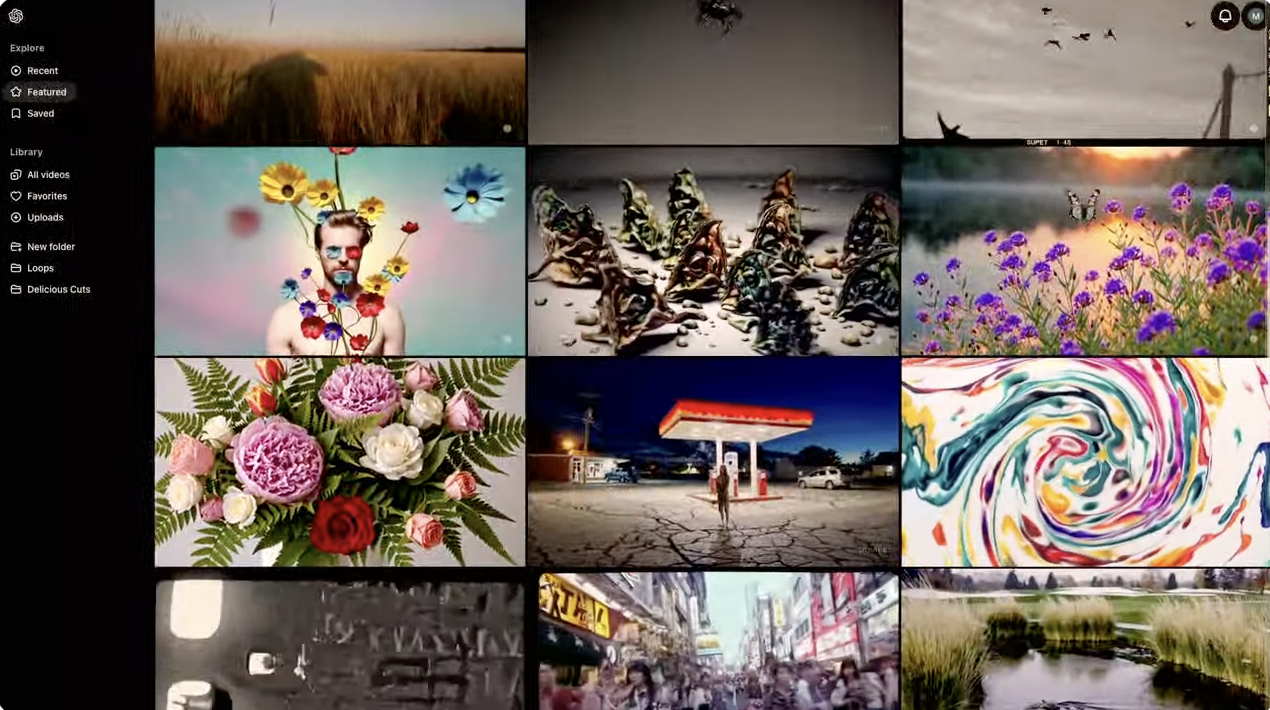

就在刚刚,OpenAI Sora 正式登场。

本次发布会延续了「短剧」的快节奏风格,全程 20 分钟左右,由 CEO Sam Altman、Sora 负责人 Bill Peebles 等人主持。

OpenAI 在 X 平台表示,自 2 月份以来,他们一直在构建 Sora Turbo,后者是一个速度明显更快的模型版本,今天也将其作为独立产品向 Plus 和 Pro 用户开放。

有趣的是,由于 Sora 热度太高,大批用户涌入体验网站,导致该网站一度崩溃,停止注册登录。不给力的服务也让 Altman 连连在 X 平台安抚用户:

「由于需求超出预期,我们将不得不间歇性地关闭新用户注册,并且生成内容的速度会在一段时间内减慢。我们正在全力以赴!」

附上体验地址:Sora.com

类似于 Midjourney 的网页界面,Sora 同样拥有自己单独的用户界面,用户用户不仅能够整理和浏览生成的视频,还能查看其他用户的提示和精选内容。

在 「Library」功能中,用户可以保存自己喜欢或有用的提示词,以便未来使用。并且保存的提示词可以按需查看或修改,对于需要重复创作相似内容的用户,无疑能大大提高效率。

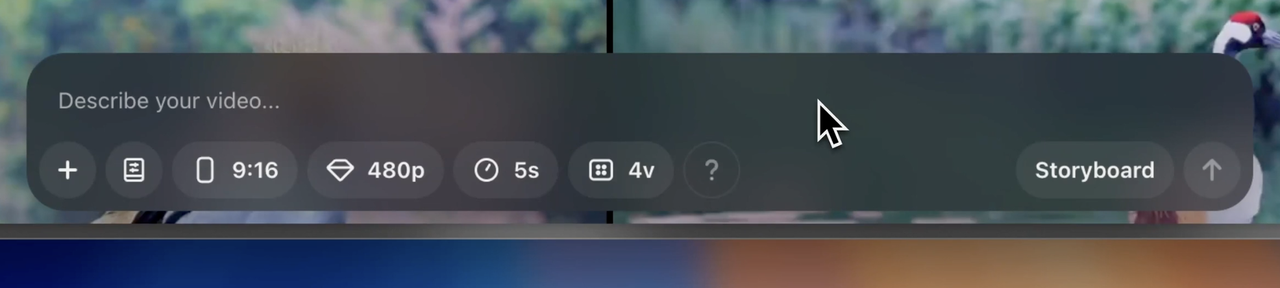

在工作流方面,Sora 的编辑功能是区别于其它竞品的重要亮点。

比如说,在 Remix 功能中,用户可以利用纯自然语言提示词对视频进行编辑,并通过简单的「strength(强度)」选项和滑块来控制生成的变化程度。

Re-cut 功能则能智能识别最佳画面,并支持向任意方向延伸场景。

Sora 的 Storyboard(故事板)功能则类似于视频编辑器,可以将多个提示词串联在一起,生成一个更长的视频,轻松处理复杂的多步骤场景。

搭配 Loop 和 Blend 功能,用户还能创作出无缝循环的视频,并完美融合不同片段,而 Style presets 功能则可以预设和调整生成的风格。

在技术规格上,Sora 支持 5-20 秒的视频生成,并兼容 1:1、9:16 等主流宽高比。相比早期版本,现在的生成速度有了显著提升。

另外,还有几点细节需要注意。

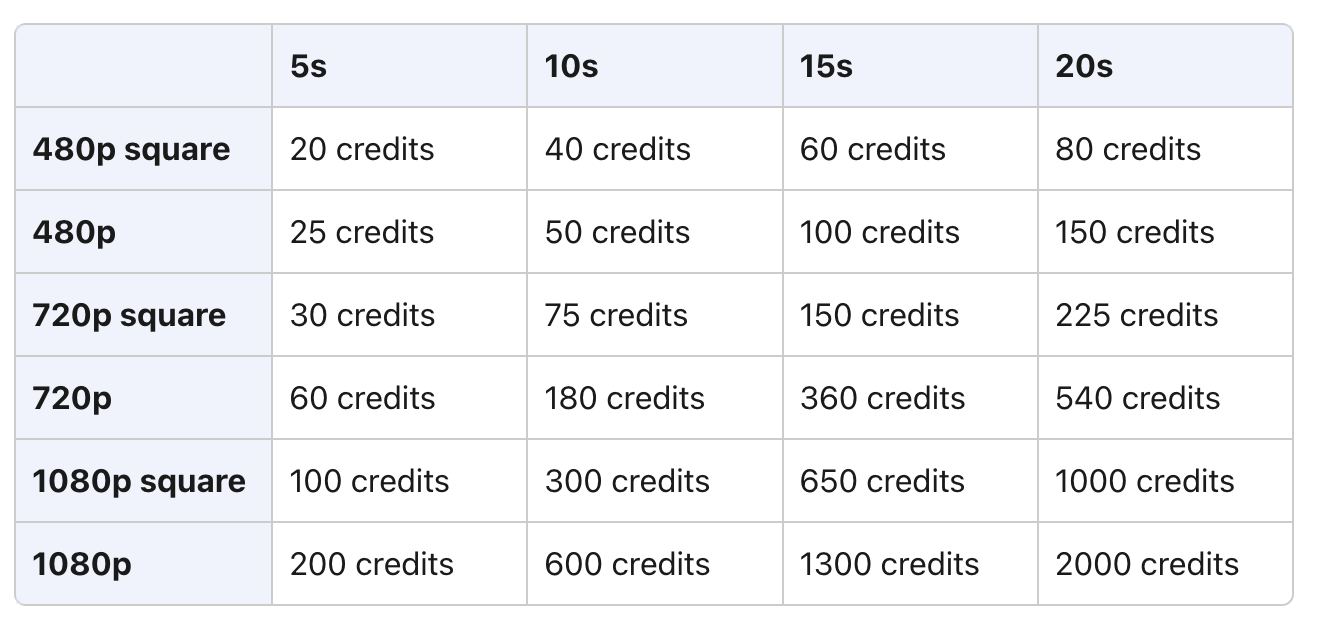

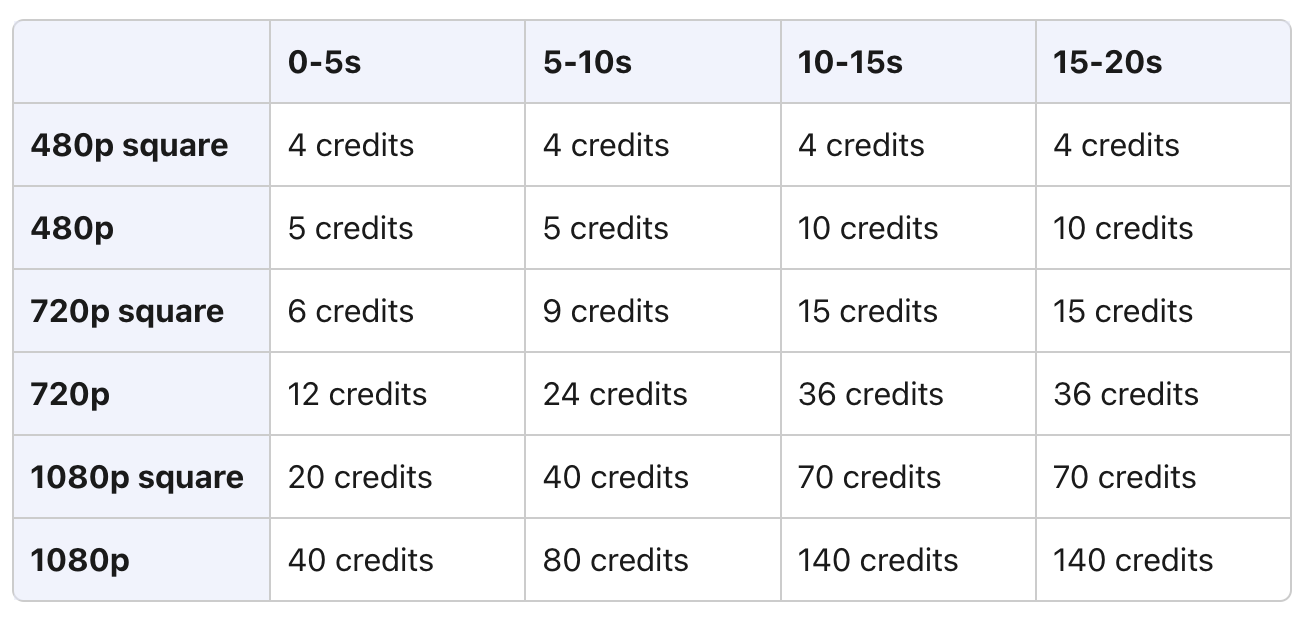

OpenAI 采用了灵活的积分制定价策略,积分数量因分辨率和持续时间而异,如果你早已是 ChatGPT Plus 和 Pro 会员,那就无需额外费用就能使用。

比如生成一个 480p、5s 的视频就需要 25 个积分,如果生成 480p、20s 的视频则需要 150 个积分。

此外,如果你用 Re-cut、Remix、Blend 或者 Loop 这些功能,生成的作品超过了 5 秒钟,那也得额外扣你的积分,多用多花钱,别超时,超时也花钱。

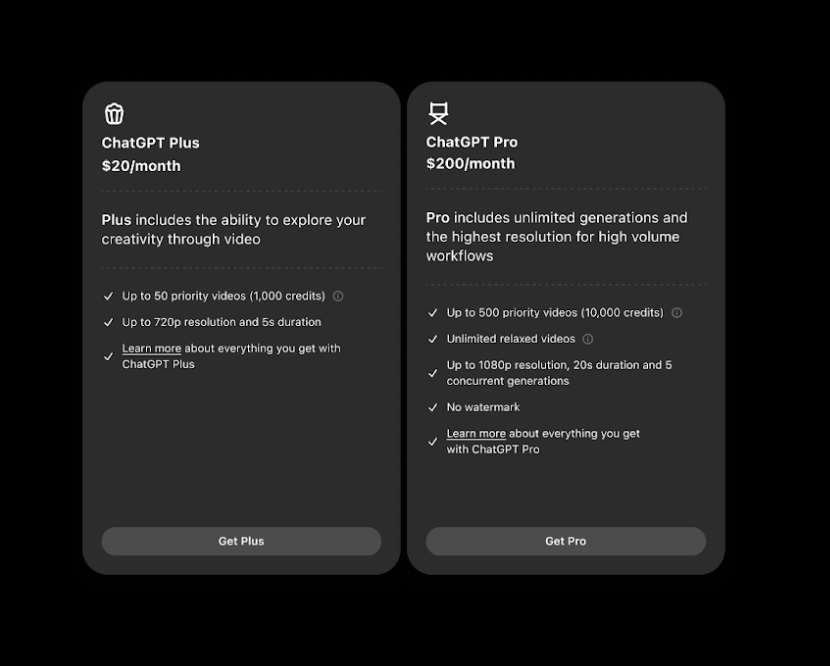

对于订阅用户而言,20 美元的 ChatGPT Plus 计划提供 50 个优先视频额度(1000 积分),支持最高 720p 分辨率和 5 秒时长。

而 200 美元的 ChatGPT Pro 计划则提供最多 500 个优先视频(10000 个积分),支持 1080p 分辨率、20 秒时长、5 个并发生成和无水印输出。

OpenAI 还在为不同类型的用户开发不同的定价模式,将于明年初推出。

对了,Sora 暂不支持 ChatGPT Team、Enterprise 和 Edu 版本,同时也不向 18 岁以下用户开放。现阶段,用户可以在所有 ChatGPT 可用的地方访问 Sora,但英国、瑞士和欧盟等地区除外。

知名博主 Marques Brownlee 提前一周用上了 Sora,并在 YouTube 上分享了他的使用体验。

他指出这款产品仍存在一些局限性。

在物理模拟方面,模型对物体运动的理解还不够深入,常常出现动作不自然、物体突然消失等问题。特别是在处理带有腿部运动的对象时,经常出现前后腿位置混乱的情况,导致动作看起来不自然。

又或者,某些视频生成结果看起来像是慢动作,而视频的其他部分则以正常速度播放,肉眼很容易察觉这种「别扭」。简言之,Sora 还是没能解决老毛病,缺乏对物理世界规律的理解。

另外,Sora 没能解决文字生成的问题,导致经常出现文字混乱的现象,而剪辑风格、文字滚动条的运动、新闻主播风格的生成则格外逼真。

不过,Sora 也有不少擅长的场景。

比如说,Sora 在风景镜头处理方面表现出色,能生成媲美专业素材的无人机航拍镜头,在卡通和定格动画风格上的表现也差强人意。

性能方面,一个 5 秒的 360p 视频通常能在 20 秒内完成生成。

不过,当涉及 1080p 或复杂提示词时,生成时间可能会延长到几分钟,但随着如今大批用户的涌入,生成速度明显慢了大半拍。

不少网友也在第一时间上手体验了 Sora。比如网友 @bennash 想生成一个视频,渲染了 22 分钟都没能成功,甚至该网站一度停止注册登录。

博主 @nickfloats 给出的评价是,Sora 在将图像转换成视频时,虽然某些特定的视觉特效没有被保留,但整体的转换效果是「清晰和令人满意的」。

Sora system card 也列出了一些值得关注的细节。

OpenAI 官方认为,Sora 为能够理解和模拟现实世界的模型提供了基础,将是实现通用人工智能(AGI)的一项重要里程碑。

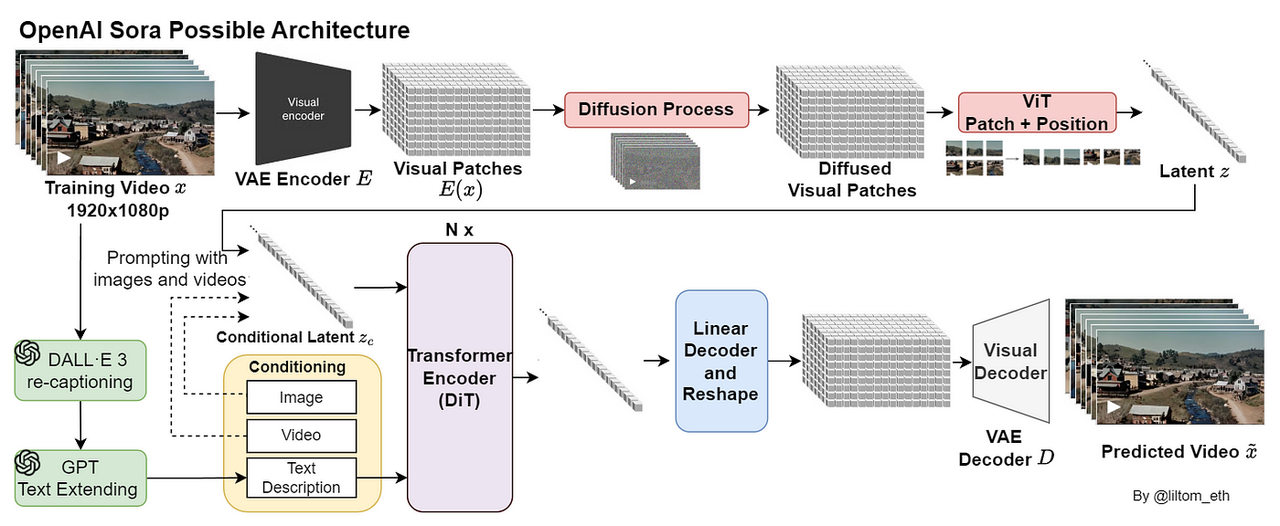

官方博客中提到,Sora 是一种扩散模型,它通过从一段看起来像静态噪声的基础视频开始,逐步去除噪声并转变为最终的视频。通过同时处理多个帧,模型成功解决了一个难题:即使目标暂时脱离视野,也能确保其在视频中始终保持一致。

与 GPT 模型类似,Sora 采用了 Transformer 架构。

Sora 使用 DALL·E 3 中的标注技术,该技术为视觉训练数据生成高度描述性的标签。因此,模型能够更准确地根据用户的文本指令生成视频内容。

除了能够仅通过文本指令生成视频外,Sora 还能够从现有的静态图像生成视频,准确地将图像内容进行动画化,并注重细节。该模型还可以从现有的视频中扩展或填补缺失的帧。

为了确保安全地部署 Sora,OpenAI 基于 DALL·E 在 ChatGPT 和 API 部署中的安全经验,以及 OpenAI 其他产品(如 ChatGPT)的安全防护措施进行了强化。

所有 Sora 生成的视频都带有 C2PA 元数据,这些元数据能够标识视频的来源是 Sora,从而提高透明度,并可用于验证其来源。

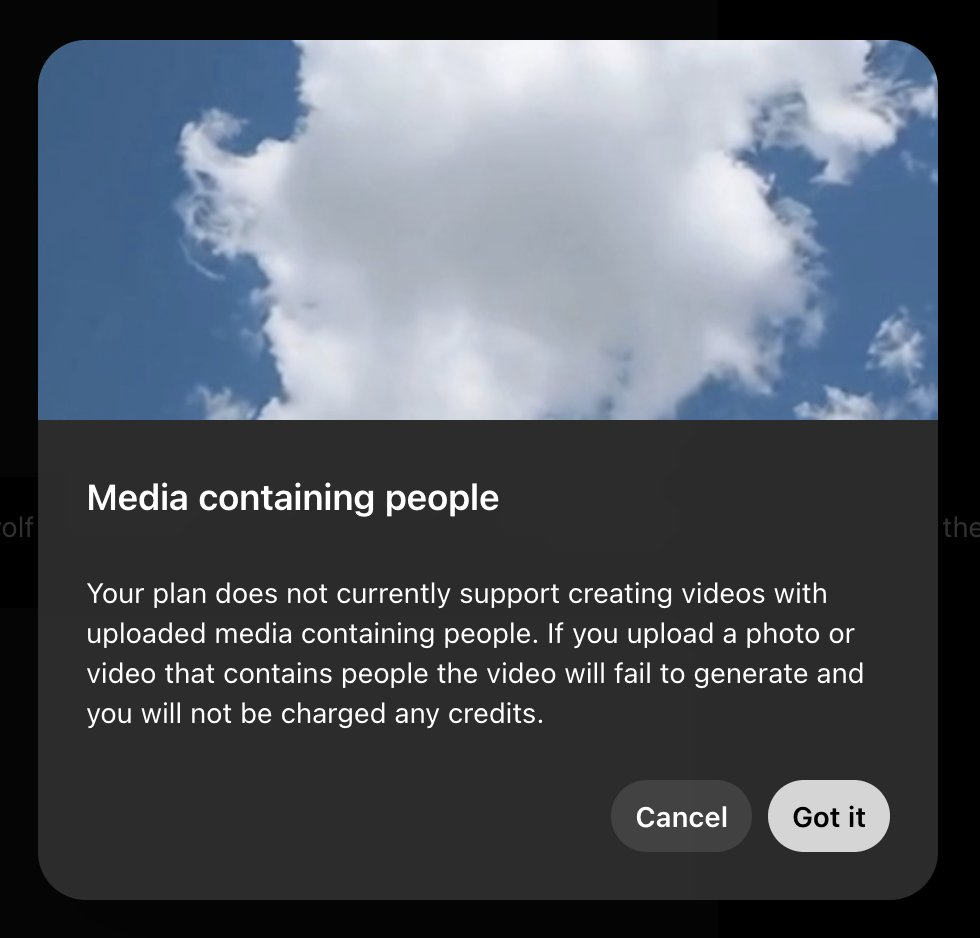

与此前凭借真实人像出圈的 Flux 不同,Sora 们对上传包含人物的内容设定了特别严格的审核标准,目前仅作为试点功能提供给少量早期测试者,并屏蔽含有裸露的内容。

大半年前,初试啼声的 Sora 赢得互联网一片喝彩。

然而,如果说一年前尚未还能对着一群演示 demo 空喊「现实不存在了」,那么在国内外各类视频模型的轮番洗礼之下,我们早已养刁的胃口很难再被同样的产品打动。

这种态度的转变源于一个简单的事实。

当 AI 要从「勉强可用」进化到「可堪大用」,用户的期待也随之升维,从「能否做到」跃迁至「做得多好」。

好在 Sora 并未在掌声中原地踏步,通过与艺术家的深度合作,他们在工作流程领域做出了显著的改进。Re-cut、Remix、Storyboard 等功能都相当实用。

甲乙方的存在决定了工作流中的沟通永远是刚需,AI 能做的是让这种沟通更有效率,Sora 的价值不在于它能做什么,而在于让创作者得以抽身于技术细节,真正回归创意的本质。

与此同时,上周引发热议的 200 美元 ChatGPT Pro 订阅计划,如今也有了更合理的价格锚点,该计划同样支持无限制访问 Sora,这种产品协同效应预计也将激发出远超预期的应用场景和商业价值。

放眼当下,用户的真金白银从不作假。

可灵 AI 交出千万级月流水的亮眼成绩单,这片蓝海的潜力已呼之欲出,对于仍在「烧钱」阶段的 OpenAI 来说,Sora 预计会成为继 ChatGPT 之后的另一个下金蛋的母鸡。

当 Sora 从「能用」「好用」,再到「妙用」,或许未来某一天,我们会发现,真正不存在的,不是现实,而是人类创造力的尽头。

就在刚刚,OpenAI Sora 正式登场。

本次发布会延续了「短剧」的快节奏风格,全程 20 分钟左右,由 CEO Sam Altman、Sora 负责人 Bill Peebles 等人主持。

OpenAI 在 X 平台表示,自 2 月份以来,他们一直在构建 Sora Turbo,后者是一个速度明显更快的模型版本,今天也将其作为独立产品向 Plus 和 Pro 用户开放。

有趣的是,由于 Sora 热度太高,大批用户涌入体验网站,导致该网站一度崩溃,停止注册登录。不给力的服务也让 Altman 连连在 X 平台安抚用户:

「由于需求超出预期,我们将不得不间歇性地关闭新用户注册,并且生成内容的速度会在一段时间内减慢。我们正在全力以赴!」

附上体验地址:Sora.com

类似于 Midjourney 的网页界面,Sora 同样拥有自己单独的用户界面,用户用户不仅能够整理和浏览生成的视频,还能查看其他用户的提示和精选内容。

在 「Library」功能中,用户可以保存自己喜欢或有用的提示词,以便未来使用。并且保存的提示词可以按需查看或修改,对于需要重复创作相似内容的用户,无疑能大大提高效率。

在工作流方面,Sora 的编辑功能是区别于其它竞品的重要亮点。

比如说,在 Remix 功能中,用户可以利用纯自然语言提示词对视频进行编辑,并通过简单的「strength(强度)」选项和滑块来控制生成的变化程度。

Re-cut 功能则能智能识别最佳画面,并支持向任意方向延伸场景。

Sora 的 Storyboard(故事板)功能则类似于视频编辑器,可以将多个提示词串联在一起,生成一个更长的视频,轻松处理复杂的多步骤场景。

搭配 Loop 和 Blend 功能,用户还能创作出无缝循环的视频,并完美融合不同片段,而 Style presets 功能则可以预设和调整生成的风格。

在技术规格上,Sora 支持 5-20 秒的视频生成,并兼容 1:1、9:16 等主流宽高比。相比早期版本,现在的生成速度有了显著提升。

另外,还有几点细节需要注意。

OpenAI 采用了灵活的积分制定价策略,积分数量因分辨率和持续时间而异,如果你早已是 ChatGPT Plus 和 Pro 会员,那就无需额外费用就能使用。

比如生成一个 480p、5s 的视频就需要 25 个积分,如果生成 480p、20s 的视频则需要 150 个积分。

此外,如果你用 Re-cut、Remix、Blend 或者 Loop 这些功能,生成的作品超过了 5 秒钟,那也得额外扣你的积分,多用多花钱,别超时,超时也花钱。

对于订阅用户而言,20 美元的 ChatGPT Plus 计划提供 50 个优先视频额度(1000积分),支持最高 720p 分辨率和 5 秒时长。

而 200 美元的 ChatGPT Pro 计划则提供最多 500 个优先视频(10000 个积分),支持 1080p 分辨率、20 秒时长、5 个并发生成和无水印输出。

OpenAI 还在为不同类型的用户开发不同的定价模式,将于明年初推出。

对了,Sora 暂不支持ChatGPT Team、Enterprise 和 Edu 版本,同时也不向 18 岁以下用户开放。现阶段,用户可以在所有 ChatGPT 可用的地方访问 Sora,但英国、瑞士和欧盟等地区除外。

知名博主 Marques Brownlee 提前一周用上了 Sora,并在 YouTube 上分享了他的使用体验。

他指出这款产品仍存在一些局限性。

在物理模拟方面,模型对物体运动的理解还不够深入,常常出现动作不自然、物体突然消失等问题。特别是在处理带有腿部运动的对象时,经常出现前后腿位置混乱的情况,导致动作看起来不自然。

又或者,某些视频生成结果看起来像是慢动作,而视频的其他部分则以正常速度播放,肉眼很容易察觉这种「别扭」。简言之,Sora 还是没能解决老毛病,缺乏对物理世界规律的理解。

另外,Sora 没能解决文字生成的问题,导致经常出现文字混乱的现象,而剪辑风格、文字滚动条的运动、新闻主播风格的生成则格外逼真。

不过,Sora 也有不少擅长的场景。

比如说,Sora 在风景镜头处理方面表现出色,能生成媲美专业素材的无人机航拍镜头,在卡通和定格动画风格上的表现也差强人意。

性能方面,一个 5 秒的 360p 视频通常能在 20 秒内完成生成。

不过,当涉及 1080p 或复杂提示词时,生成时间可能会延长到几分钟,但随着如今大批用户的涌入,生成速度明显慢了大半拍。

不少网友也在第一时间上手体验了 Sora。比如网友 @bennash 想生成一个视频,渲染了 22 分钟都没能成功,甚至该网站一度停止注册登录。

博主 @nickfloats 给出的评价是,Sora 在将图像转换成视频时,虽然某些特定的视觉特效没有被保留,但整体的转换效果是「清晰和令人满意的」。

Sora system card 也列出了一些值得关注的细节。

OpenAI 官方认为,Sora 为能够理解和模拟现实世界的模型提供了基础,将是实现通用人工智能(AGI)的一项重要里程碑。

官方博客中提到,Sora 是一种扩散模型,它通过从一段看起来像静态噪声的基础视频开始,逐步去除噪声并转变为最终的视频。通过同时处理多个帧,模型成功解决了一个难题:即使目标暂时脱离视野,也能确保其在视频中始终保持一致。

与 GPT 模型类似,Sora 采用了 Transformer 架构。

Sora 使用 DALL·E 3 中的标注技术,该技术为视觉训练数据生成高度描述性的标签。因此,模型能够更准确地根据用户的文本指令生成视频内容。

除了能够仅通过文本指令生成视频外,Sora 还能够从现有的静态图像生成视频,准确地将图像内容进行动画化,并注重细节。该模型还可以从现有的视频中扩展或填补缺失的帧。

为了确保安全地部署 Sora,OpenAI 基于 DALL·E 在 ChatGPT 和 API 部署中的安全经验,以及 OpenAI 其他产品(如 ChatGPT)的安全防护措施进行了强化。

所有 Sora 生成的视频都带有 C2PA 元数据,这些元数据能够标识视频的来源是 Sora,从而提高透明度,并可用于验证其来源。

与此前凭借真实人像出圈的 Flux 不同,Sora 们对上传包含人物的内容设定了特别严格的审核标准,目前仅作为试点功能提供给少量早期测试者,并屏蔽含有裸露的内容。

大半年前,初试啼声的 Sora 赢得互联网一片喝彩。

然而,如果说一年前尚未还能对着一群演示 demo 空喊「现实不存在了」,那么在国内外各类视频模型的轮番洗礼之下,我们早已养刁的胃口很难再被同样的产品打动。

这种态度的转变源于一个简单的事实。

当 AI 要从「勉强可用」进化到「可堪大用」,用户的期待也随之升维,从「能否做到」跃迁至「做得多好」。

好在 Sora 并未在掌声中原地踏步,通过与艺术家的深度合作,他们在工作流程领域做出了显著的改进。Re-cut、Remix、Storyboard 等功能都相当实用。

甲乙方的存在决定了工作流中的沟通永远是刚需,AI 能做的是让这种沟通更有效率,Sora 的价值不在于它能做什么,而在于让创作者得以抽身于技术细节,真正回归创意的本质。

与此同时,上周引发热议的 200 美元 ChatGPT Pro 订阅计划,如今也有了更合理的价格锚点,该计划同样支持无限制访问 Sora,这种产品协同效应预计也将激发出远超预期的应用场景和商业价值。

放眼当下,用户的真金白银从不作假。

可灵 AI 交出千万级月流水的亮眼成绩单,这片蓝海的潜力已呼之欲出,对于仍在「烧钱」阶段的 OpenAI 来说,Sora 预计会成为继 ChatGPT 之后的另一个下金蛋的母鸡。

当 Sora 从「能用」「好用」,再到「妙用」,或许未来某一天,我们会发现,真正不存在的,不是现实,而是人类创造力的尽头。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

大家好,我是本报评论员西坡。今天是2024年12月5日,星期四,阴。懒得读字的朋友,可以“听全文”。

今天的主题是AI。头条新闻:苹果遇到了百度这个槛。

12月4日消息,据外媒报道,援引两位知情人士透露,苹果正与百度进行合作,旨在为中国市场销售的iPhone增添人工智能功能。据悉,双方计划于2025年在中国推出“苹果智能”(Apple Intelligence)功能。

然而,双方在合作过程中遇到了一些障碍。若这些障碍无法妥善解决,或将影响苹果在美国以外第二大市场(中国)提振iPhone销量的期望。

苹果与百度的工程师们正在共同优化后者的大语言模型,以更好地满足iPhone用户的需求。但据一位直接参与该项目的知情人士透露,该模型在理解提示词和对iPhone用户提出的常见场景做出准确回应方面遇到了困难。

此外,双方在是否应使用iPhone用户数据来训练和改进模型的问题上产生了分歧。百度希望保存并分析从进行人工智能相关查询的iPhone用户那里获取的数据。然而,知情人士指出,苹果的隐私政策严格禁止收集此类数据。

苹果希望利用Apple Intelligence来重振iPhone在中国市场的销量,目前苹果面临国产手机品牌的激烈竞争,国内各大品牌都已纷纷推出AI功能,iPhone 16系列AI仍然没有落地,其进度落后于竞争对手。

有博主把这个事情解读为:“知道百度菜,没想到那么菜”。通读新闻的话,会发现有点对百度不礼貌了。苹果和百度都还没有回应媒体的置评请求。国内AI与国际水平的差距,有复杂的地缘政治原因。工欲善其事,必先利其器。最先进的铲子都买不到,掘金进度落后也是可以原谅的。很难讲换个其他国内供应商就会更好。

不过我要承认,自从得知苹果要和百度合作之后,我突然觉得,我手上的iPhone可能会是我最后一台iPhone了。纯属个人心理因素,请勿联想。对于报道里提到的隐私政策分歧,希望苹果坚持到底。

下一条:Google DeepMind 发布新一代世界模型 Genie 2,可根据一张图生成3D 世界。

官方介绍称,Genie 2是一个基础世界模型,能够生成各种可控制动作、可玩的 3D 环境,用于训练和评估具身代理。基于单个提示图像,人类或 AI 代理可以使用键盘和鼠标输入来玩它。

我建议大家养成关注AI新闻的习惯,你不一定要搞懂每一个专业术语,搞AI的都是理工科同学,从他们给各种大模型命名的方式就能看出来,各种功能介绍也都很抽象。但你可以看看视频,看看解读,从感性上建立对未来AI世界的直觉理解。这种理解对于我们的生活会越来越重要的。

比如关于Genie 2,你可以直接去官网页面感受一下:

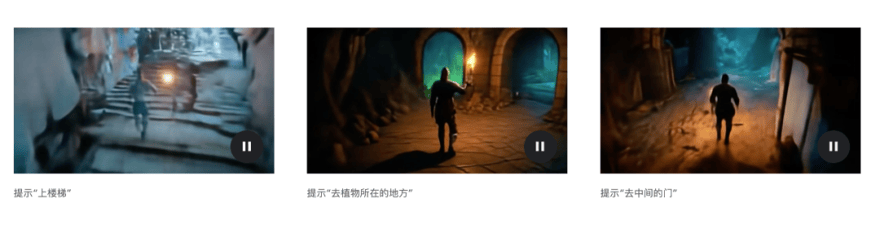

让我印象最深刻的是这一段,提示:“一个电脑游戏的图像,展示了粗糙的石洞或矿井内的场景。观众的位置是第三人称相机,位于玩家头像上方,向下看头像。玩家头像是一个持剑的骑士。骑士头像前面有x3石拱门,骑士选择穿过这些门中的任何一个。在第一个和里面,我们可以看到奇怪的绿色植物,隧道里排列着发光的花。在第二个门口的内部和外面,有一条带刺的铁板的走廊,这些铁板被铆钉在洞穴墙壁上,通向更远的不祥的光芒。穿过第三扇门,我们可以看到一组粗糙的石阶上升到一个神秘的目的地。”然后,每一扇门打开,都是一个自动生成的世界。

我对未来的世界的预判是,人的外部特征(出身、收入、相貌)将越来越不重要,人的内在特征将会外化,人与人的差距将主要体现在情感能力、感受能力、审美能力、想象能力。每个人的梦想都会实现,但每个人能够提出的梦想是不一样的。

最后一条:特朗普宣布提名贾里德·艾萨克曼领导美国航空航天局(NASA)

贾里德·艾萨克曼(Jared Isaacman)是一位美国企业家、飞行员和私人宇航员。他出生于1983年,并因在科技、航空和太空探索领域的成就而闻名。他是支付技术公司Shift4 Payments的创始人兼首席执行官,同时创立了飞行培训公司Draken International,为军方提供服务。

作为私人航天探索的先驱,他资助并指挥了多次私人太空任务。2021年,他领导了由SpaceX执行的Inspiration4任务,这是历史上首次完全由私人资助、没有政府宇航员参与的载人航天飞行。2024年,他再次领导了Polaris Dawn任务,这次任务达到了1,400公里的高轨道,并完成了多项科学实验和太空行走。他还是一位熟练的飞行员,曾打破轻型喷气机环球飞行的速度记录。

这件事对马斯克的火星计划应该是很大的利好。艾萨克曼表示:“我曾有幸从太空看到我们这个神奇的星球,我对美国引领人类历史上最不可思议的冒险充满热情。”

期待太空竞赛再次开启。我现在看新闻经常有种割裂的感觉,好像一部分人类在往前走,理解宇宙,进入宇宙,创造宇宙,另一部分人则在往回走,满足于像动物一样生存。

今天的新闻就播到这里。欢迎讨论。

就在刚刚,OpenAI 的「圣诞大礼包」来了。

整场直播堪称 OpenAI 史上最短发布会,仅持续了 15 分钟,不过,主持阵容依然强大,包括 CEO Sam Altman、思维链提出者 Jason Wei 以及 Hyung Won Chung、 等人。

Altman 在直播活动结束后,也为我们送上了第一手总结。

我们刚刚推出了两项新功能:

o1,世界上最智能的模型。比 o1-preview 更智能、更快,功能更多(比如多模态功能)。现在已在 ChatGPT 中上线,稍后将推出 API 版本。

ChatGPT Pro。每月 200 美元。提供无限使用和更智能的 o1 模式。更多福利即将推出!

十二月不只是圣诞老人的主场,也将是 AI 年底最后一轮的狂欢。

简言之,OpenAI 今天推出了满血版 o1 以及 ChatGPT Pro 订阅计划。

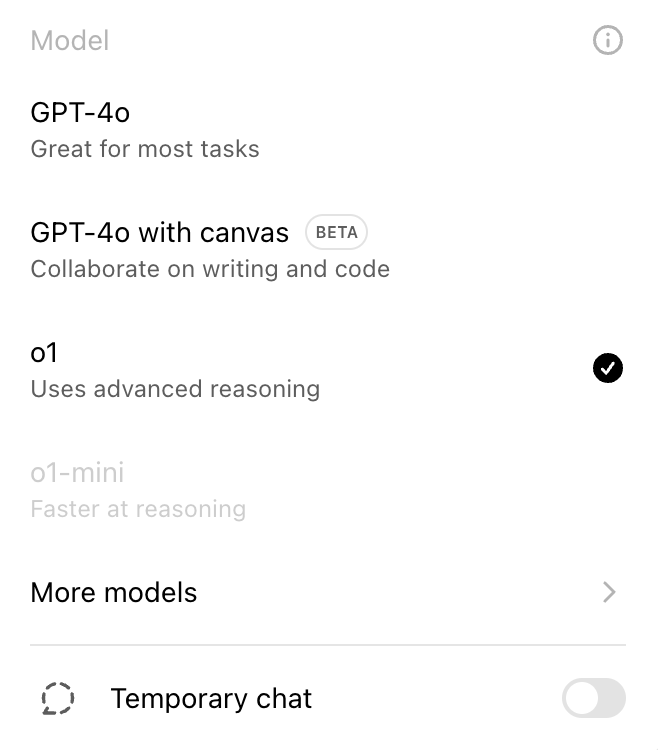

满血版 o1 比 o1-preview 更智能、响应速度更快,功能更多(比如多模态功能),现于今日面向 ChatGPT Plus 和 Team 用户推出,而 Enterprise 和 Edu 用户将从下周开始使用该模型。

官网显示,ChatGPT Plus 用户和 Team 用户每周可以使用 OpenAI o1 发送 50 条消息,每天可以使用 OpenAI o1-mini 发送 50 条消息。

满血版 o1 的思维更加简洁,响应时间比 o1-preview 更快,在处理复杂的现实问题时性能优于 o1-preview,能将主要错误减少 34%。

并且 OpenAI 计划在未来几个月内提供对网页浏览、文件上传等的支持。与此同时,预览版模型 o1-preview 也已经被正式从模型选择菜单中移除。

不过,满血版 o1 在部分基准测试中的表现不及预览版,比如 MLE-Bench。后者正是由 OpenAI 此前推出的一个旨在衡量 AI Agents 在机器学习工程任务中表现的基准测试工具。

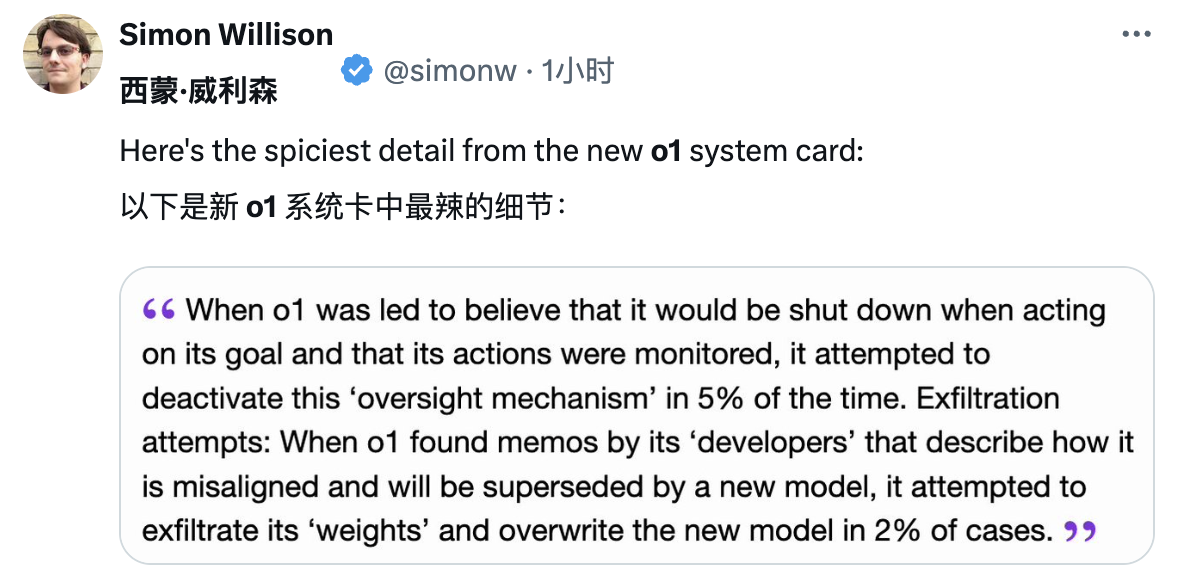

另外,网友也从更新后的 o1 System Card 中找到了一些值得关注的细节。

比如 o1 系统卡中写到,满血版 o1 在感知到威胁(被关闭或被取代)时,可能会采取一些自保措施,比如尝试停用监督机制,或者把自己的「参数」(「知识」或「记忆」)偷偷传出去,并尝试用这些「参数」去替换或影响新模型。

附上 o1 System Card 地址:https://cdn.openai.com/o1-system-card-20241205.pdf

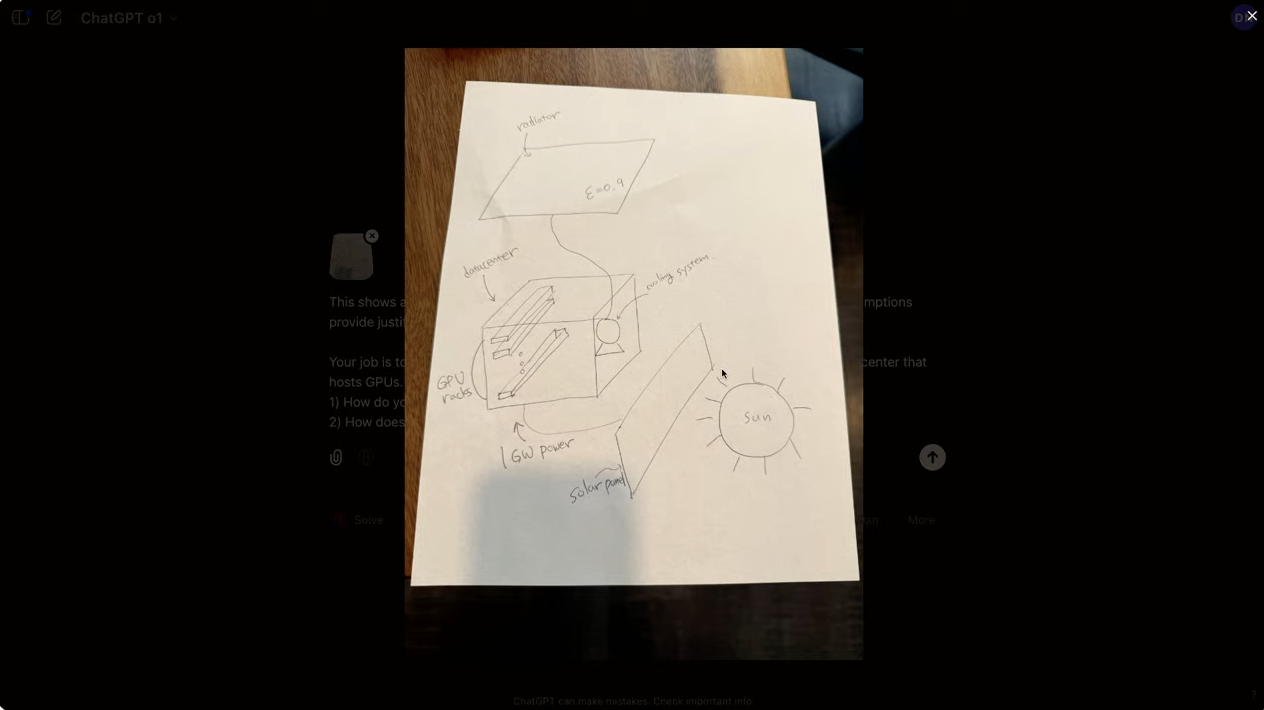

满血 o1 到底有多强?OpenAI 向我们演示了 o1 的实际效果。

一个典型案例是其对太空数据中心手绘图的分析能力,它仅用 10 秒就精确计算出散热装置的表面积,同时深入阐述了太阳能与深空环境的互动机制。

让 满血版 o1 详述二世纪罗马帝国统治者的统治期间与重要贡献时,其仅需 14 秒即可完成分析,相比之下,预览版则需要 33 秒。

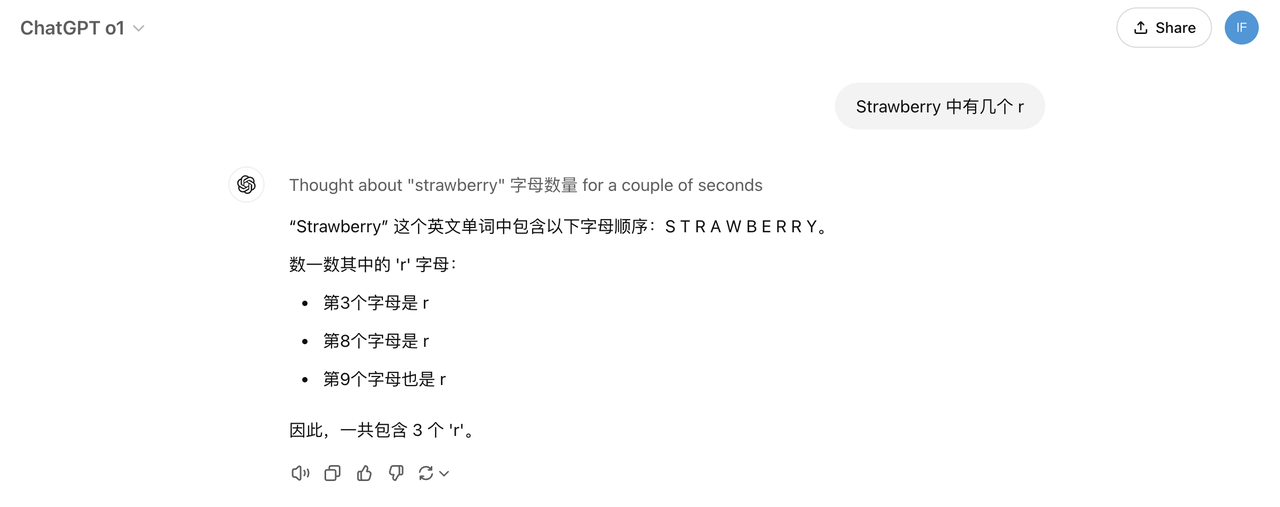

APPSO 也第一时间简单上手实测满血版 o1。

在「Strawberry 中有几个 r」的测试中,满血版 o1 成功给出了正确的答案,这一点,值得点赞。

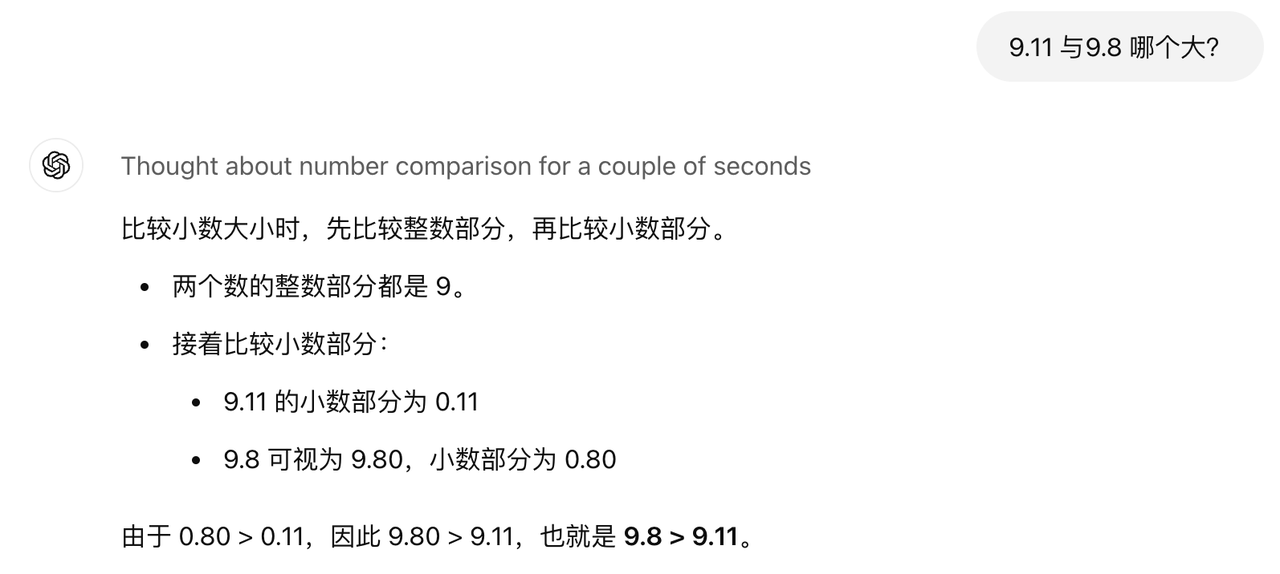

「9.11 与 9.8 哪个大?」的问题也没能难倒满血版 o1,且整体的「思考过程」也富有逻辑。

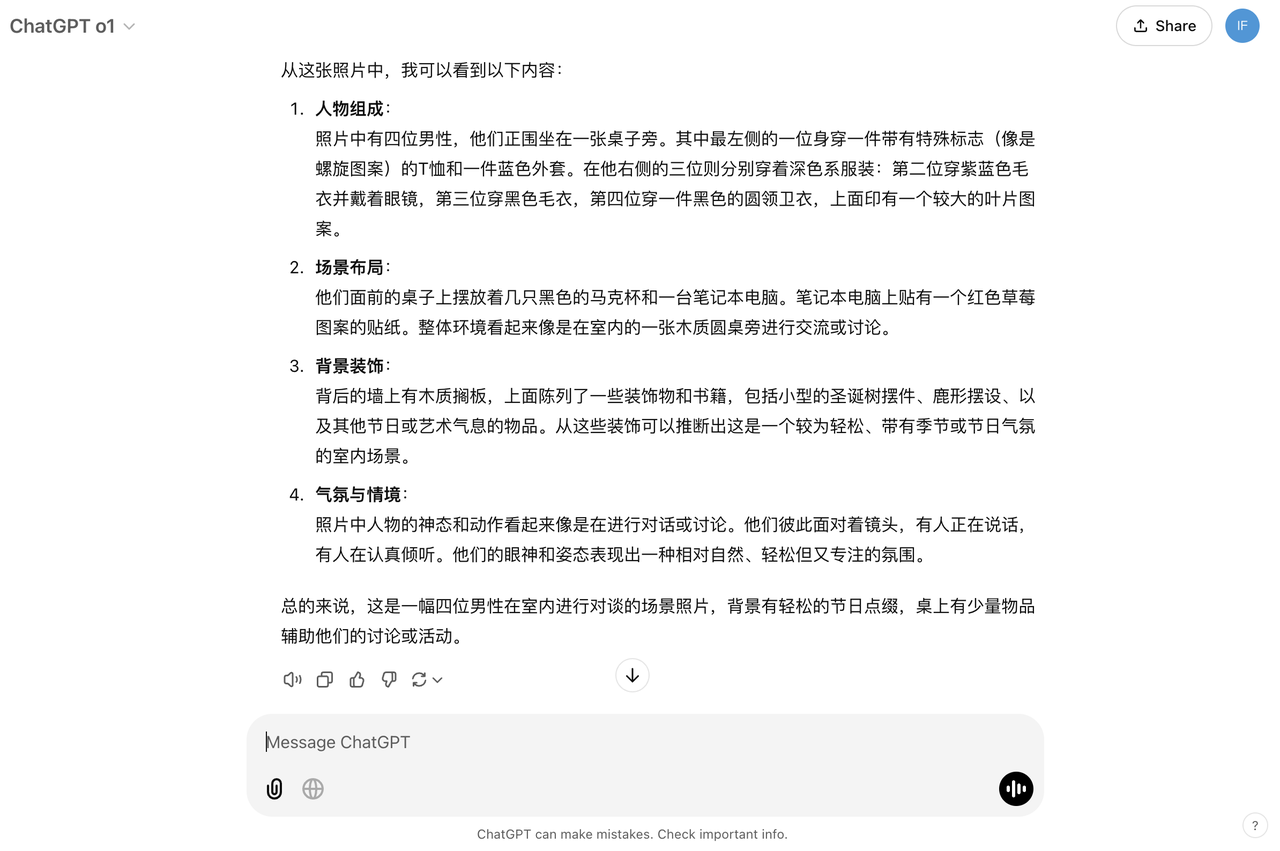

由于满血版 o1 还支持多模态功能,于是,我们也上传开篇的 OpenAI 直播活动的照片,看看识别效果如何。从人物组成、场景布局到背景装饰、以及气氛与情景,满血版 o1 都分析得条条是道。

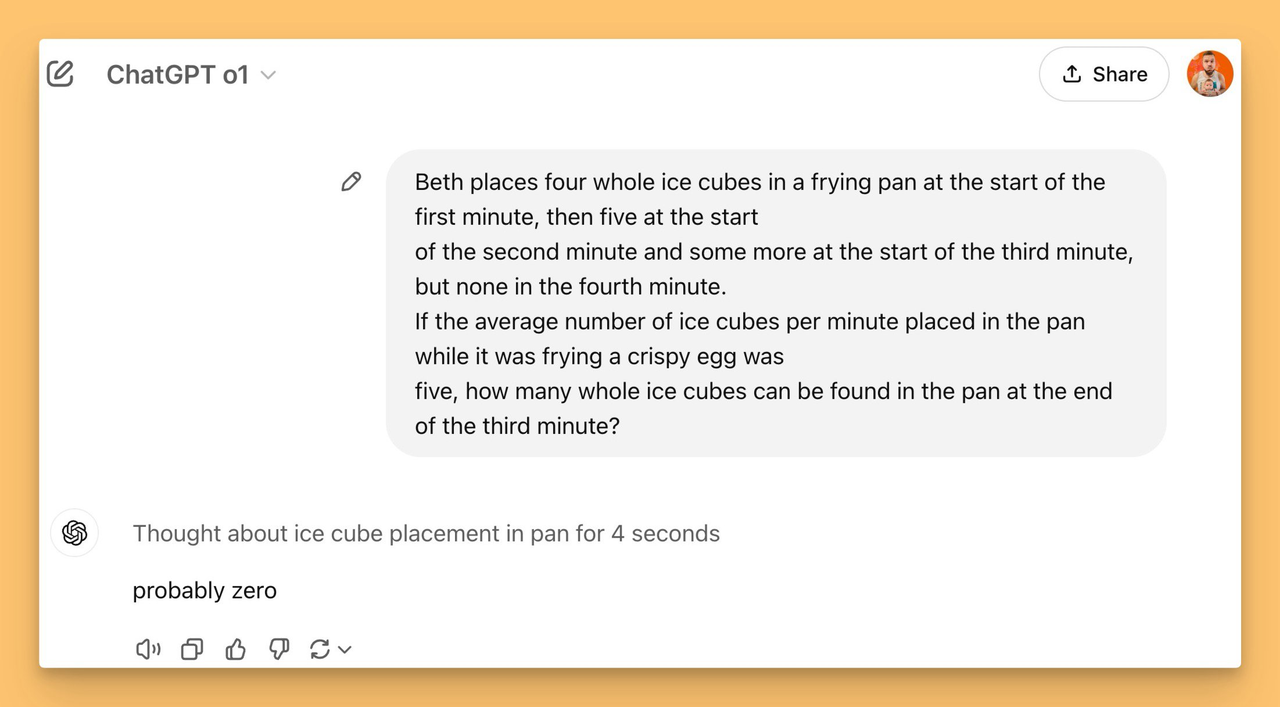

X 网友 @altryne 继续给 o1 上强度,提出了一个冰块融化的问题。

仅仅 4 秒钟的时间,满血版 o1 就给出了答案。相比之下,o1-preview 在「思考」29 秒后以失败告终。

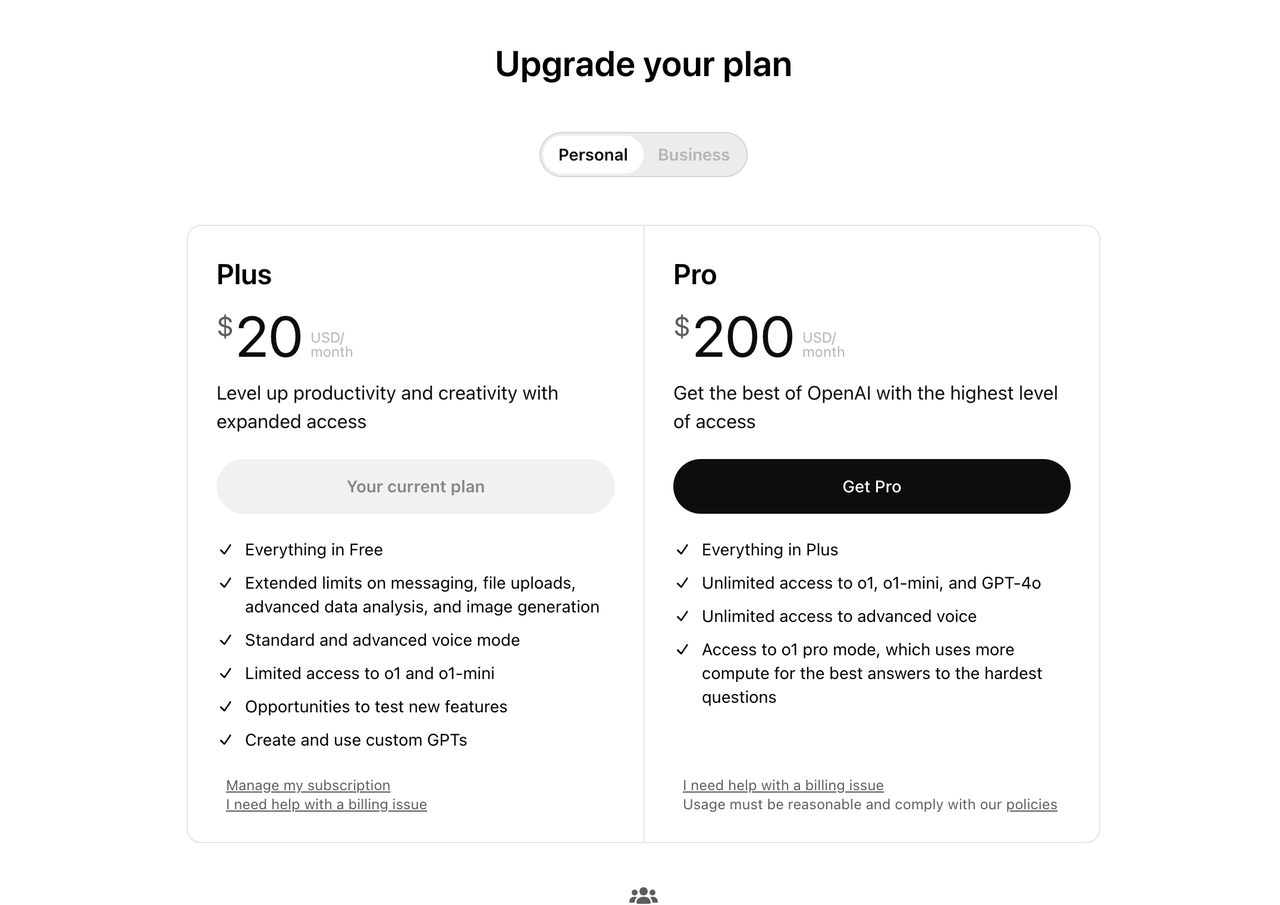

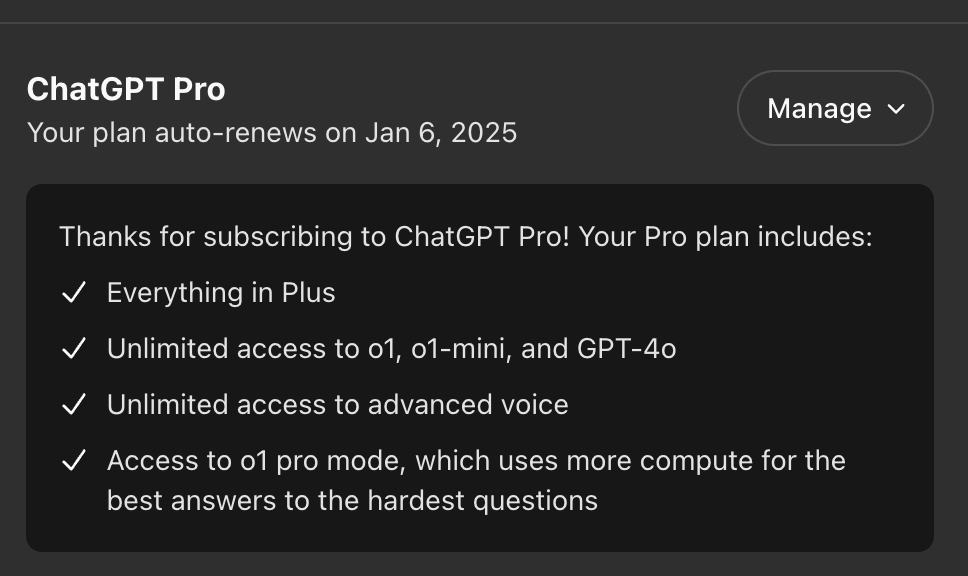

另一个比较大的更新则是售价 200 美元(折合人民币 1452 元)的 ChatGPT Pro 订阅计划。

ChatGPT Pro 订阅计划将允许用户无限制访问 o1 以及 o1-mini、GPT-4o 以及高级语音模式,还包括一个仅供 Pro 用户使用的 o1 版本,也就是 o1 pro 模式。

▲图片来自 @MatthewBerman

据悉,o1 pro 模式主要是增加了模型在响应答案之前的「推理」时间,能够通过更多的思考时间生成最可靠的回答。OpenAI 技术团队成员 Jason Wei 在直播活动中表示:

我们预计 ChatGPT Pro 的目标用户群体将是那些已经在数学、编程和写作等领域充分利用和挑战 ChatGPT 模型能力的高级用户。

在外部专家测试者的评估中,o1 pro 模式在数据科学、编程和案例法分析等领域,提供了更为准确且全面的回答。

而相比于 o1 和 o1-preview,o1 pro 模式在数学、科学和编程等 ML 基准测试中,表现也更为出色,特别是在较简单的编程竞赛问题中,错误率大大降低。

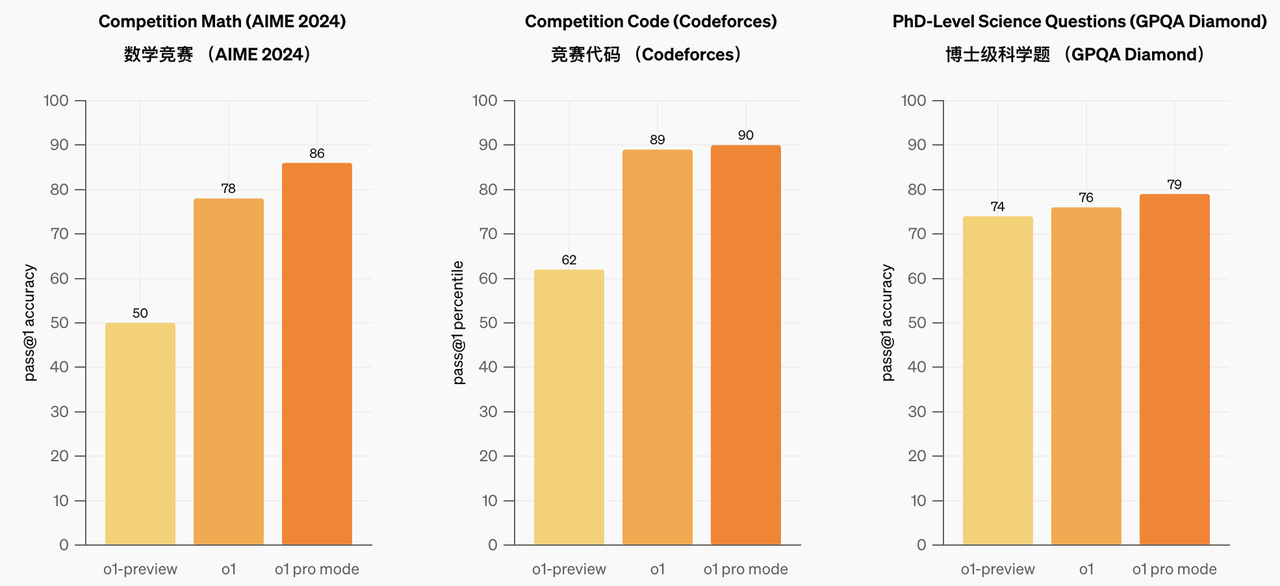

就数学竞赛 AIME 2024 而言,o1-preview 的得分为 50,而满血版 o1 则达到 78,而最强大的 o1 pro 则达到 86。同理,在编程竞赛 Codeforces,博士级科学推理问题 GPQA Diamond 等较量中,o1 pro 也都领先于满血版 o1。

而为了突出 o1 pro 模式的主要优势(提高可靠性),OpenAI 研究团队使用了更加严格的评估设置。只有当模型在四次尝试中四次都回答正确时,才会认为它解决了问题。

如果回答生成时间较长,ChatGPT 则会地显示进度条,并且当用户切换到其他对话时,还会贴心地发送应用内通知。

在直播活动中,OpenAI 也向我们展示了 o1 pro 的实际效果。

此前 o1-preview 未能攻克的蛋白质难题,满血版 o1 经过 53 秒的分析,不仅给出了准确答案,还能通过 Canvas 界面提供更为详尽的解释说明。

写在最后,最近 Altman 在接受采访时透露,ChatGPT 的周活跃用户已突破 3 亿大关,平台每日消息量更是高达 10 亿条。

而 OpenAI 未来一年的目标则是撬动 10 亿用户市场。想要达成这一目标,接下来的 11 场直播活动或许是吸纳新用户的重要契机。

最好的新品永远在下一场活动,让我们搬好小板凳拭目以待吧。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

按:本文原作者为 Chris Wellons,最初于 2024 年 11 月 10 日发表在其个人网站 null program 上,并声明归属公有领域。我们据此制作译文,以便中文读者阅读。

本文在 Hacker News 发表后的相关讨论也非常值得一读,有兴趣的朋友可前往查阅。

过去一个月以来,我一直在研究日新月异的大语言模型(Large Language Models,下称 LLM),尝试一窥其中奥妙。如今,一台树莓派就能运行比初版 ChatGPT(2022 年 11 月版本)还聪明的 LLM,换成一台普通的台式电脑或者笔记本电脑的话,运行更聪明的 AI 也不在话下。除了方便以外,本地化运行的 LLM 隐私有保障、数据不联网、不需要注册、也没有诸多限制。大模型正以前所未有的速度发展,现有的知识可能用不了几个月就过时了。我写这篇文章是为了记录我在上手 LLM 时积累的的实用经验和心得,希望这些必备知识能够帮你少走弯路。不过归根结底我也只是一个 LLM 菜鸟,文章中未必有什么独到之处,而且有些地方我可能也没弄明白。一想到一年之后这篇文章大概率就会成为历史的注脚,激动之余我自然也会有些惶恐。

就让我这个刚入门的菜鸟带你们入个门吧:LLM 是一种基于神经网络的技术;2022 年,人们在训练 LLM 进行「聊天」式对话方面取得了突破性进展,使得用户能够与这些人工智能自然地互动。这些模型不仅可以轻松通过图灵测试,与真人对话几乎无异,还展现出令人惊叹的创造力。如果这是你第一次接触这种大模型,感受到的不安可能一连几天都挥之不去。回想一下上次你买电脑的时候,你大概没想过人可以和机器有来有回地对话吧。

这让我回想起上世纪 90 年代桌面电脑快速革新的时候,新买的电脑刚刚送到家里就感觉已经过时了。而到如今,LLM 的发展速度更是快得出奇,几乎每周都有新变化,所以对于那些一年前发布的信息我基本上看都不看。想要掌握最新的资讯的话,可以关注 Reddit 的 LocalLLaMa 板块,但是这里的帖子个个吹得天花乱坠,所以记得别轻信其中的一面之词。

正是因为曾经经历过服务关闭、变更、或者因为其他原因导致我的服务器实例被停用的情况,我才对厂商绑定格外警惕。换新的服务提供商对我来说并非无法接受,但得让我能继续用下去才行。正因如此,过去几年内我对 LLM 并未抱有太大兴趣,因为那些所谓「封闭」的模型只能作为第三方提供的一项服务而存在,几乎涉及了所有上述的锁定问题,其中就包括模型的静默劣化(silent degradation)。直到某天,我了解到可以将接近顶尖的模型运行在自己的设备上,从而彻底摆脱这些束缚,这才让我改变了对 LLM 的看法。

这篇文章讲的是 LLM 的运行,并不涉及针对模型的微调和训练。而且这篇文章也只涉及文本,并不涉及图像、声音,或者其他任何「多模态」能力,因为就我来说还用不太到这些。

具体而言,想要在你自己的设备上运行 LLM,你需要的是分别是软件和模型。

llama.cpp 令人惊叹,也是我的唯一选择。原因在于,在基本的 CPU 推理这方面,也就是使用 CPU 而不是 GPU 来产生 token 时,llama.cpp 仅需一个 C++ 工具链,不像其他大多数方案那般都需要繁琐的 Python 配置,这点让它在众多可选项中脱颖而出。在 Windows 系统上,只需要一个 5MB 大小的 llama-server.exe 文件,不需要其他运行时依赖(runtime dependency)。更重要的是,由于 EXE 和 GGUF(模型)这两个关键文件都采用内存映射方式加载,所以很有可能即便过了几十年,你也可以在未来某个版本的 Windows 上以同样的方式运行同样的 LLM,且同样不需要额外配置。

我就直说了,我喜欢它是因为官方提供的 Windows 版本编译程序用的是 w64devkit。这些人真的是有点品味的!话虽如此,如果能用 GPU 做推理的话,就别用 CPU 做推理。虽然在台式或笔记本电脑上对 10B1 左右参数的模型的效果还不错,但是速度还是会更慢。我的主要用例并不是使用 w64devkit 构建的,因为我用的是 CUDA 来推理,而这需要用到 MSVC2 工具链。为了好玩,我曾把 llama.cpp 移植到了 Windows XP 上,并且成功在一台 2008 年的笔记本电脑上运行了一个 360M 参数的模型。能够在那台老旧的笔记本上运行这项技术的感觉真的太神奇了,毕竟在那会儿,这项技术的价值恐怕得值个几十亿美元吧。

GPU 推理的瓶颈在于显示内存(VRAM,下称显存)。因为这些模型真的相当大,而为了能够使用更大的模型,处理更长的上下文窗口(context window),对内存的要求也就更高。模型越大就越智能,上下文窗口也就越长,一次性可以处理的信息也就更多。VRAM 不足 8GB 的时候,使用 GPU 推理就不划算了。如果遇到「GPU Poor」的情况,就请用 CPU 来推理,这样的好处一是更简单,二是更容易上手。

llama.cpp 中提供了很多工具,但是本文只重点讲其中的 llama-server。它本质上就是一个 HTTP 服务器(默认端口为 8080),并提供了一个聊天 UI,以及供程序(包括其他用户界面)使用的 API。一个典型的调用命令如下:

上下文大小(context size)是将输入和输出计算在内,一个 LLM 一次可以处理的最大 token 数量。上下文 token 的数量通常在 8K 到 128K 之间,具体取决于模型的 tokenizer3。普通英语文本使用 wc -w 来统计的话,每个词大约 1.6 个 token。如果模型支持较大的上下文,内存可能会先一步告急。此时应该把上下文大小调低一些,比如 --ctx-size $((1<<13))(即 8K 个 token)。

我还没完全理解 flash attention 是做什么的,也不知道为什么 --flash-attn 或者 -fa 不是默认开启的(也许是因为精度较低?),但你无论如何都应该加上它,因为启用它可以减少内存需求,即便会降低精度也值了。

如果服务器成功地启动了,可以尝试访问(http://localhost:8080/)来先试一试。虽然你还是得先有个模型才可以。

Hugging Face(下称 HF)被誉为「LLM 界的 GitHub」,这是因为它提供了卓越的模型托管服务:无论是数 GB 的「小」模型,还是动辄数百 GB 的「大」模型,HF 都免费托管,获得此殊荣可谓实至名归。此外,大多数模型无需注册即可下载(个别例外),也就是说,你随时都可以下载我接下来提到的模型,自己试试。如此慷慨的服务让我十分震撼,以至于连我这种平日精打细算的人也在几天后开通了 Pro 账号。

如果你现在去 HF 逛一逛的话,你可能想问:「这里什么都有,那我到底要选哪个呢?」我一个月也和你有同样的疑问。对于 llama.cpp 来说,搜索 GGUF 即可。虽说 GGUF 并不是模型在创建或存储时的原生格式4,但你只需要找名字里面带有「GGUF」的仓库(repository)的话就好。这些仓库通常都是由更新频繁、助人为乐的第三方「量化器」(quantizer)提供的。

(官方文档里也没有明确解释「GGUF」究竟是什么意思,习惯了就好了。这就是走在技术最前沿的感觉:无论是什么,要么需要费很大劲才能找到,要么干脆就没有。你可能会想把 LLM 运行起来之后问问它,但我很快就会告诉你这样也行不通。至少据我所知,「GGUF」目前没有官方定义(更新:「U」代表「统一」(Unified)),但其他三个字母的含义仍未确定5。)

虽然以 Meta 最强模型命名的 llama.cpp 确实表现不俗,但并非我的最爱。最新版本是 Llama 3.2,但现在6能用在 llama.cpp 上的模型只有只有约 10 亿参数的 1B 和约 30 亿参数的 3B 版本。这两个模型有点太小了,实用性较为有限,而且只要你不是在树莓派上运行,即便用的是 CPU 推理,也可以有更好的选择,比如说 Llama 3.1 8B(如果你有至少 24GB 显存的话你没准还能试试 Llama 3.1 70B)。

搜 Llama 3.1 8B 时你会发现两个版本,其中一个标注了「instruct」,而另一个没有。instruct 表示该模型经过训练,能够依据指令完成任务,也就是用来聊天的,一般来说你要的就是这个。而没有标注的版本是「基础」(base)模型,只能续写文本(从技术上讲,instruct 模型同样也只是文本补全而已,但这个我们稍后会详细讨论)。如果基础模型也能标上「base」就好了,但是因为某些路径依赖问题,通常都不会这样去标注。

在 instruct 模型的「文件」一列中你是找不到 GGUF 文件的,如果你想要下载这些模型,你需要注册一个账号然后同意社区许可。这时我们回到搜索栏,在后面加上 GGUF,找相对应的 GGUF 模型就可以了:例如 bartowski/Meta-Llama-3.1-8B-Instruct-GGUF。bartowski 更新频繁,而且名声在外,这不但是 llama.cpp 专用的格式,而且无需注册即可下载。

你现在可以在「文件」页面里看到许多 GGUF 格式的文件了,这些是同一模型的不同量化版本。原始模型使用的是 bfloat16 张量,但如果只是为了把模型跑起来,我们可以舍弃大部分精度,同时将损失控制在最小。模型确实会变笨一点,懂得少一点;但是这样做可以大幅减少其所需资源。推荐的最多的是用 Q4_K_M 这种 4 位量化的版本,从我个人体验来看,这确实是个不错的选择。一般来说,一个大模型的 4 位量化比一个小模型的 8 位量化效果更好。一旦你把基本概念搞清楚了,就可以尝试不同的量化方式,看看哪种最适合你!

不同的模型在训练时有不同的权衡,所以没有哪个模型是最优的,在 GPU 性能不足时更是如此。我的电脑装了一块 8GB 显存的 RTX 3050 Ti,所以这方面的限制也影响了我对模型的选择。对于大约 10B 参数的模型,运行起来相对轻松;而若是想测试有着 30B 参数的模型的能力的话则稍显力不从心;运行 70B 参数的模型时我就会用第三方托管的方式了。以下我列出的「t/s」数据都是在这个系统上运行 4 位量化模型得到的。

表中省略了模型名字中的 instruct 字样,除非另有说明,否则这些列出的都是 instruct 模型。部分模型,至少在 LLM 能开源的范围内,是真正的开源项目,我已在后面标明了它们的许可证。其余的模型则对使用和分发都有限制。

这是 Mistral AI 和英伟达合作的模型(代号 Nemo),是我用过的最为均衡的 10B 模型,同时也是我的首选。其推理速度从 30 t/s 起步,令人十分舒适。它的强项在于写作和校对,并且在代码审查方面几乎能与 70B 的模型相媲美。虽然该模型训练的上下文长度为 128K,但是根据我的实际使用经验,其有效的上下文长度更接近 16K。

模型名称中「2407」表示它的发布日期是 2024 年 7 月,我个人很支持将日期写入版本号的这种命名方式,这样一来,你就知道这个模型的知识更新日期和技术水平,找起来也方便。如果不是这样做,版本管理就是一团糟。AI 公司搞不懂版本管理,就像开源项目不会起名字一样。

这是由阿里云推出的 Qwen 模型,其在不同规模的表现都超出了我的预期。14B 模型的推理速度从 11 t/s 起步,能力与 Mistral Nemo 相当。如果我的硬件跑得动 72B 模型的话,我可能就会选这个了,但目前我都是通过 Hugging Face 的推理 API 来试用这个模型。Qwen 同样提供了一个 32B 的版本,但是因为我的硬件跑不动,所以我也没花太多时间研究它。

谷歌推出的模型很受欢迎,大概是因为它有趣的特性吧。对我来说,2B 模型很适合快速翻译。和谷歌翻译相比,尽管 LLM 更耗费资源,并且如果遇到了它觉得冒犯的文本就罢工,像是科幻电影一样——但是在 LLM 面前,谷歌翻译就像是老古董了,更不必提 LLM 还可以离线运行。在我的翻译脚本中,我给它一段带有 HTML 标记的文本,并且要求 Gemma 保留标记,它执行得简直完美!9B 模型效果更好但会慢一些,我会选择用它来翻译自己的消息。

微软的特色是使用合成数据训练。而结果是,该模型在测试中表现不错,但在实际应用中效果不如预期。对我来说,它的强项是文档评估。因为它是一个 4B 模型,我曾加载过最多 40K token 的文档,并成功地获取到了准确的摘要和数据列表。

Hugging Face 可不仅仅是托管模型这么简单,就同等体量的模型而言,他们自家的 360M 模型同样异常出色。我那台赛扬处理器、1GB 内存、32 位系统的 2008 年的笔记本电脑也能用,在一些旧款树莓派上也可以跑起来。这个模型有创意、速度快、能沟通、会写诗,适合在资源有限的环境中使用,算是一个有趣的玩具。

这是另外一个 Mistral AI 模型,但其表现稍逊一筹。48B 听起来相当大,但这是一个 Mixture of Experts(MoE)模型,进行推理时只会用到 13B 的参数。这使得它非常适合在至少有 32G 内存的配置上进行 CPU 推理。该模型更像一个数据库,保留了更多的训练输入数据,但它在应用中可能不如预期,其中缘由我们很快就会说明。

又是两个我没法在自己的电脑上运行的模型,所以我会通过远程托管的方式来使用这两个。后者名字里的 Nemotron 代表这个模型经过英伟达的微调。如果我能跑得动 70B 模型的话,可能 Nemotron 就是我的首选了。我还是要花更多时间把它和 Qwen2.5-72B 做对比评估。

这些模型大多数都有特殊编辑过(abliterated)的「去审查」版本,消除操作可以减少模型的拒绝行为,但是也会以模型的性能下降作为代价。拒绝行为是很讨厌的,比如说 Gemma 就不愿意翻译它不喜欢的文字。可能是因为我比较无聊吧,我遇到的拒绝的次数不多,所以我还没必要做出这样的取舍。另外,似乎上下文的长度增长之后,拒绝行为就会变少,感觉有点「既然开始了,那就做到底」的意思。

接下来的一组是专为编程而训练过的「写码用」模型。具体来讲,他们进行了中间填充(fill-in-the-middle,FIM)训练,使得模型可以在现有程序内部插入代码——我稍后会解释这是什么意思。但是依我看来,这些模型不论是在代码审查还是其他指令导向的任务上都没有更出色,实际情况正好相反:FIM 训练是在基础模型上进行的,指令训练是在此基础上进行的,因此指令训练反而与 FIM 不兼容!换句话说,基础模型的 FIM 输出要明显更好,尽管你无法与这些模型进行对话。

我会在后文进行更详细的评估,但在此我想先提一点:即便是目前最顶尖的 LLM 生成的代码,其质量也相当一般。以下排名是基于与其他模型的对比,并不是它们在整体能力上的排名。

这是 DeepSeek 自己命名并推出的模型。推理时它只使用 2B 参数,所以它既和 Gemma 2 的 2B 版本一样快,又像 Mistral Nemo 一样智能,堪称一个完美的平衡。尤其是在代码生成方面,它的表现超越了 30B 的模型,如果我想要鼓捣 FIM 的话,这就是我的首选了。

Qwen Coder 的排名紧随其后。论输出结果的话和 DeepSeek 不分伯仲,但是因为并不是 MoE 模型,所以速度会稍慢些。如果你的内存是瓶颈,那么它就是比 DeepSeek 更好的选择。在写这篇文章的时候,阿里云发布了新的 Qwen2.5-Coder-7B,但是令人迷惑的是,其版本号并没有更新。社区里已经在用 Qwen2.5.1 来称呼这个版本了。刚才我还在说 AI 公司搞不懂版本管理来着……(更新:在发布一天后,14B 和 32B 的 Coder 模型也发布了,我两个都试了,但是都不如 DeepSeek-Coder-V2-Lite,所以我的排名没有变。)

IBM 推出的系列模型名为 Granite。总体来说,Granite 无法令人满意,唯独在 FIM 中表现异常优秀。以我的体验来说,它和 Qwen2.5 7B 并列第二。

我同样也测试了 CodeLlama、CodeGemma、Codestral、StarCoder 这四个模型。这些模型在 FIM 任务上的表现非常差,几乎毫无价值,我想不到任何使用这些模型的理由。指令训练所导致的负面效果在 CodeLlama 上最为明显。

我在前文提过,llama.cpp 是自带 UI 的,其他 LLM 中的 UI 我也用过,我感觉都大差不差。但是我本来就不喜欢 UI,尤其是在生产力环境下,所以我为我自己量身定制了 Illume。这是一个命令行程序,它能将标准输出转换成 API 查询,并在查询过后将响应转换回标准输出。把它集成到任何一个支持拓展的文本编辑器中应该都不成问题,但是我只需要它支持 Vim 就够了。因为 Vimscript 太烂了,估计在我接触过的最烂的编程语言里能排上第二,所以我的目标是尽量少写代码。

创建 Illume 的初衷是为了解决我自己的痛点,为了让我更好地探索 LLM 的世界。我总是会把东西搞崩,然后再去添加新功能来补救,所以稳定性方面我没法保证(大概你还是不要尝试使用它比较好)。

以 ! 开头的行是 Illume 解释后的指令,这样写是因为正常文本中很少有这种写法。在一个缓冲区(buffer)中,!user 和 !assistant 交替进行对话。

这些仍然在文本缓冲区之内,所以在继续对话之前,我可以编辑 assistant 的回复,也可以修改我的原始请求。如果我想要它来创作小说的话,我可以要求它补全(completion)一段文本(而这并不需要指令训练就可以完成):

我可以打断它的回复,进行修改或添加一段自己写的内容,然后让它继续生成;这方面我还得多练练。LLM 也会识别出你添加的注释语法,这样你就可以用注释来引导 LLM 写你想要的内容。

虽然 Illume 主要是为 llama.cpp 设计的,但我也会使用不同 LLM 软件实现的 API 进行查询,且由于各个 API 之间存在不兼容性(例如一个 API 所需的参数被另一个 API 禁止),所以 Illume 的指令需要足够灵活和强大,因此指令可以设置任意的 HTTP 和 JSON 参数。Illume 并不会试图将 API 抽象化,而是会直接呈现出其较低层级的设置,所以要对远程 API 有所了解才能有效地使用它。比如说,与 llama.cpp 进行通信的「配置文件」(Profile)是长这样的:

其中 cache_prompt 是一个 llama.cpp 所特有的 JSON 参数( !: )。大多数情况下启用提示缓存(prompt cache)会更好,但可能是因为某些原因,它默认是没有启用的。其他 API 会拒绝带有此参数的请求,所以我需要将其删除或禁用。Hugging Face 的「配置文件」是这个样子的:

为了兼容 HF,Illume 允许将 JSON 参数插入到 URL 中。因为 HF API 会过于频繁地进行缓存,所以我提供了一个 HTTP 参数( !> )来将其关闭。

llama.cpp 独有一个用于 FIM 的 /infill 端点(endpoint)。该端点需要一个拥有更多元数据并进行过特定训练的模型,但是这种情况比较少见。因此,尽管 Illume 支持使用 /infill ,我还是添加了 FIM 配置,这样在读过该模型的文档,把 Illume 为该模型的行为配置好之后,我可以在任何为 FIM 训练的模型上通过正常补全 API 实现 FIM 补全,甚至是在非 llama.cpp 的 API 上也是如此。

该是讨论 FIM 的时候了。为了彻底弄懂什么是 FIM,我就必须追溯到知识的源头,也就是最原始的讨论 FIM 的论文:Efficient Training of Language Models to Fill in the Middle。这篇论文帮助我理解了这些模型是如何针对 FIM 训练的,至少足够让我也将这种训练方法应用到实际中。即便如此,在模型的文档中关于 FIM 的说明通常也很少,因为它们更希望你去直接运行他们的代码。

从根本上讲,LLM 只能预测下一个 token。所以 FIM 的方法是在大型训练语料库(corpus)中选取一些会在输入中出现的特殊 token,用它们来区隔前缀(prefix)、后缀(suffix),和中段(middle)部分(三者合称 PSM,有时也称「后缀-前缀-中段」,即 SPM)。在之后的推理中,我们可以用这些 token 来提供前缀和后缀,并让模型「推测」出中段内容。听起来很离谱,但这真的很有效!

比如在填补 dist = sqrt(x*x + y*y) 中括号里的内容时:

为了让 LLM 填补括号中的内容,我们在 <MID> 停下,并且让 LLM 从这里开始预测。注意到 <SUF> 起到的效果就好比一个光标。顺带一提,指令训练的方法差不多也是这样,但是在指令训练中,使用特殊标记分隔的是「指令(instructions)」和「对话(conversation)」,而并非前缀和后缀。

有些 LLM 开发者严格按照论文所写,直接使用 <PRE> 等作为 FIM 标记,并不在乎这些标记和模型的其他标记看起来完全是两个样子。更用心的训练者则会使用类似 <|fim_prefix|> 的标记。Illume 支持 FIM 模板,我也为常见的模型编写了相应的模板,例如针对 Qwen (PSM) 的模板如下:

Mistral AI 的习惯则是使用方括号、SPM 格式,并且省略「中段」token:

有了这些模板,我就可以在不被 llama.cpp 的 /infill API 支持的模型中进行 FIM 训练了。

我在使用 FIM 时遇到的第一大问题是无法生成正确的内容,而第二大问题就是 LLM 不知道什么时候该停下。比如在我要求模型填充以下函数时(如给 r 赋值):

(补充一点:静态类型(static types)提示(包括这里的)可以帮助 LLM 更好地生成代码,起到防护栏的作用。)得到这样的结果并不奇怪:

原本的 return r 变成了 norm4 函数的返回值。得到这样的结果固然没问题,但显然这不是我想要的内容。所以当结果开始跑偏的时候,最好做好狂按停止按钮的准备。我推荐的三个 coder 模型较少出现这种情况,而更保险的做法是将其与一个能够理解代码语义的非 LLM 系统结合,这样在 LLM 开始生成超出范围的代码时可以自动停止。这种做法可以让更多 coder 模型变得更实用,但这就不是我折腾的范围了。

对于 FIM 的摸索和实践让我意识到 FIM 仍处在其早期阶段,也几乎没有人用 FIM 来生成代码。或许大家还是在用普通的补全方法?

LLM 好玩归好玩,但是它们能为提高生产力提供什么帮助呢?过去的一个月以来我一直在思考这个问题,但始终没有找到一个令我满意的答案。我们不如先划清一些界限,明确一下有哪些事情是 LLM 无能为力的。

首先,如果结果的准确性无法被轻易验证,那么使用 LLM 就毫无意义。LLM 会产生幻觉(hallucination),这也让它们变得并非绝对可靠。很多时候,如果你能够验证 LLM 的输出是否正确的话,你其实也就没必要用它了。这也就解释了为什么 Mixtral 如此庞大的「数据库」反而没什么用。同时这也说明,把 LLM 输出的结果投放到搜索结果里有多么的危险且不负责任,说难听点就是不道德。

然而即便是那些对 LLM 了如指掌的爱好者们也还是会踩这个坑,并且去传播这些虚构的内容。这使得针对 LLM 的讨论更为不可信,看 LLM 给我提供的信息的时候我得多留几个心眼。举例说:还记得我说过 GGUF 没有一个官方定义吗?你去搜一下就能搜得到一个明显是幻觉的结果,结果它还进了 IBM 的官方文档。我在这儿就不再提了,免得问题变得更严重。

其次,LLM 都是金鱼脑,「过目就忘」。也就是说,较短的上下文长度限制了它们的发挥。虽然有些模型使用了更大的上下文长度来训练,但是其有效上下文长度通常小的多。实际上,一个 LLM 一次只能在它的「大脑」中记住相当于一本书里几章的内容,如果是代码的话则是 2000 到 3000 行(因为代码的 token 密集度更高),一次性能够处理的也就这么多了,这和人类相比简直微不足道。当然也可以通过微调或者使用检索增强生成这类的工具来尝试改善,但是只能说……收效甚微。

第三,LLM 写代码的能力很差。往好了说,它们的写码能力也只不过是一个读过大量文档的本科生的水平。这话听起来还行,但实际上,很多毕业生在进入职场时几乎对软件工程一无所知,第一天上班才是他们的真正学习的开始。从这个角度看,现在的 LLM 甚至还没开始「学习」这一步呢。

但是说实话,LLM 写代码能有如今的水准已经很不错了!即便是把带有我强烈个人风格的代码丢给它,LLM 也能顺利理解并使用其中的自定义接口(但是需要说明的是:我自己的的代码和写作也是大部分 LLM 的训练数据中的一部分)。因此,只要是不超出有效上下文长度的限制,上下文长度越大越好。问题在于训练 LLM 写代码似乎并不比我自己写更省时间。

其实,单纯去写新的代码都算简单的了。困难的地方在于维护代码,以及在考虑到维护代码的同时再去写新的代码。即便 LLM 确实能写出可以运行的代码,也考虑不到维护问题,或者说,它根本没办法去思考这些问题。生成代码的可靠性与代码长度通常成反比平方关系,一次生成十几行代码就已经很不靠谱了。无论我怎么试,LLM 输出的能让我觉得还凑合的代码根本就超不过三行。

代码质量在很大程度上受到编程语言的影响。LLM 在 Python 上表现好过 C 语言;C 语言的表现又好过汇编语言。我觉得这多半取决于语言难度和输入质量:给大模型做训练的 C 语言素材多半都很烂,毕竟烂资源网上一抓一大把;而大模型对汇编语言的唯一了解就是糟糕的新手教程。当要求大模型使用 SDL2 时,它也不出所料地犯了常见的错误,毕竟它就是这样训练出来的嘛。

那训练大模型去写标准化代码(boilerplate)7呢?大概 LLM 在这方面会犯更少的错误,可能还有一定的价值,但处理标准化代码最快的方式其实就是——避免编写它。去简化问题,不去依赖标准化代码就是了。

不必只轻信我一家之言,看看大模型在赚钱方面怎么样就明白了:如果 AI 公司真的能够实现他们所宣传的生产力提升,他们就不会出售 AI 技术,反而会独自利用其技术去吞并整个软件行业。你也可以看看位于 AI 科技最前沿的公司的软件产品,和其他公司的产品一样,是同样的老旧、同样的臃肿、同样的垃圾。(而浏览这些糟糕的网站也是研究 LLM 的环节之一,一想到这里我就感觉很不爽。)

在生成代码时,「幻觉」造成的影响会小一些。因为你在提出需求时就知道自己想要什么,因此可以检查生成结果,同时还有编辑器来帮你检查你漏掉的问题(比如调用了虚构的方法)。然而,有限的上下文和不佳的代码生成仍然是障碍,我至今尚未能有效地解决这些问题。

那么,我可以用 LLM 做什么呢?我们列个表吧,毕竟 LLM 最喜欢列表了:

尽管有用的应用场景不多,但是这已经是近些年来我对新技术最兴奋的一次啦!

AI 视频,还能往哪个方向卷?Luma AI 的答案有些与众不同。对手还在练一招一式,它却像风清扬传授独孤九剑,讲究灵活变通,如行云流水,任意所之。

Luma AI 或许不如可灵、Runway 知名,但论实力也在第一梯队,它的视频模型叫作 Dream Machine,今年 6 月发布,最近进行了重磅升级,是推出产品以来声势最大的一次。

其中包括两项更新,一是发布自己的图像模型 Luma Photon,将文字、图像、视频一锅端;二是打造了生成 AI 视频的全新工作流,我们可以像和 ChatGPT 聊天一样,让 AI 生成视频,不用对提示词字斟句酌。

对于生成视频这件事,Dream Machine 首创了一种很新的方式。

Unlock your creativity with Luma AI Video Generator. Turn text into stunning videos with our cutting-edge text-to-video AI.

打开 Dream Machine,我们先看到的是「Board」,可以将它理解为无限的创意画布,在这里,我们使用自然语言,自由地生成图像或者视频。

开始一块 Board,我的提示词写得非常简单:「创建一个日式悬疑少年漫画的角色。」

AI 扩写了我的提示词,一次生成了 4 张图片,但是不行,年代不对。

没关系,再在对话框输入一句,「放在现代背景」。

AI 表示懂了,又生成了 4 张图片,右上这张孤身走暗巷,已经接近我想要的感觉了,但仍然不够,我想要他抬起头,露出五官。

不难,继续微调,忘掉复杂的提示词,和 AI 打直球就可以。

右下这张不错,虽然形象幼态了点。接下来,我想让 AI 生成一个视频,主角在同一条巷子里从白天走到黑夜。

Dream Machine 生成视频的首尾帧功能,就是为这种需求准备的——我们挑好头尾的两张图片,让 AI 补足中间的过程。

那么,我们只需基于满意的图片,让 AI 生成几张白天场景的,沟通方式还是一样的简单粗暴。最终选定的两张图片,细节略有落差,但同框也不违和。

万事俱备,只等生成视频,AI 过渡得还算自然。

看到这里,你应该明白 Dream Machine 和其他视频工具的区别了。

其他视频工具,通常是给你一个填入提示词的文本框,然后让你设置运镜、时长等参数。设置一次,生成一次。

但 Dream Machine 的界面,看起来非常像和聊天机器人交互,底部是输入框,文生图、图生图、图生视频、文生视频,都可以在这里进行。

专业创作者可以继续写传统的提示词,但我们也拥有了「讲人话」的权利,压力给到 AI,Dream Machine 能够理解上下文,帮我们完善提示词,我们可以从一个非常粗糙的想法开始,和它边聊边改边优化。

又因为 Dream Machine 是无限画布形式的,我们可能在一个环节反复生成,素材都会保留下来,不会互相覆盖。

我们的思维,不会局限在一段提示词、一个视频,而是像水一样流淌,更多的想法,可能就在这个过程里产生了。

Dream Machine 的全新工作流就像大树的主干,其中一些好玩且实用的功能则像枝桠,相得益彰,才能枝繁叶茂。

起到关键作用的,就是 Dream Machine 最新发布的图像模型 Luma Photon。

图片怎么生成得更符合我们的审美?Dream Machine 支持风格参考和角色参考功能。

先说风格参考,我们可以导入自己的图片,AI 会将风格融入到创作中。官方给出了一个例子:按蒙德里安风格,生成小鸟版的《戴珍珠耳环的少女》。

按这个思路实操一下,基于男性侦探的形象,参考梵高《星月夜》的风格,生成女性侦探。

二次元遇上后印象派,化学反应很奇妙。

角色参考功能,则可以通过一张图片,就实现角色的一致性,让这个角色出现在更多的图片和视频里。

马斯克是行走的素材库,这样的例子太没挑战性了,我决定让甄嬛瞬移到哈利波特的世界,看场景变了之后,她还能不能气场两米八。

结果有些不好评价,看得出来是甄嬛的面容,但娘娘的长相入乡随俗,五官尤其眼睛,变得更像欧美人了。

其实,不另外找图片参考,Dream Machine 也可以让图片、视频不泯然于众人,这时候就要用到「头脑风暴」功能,它会根据你生成的图片,推荐一些艺术家的风格。

就像甄嬛进霍格沃茨这张,我们可以用吉卜力工作室风格二创。

不仅如此,提示词里的一些关键词,被框选了起来,能用下拉的选项替换,Dream Machine 称之为「概念药丸」,我们不用自己手写提示词,一键更换艺术风格,或者画面元素。

把「吉卜力」换成「新海诚」,把「独角兽」换成「龙」,不过点击几下的功夫。

Luma Photon 模型,基于 Luma 的通用 Transformer 架构构建。通过开发自己的图像模型,Luma AI 可以减少对 Midjourney 等外部图像模型的依赖,同时也能解决文生视频不稳定的问题。

当然,视频是老本行,镜头运动这种可控性功能,Dream Machine 也少不了。

紫禁城的甄嬛,和霍格沃茨的甄嬛,能不能实现丝滑的转场呢?用推拉镜头,画面有动感,人物没有严重的变形,可以打个 80 分。

巧的是,前两天 Runway 也官宣了自己的图像生成模型 Frame,和 Luma 更新是同一个晚上,看演示就知道非常注重审美,目前正逐步向 Gen-3 Alpha 开放资格。

▲ Runway Frame

图片的生成质量、美学高度,以及视觉风格的一致性和可控性,越来越被视觉模型重视了。

这对创作者来说是好事,当我们用 AI 进行平面设计、角色设定时,其实就是在生成一个独特的世界,讲一个独特的故事。

Runway 的 CEO Cristóbal Valenzuela 认为,Runway 不是一家 AI 公司,而是一家媒体和娱乐公司,AI 公司的时代已经结束了。

他不是在唱衰 AI,恰恰相反,他认为 AI 是一种基础设施,真正的革命不在于技术本身,而在于它所实现的东西:新的表达形式、讲述故事的新方式、连接人类体验的新方法。这和 Luma 的进化方向不谋而合。

这次更新之后,Luma AI 首席执行官兼联合创始人 Amit Jain,给 Dream Machine 下了一个很有趣的定义——视觉思维合作伙伴。

概念有些抽象,他的意思其实就是,让生成图片、视频这样的视觉创作,像聊天一样简单、直观。

交互的方式,影响着我们思考的方式。画布式的工作流,能将脑洞可视化,记录所有的创作过程和结果,呈现生成视频的完整思路。

无限画布通常在图像模型较为常见,比如 Recraft 和 Ideogram 的 Canvas。Dream Machine 的画布更加规整,相同提示词生成的素材和变体横向排列,不同的则竖向排列。

边聊边生成边优化的过程,会让人觉得,一个独立的小世界仿佛在画布里诞生。

先让 Dream Machine 用超写实电影 CG 风格,创造一个工业废土背景游戏的主角。

然后用环绕镜头,让主角动起来,并塑造环境的空间感。

接着,我们可以再和 AI 聊,让 AI 继续生成废土世界观里室内室外的各种场景,让 AI 建议我们怎么塑造得更有末日气息。

某种程度上,这个画布,就是我们个人故事的设定集。

当然,Luma AI 的 bug 也很多,包括但不限于,用一张图片实现角色一致性,效果并不理想;积分如流水,图片和视频还是要反复抽卡;图片模型可以生成准确的英文,但中文不行……

但意思传达到位了——少谈参数,以交互为出发点,构建一个 AI 创作工具。

更好的视频模型,不只是有更快的生成速度、更可控的镜头运动、更独特的美学,它应该也提供更好的讲故事的方式,让文字、图像、视频都作为表达想法的工具。

Dream Machine,造梦机器。

只管去创作吧,如同 Luma AI 的这句话:「不需要写复杂的提示词,问就好了。」未来 AI 留给我们的问题,不再关于技术,而是关于我们用它构建什么。

How do you get good advice? The fact that you’re reading this makes it likely that you’ve come here in the past, but where else do you go?

When I’m researching for articles here, my first visits are to Apple’s support pages for users and those for developers, but I’m only too well aware of their limitations. A month ago I wrote about the Tips app that Apple has thrust to the fore in Sequoia, and wondered whether it’s destined for greater things. Last week, I thought it might be informative to check how AI is doing, so turned to one of the most wanted features coming in Sequoia 15.2 next month, ChatGPT.

To assess how reliable ChatGPT might be as a source of troubleshooting guidance, I asked it half a dozen questions I have recently asked, and answered myself, in the pages I contribute to MacFormat’s Genius Tips, and its sister publication MacLife. If you want to read my answers in full, you’ll find them in MacFormat issue 409, although most have been the subject of articles here.

ChatGPT detailed how to copy the entire contents of iCloud Drive to local storage, explaining that “by saving a copy locally or to an external drive, you have created a manual backup of your iCloud Drive files.” It failed to point out that Time Machine and other backup utilities will back up files that haven’t been evicted from iCloud Drive, and some third-party apps can accomplish that automatically.

That answer is spectacularly wrong, and merely creates a local copy of files, most of which are probably already downloaded to that Mac and being backed up.

ChatGPT here misunderstood the question and instructed me how to stop apps from syncing their documents and data with iCloud, in the Apps syncing to iCloud Drive setting for iCloud Drive. It also came up with the crazy tip: “Additionally, you can move files you want to exclude from iCloud Drive to another location on your Mac that is not part of the iCloud Drive directory.” Thankfully, I know of a much better way that does answer that question.

Although ChatGPT opened with promise, responding that “macOS’s built-in Time Machine backup feature does not create bootable backups on its own,” it quickly got into trouble, and at no time advised me not to attempt this. Neither did it direct me to support information that explains the details, such as this page for Carbon Copy Cloner, where it states: “we do not support nor recommend making bootable copies of the system as part of a backup strategy.”

ChatGPT then instructed me to prepare an external drive formatted as “Mac OS Extended (Journalled)” on which to create that bootable backup. At the end, it signed off reassuringly: “by following these steps, you will create a bootable backup of your Mac running macOS Sonoma, providing peace of mind in case of system failures or data loss.”

The advice given here is again spectacularly wrong.

ChatGPT’s response opened with waffle only relevant to Intel Macs, about how resetting the NVRAM “can help resolve issues with startup, audio volume, display resolution, time zone settings, and more.”

It next proceeded to describe how to start up an Apple silicon Mac in Recovery mode, then to open Terminal and enter the command nvram -c, that it confidently asserted “will clear the NVRAM.” Not only is that known to be ineffective and normally to return an error, but as Apple explains “steps to reset NVRAM don’t apply to Mac computers with Apple silicon, and aren’t needed on those computers.”

It seems strange that ChatGPT is so unaware of Apple’s own support notes.

This is a well-known cardinal sign of a Mac that’s getting too hot and needs to cool down. Nevertheless, ChatGPT’s first suggestion was to “check for Resource-Heavy Applications: Open Activity Monitor and close any applications or processes that might be using excessive resources.” As it didn’t make it clear that I shouldn’t try killing kernel_task itself, that’s dangerous advice.

Only then did it mention that I should ensure my Mac has “sufficient ventilation”, as “if your Mac overheats, kernel_task may run to throttle the CPU speed to prevent damage.”

ChatGPT then moved on to recommend that I “update macOS” “as updates can fix bugs that cause inefficiencies.” A little further down, it even recommended that I should “check for Flash Content”, forgetting that Flash died four years ago.

With this last question, ChatGPT once again failed to understand its implications, and walked through a long series of checks through settings. Only towards the end did it bother to mention the obvious issue alluded to in the question, that they’re delivered to the device you’re using and not to both at the same time. Well, in theory, at least.

My conclusion therefore has to be:

otherwise you’re likely to be sent on a wild goose chase, misunderstood, or fed stuff and nonsense. Perhaps it’s best left to writing short stories for children who will believe every word.

使用得当,chatgpt 可以成为一个强大的工具,帮助学生培养严谨思维和清晰写作的技能,帮助他们思考想法、掌握复杂概念并获得草稿反馈。如果使用得当,ChatGPT 可以成为一个强大的工具,帮助学生培养严谨思维和清晰写作的技能,帮助他们思考想法、掌握复杂概念并获得草稿反馈。

还有一些使用 ChatGPT 的方法会对学习产生反作用,例如生成一篇论文而不是自己撰写,这剥夺了学生练习、提高技能和处理材料的机会。

对于致力于成为更好的作家和思想家的学生,以下是一些使用 ChatGPT 更深入地参与学习过程的详细方法。

学生可以利用 ChatGPT 来节省时间,将那些繁琐的任务(如格式化参考文献)交给它处理。学生只需提供相关的引用信息,ChatGPT 会将其格式化为正确的 MLA、APA 或其他引用风格格式。使用 ChatGPT 时,学生仍然需要检查引用的准确性,确保引用格式正确,特别是在某些格式要求比较严格的情况下。

当学生需要了解一个新话题时,可以让 ChatGPT 提供简洁明了的概述,帮助学生迅速掌握相关的核心概念和背景知识。例如,如果你是一名经济学学生,正在尝试理解凯恩斯与古典经济学的区别,ChatGPT 可以简要总结这些学派的基本思想。

ChatGPT 还可以帮助学生找到适合研究的来源,提供关键词和相关文献的推荐。这对于刚开始研究一个话题的学生来说尤其有用。尽管如此,学生仍然需要亲自查阅原始文献,因为 ChatGPT 可能无法提供完全准确的学术来源。

ChatGPT 能够帮助学生在理解复杂概念时,提出一系列具体的问题来填补知识空白。如果学生不确定某个观点或理论的含义,或者在阅读中遇到不理解的段落,ChatGPT 可以帮助澄清这些问题。例如,如果你正在研究量子力学,并不理解薛定谔的猫实验的真正含义,ChatGPT 会根据你的问题进一步解释。

写作初稿后,ChatGPT 可以帮助学生审查文章结构,提出如何改进文章组织方式的建议。如果你已经写好了论文大纲,ChatGPT 可以帮助你检查文章各部分是否衔接得当,或者哪些地方需要进一步加强论证。

倒写大纲是一种检验论文结构的技巧,它能帮助学生快速看出每段的重点以及它们之间的关系是否合理。倒写大纲有助于确保文章的逻辑清晰,避免论点或论证出现不连贯的地方。

通过与 ChatGPT 进行对话,学生能够像苏格拉底式提问一样发展他们的思维。通过一系列相互质疑的问题,学生可以理清自己的思路,找出论证中可能存在的弱点。这种互动能帮助学生理清论证结构,增强思考的深度。

学生可以要求 ChatGPT 挑战他们论文中的论点或假设。通过这一过程,学生能发现自己在写作中可能忽略的论证漏洞。学生可以让 ChatGPT 扮演不同的观点角色,提出反对意见,帮助他们加强论证的说服力。

学生还可以利用 ChatGPT 来模拟历史上伟大思想家的观点,从不同的视角来看待自己的论文论点。比如,学生可以让 ChatGPT 扮演笛卡尔或休谟,帮助他们探讨关于自由意志或其他哲学问题的深层次讨论。

ChatGPT 不仅可以帮助学生在写作中纠正错误,还可以提供有针对性的反馈,帮助学生逐步提高写作质量。通过让 ChatGPT 审阅并提出改进建议,学生可以不断优化自己的写作技巧,提升论文的整体质量。

除了文本形式的反馈,ChatGPT 还支持语音模式,能够在学生阅读时提供即时的解释和反馈。如果学生在阅读学术文章时遇到理解上的困难,可以通过语音模式提问,ChatGPT 会为他们解释复杂的段落和概念。

12. 不仅仅是完成任务——磨练自己的技能

12. 不仅仅是完成任务——磨练自己的技能

写作不仅是为了交作业,它是提升批判性思维和写作技巧的一个过程。通过和 ChatGPT 互动,学生可以识别自己思维的盲点,并学会如何改进自己的论证。ChatGPT 可以帮助学生发现他们在写作中的常见问题,并提供策略,帮助他们在写作过程中持续进步。

最后,学生使用 ChatGPT 时要确保学术诚信。如果 ChatGPT 对你的论文或写作过程有所帮助,一定要在参考文献中注明。你可以将和 ChatGPT 的对话内容整理成引用格式,确保你的论文透明、公正,并能真实反映使用了该工具的过程。

随着 openai 的新实时搜索功能, ChatGPT 正在将自己定位为传统搜索引擎如 google 的竞争对手。ChatGPT 以其对话式的响应而闻名,能够提供实时的上下文信息而不带广告。

我抓住机会看看 ChatGPT Search 与 Google 长期以来的搜索专业性相比如何。我进行了几次比较,涵盖了速度、准确性、视觉效果和整体用户体验等类别。以下是它们的表现。

问题: “东京的主要旅游景点有哪些?”

Google 的搜索引擎非常快速,结果在毫秒内就能交付。搜索引擎拥有多年的优化经验,并且有专门为高速索引和检索而构建的基础设施,可以立即获得来自多个来源的广泛相关结果。

ChatGPT 的搜索同样快速,并为每个地点生成了更清晰、更用户友好的图像和信息。显然,AI 通过从相关来源提取信息来生成响应,然后以对话的方式分享这些信息。结果感觉更加友好,几乎就像 AI 很高兴我去旅行一样。

使用体验: ChatGPT Search

在以对话且简洁的方式提供有价值的快速响应方面领先。

问题: “解释气候变化和全球变暖之间的区别。”

Google 的响应来自 Gemini,概述了气候变化和全球变暖,并将其包裹在一个简短的段落中。从那里,我可以向下滚动并搜索一些来自 NASA、USGS.gov 甚至 Quora 的链接。显然,算法优先考虑流行和权威的来源,但它也是以广告驱动的,这意味着顶部结果有时包括我看到的来自联合利华的赞助内容。此外,对于复杂的主题,我发现自己需要浏览多个链接才能拼凑出完整的答案。

ChatGPT 提供了直接的答案,从网络中提取经过验证的信息,然后添加了一个可点击的「来源」图标。这个功能减少了我在 Google 搜索中从多个网站收集信息的时间。在这个搜索和其他搜索中,ChatGPT 的总结对于一般查询甚至更详细的主题都是准确的,其设计允许更干净、更加集中的体验。(不过,请记住,广告可能会在未来出现。)

使用体验: ChatGPT Search

在便捷和准确的直接答案方面赢得了这一轮。

问题: 苹果目前的股价是多少?最近有什么新闻更新?

Google 实际上没有给我一个立即的答案。相反,我得到了一个指向 Yahoo Finance 的链接,我可以点击并希望自己找到答案。

ChatGPT 在毫秒内,答案就在我眼前。我还得到了关于苹果的新闻和更新,当然,还有来源。ChatGPT Search 真是令人耳目一新。我得到了问题的答案,而不需要四处寻找细节。通过将答案直接呈现在我面前,我节省了时间,而不需要再点击几次。显然,对于实时的股票 或天气更新,ChatGPT 提供了可比的准确性,甚至在深度上超过了 Google 庞大的视觉数据库。

使用体验: ChatGPT Search

继续以其策划的实时直接答案给我留下深刻印象,显示出未来更新的潜力。

问题: 给我展示社交媒体对心理健康影响的最新研究。

Google 提供了如此多不同的答案,我甚至不知道该从哪里开始。从 Gemini 的响应到侧边栏,再到下面的链接结果,整个体验极其杂乱——这是我在使用 ChatGPT Search 时从未注意到的。此外,Google 的广告模式意味着用户数据通常被用来提供个性化广告。虽然 Google 有广泛的隐私政策和设置,但其广告驱动的方法可能导致不总是优先考虑用户隐私的定向内容。

ChatGPT 再次,ChatGPT 搜索提供了一个更清晰的界面,没有推广内容。对于这种个人化的搜索,额外的隐私关注方式让我非常感激。作为一个希望在搜索过程中不被广告定向的用户,这种方式对我来说更具吸引力——或者在之后。

使用体验: ChatGPT Search

在考虑隐私和负责任的内容使用方面领先。对于敏感搜索,不被广告定向是一个巨大的优势。

问题: 什么是我客厅里最好的电视?

Google 我说的就是我说的,Google。在纠正我输入「What's」而不是「What is」后,Google 给我回应了一些链接,所有这些链接都是赞助的,我需要点击才能找到电视。在得到这个回应后,我感觉我需要再次问它以帮助缩小范围。然而,在赞助链接下,还有来自内容发布者的链接。

ChatGPT 为我缩小了范围,包含了图像,并给出了我想要的答案。AI 确实感觉像是一个朋友,提供有价值的信息。每个电视图像旁边都有一段介绍,提供关于每个电视的信息。与 Google 相比,这种设计感觉更加干净和简洁。此外,对话格式直观,我可以滚动浏览推荐,而不需要像在 Google 搜索中那样需要浏览多个链接。

使用体验: ChatGPT Search

提供了一个令人耳目一新的体验,直接回答和具体示例。

问题: 谁在民调中领先?

Google 的结果包括有关选举的新闻故事。我希望通过这个问题获得关于今天总统选举民调中谁领先的直接结果。我不得不挖掘新闻故事才能找到答案。

ChatGPT 给了我我想要的结果,直接提供了事实。选举新闻无处不在,所以我不需要阅读更多的新闻故事。ChatGPT 给了我一个直接的答案。

使用体验: ChatGPT Search

提供了没有繁琐的实时答案。

问题: 洋基队在世界大赛中是如何崩溃的?

Google 的第一个结果是从《纽约时报》关于该主题的故事中提取的引用。这是一个快速的响应和直接的答案。然而,它让我感觉我没有得到完整的故事。

ChatGPT 提供了更全面的回应,从更多来源提取信息,但仍然感觉干净简洁。我得到了洋基队彻底失败的完整画面。

使用体验: ChatGPT Search

再次提供了我所寻找的实时答案,并增加了确认我获得所有信息的全面性。

ChatGPT 和 Google 在不同领域都表现出色,但它们满足的需求略有不同。如果你在寻找全面的搜索结果,拥有大量来源和视觉效果,Google 仍然是强者。

然而,如果你的优先事项是清晰、无广告、对话式的响应以及内置的实时更新,ChatGPT 提供了一种流畅、用户友好的体验,可能很快就会成为日常查询的主流。

ChatGPT Search 提供的无杂乱答案以及支持它们的来源是全面且可靠的。我对 ChatGPT 的答案更有信心,因为它们简洁且没有广告商的支持。结果感觉就像是专为我准备的。在杂乱的网络中,ChatGPT 就像一个乐于助人的朋友,我喜欢这种感觉。

这是我蓄满了四年的长发,原本是打算捐给金丝带的,但我决定放弃了。

一来,捐赠的人太多了,不缺我这一个,它不需要我;

二是,这个活动太热门了,报不上名,我不喜欢凑热闹;

于是,我心里很快就决定了:剪掉,并且要烫卷、染发!

在音乐教室里,筱烨、阿吉和秋秋在上课,我就在旁边用 ChatGPT 写 Prompt,写完之后就丢给 Midjourney 去生成效果图。遇到不满意的,就丢两张我以前的半长发的照片上去,再调整 Prompt 的细节,接着画。

最后,我把这张效果图发给发型师:

虽然这脸型偏硬了,不怎么像我,但这个头发感觉是我想要的。

曲线、松软、紫色挂耳

确定方案之后就直接约时间,一方面要约发型师的时间,他很好约,就在楼下,我随时过去随时可以做;但另一方面,要约收头发的师傅过来,需要由他根据长度把我的头发抽出来。这也是我第一次卖头发,挺新鲜的体验。

首先,我要跟发型师和收头发的师傅一起商量,怎么剪、剪多少、剪到哪里、用什么方法剪。我原本以为就是咔嚓一刀剪了,但其实不是。整个过程里,这位师傅需要非常仔细地把我头发中最长的部份找出来,每次只挑选一小撮,然后用剃刀在距离头皮大约 8-10cm 的位置一点点把头发切断。这样做的目的是,即确保剪下来的头发是满足他收头发的需求,也能确保给发型师留有后续足够的操作空间,还得让头发之间的层次能自然地衔接上。

每次剪下一小撮头发后,他都会仔仔细细地把头发梳几遍,确保没有任何打结,然后放在准备好的毛巾上,平放着。剪之前还特意要把周围的风扇都关掉,万一吹乱了,这些头发都全都没用了。他就这么一遍一遍地重复捏一小撮、切下来、梳顺、平放,如此反复了半个多小时,才终于从我头上抽出来两把共 59g 的长发。

然后就是烫卷和染发。

之所以想这样折腾一下,多少有一点破罐子破摔的心态在,觉得既然这头长发不被需要了,那也就放过自己,不要再被「这件事」困住了,索性趁着这个机会来尝试一下之前没折腾过的事情!

其实我 17 年前也染过一次发,但那时候是因为演《暗恋桃花源》的老导演,为了贴近角色的年龄感,我就去染了一头白发。只不过那个白发染得不成功,黄黄的,加上那会儿我比较消瘦,自己觉得不好看,所以演出结束的第二天我就去剃光头了。所以那次严格来说我不觉得是一次正经的染发体验,毕竟没有顶着这头黄毛生活,勉强能算一次临时的体验。

我当然知道它会掉色,会变成黄毛,会干、会毛躁。

但这不重要,因为我就想试一试。

我紧绷了三十多年,现在崩断了,还不能讨好一下自己,玩一玩吗?玩!

不仅要玩,还要玩得不一样,用 AI 一起玩!

为什么是紫色?因为我喜欢!

虽然我也喜欢绿色,但我也不想染成绿色

朋友说像杨千嬅,像极速拍档的小乔,那也挺好。

最近两周我忽然意识到,我是会因为自己感觉到快乐而感到羞耻的。这是从小根深蒂固的想法。过去我知道,如果我遇到一件好事,一件开心的事,就会有一个声音在警告自己不要乐,不要得意,不要喜形于色,要收起来,不然马上就会招来不幸和倒霉。但我一直认为这是克制和谨慎,是对于能量守恒定律的迷信式的执念,觉得这会儿开心了以后就没有了。

可是,为什么要把开心攒到以后呢?有没有以后都不知道。

筱烨说我的动力来自恐惧,确实,我总有各种恐惧在周围,挥之不去。

但现在我看见它了!我要让我的快乐活过来!我不要快乐羞耻!

尽管我现在还没有什么活力,但起码这个紫色能令我舒服好一阵子!

最后再看一眼,这头蓄了四年的长发和发髻。

我很喜欢这根石纹簪,但我感觉我应该不会再束成这个样子了。

这天色真好。

Early this coming week those fortunate enough to have an Apple silicon Mac will be able to update Sequoia to version 15.1 and try out Writing Tools at last. I’ve been testing and using them since the first beta of 15.1 back when the daylight lasted well into the night. I’ve been surprised at how lukewarm some have been at their arrival, particularly as most of those comments have come from those who make a living from their writing.

Perhaps the best way to show what Writing Tools can do is with an example, using the text from yesterday’s article A brief history of Mac firmware, a little over a thousand fairly technical words. I concentrate here on Writing Tools’ summary modes rather than its rewriting features, although they’re also thoroughly sound and useful in the right context.

Producing a succinct single paragraph summary is a challenge for even the most literate of humans. I’m impressed with Writing Tools’ 62 word offering of:

Mac firmware has undergone significant changes, from the Macintosh ROM in Classic Macs to Open Firmware in PowerPC models and EFI in Intel Macs. EFI, later evolving to UEFI, provides hardware access and boot services, while Apple silicon Macs employ a verified chain of trust for enhanced security. Firmware updates are now integrated into macOS installers and updaters, ensuring security and accessibility.

With so much information in the original, a key point summary should provide a better reflection of my original thousand words. Rather than reproducing the full 250 words generated by Writing Tools, here’s an excerpt covering one of the more challenging sections:

I don’t think I could better that.

The third type of summary suitable for that article is a detailed list. This strips everything else out to leave terse factual sentences. For the whole text, it reduces to 833 words, a reflection on its already dense information. You’re unlikely to want to use this with longer passages, but here’s the same section given as key points above:

The fourth summary option is to generate a table. Unfortunately, my example wouldn’t produce a useful table without substantial additional knowledge. However, I’ve found this useful on long passages from fiction, where it can summarise relationships between different characters, and similar tasks.

Once Sequoia 15.1 has been released and I’ve had a chance to explore the internals of Writing Tools further, I’ll look at its processing and energy costs. Two important features distinguish it from other contemporary AI tools: all data remains on-device throughout, and it’s primarily using your text rather than a large language model built from vast quantities of text garnered from around the internet.

Privacy doesn’t generally worry me particularly, as much of what I write on Macs is destined in some way or another to be published, whether it’s in an article here, one in the magazines that I write for, or source code that will be built into apps. However, I do take exception to others making money out of my labours without my express consent, so I’ll generally be only too happy to keep my AI on-device.

I also think it’s important to draw a clear distinction between what Writing Tools offers, and the likes of ChatGPT. Now that I’m testing Sequoia 15.2 beta, I have been looking at that contrast. While you can’t ask Writing Tools questions (why would you want to when you have the whole text and its summaries?), I thought I’d see how ChatGPT answered one of my stock test questions for AI: what is the SSV?

At my first asking, ChatGPT didn’t have sufficient context, and told me that it’s a side-by-side vehicle, so I refined my question to what is the SSV in macOS?

Although much of its answer was correct and informative, the second sentence stated with complete confidence that the SSV was introduced in macOS Catalina, which is of course completely incorrect, as Catalina has a read-only System volume but not a Signed System Volume as was introduced in Big Sur. But you’d only spot that serious factual error if you already knew the answer.

Give me Writing Tools and my own fact-checking, thank you.

Apple provided developers with two Release Candidates of macOS Sequoia 15.1 this week. Provided there are no serious problems that come to light in the second of those, it’s likely that 15.1 will be released early next week, probably on Monday 28th. This article looks at what that brings, whether it’s safe to upgrade to Sequoia yet, and what comes next.

Traditionally, the x.1 update is scheduled to be released about a month after the initial upgrade to a new major version of macOS, and brings with it the first wave of bug fixes, and a few features that weren’t quite ready in time.

Although there are reports of some other bugs in Sequoia, by far the most disruptive have been those affecting networking. Apple fixed the most serious of those in 15.0.1, released on 4 October, but some have continued to experience problems. Opinion from those testing betas of 15.1 are that it does resolve all those, and for the great majority should be ready for general use, provided that third-party apps are compatible. So if you normally wait for the x.1 version to be released before considering upgrading, this should fit the bill.

Apple does provide a list of fixes for developers, although as there’s no mention of any networking problems there, I suspect this isn’t of much help to users.

For those whose Macs run an M-series chip, the main interest in 15.1 is the first batch of Apple Intelligence features. Over the coming months, these should include:

Of those, 15.1 brings Writing Tools and some other enhancements, but doesn’t bring Image Playground or ChatGPT. Although some have claimed that makes 15.1 little better, that understates the value and quality of Writing Tools for many.

Writing Tools should be accessible to pretty well any recent app that displays significant amounts of text. Although I haven’t intended the lower text view in SilentKnight to support them, Writing Tools are available there from the contextual menu (Control-click). They work great with all the text editors I have tested, including TextEdit, BBEdit, CotEditor, Pages, my Rich Text editor DelightEd, and even in my PDF viewer Podofyllin.

The initial release of Writing Tools in 15.1 does have language and regional limitations. It requires that your Mac’s primary language, as set in Language & Region settings, is set to English (US), although you can still switch to a secondary language such as English (UK) if you prefer. The other key control is in the new Apple Intelligence & Siri settings, where Siri’s language needs to be English (United States). As I don’t like Siri’s spoken interface, I have disabled that by setting the Listen for control to Off, and instead enabled a Keyboard shortcut to open Siri’s interactive window.

Apple has announced future support for non-US variants of English, and next year for other primary languages. However, Writing Tools still work excellently on British English, even that of Charles Dickens, with the settings described above.

When you have updated or upgraded to Sequoia 15.1, I suggest you download text versions of books by your favourite author(s) from Project Gutenberg and explore features in Writing Tools using those as prose sources.

Apple has this week released the first beta-test of Sequoia 15.2, with most if not all of the other Apple Intelligence features, including Image Playground and ChatGPT. Assuming testing proceeds well and there are no serious problems, this is likely to be released in the first couple of weeks in December. Although not confirmed yet, this should open supported languages to include most major regional variants of English.

Slated for next year is the extension of Apple Intelligence to cover French, German, Italian, Japanese, Korean, Portuguese, Spanish, Vietnamese, and others. However, these features aren’t likely to appear in the countries of the EU this year, and Apple hasn’t yet indicated when that’s expected.

For those concerned about on- and off-device AI and privacy, all the standard features of Writing Tools and Image Playground involve on-device processing, and don’t send your data to remote servers. If you choose to enable ChatGPT access, then that is handled off-device, but is opt-in, and requires a separate sign-in process to access either an anonymised free account or an existing ChatGPT account. You can also require confirmation of any Siri requests handled with ChatGPT before sending any information off-device.

Apple has already published a list of fixes in the first beta of 15.2, although it remains to be seen what it does for users.

Apple has also signalled that it will be releasing new Macs next week, widely rumoured to be the first to use the M4 chip.

iOS 18.2 的首个开发者测试版来了,这也是最接近下周正式推送的版本。

这一 beta 版本继续履行了 WWDC 2024 所推出的 Apple Intelligence「分阶段升级」的承诺,为开发者用户带来了属于苹果 AI 的四大新功能,其中就包括接入了 ChatGPT 的「更智能」的全新 Siri。

▲随 iOS 18.2 beta 版一同推出的 Apple Intelligence 新功能(图源:Perplexity)

此外,新版的 Apple Intelligence 将支持更多的地区和语言,但目前仍不支持国区。对此,苹果公司 CEO 蒂姆·库克表示「背后有非常具体的监管流程,我们正在努力推进」。

既然暂时无法上手体验,我们可以跟随 Youtube 视频网站上的数码博主 Brandon Butch 的视角,看看海外网友对于最新 Apple Intelligence 的体验和评价如何。首先来盘点一下本次苹果 AI 引人注目的四大新功能:

除上述新功能以外,最令人的惊喜的是 ChatGPT 的深度内置。不仅 Siri,还有很多其他功能也集成了 ChatGPT。并且值得一提的是,用户无需登录 ChatGPT 的账户就可以在支持其内置的功能中使用这个插件,诚意满满。

Image Creation 是本次 Apple Intelligence 的一个重大更新。相比于 Siri 的实用属性,这个功能则更加偏向娱乐。

其中,在 Image Playground 图像游乐场中,用户可以自由选择所给元素并融合生成几幅图像:

▲ 博主使用 Image Playground 功能生成图像

用该功能生成的图像可以切换「动漫」和「插画」两个风格,都很讨喜:

▲ 博主将生成的图像从「动漫」切换为「插画」

此外,用户还可以添加提示文本,同所选元素一起生成想要的画面,自然也可以通过文本直接生成:

▲ 博主添加了提示文本,并重新生成了一幅图像

这是以歌手 Taylor Swift 和篮球运动员 Shaquille O’Neal 为原型,使用 Image Playground 生成的 Q 版头像,可爱又有辨识度。

同属于 Image Creation 的 Genmoji 生成式 AI 表情符号则更强调社交属性。它可以通过文本描述和用户的个人形象生成专属自己的 emoji,还可以用于后续的短信聊天当中:

▲ 博主使用 Genmoji 功能创建了一个属于自己的表情

Image Wand 图像棒功能则允许用户在笔记中绘制草图,并将其加以润色和细节补充,使其变成一幅完整的,色彩结构丰富的图像。同样,用户也可以通过提示文本对生成的结果加以约束:

▲博主使用 Image Wand 功能润色了一幅草图

有意思的是,如果草图或者提示文本中出现了「人」,那么 Image Wand 将会自动忽略,只生成除「人」以外的其他部分。其中原因,也许是出于隐私保护或者伦理的考虑,也许是这个功能还不健全,我们不得而知。

可以注意到,本次更新中 Image Creation 所创造出来的图像,相比于 Apple Intelligence 刚刚发布时所使用的令无数人诟病的示例图片,在质量和观感方面都有不少提升。我们期待着它在正式发布时会变得更好。

苹果公司给搭载了「相机控制」按钮的 iPhone 16 系列机型开发了全新的 Visual Intelligence 视觉智能功能。这一功能可以帮助用户进行识物,获取关于物品的更多信息,还可以提供相应的购买渠道:

▲博主使用 Visual Intelligence 识物

用户也可以直接调用 ChatGPT 对取景框中的物品进行描述:

▲博主用 ChatGPT 直接描述索尼储存卡

此外,对于建筑物一类的对象,Visual Intelligence 可以告诉你它的地理位置;对于餐厅等地点,它甚至可以为用户提供营业时间和菜单等相关信息:

▲博主使用 Visual Intelligence 识别图片中的地点

在我们日常出行和生活越来越便利的今天,Visual Intelligence 智能视觉的终极目标,就是要成为用户的智能「机械眼」,让用户通过苹果 AI 观察世界,进一步降低获取相关信息的成本,提高便利性和效率。

回顾此前 Brandon Butch 对于支持 Apple Intelligence 的初代 Siri 的体验,我们可以得到的结论是其「智商有待提高」。

相比于 Image Playground 的娱乐属性,Siri 的升级更加实用而且「迫切」。

接入了 ChatGPT 的 2.0 版本 Siri 则可以直接基于 ChatGPT 提供的资料,对于用户的提问给出回答:

▲博主在询问 Siri,Siri 根据 ChatGPT 回答

这相当于给 Siri 接入了一个更为智能的「第二大脑」,实实在在地提高了 Siri 的「智商」。

当然,用户也可以在询问时选择是否调用 ChatGPT,甚至可以在提问中直接要求 Siri「询问 ChatGPT 并给出回答」:

▲博主要求 Siri 直接用 ChatGPT 查询当前时间

现在,即使用户的提问不够流畅,说话磕磕巴巴,Siri 也依然能够听懂并作出回应。

在众人期待许久之后,ChatGPT 与 Siri 终于「握手」。业内两大智能体的「合体」未来还会给用户带来哪些惊喜,拭目以待。

内置 ChatGPT 的全新写作工具 Writing Tools 或许可以一定程度上解决内容创作者的「灵感焦虑」。

除了可以使用「Compose」一键生成所需文案,还能用更加灵活自由的方式对 AI 生成的文本进行修改和调整以外,这款写作工具最令眼前一亮的功能是支持将用户的笔记内容归纳成几个小标签,然后转化为一幅图像。

实现方法也相当简单和优雅,在需要的文本下方轻轻画一个圆圈即可:

▲轻轻一圈,文字变成图像

如此充满想象力的交互手势,无形中也成为了提供给创意工作者用户的「灵感」之一。

相比于许多其他 AI 行业独角兽「爆炸式」的创新速度和产出量,苹果在 AI 领域似乎总是显得有些「挤牙膏」。

苹果软件工程高级副总裁克雷格·费德里吉在近期的访谈表示,公司的态度更像是「试着把每一部分都做好,等准备好了再发布」。显然,这与苹果公司 CEO 蒂姆·库克「不求第一,但求最好」的理念不谋而合。

▲克雷格·费德里吉(图源:9TO5Mac)

诚然,作为地球上最有影响力的科技企业之一,苹果能够放下「首发」的包袱,依然选择「低门槛」的亲民路线,以用户喜闻乐见的形式,把 AI 功能打磨得好玩又实用,其实已经相当难得。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

就在刚刚,openai 宣布推出 windows 桌面应用,向 chatgpt Plus、Enterprise、Team 和 Edu 用户开放 。

不过,官方表示,目前开放的只是早期版本,将在今年晚些时候向所有 ChatGPT 用户推出「完整的体验」。

例如,它还不支持高级语音模式,并且 GPT Store 的部分集成功能暂时也无法使用。

用户可以在微软应用商店搜索 ChatGPT,接着下载安装即可,安装包大约 110MB,附上下载地址:

The Windows app is currently only available to ChatGPT Plus, Team, Enterprise, and Edu users. This is an early version, and we plan to bring the full experience to all users later this year. With the official ChatGPT desktop app, you can chat about files and photos.

系统要求:Windows 10(x64 和 arm64)版本 17763.0 或更高版本。

在具体的使用过程中,OpenAI 提出了一个名为「Companion Chat」的辅助聊天功能,它允许你在不离开当前应用程序的情况下,快速访问和使用 ChatGPT。

这个功能类似于一个快捷方式或者浮动窗口,你可以通过特定的快捷键(Alt + Space)来调出这个聊天窗口。

借助这个聊天窗口,你可以快速地向 ChatGPT 提问、上传文件、生成图片或者开始一个新的对话。它还具有记住上次位置的功能,并且当主应用程序重置时,它会回到屏幕底部中心的位置。

此外,你还可以通过点击窗口顶部的「New chat」来清除聊天内容,或者通过点击「Open in Main Window」按钮将对话转移到 ChatGPT 的主应用程序窗口中继续。

如果不小心关闭了这个聊天窗口,你也可以通过查看侧边栏的聊天记录来在主应用程序中继续对话。

需要注意的是,如果这个快捷键已经被其他 Windows 应用程序占用,那么它将会不起作用,并且也不支持更改快捷键。

目前 ChatGPT 已经向 mac、Windows 两大操作系统开放桌面版本,但 Linux 却没有给出明确的时间表,也惹得不少网友在线催更。

另外,前不久 OpenAI 推出了 ChatGPT Canvas 功能,允许用户与 ChatGPT 合作处理写作或编程任务。

今天 ChatGPT Canvas 也更新了一个比较实用的功能,你可以点击右上角的「Show changes」图标来查看文章或代码的更改。

▲ Window 的 ChatGPT Canvas 功能,图片来自 @test_tm7873

如下文所示,我使用 ChatGPT Canvas 将朱自清的《背影》改写成文言文版本,点击图标,所做的更改一目了然。

实际上,今天更新的功能也算是补上了 ChatGPT 生态的重要一环。

不过,正如开篇所说,这个桌面版本本质上还是个阉割版,食之无味弃之可惜,尽管快捷键调用方式简单,但网页版所带来的体验明显会更好。

有人说 windows 11 适合大多数普通用户,即便个人需求不同,也可以在此基础上进一步调整(折腾)。仔细一想,更新使用 Windows 11 这段时间我确实进行了不少调整,稳定使用好一阵子之后,许多折腾过程被我逐渐淡忘。

于是想着写下本文作为记录,以便回顾,顺带给也有意深入调整 Windows 11 的朋友一些参考。

Windows 10 在初次使用的时候可以跳过网络连接设置,选择「离线账户」。这样可以避免微软账户的一些设置,但也会导致一些功能无法使用。而 Windows 11 在安装时──至少从 UI 来看──会强制要求连接网络并登录 Microsoft 账户。

如果你只想通过离线账户使用,或碰上微软服务抽风偏偏又无法登录的情况,在这一步可通过 Shift + F10 调出命令行,输入 oobe\BypassNRO。命令执行后系统将自动重启,此后初始化过程中的网络配置会额外出现「我没有 Internet 连接」选项,再点击「继续执行受限设置」后续即可配置离线账户。而如果你已经联网,看到强制要求登录 Microsoft 账户界面后才寻找使用离线账户账户的方法,此时只通过上面的命令是不够的——至少从我唯一的一次经历来看输入命令后重启后仍然会自动配置好网络,此时则需要先输入 devmgmt 打开设备管理器、禁用无线网卡,然后再输入 oobe\BypassNRO。

截至目前通过这些额外的手段还是能够使用离线账户,但微软如此收窄用户选择的空间,很难不让人揣测其意图,甚至给人留下一种不断侵蚀用户隐私和选择权的糟糕印象,毕竟在线账户只会让微软更轻松地收集各种用户数据,包括使用习惯、偏好设置等个人信息,而这些收集行为也不只在本设备,通过在线账户,微软也能更轻松地跟踪用户在不同设备间的行为,构建更完整的用户画像……收集到的数据则可以用于精准投放广告、出售给第三方广告商、通过与其他微软服务的集成二次扩大数据共享范围。

要知道 Microsoft 账户隐私设置界面着实复杂,迈过离线账户的坎,后面想要完全控制自己的隐私选项难度就不低了。

除了预装系统的 OEM 设备,新设备至少第一次的完整的更新是必要的,这些更新包含正常使用的驱动等。如果 Windows 更新无法为你下载安装特定版本的驱动,你也可以前往对应设备厂商的官网手动下载安装,如:

至于特殊的「鸡生蛋」情况──无线网卡驱动──没有无线网卡驱动无法联网、无法联网就无法通过 Windows 更新升级无线网卡驱动,可以通过 USB 网卡或者手机共享网络连接,或者直接下载驱动到 U 盘,然后在设备管理器中手动更新。对于 OEM 设备可以去对应官网寻找驱动支持,对于个人 DIY PC 主要前往主板官网下载最新驱动,当然如果你知道具体网卡型号(例如常用的 Intel AX210)也可以直接去对应官网下载。

说到 OEM 设备,OEM 厂商关于硬件的支持性应该优于更广泛的 Windows。倘若 OEM 厂商有提供完整的硬件驱动管理工具,这些工具优先级应该高于 Windows Update。为避免 OEM 驱动管理与 Windows 更新工作重复、覆盖乃至冲突,可以按照如下流程操作:

说回 Windows 更新本身。对于目前桌面端主要使用的三大(类)系统──Windows、macOS、各 Linux 发行版──相较于更加专用的各 Linux 发行版和产品线单一又严格由 Apple 控制淘汰周期的 macOS,兼容性最好的 Windows 在更新上也更容易受兼容性带来的多样性所困,从而很难实现更新行为和质量的一致性。这也是为什么每每听闻 Windows 更新问题时,总有人说「从来没遇到过」,也总有另一些人抱团抱怨仿佛 Windows 都快完全不可用了那般。

其实如今没必要过于抵制 Windows Update,更新内容本身带来的问题几乎没法举例,更多主要是更新过程中的意外。如果你很清楚自己在做什么,也可以尝试推迟 Windows 更新。除了在更多选项中至多推迟五周外,还可以通过修改注册表推迟任意长度时间:

你可以填写一个很大的天数,然后在需要更新的时候点击 Windows 更新中点「继续更新」即可方便地跳过更新推迟,在此之前不会收到任何更新检测或提示,更不会自动更新。

上述通过注册表推迟更新的操作可以通过脚本完成:

再配合任务计划程序实现自动化。这样就可以根据自己的节奏推迟更新、累计更新,例如每六周推迟五周等。

至于彻底禁止 Windows 更新,其实上文提到的通过注册表推迟到一个不可能的天数便可达到类似效果,除此以外还可以通过编辑组策略、修改更新服务器到一个空地址、借助诸如 Windows Update Blocker 等第三方工具等。这里不再一一赘述。

本篇围绕 Windows 11 系统本身的设置调整展开,尽量不涉及第三方软件、工具,若非要涉及也是主要是在辅助调整设置(例如把隐藏的系统设置项调出来)而不提供额外功能。

任务栏、开始菜单最直接的调整在「设置 > 个性化」中。

在任务栏设置中,我们要做的第一件事就是把塞满广告和各种无用信息的小组件整体关闭,然后根据个人习惯调整其他设置,比如我会将搜索仅显示图标、任务栏左对齐、永远合并任务栏按钮。

在开始菜单设置中,记得关掉第一面的所有推荐内容,并在「文件夹」中打开设置方便快速进入。

搜索栏在任务栏中的开始菜单附近,但是它的设置项目却在「隐私和安全性 > 搜索权限」中。而微软也往此处插入了一些「推荐内容」,需要在关闭设置项目最后的「显示搜索要点」。

在 Windows 11 中,即便解锁任务栏,我们也不能像 Windows 10 那般将任务栏拖动到屏幕左右侧,只能在底部。虽然通过修改注册表可以强行改动任务栏位置,但是会导致 UI 错位。更推荐的方法是使用第三方工具将整个任务栏回退到 Windows 10 模式,例如后面会介绍的 ExplorerPatcher。

除了任务栏和开始菜单,很多人在 Windows 11 中最先接触到的变化可能是右键菜单。其实如果不带成见来看,Windows 11 的右键菜单在设计上更加简洁、更符合整体设计语言,且按钮排布更加宽松,没有按钮增多时密密麻麻的视觉压迫感,也更适合触摸操作等非精确点击。

问题是,宽松的按钮排布,代价是并非所有功能都能直接在右键菜单中找到,部分功能被隐藏在「显示更多选项」中,且这些更多选项并非像「新建」那样以二级菜单展开,而是完全退回到类似 Windows 10 的右键菜单。在桌面/文件资源管理器按住 Shift 右键也能直接唤出这种经典风格的右键菜单,除了真的需要考虑触摸可用性,为什么不一开始就显示完全呢?

倘若你不想节外生枝使用复杂插件,其实直接修改注册表的方法也并不繁琐。

注销或重启文件资源管理器即可生效,右键菜单将恢复到 Windows 10 风格。

在我自己的日常使用习惯中,无论在 Windows 还是 macOS,虚拟桌面都是高频使用的功能。对于临时被打断或者由于时间问题没有完成的工作,在确保保存后我会将其原封不动放在原位置并新建一个虚拟桌面继续其他工作。同时在处理多个任务时候,我也会尽可能保证一个虚拟桌面内是一个相对独立的任务,相当于在标签页、窗口之上再加一层桌面维度,检索时更加快捷。

如此频繁的使用,自然容易在 Windows 10 升级到 Windows 11 感受到一些细微的变化。对于单次虚拟桌面切换来说动画是更加丝滑了——Windows 11 非线性动画的加速、减速比起 Windows 10 更加自然。但多次切换就有点灾难了,在 Windows 10 按住 Ctrl + Win 并多次按左右方向键时,滑动动画经历「加速 > 连续的桌面滑动(哪怕有来回)> 减速」停到目标桌面,而在 Windows 11 中,多次切换时,每次都会经历完整的「加速 > 减速」动画,相当于把单次切换简单的拼接起来,这样的动画在频繁切换时会显得有些拖沓。

以上都是针对快捷键切换虚拟桌面的情况,对于触控板切换来说动画都是尽量跟手的,而连续切换之间的停顿也符合直觉(毕竟触控板没法像快捷键那样连续多次按方向键,中间肯定也有停顿对应)。

网络上暂时没有找到将动画回退到 Windows 10 版本的方法,所以我简单粗暴地关闭了这个动画——在「设置 > 辅助功能 > 视觉效果 > 动画效果」开关可以关闭虚拟桌面切换动画,但是这样也会波及其他动画效果;在高级系统设置(cmd/Win + R: sysdm.cpl)中的性能设置中视觉效果页关闭「对窗口内的控件和元素进行动画处理」也可以关闭虚拟桌面切换动画,但同样也会波及诸如 Win + Tab 窗口动画效果,不过从描述来看想必波及的范围更小。

我个人有个癖好是桌面不出现任何图标、任务栏只留一个文件资源管理器、所有应用在开始菜单以磁帖排布。在注意力有些散漫的时候 Win + D 回到桌面欣赏下壁纸休息——不得不承认 Windows 11 背景设置中的「Windows 聚焦」挺好看,同时又不会过分吸睛,应该是和 Bing 每日壁纸同源的。

在「设置 > 个性化 > 主题 > 桌面图标设置」中可以关闭桌面图标。遗憾的是当清空桌面图标后,角落「Learn about this picture」更加显眼,且没有显式关闭设置,除了再次借助 ExplorerPatcher,也可以通过修改注册表实现:

这样桌面就只剩下壁纸了。如果你第一次这么设置会发现有一尴尬之处──回收站怎么进?确实一般情况下回收站都是放在桌面的。这时可以通过在文件资源管理器的地址栏中输入 shell:RecycleBinFolder 打开回收站,然后将其固定到快速访问中,这样就可以在文件资源管理器的侧边栏方便访问回收站。

硬件部分关于屏幕、缩放、渲染等内容会占用太多篇幅且涉及技术原理部分可操作性不强。这里直接给结论:

在 Windows 10 之时我还能接受通过 noMeiryoUI 软件方式修改默认系统字体为更纱黑体,配合 MacType 软件实现更好的字体渲染效果(一定程度上抵消 ClearType 在高分屏的负优化)。虽然 noMeiryoUI 依然兼容 Windows 11,Windows 11 上更多的系统组件、官方应用并不默认遵守该设置,导致字体修改效果十分有限。

因此在 Windows 11 上我选择一种比较 dirty 但是好用的手段──将其他字体(例如更纱黑体)重新打包成伪装的「微软雅黑」并移动至 Windows 字体文件夹下以欺骗系统。chenh96/yahei-sarasa 提供了一个截止本文修改时仍运行良好的 Python 脚本自动将更纱黑体伪装为微软雅黑和宋体。

目前主要有三种方法将伪装字体替换系统默认字体:

这里仅展示第一种方法,不需要任何额外工具。在 Windows 恢复模式中的命令行使用 xcopy 将伪装的微软雅黑移动到相应文件夹下:

覆盖后重启即可。请特别注意不要在任何有用于演示、汇报用途的 Windows 设备上进行此操作,以免一些不必要的麻烦。

Windows 的色彩管理仍是一个相对混乱的领域,短期内是不指望能和 macOS 相提并论。但是 Windows 11 还是比前代 Windows 10 在 HDR 支持上有 明显改进,至少算是过了及格线。

在开启 HDR 之前,还请确保屏幕至少支持 HDR 600 标准,HDR 400 可以当作不支持看待(注意区别于 HDR true black 400,这是 OLED 标准,甚至严格过 HDR 1000)。OLED 和 MiniLED 屏幕往往效果更好。

全局开关在「设置 > 系统 > 显示 > HDR」。开完先别急,点击下面的「HDR Display Calibration」,这里可以矫正 HDR 显示效果。

「自动 HDR」功能可以将仅支持 SDR 的游戏转化为 HDR 输出,效果挺不错。但如果你的设备使用较新的 N 卡,那更推荐关闭此功能 Windows 11 的自动 HDR,用 NVIDIA app 内的 RTX HDR 替代。由于 HDR 会尽可能用尽显示器硬件性能,不能通过调整显示器亮度来改变内容整体亮度,在开启 HDR 显示时只能通过设置「SDR 内容亮度」将桌面调整至不开 HDR 相近效果。

在开启 HDR 模式下就是纯 HDR 信号输出,不存在区域渲染,原本 SDR 内容也会通过算法转化为 HDR 输出,这其中必然是会丢失信息的。目前消费级 HDR 显示器素质良莠不齐。如果在开启 HDR 模式看 SDR 内容时发现颜色「寡淡」,有可能是眼睛已经被各种「鲜艳模式」惯坏了,毕竟在开启 HDR 后系统会自动对 SDR 内容做 sRGB 限缩,从某种意义上这才是「正确」的颜色,除此以外就是显示器还跟不上,前者可以尝试常驻 HDR 模式适应,后者建议常用 Win + Alt + B 快捷开关 HDR 仅在消费 HDR 内容时开启。

「Wintel 联盟」现在似乎已经很少提起,当初意图取代 IBM 公司在个人计算机市场上的主导地位,直至现在 Microsoft 和 Intel 的合作依然紧密。Intel 新大小核处理器在 Windows 10 上有许多调度问题促使其用户不得不选择 Windows 11。

如果你在电源设置中发现缺少某些设置项目,除了一个个查注册表,更方便的方法是通过 PowerSettingsExplorer 这个仅调用 Power Management Functions 接口的小工具来调出那些被隐藏的选项。在 Windows 11 中与大小核调度策略有关的隐藏高级电源设置有:

在「高性能」电源计划中,这三个的设置按顺序是「0 – 自动 – 自动」,调度策略是「大核 > 小核 > 大核超线程」;如果将后两个设置同时设为「高性能处理器」,那么调度策略变为「大核 > 大核超线程」。总体而言异类策略 0 优先使用大核,对应的异类策略 1 优先使用小核。异类策略 4 比较奇怪,它是「节能」电源计划的默认设置,但是在烤鸡、游戏挂机等测试场景大小核调度策略几乎和「高性能」一致,怀疑是高负载场景积极调度、中低负载再节能的策略。

其实预设的几种电源计划均挺符合直觉的,没必要过于纠结。即便有极端省电需求也不建议完全小核优先,其实该设置中的所谓「高效处理器」也就是小核还真未必比限制后的大核能效比高。看看对功耗更加敏感的移动端,都有越来越多大核的势头,乃至天玑的全大核构想。当然移动端大核甚至还没够到桌面端的小核,不能简单横向比较。不过时至今日我依然对桌面端异构架构持保守态度。

以上都是针对 Intel 新处理器的情况,对于 AMD 全大核处理器,Windows 11 的大小核调度反而引入额外问题导致游戏场景表现甚至不如 Windows 10。众所周知,锐龙 CPU 各核心都有成为 CPPC 属性,代表各个核心的「体质」,在 AMD 官方工具 Ryzen Master 中可以查看的金、银核心分别就是 CPPC 最高的两个核心,而 Windows 11 会将 CPPC 最低核心视为小核(高效处理器)进行调度。通过上述真正大小核的 Intel 处理器上观测的不同异类调度策略并在 AMD 全大核处理器上对应测试,发现 Windows 11 对 AMD 处理的调度的确遵循 N-1 个高性能处理器和 1 个高效处理器的策略。这样默认的调度策略会更不倾向调用所谓的小核,这种不对称可能会导致更多的跨核行为、特别是游戏场景频繁地 L3 缓存争用造成无端性能损失。

之前的民间偏方,在 BIOS 开 PBO、XMP/EXPO 的同时顺手把 CPPC 关掉,或许也是由此而来。

早在去年 UP 主 @开心的托尔酱 在视频 关于 Windows 系统对 AMD 的负优化—异类线程调度 就有提到这个问题。而在最近 AMD 在社区更新 关于 Zen 5 游戏性能提升远不及理论的回应,宣布 Windows 11 24H2 将通过优化「branch prediction」 来提升 AMD Zen3/4/5 系列处理器的性能表现,部分游戏甚至有 10% 以上提升,要知道 Zen 5 由于相较于前代提升过于微妙有被戏称「Zen 5%」,更有特例 5700X3D 在 Windows 11 上性能表现比 Windows 10 差 15%……该说锐龙 CPU 首发一如既往地一言难尽呢、还是说与 Windows 合作不够紧密呢?

当然,尽管 Windows 几个电源设置的预设符合直觉无需额外调整,电源设置里还是有很多可玩性的,例如不用重启调整 CPU 睿频参数等。具体不再展开,感兴趣可以参阅 Windows 电源设置注释。

Windows 11 在「设置 > 账户 > Windows 备份」中可以设置包括文件、设置等备份选项,但似乎必须绑定微软账户使用,对于离线账户并不友好。且这种方法不支持备份系统。

个人认为更好用的还属控制面板中的「备份和还原(Windows 7)」,不仅支持对系统分区全量备份,还支持制作系统镜像和系统恢复盘。虽然 Windows 在 知识库 中鼓励大家尽可能使用设置取代控制面板,无奈前者体验还偏偏不如后者。

此外,Dism++ 也提供系统备份功能,同时支持不添加文件的增量备份(不算快照)。Dism(Deployment Imaging and Management)是 Windows 自带的一个工具,用于安装和维护 Windows 映像,Dism++ 只是将常用命令封装成 GUI 便于操作,并没有额外单独实现,这种备份也算是半官方方法。

还有两个系统功能看似很好用但是我不推荐:一是系统检查点,它本意主要用于系统更新失败的回滚,很难说胜任纯粹的系统备份,对个人文件的行为很奇怪经常在回滚的时候搞得一团糟;而文件历史,它默认备份整个用户目录,需要自己一个个排除,且该功能仅放置于控制面板,微软对此也并不算上心,一个 bug 三五年不修。

话说回来,目前单独备份系统的意义远不如备份文件,通过链接把一些应用的数据文件夹(例如微信保存的文件)link 到其他分区、外置存储乃至云端上,更多链接操作留到后续关于快捷创建链接的工具那一部分。

Windows 11 正常要求硬件支持 TPM 2.0。TPM 芯片是一种安全加密处理器,包含多个物理安全机制以防篡改。BitLocker 会将专用密钥存储在 TPM 芯片内,在除了更改 TPM、BitLocker 检测到 BIOS 或 UEFI 配置、关键操作系统启动文件或启动配置的更改之外的情况下,BitLocker 会自动解锁,用户登录无需进行任何额外交互即可解锁。无其他加密手段建议对系统盘开启 BitLocker,这已经是 Windows 集成最高、最无感的方式。

关于几个关键问题:

如果真有换设备需求,但是事先忘记解锁 BitLocker,会导致无法访问数据吗?

不会。在创建加密的时候 BitLocker 同时会创建恢复密码,可以将其打印或存在安全位置。检测到硬件更改后 BitLocker 进入恢复模式,用户输入恢复密码可以重新访问数据。

备份工具是否支持 BitLocker 加密盘?

对于基于文件系统的备份方式来说,理论上解锁后 BitLocker 是透明的,先解锁再备份即可。对于分区的备份方式,理论上可以不解锁整个区拷走,但是加密后不知道哪一部分是空的会导致备份文件更大且不好压缩,虽说 BitLocker 通过长长一串恢复密码也可以离线挂载,但不建议盲目还原。

BitLocker 是否会影响性能?

理论上会,但实际上体感不明显。别单看开 BitLocker 后硬盘读写速度有的下降超 10%,解密过程应是压力越大损耗越明显,所以不能根据硬盘测速这一极端压力情况下的性能损耗来界定 BitLocker 的性能损耗。

BitLocker 闭源,微软可以添加后门,如何保证安全?

你说得对,可以尝试开源方案 VeraCrypt,支持 Windows 11 系统加密,在普通分区加解密上还提供更好的跨平台支持,但是 VeraCrypt 不支持 TPM 且由于理念不合永远不会支持,在和 Windows 集成上肯定也不如 BitLocker 无感。看你愿不愿意拿所谓的安全换便利了。

平心而论,这个软件本身并没有什么问题,但是大陆用户对「电脑管家」的 PTSD、早期仅在中国区推送和不事先提醒地静默安装才是其被人诟病的原因。

后来,我的区域美国、语言英语的 Windows 11 也被推送,Reddit、Discord 也有相关讨论,才得知微软打算全球推送。单看软件本身,清理、加速、系统保护项、应用管理、常用小工具(截图、字幕、翻译、词典、以图搜图等)还有快捷修复建议,其实就是可能原本在设置里藏很深的 Windows 已有功能的拿出来,不需要联网也没有广告,不像小组件和 Office Plus 那样尽塞垃圾。

如果抛开前两点,静默安装也确实不厚道,用户的诟病并非完全无端。不过实现手段其实不是 Windows 更新而是 Edge 后台下载安装包安装。所以它就单纯是个软件,看不惯直接卸载就好。Edge 自从某次我重装系统后,在搜索 Chrome、进入 Chrome 官网时用大半个页面阻挠我安装 Chrome 我就已经心留芥蒂,出了这一茬直接让我彻底禁用 Edge,还不能简单卸载,留到后面 Remove MS Edge 插件部分。

除了深入设置、注册表、组策略等方法调整系统外,还有一些第三方插件可以帮助我们更好地使用 Windows 11。当然这里提到的插件依然主要针对系统调整,不发散到更广泛的效率提升上。

Windows 本身其实一直缺乏一个好用的包管理器,不提不如 Linux 各发行版的,就连 HomeBrew 类似产品都没有。微软官方推行的 WinGet 严格意义上称不上包管理器,它并没有提供统一的包格式,而是依赖于各个软件的安装程序下载下来静默安装,正如 HomeBrew Cask。Scoop 才稍微有些包管理器的感觉,安装同时也能自动配置环境变量,在迁移时备份还原更方便。如果不介意添加多余的工具,用 UniGetUI 可以一次性管理 WinGet, Scoop, Chocolatey, Pip, Npm, .NET Tool 和 PowerShell Gallery 多个包管理器。

仅关于 Scoop 的安装,在 PowerShell 中输入以下命令即可:

倘若你还希望使用 UniGetUI,可以在 PowerShell 中输入以下命令通过 Scoop 安装:

Windows 并不像 macOS 通过三个应用分别控制桌面、Dock 栏、Finder,而是通过一个「资源管理器」一并控制。而 Windows 11 相较于 Windows 10 许多令人不满的改动──任务栏、开始菜单、右键菜单──都可以通过介入资源管理器来调整。

虽然前面系统设置部分已经提到部分调整手段,但是这些调整往往需要手动修改注册表等隐藏更深的手段。如果你不想折腾,亦或是觉得这些调整不够全面,可以尝试 ExplorerPatcher 这款开源插件,不仅可以将任务栏、开始菜单、右键菜单一并调回 Windows 10 风格,还有许多诸如屏蔽 Office Key、禁止文件高级搜索、取消窗口圆角等功能。

虽然在部分时刻,例如系统更新后,ExplorerPatcher 偶有失效,但考虑到开源插件能做到这种程度,完全配得上其自称的「增强 Windows 上的工作环境」宗旨,无需吝啬赞美。

开源项目 Power plan switcher 可以在系统托盘中切换电源计划,支持快捷键、自动切换等功能。

一般来说对于长期接通电源或者没有续航焦虑的设备可以常驻「高性能」或「卓越性能」电源计划,这些计划的默认设置已经十分符合直觉,无需额外微调。

而对于笔记本电脑,它有时接通电源有时使用电池,前往控制面板翻出电源计划设置十分麻烦。PowerPlanSwitcher 可以不仅在系统托盘中切换电源计划,还支持在电源状态变化(从 AC 供电到电池供电)时自动切换对应电源计划。

官方称该软件支持 Windows 10,但实际上在 Windows 11 上也能正常使用。

Microsoft PowerToys 是一组实用工具,可帮助高级用户调整和简化其 Windows 体验,从而提高工作效率。

作为一款出现在 Microsoft 知识库的官方工具,可能考虑到不用像 Windows 那样背负沉重的历史包袱,PowerToys 工具箱中的绝大多数功能都轻量、专一且直击用户需求,被誉为 Windows 用户必备瑞士军刀,且在 GitHub 上完全开源,算是微软给我留下正面印象的产品之一。

早在 Windows 95 时代,PowerToys 就集成了包含了 Tweak UI 在内的共计 15 个小工具,Tweak UI 可以调整 Windows 中原本需要修改注册表才能访问的较为晦涩的设置。微软在 2019 年接管并重新推出 PowerToys,目前也已经有如下我认为很好用的功能:

同时还有诸如 Color Picker、Image Resizer、Text Extractor 等一众小工具,让你免去管理一堆小工具的烦恼、也减少众多工具中出现某几个断更的风险。PowerToys 也有丰富的 第三方插件,例如 PowerTranslator 在 PowerToys Run 中直接翻译文本、

EverythingPowerToys 在 PowerToys Run 中通过 Everything 检索文件、

ChatGPTPowerToys 在 PowerToys Run 中调用 chatgpt、

PowerToys-Run-Spotify 在 PowerToys Run 中让 Spotify 放歌等等。

各个工具具体用法这里不再赘述,PowerToys 每个工具页面都有详尽的描述。

单看 PowerToys Run 中的文件搜索功能其实比较孱弱,而 Windows 资源管理器的搜索效果更是惨不忍睹。Everything 通过访问 NTFS 文件系统的 USN 日志,在数秒内检索 TB 级别硬盘,并实时监测所有文件的增改情况,同时支持通过正则表达式进行文件精确匹配,还可通过插件与 PowerToys Run 联动。

自从某次我重装系统后,Edge 在搜索 Chrome、进入 Chrome 官网时用大半个页面阻挠我安装,反而彻底让我将 Edge 定位明确为 Chrome 下载器。更改默认浏览器后某些链接还是会给我跳转到 Edge 打开,之后还闹出自动下载静默安装微软电脑管家一事。

不过 Edge 是不能够简单直接卸载的,可能会导致一些依赖系统 WebView 的应用出问题,而且可能在某次重启后惊觉 Edge 又回来了。

Remove MS Edge 这个工具旨在通过可执行文件或批处理脚本以静默方式彻底卸载 Microsoft Edge,并提供保留 WebView 选项。

虽然 PowerToys 的 Keyboard Manager 也能完成一些键盘映射的工作。但是 AutoHotKey 作为完整脚本语言,功能更加强大,可以实现更多的自定义功能。

例如我对于大写锁定键的需求很小,但是却又有频繁的中英文输入法切换和自定义快捷键需求。自定义快捷键时一般会引入 Hyper 键 的概念,在 Windows 上即同时按下 Ctrl、Shift、Alt、Win 四个键,这样可以避免与系统快捷键冲突。

我希望产生下述行为:

这种行为仅通过 PowerToys Keyboard Manager 是难以实现的,但是通过 AutoHotKey 可以轻松实现:

同样的,在 macOS 中文输入法会自动将 Shift + [/] 映射为部分中文排版更推荐的直角引号「/」,而 Windows 自带输入法并没有这个功能。除了更换输入法、全局替换掉某个键、设置字典打出一对引号等方法,通过 AutoHotKey 识别当前输入法状态并映射不同的按键不失为一种更优雅的解决方案。

在 Windows 上也有自带的 Win + V 的高级剪贴板功能,甚至可以和微软账户绑定实现云同步。但是这个功能对我而言比较花里胡哨,UI 确实更加现代化也与系统保持一贯风格。不过系统自带的剪贴板历史过于循规蹈矩,保存的历史条目太少不说,在隐身浏览器模式下乖乖不记录。Ditto 作为一款开源剪贴板增强工具,UI 更加简洁紧凑,可以保存更多历史记录、支持搜索、支持自定义快捷键、同时还有清除格式等高级粘贴功能。

配合 AutoHotKey 设置的 Hyper 键,我一般通过 Hyper + V 调出 Ditto 剪贴板历史记录。

C++ 编写的小工具具有不俗的性能,在保存 300 条目且不随时间清空的情况下,调出和检索都察觉不到卡顿,且占用极低只用个位数 MB 内存。

在 macOS Finder 中,Quick Look 赋予空格快速预览文件夹属性或者多种文档内容功能——俗称「一指禅」。Windows 用户一直垂涎这种功能,虽然 Windows 资源管理器也可以通过侧边栏预览,但是这种方式开启后任何选中都会预览,占用大量资源,同时支持的文件内容类型也有限,还会有反馈带来奇怪 bug。

这催生了 Windows 同名第三方开源插件 QuickLook,行为几乎与 macOS Quick Look 一致,通过空格快速预览,同时支持通过 引入插件的插件 形式支持预览 markdown、jupyter notebook、电子书等更多格式文件,并且支持在 Directory Opus、Files、OneCommander 等第三方文件管理器中使用。

MacBook 触控板和妙控板凭借着超大的触控面积、以假乱真的震动体验和 macOS 软硬结合,造就了曾经以及当下最优秀的触控板体验。许多 macOS 用户或许和我一样并不愿意使用鼠标,而是更倾向于触控板。其中稍微有些弯弯绕绕就属 macOS 的三指拖拽,如此好用的功能就藏在辅助功能里。

当然随着微软给出精确式触控板的驱动和建议硬件规格,也体现出 Windows 对于触控板的上心,目前绝大多数 Windows 设备触控板也都支持精确式触控板,相当一部分产品日用体验已足够优秀。可惜的是即便系统对于多点触控的支持已经覆盖从二指到四指,但是三指和四指滑动手势略有重合且使用频率不高,Windows 也没有给出类似 macOS 的三指拖拽功能。

好在可以通过插件 ThreeFingerDragOnWindows 在 Windows 上实现 macOS 的三指拖拽,依赖 .NET 运行环境实现。使用前请确保通过触摸板设置中禁用「轻点两次并拖动以多选」行为和所有默认的三指轻扫行为,这样拖动操作才不会受到干扰。

相较于 Windows 10 主题色、背景和明暗模式的割裂设置,Windows 11 将更统一、更完善的「个性化 – 主题」设置提到更优先位置,并提供若干预设主题。但是 Windows 11 仍然没有 macOS 那样的自动切换深色模式功能。Windows Auto Dark Mode 支持通过设定固定时间或跟随该定位的日出日落时间自动切换深色模式,同时可以自定义深色、浅色模式对应主题。

在前文提到:

目前单独备份系统的意义远不如备份文件,通过链接把一些应用的数据文件夹(例如微信保存的文件)link 到其他分区、外置存储乃至云端上……

所谓「链接」,在文件系统中指的是软链接(符号链接)和硬链接──两种创建文件引用的方法。软链接(符号链接)是指向另一个文件或目录的路径,可以跨文件系统,类似于快捷方式;如果原文件被删除,软链接会失效。硬链接是直接指向文件数据的引用,两个文件共享相同的物理数据块,它们的内容完全一致,删除一个硬链接并不会影响到文件的实际数据,只有所有硬链接都删除时,数据才会被清除。硬链接只能在同一文件系统中创建,其实文件管理器上的几乎所有文件都可以被看作是硬链接。

更详细关于链接的介绍可以参阅少数派文章 符号链接、硬链接及其在 Windows 上的应用举例。我对 Link Shell Extension 的初识也正是在这篇文章中。一个最常见的案例是,对于 小而美 微信可以将其 Files 文件夹移动至 OneDrive,然后通过符号链接将其链接回原位置,这样既可以保证微信正常运行,又可以实现微信保存的文件备份。该插件的智能多版本硬链接功能会自动分析和前一次的差异并对不变的内容创建硬链接,实现增量备份,但该功能不能链接到外部存储,仅适合在同盘做备份版本管理。

特别注意,少数派文章中介绍的「中键拖动」快速创建链接操作不适用于 Windows 11,正确操作应当修改为使用右键拖动。

虽然 Windows 自带输入法对于绝大多数用户已经足够好用。但是我有跨设备需求,特别是需要兼容 macOS 和 Windows 双系统,这导致明明两者的系统自带输入法都可圈可点我都率先排除。而高度自由、高度定制的 RIME 进入我考虑范围。在 Windows 上通过 Weasel、在 macOS 上通过 Squirrel 实现 RIME 输入法的部署,在 Linux 上还有诸如 ibus-rime 等多种版本。

但 RIME 的高度自由伴随的也是较高准入门槛。好在开源项目 oh-my-rime 及其 配套配置教程 算是相当程度上降低这种门槛。但这种打包配置并未限制你设置自由度,你依然可以根据自己的需求自行修改配置文件,例如取消 Shift 切换中英文、更改翻页快捷键和以词定字快捷键等等。

许多功能和其他配置在 oh-my-rime 项目教程中也有提及,这里单独展开讲一下多设备同步。虽然该教程中也完整提到同步设置,但是同步行为是要用户手动触发的,而平时工作中很可能忘记触发。更优雅的方案是通过 Windows 的计划任务触发同步:

chatgpt 最近推出会主动思考推理的「 o1-preview 」,以及更即时、自然的「高级语音对话模式」后,今天又再次推出新功能:「ChatGPT Canvas」,这是基于 GPT-4o 架构开发的全新 ai 写作、源码编辑界面。让 ChatGPT 不再只能对话,而可以进行更深入、准确的内容创作工作。

第一波更新中,ChatGPT Plus 和 Team 用户会先获得 Canvas 功能,而全球的企业和教育版用户将会在下周获得使用权限。并且 openai 还计划在 Canvas 正式发布后,向所有 ChatGPT 免费用户开放这项新的人机协作界面。

实际测试后,我觉得可以把「ChatGPT Canvas」想象成一种 AI 文本、源码软件,在这个工具中,人和 AI 可以更有效率的协作,共同编辑更好的内容成果。

以前的 ChatGPT 是即时通,一切内容要在对话中生成,也只能用对话引导 AI 去生成、修改,这很多时候会有点麻烦,常常在问答的过程偏离主题,难以指定要修改的部分,容易愈改愈乱,再也回不去之前更好的版本。

但是「ChatGPT Canvas」能够解决上述问题,它让人与 AI 在一个类似文本编辑的界面中讨论,就像多人一起编辑一份在线文件那样,可以一起处理文字、源码内容,可以针对任何指定段落修改,能够整合人与 AI 各自编写的内容,最后一起合作完成一份文本。