苹果首款人工智能芯片曝光,想让 iPhone 的 AI 体验更「丝滑」

继 OpenAI 宣布计划自研 AI 芯片之后,科技巨头苹果近日也传出了其正在与博通(Broadcom)联合研发 AI 芯片的消息。

有趣的是,两家公司针对此事竟给出了几乎相同的理由:尽量避免对英伟达的依赖。实际上,「多元化芯片来源」正是苹果 AI 持续战略的一部分。

博通似乎成为了近期 AI 硬件领域的「香饽饽」,其在短短一个多月之内就与两家 AI 领头羊企业达成合作。据悉,博通已经占据了超八成 AI ASIC 市场,其在 2025 财年的 AI 收入有望达到 170 亿美元以上,同比增速超过 40%。

与苹果的合作消息一出,博通的股价应声上涨 6%,苹果股价也有短暂小幅上涨。这并非两者的首次合作,2023 年五月苹果就曾宣布与博通合作开发 5G 射频组件等等。

▲图源:优分析

据「The Information」报道,苹果 AI 芯片的代号为「Baltra」,将采用台积电先进的 N3P 工艺,计划于 2026 年投入量产。这个时间也与 OpenAI 自研 AI 芯片的量产时间重合。

消息称,Baltra 的设计开发旨在优化 AI 工作负载,增强 AI 和机器学习(ML)功能。这枚芯片将专用于推理任务,以及处理新数据并将其传输给大语言模型(LLMs)以生成输出。

而此次与博通的合作重点,则是将其高性能网络技术与芯片的核心处理能力整合,确保 AI 操作所需的低延迟通信。

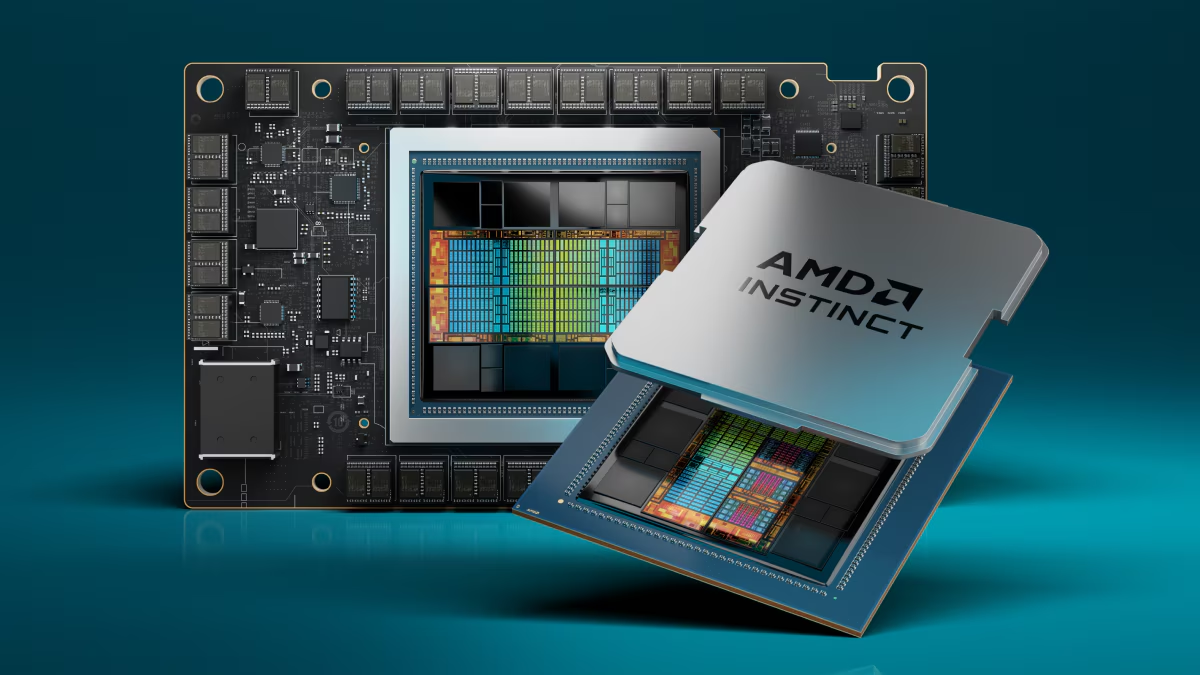

▲图源:Crypto Briefing

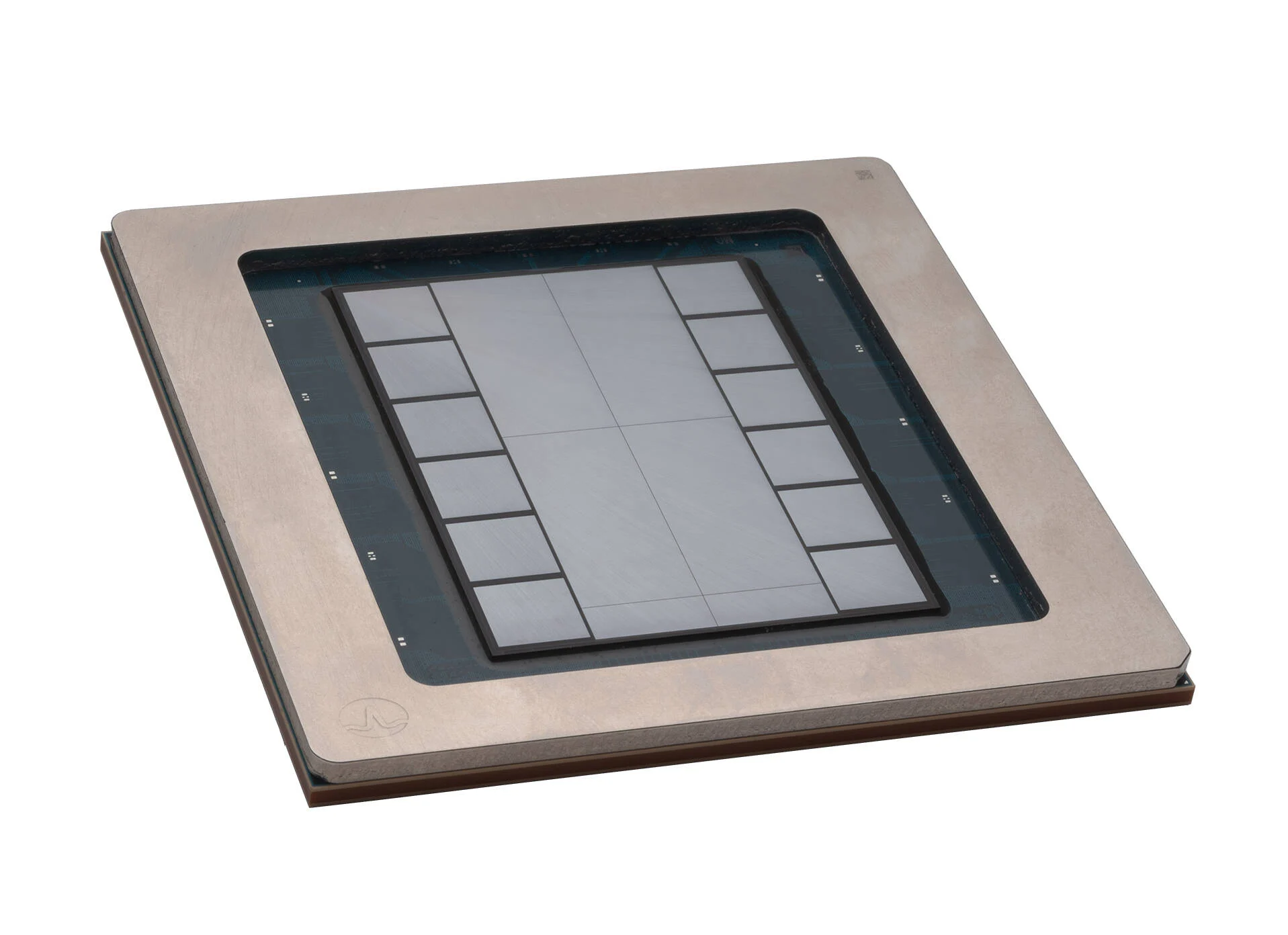

近日,博通展示了一种先进的 3.5D 系统级封装技术(3.5D XDSiP),能够让制造商超越传统光罩尺寸的限制。

具体来讲,3.5D XDSiP 将计算芯片堆叠在一个逻辑芯片上,该逻辑芯片与高带宽内存(HBM)连接,同时将其他 I/O 功能分配到一组单独的芯片上。

与传统的 3.5D 封装技术不同,博通的设计采用了「面对面」的方法,这种方法允许芯片之间通过混合铜键合(HBC)排布更密集的电气接口,从而实现更高的芯片间互连速度和更短的信号路由。

博通的 3.5D XDSiP 技术本质上是一个「蓝图」,客户可以使用它来构建自己的多芯片处理器。巧合的是,博通预计这项技术的第一批部件也将于 2026 年投入生产,这与「Baltra」的投产时间不谋而合。

▲图源:The Register

毫无疑问,这枚芯片最重要的使命,就是为苹果自家的 Apple Intelligence 服务。

苹果的原生 AI 功能自发布以来便一直引人关注。苹果原计划直接在设备上运行大部分 AI 功能,但某些功能(如 Siri和 Maps)在云端处理,并且对计算能力有很高的需求,现有的芯片又并非定制。于是,「Baltra」的提案应运而生。

Baltra 是为苹果自己的数据中心而定制设计的,其用于驱动高级 AI 任务,并确保为用户带来「无缝」的 AI 体验。这意味着苹果的 AI 战略已经超出端侧,并纳入了云计算能力。

值得一提的是,苹果刚刚发布了 iOS 18.2 正式版系统,其中新增了多项实用的 AI 功能,包括 ChatGPT 正式登陆苹果全家桶等等。未来,Baltra 将使苹果在其产品生态中部署 AI 时获得性能优势和更大的灵活性。

▲图源:Fast Company

据估计,2028 年 AI 服务器芯片市场规模预计将达到 450 亿美元,而苹果在 AI 服务器芯片市场的定位将会是对现有领导者的极大挑战。

彭博社分析指出,苹果与博通的合作进一步巩固了其在 ASIC 设计中的主导地位,这项合作预计将推动博通在 2025-2026 年之后的 AI 收入增长,并且其有望在苹果供应链中占据更多份额。

此外,自 OpenAI 在 2022 年 12 月发布 ChatGPT 以来,苹果加快了自家服务器芯片的开发工作,以保持其在人工智能领域的竞争力。苹果的目标是在 12 个月内完成「Baltra」芯片的设计。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。