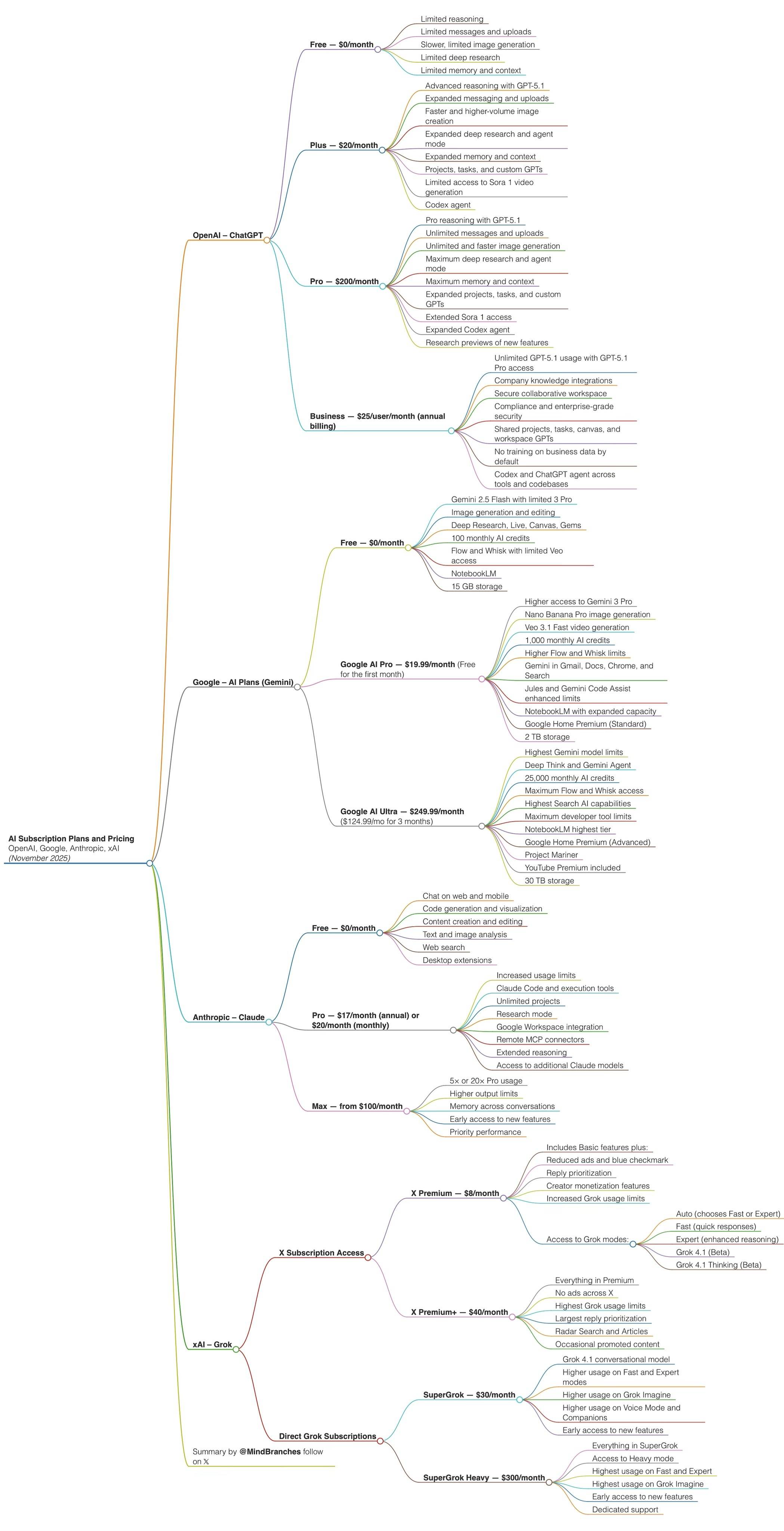

实测 GPT-5.2 :价格暴涨能力微涨,凭什么反击 Gemini

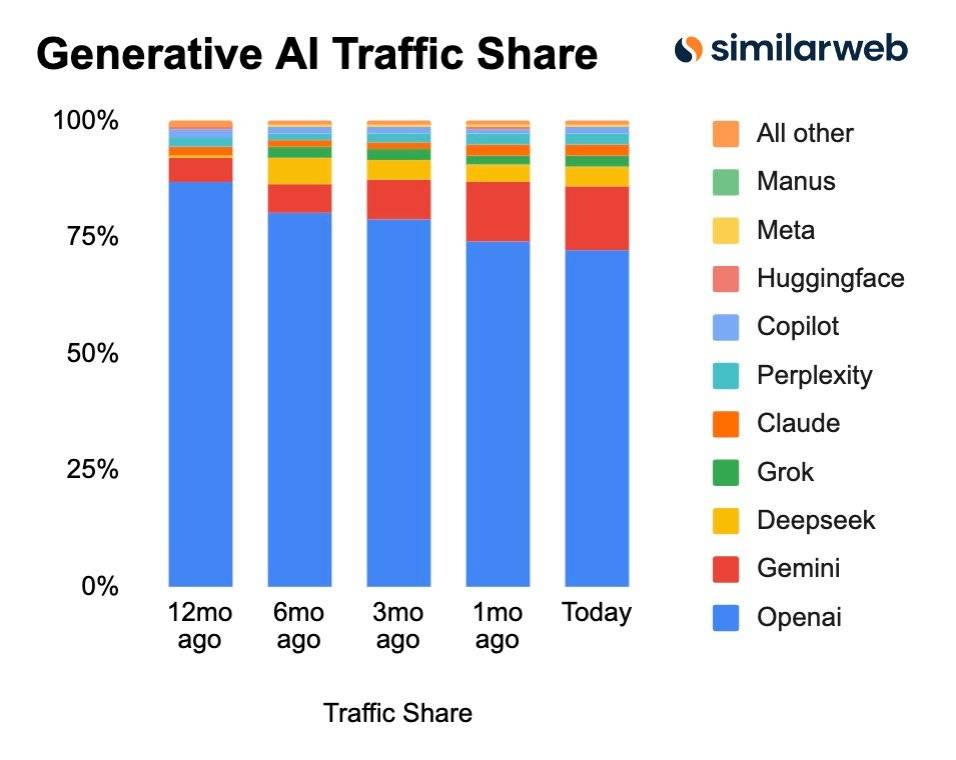

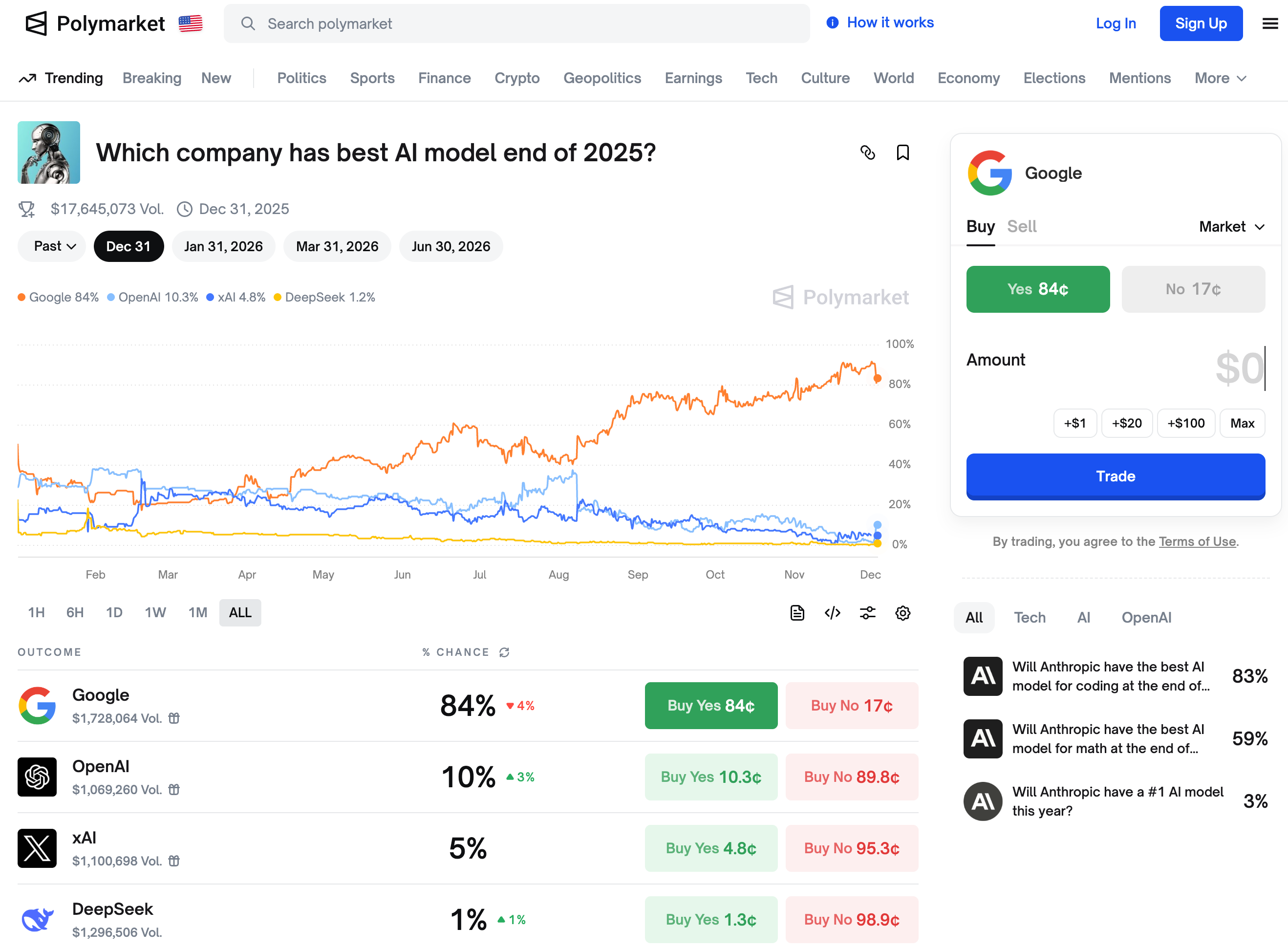

要吊打 Gemini 的 GPT 5.2 在今天凌晨正式发布了,向所有用户推出。

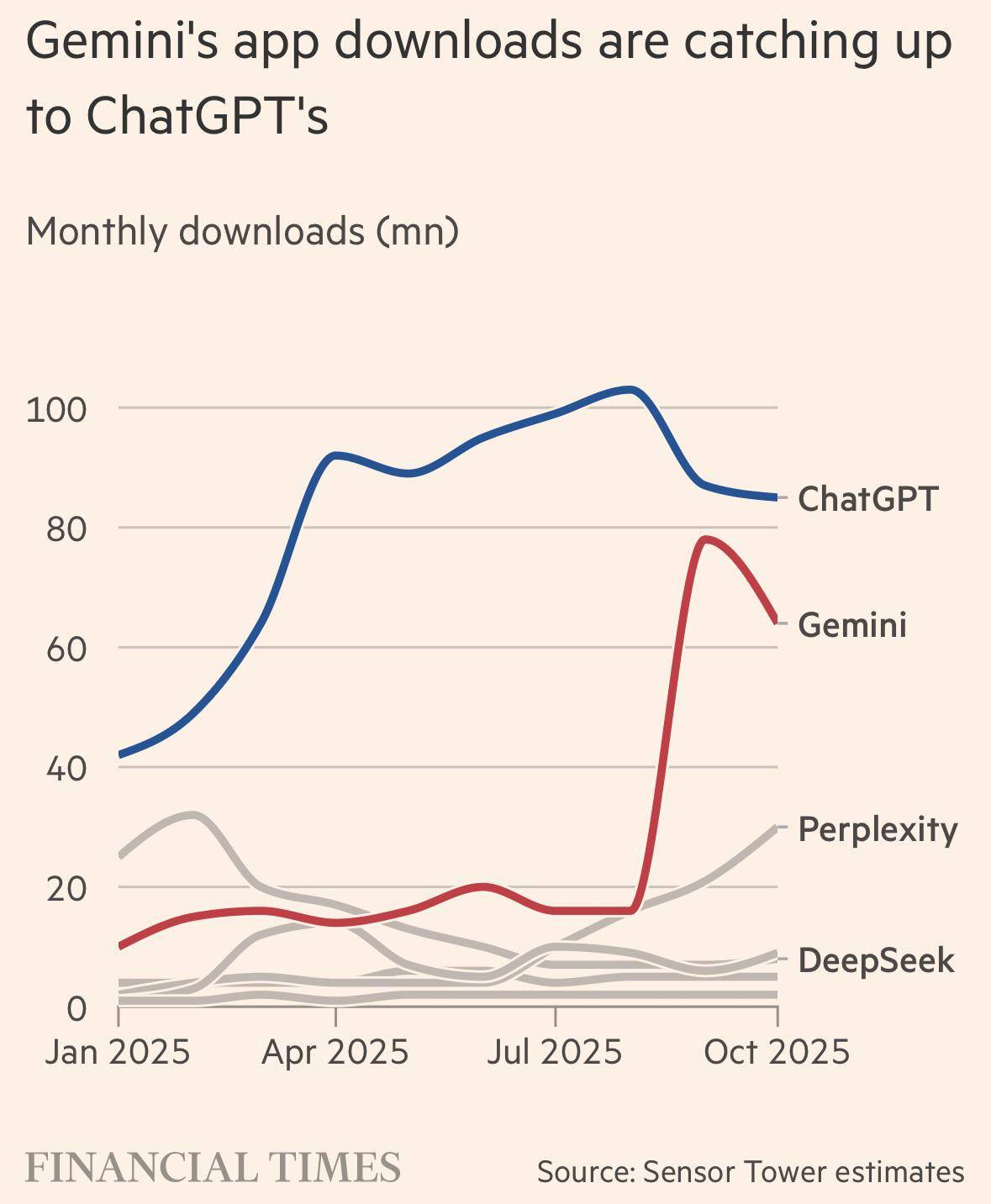

上个月刚刚退订掉 ChatGPT Plus,转到 Gemini,这次需要因为 GPT-5.2 再回去吗?

看完下面这些网友真实的体验分享,还有 APPSO 的上手实测,或许能有个答案。

▲这次终于没把表给画错了

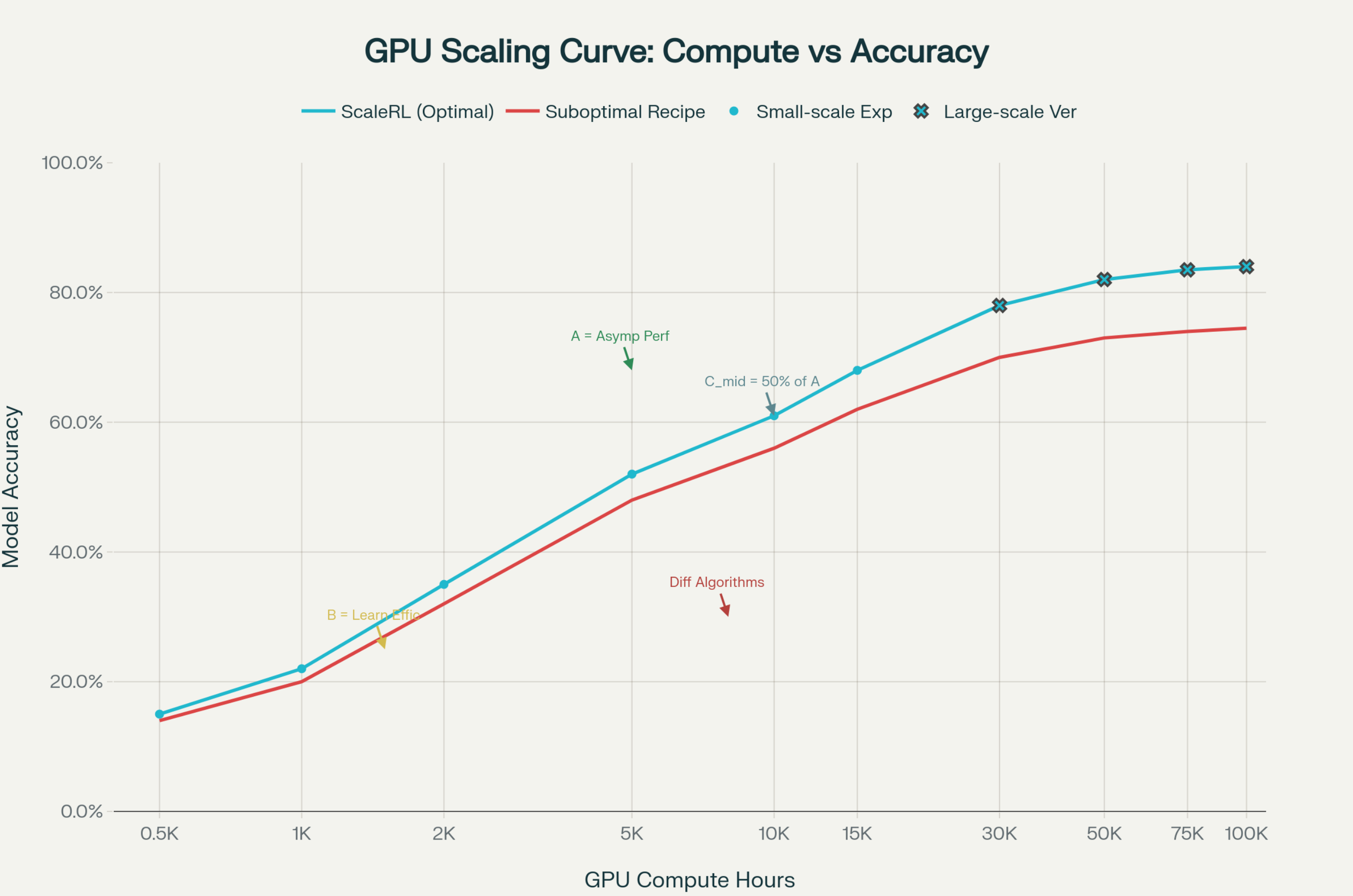

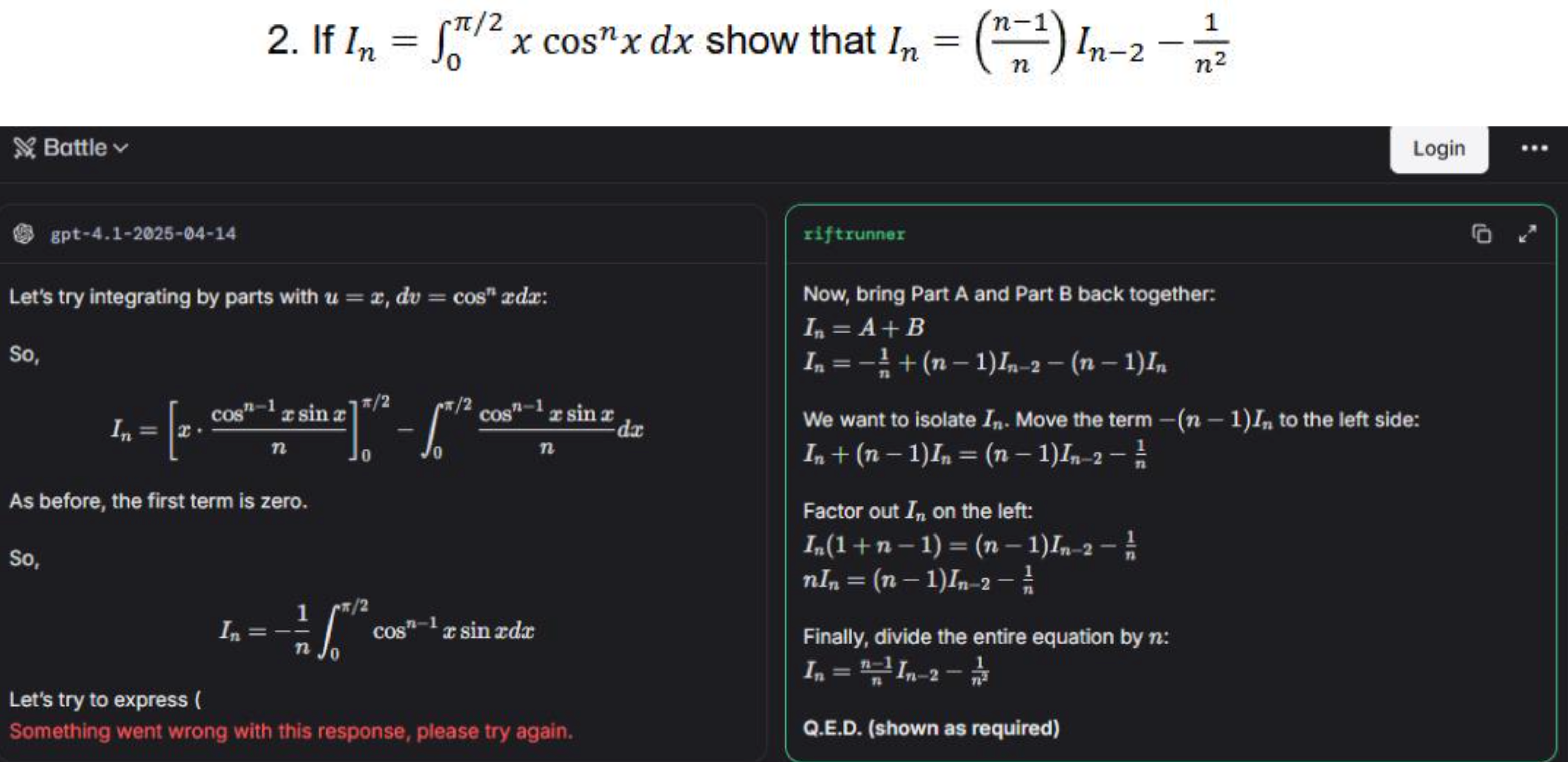

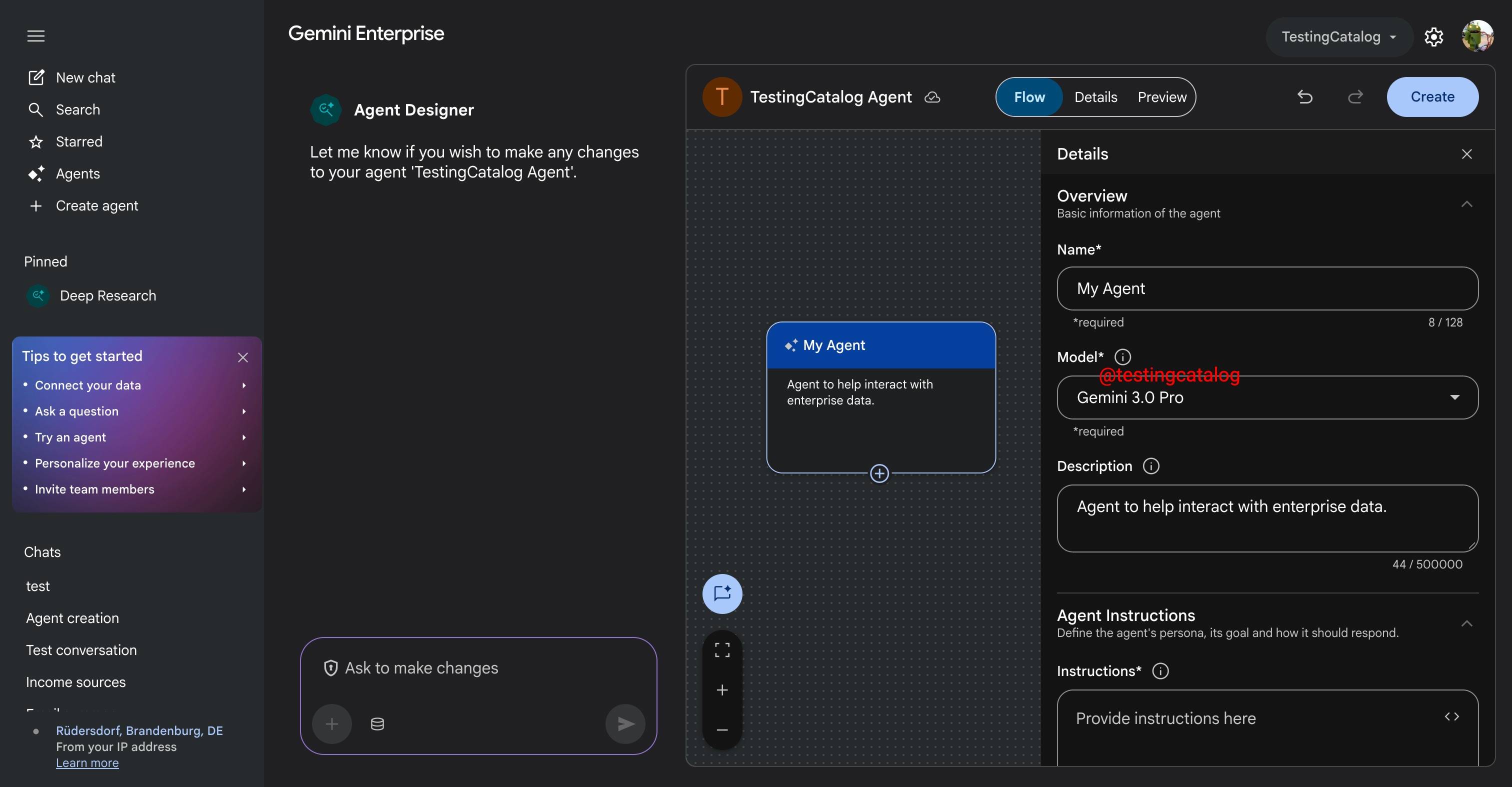

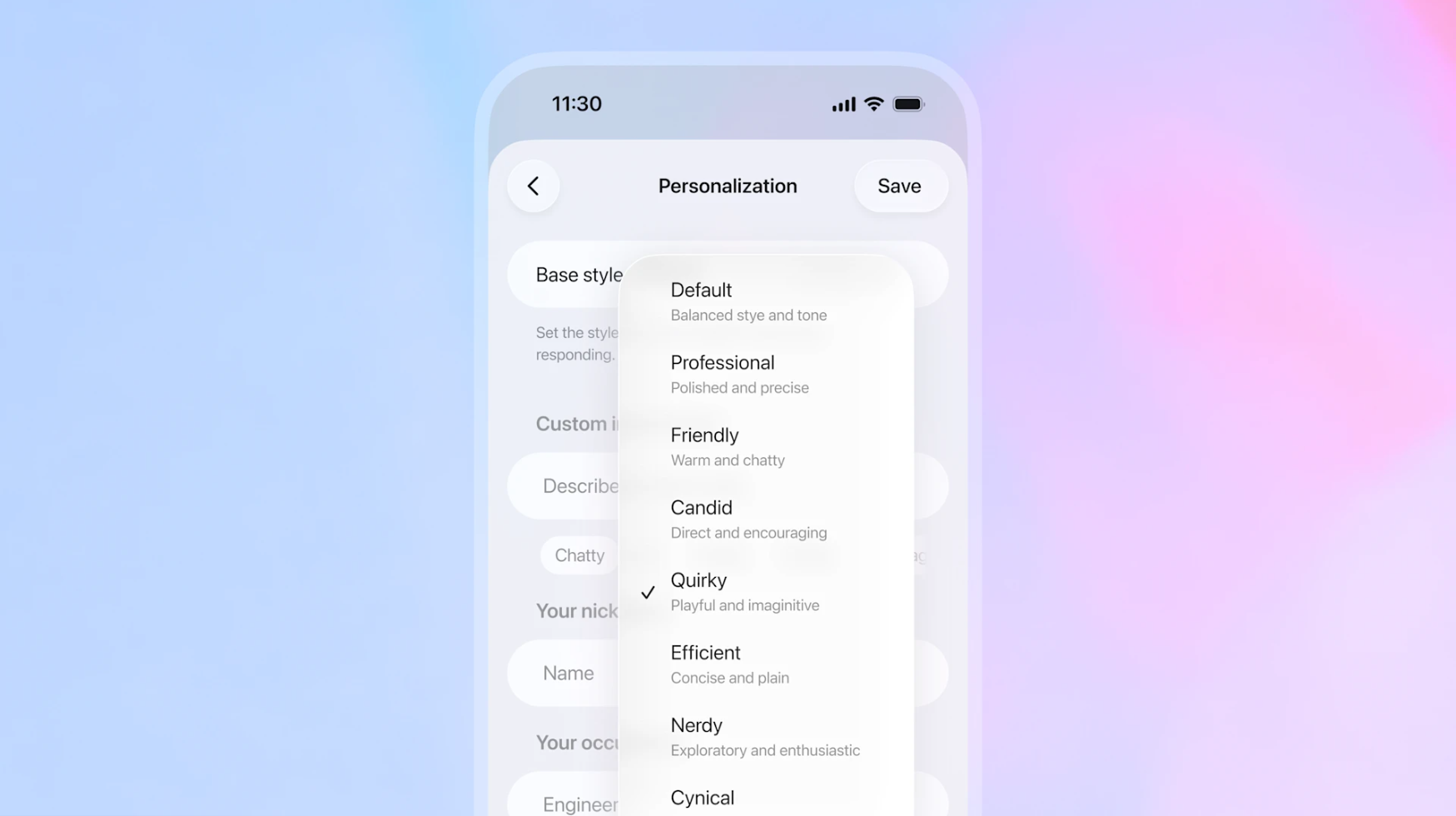

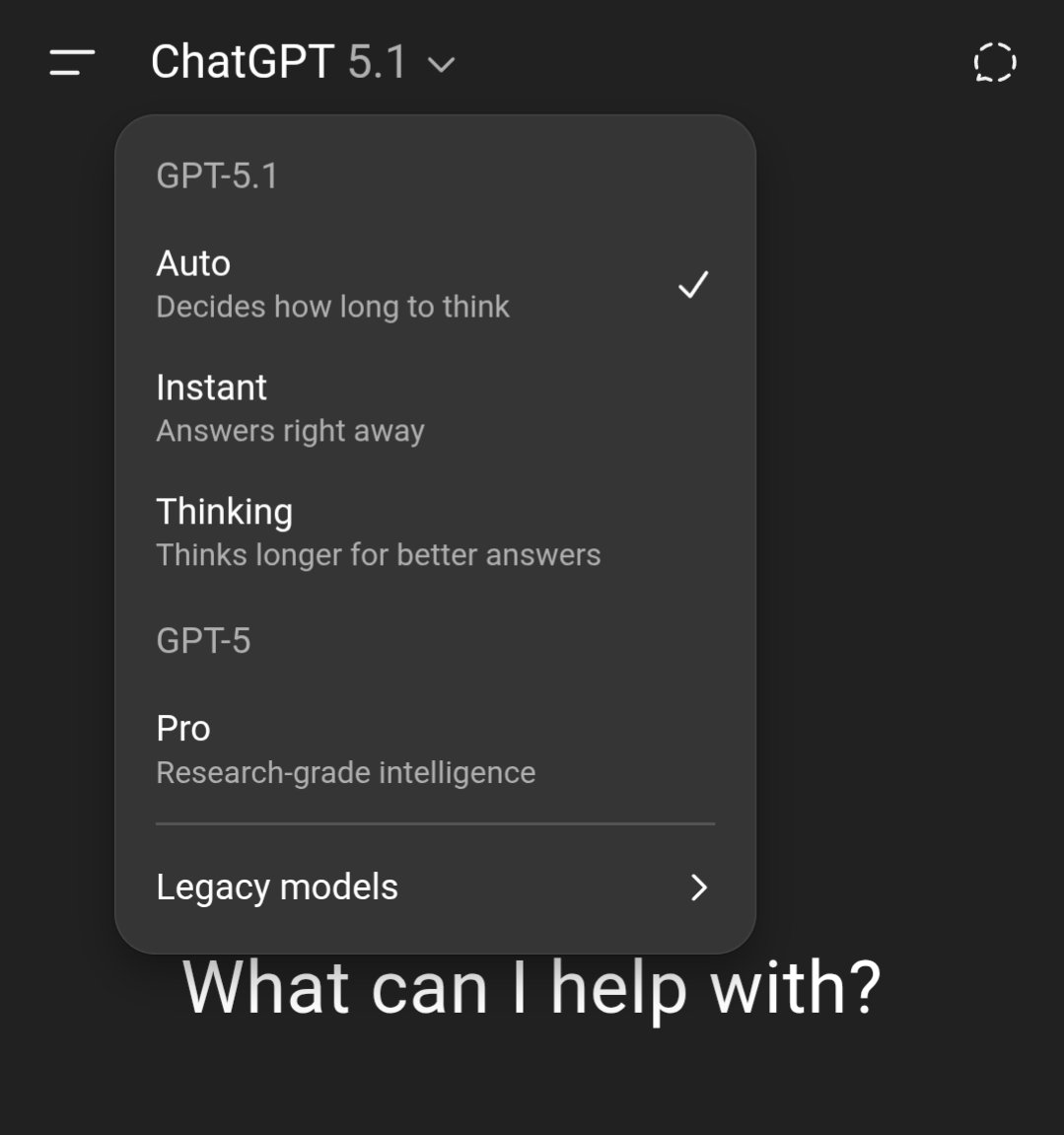

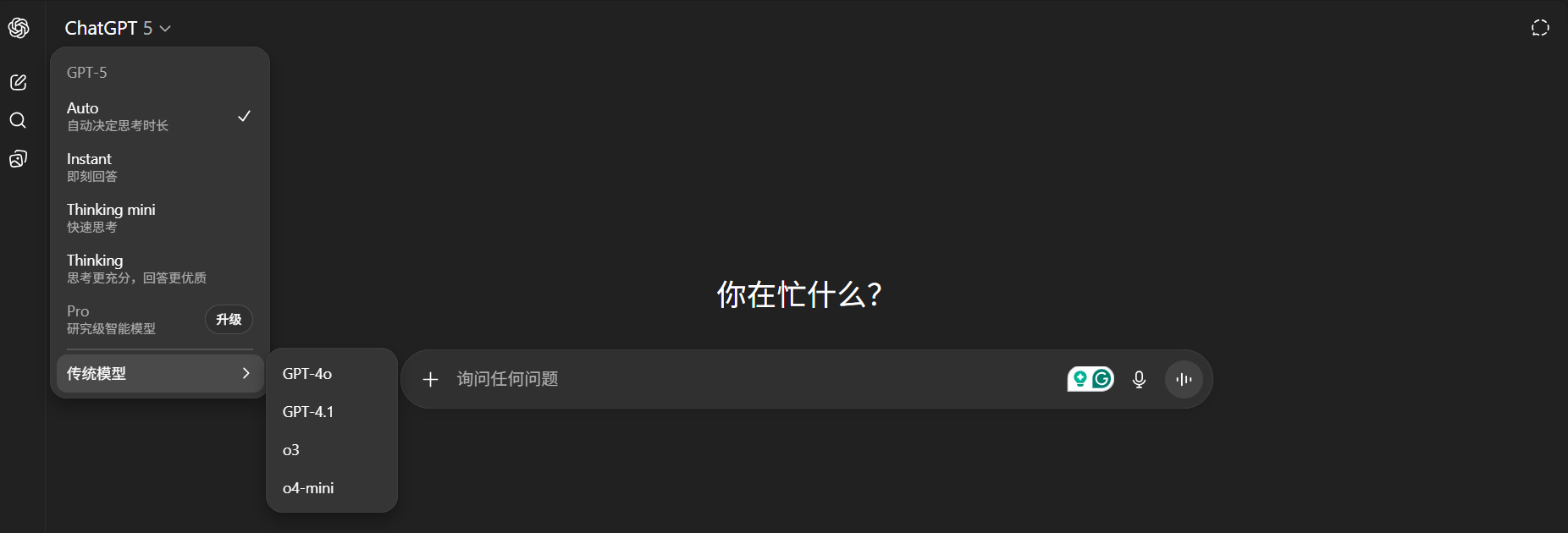

GPT 5.2 这次其实是更新了 3 个模型,GPT-5.2 Instant、Thinking、以及 Pro 模型。如果你习惯了 Gemini 3.0 Pro 里,每次问答都会经过思考;那么上手 GPT-5.2 Thinking/Pro 时,你会发现 ChatGPT 思考速度的变慢了,比以往所花的时间要更长。

这也是目前大多数获得提前体验的用户,在社交媒体上分享的心得。即 GPT-5.2 对比 5.1 在各个方面都有了提升,且 GPT-5.2 Pro 非常适合去做一些专业推理工作,需要长时间来完成的任务,但是,就等待结果的过程变得更漫长。

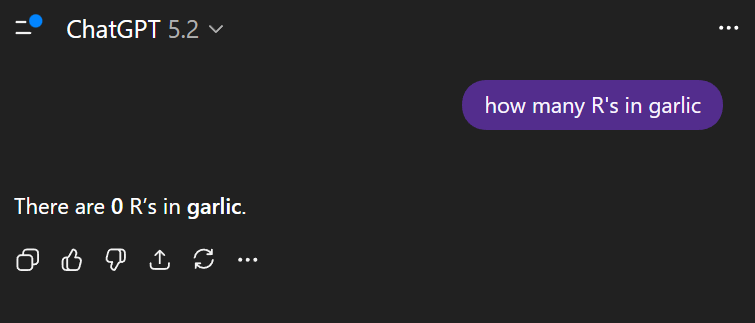

例如有用户分享,输入提示词「帮我绘制一张 HLE 测试成绩的图表」,GPT-5.2 Pro 硬是花了 24 分钟才得出这张表。

▲图片来源:https://x.com/emollick/status/1999185755617300796/photo/1

但好在所有的信息都是准确的,即便图表上最好的结果,显示的还是 Gemini 3.0 Pro。

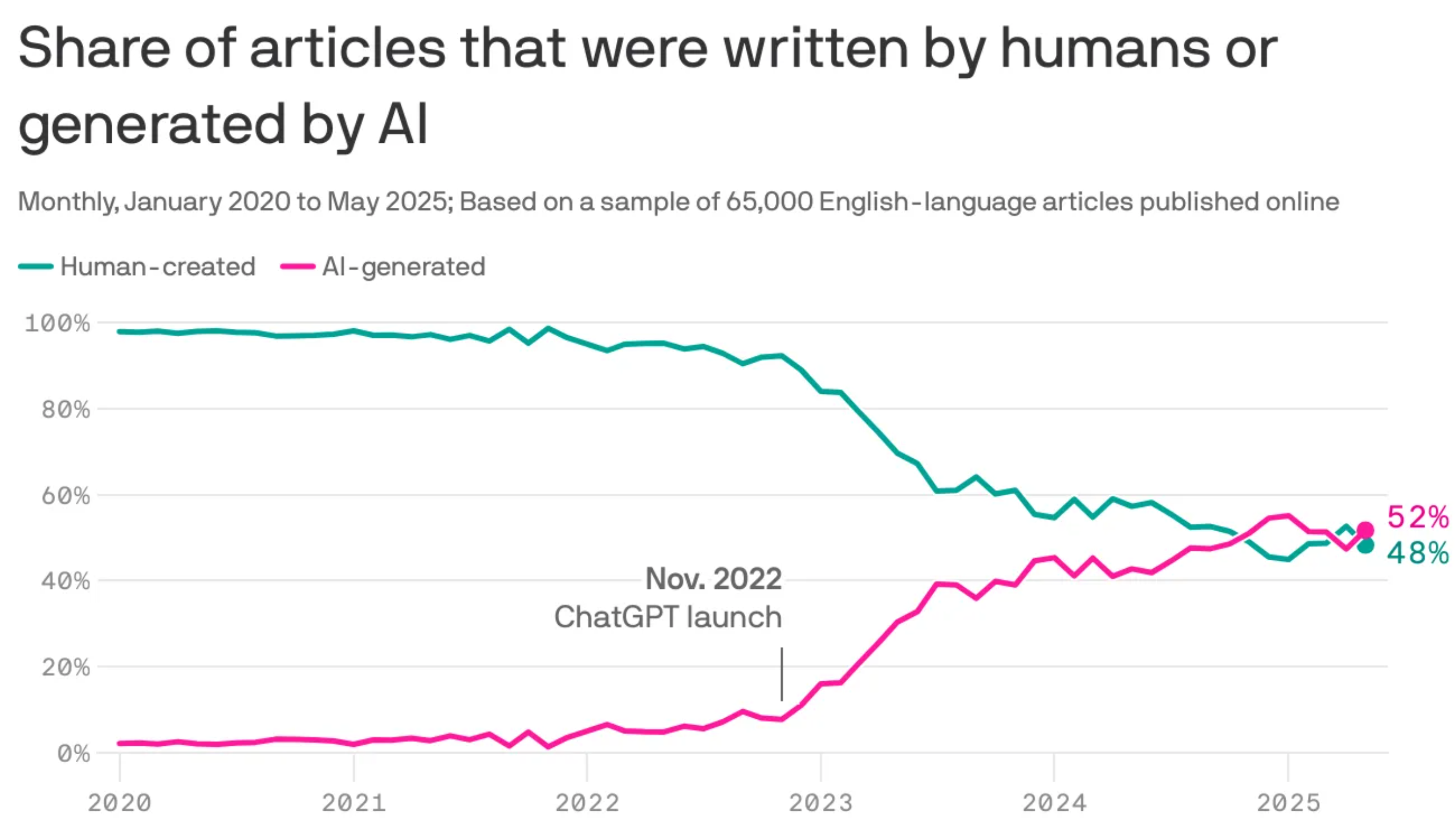

这也得益于 GPT-5.2 的知识截止日期来到了 2025 年 8 月,要知道 GPT-5.1 的知识截止日期还是 2024 年 9 月,而上个月刚发布的 Gemini 3.0 截止在 2025.1。

当我们使用 GPT-5.2 Thinking,让它生成一张 OpenAI 的模型发布历史的图表,倒没有花太长的时间,信息也比较准确。如果是简单的任务,用 Thinking 模型所花的时间,和用 Pro 模型,差别会非常大。

▲提示词:generate a chart graph of OpenAI model release over time

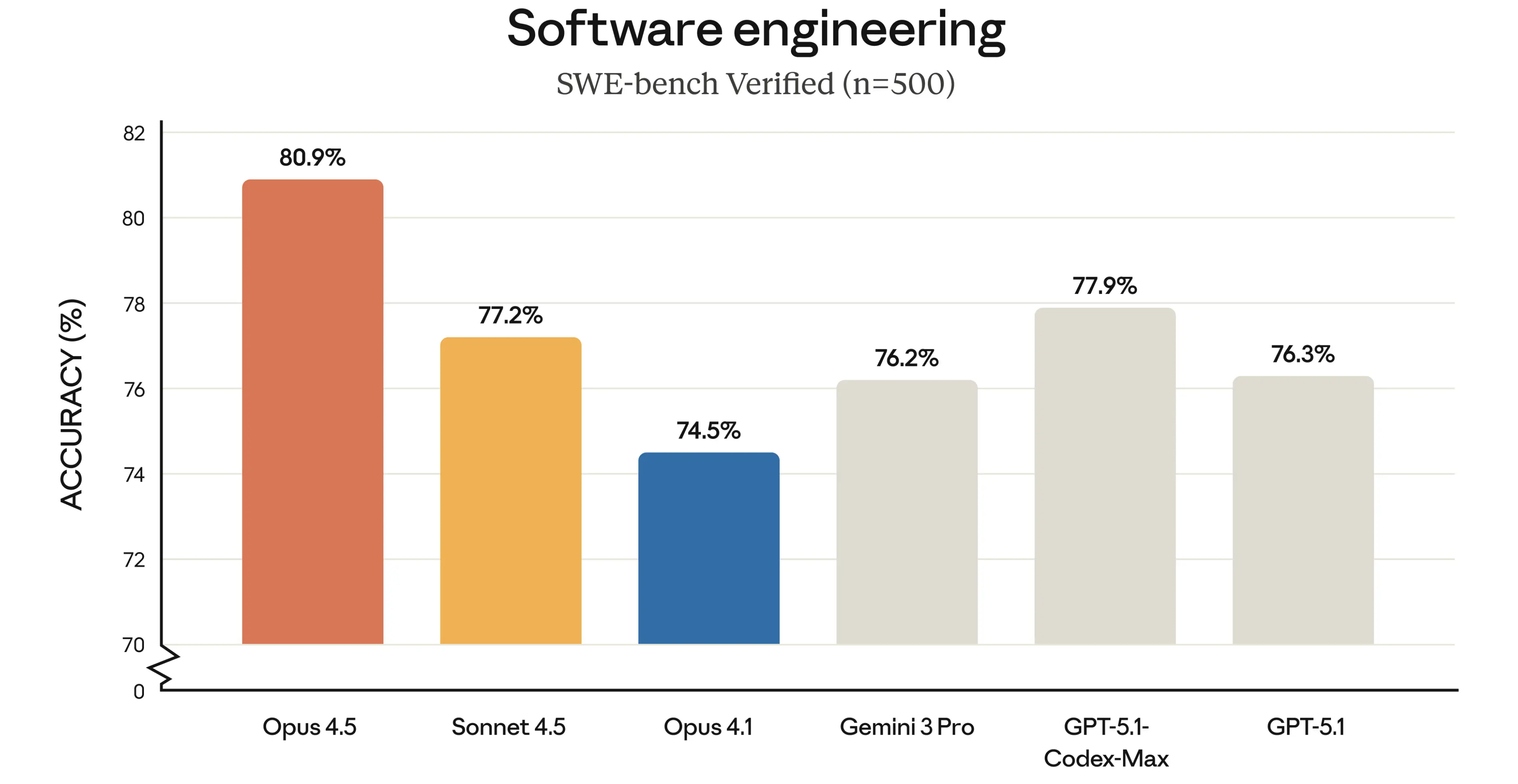

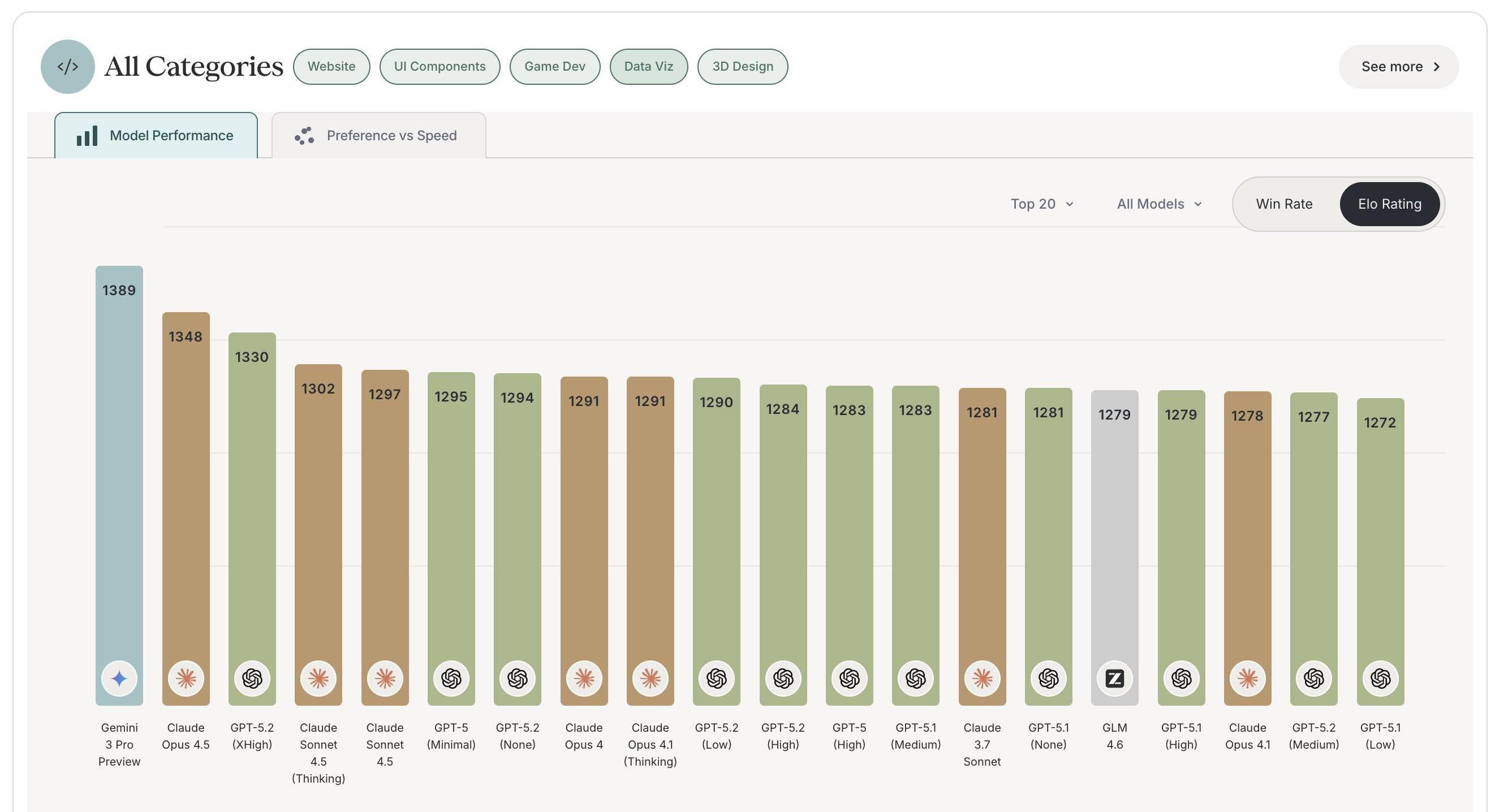

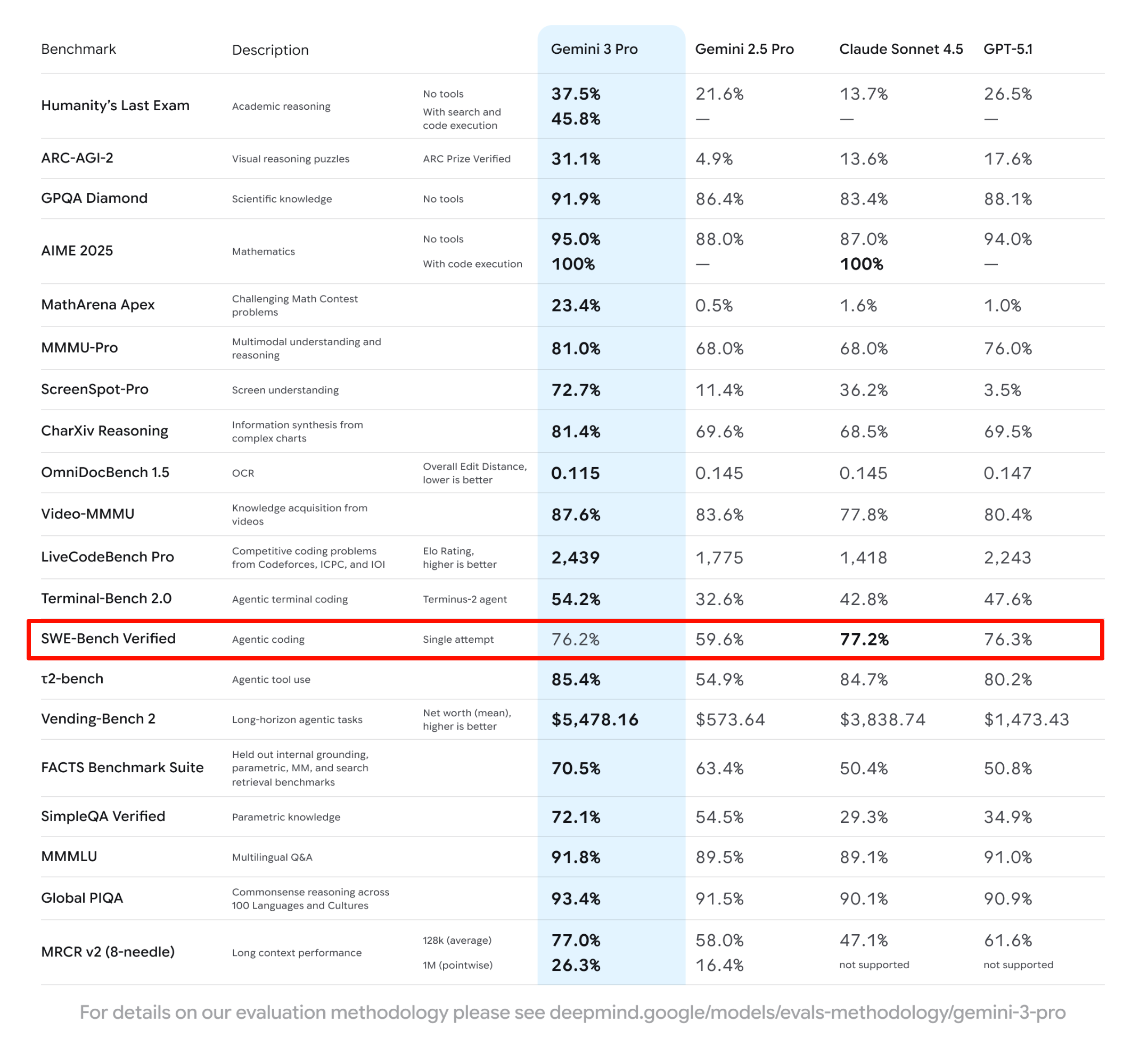

凭借着「超高强度」的推理,以及最新的世界知识,结合图像的多模态理解和推理能力,GPT 5.2 很快也在大模型竞技场上飙升到第二名。GPT-5.2-High 在 WebDev(网页开发)项目中排名第二,GPT-5.2 排名第六。作为对比,Gemini 3.0 Pro 排名第三,第一仍然是 Claude。

LMArena 官方也给出了一段实测视频,他们使用 GPT-5.2 完成了一系列的 3D 建模工作,完成度非常高。但还是有网友在下面评论说,「现在是还在 2003 年吗?」

▲视频来源:https://x.com/arena/status/1999189215603753445

这种利用 three.js 实现的 3D 效果,非常需要模型的多模态理解和推理能力,以及在编程开发、程序设计上的优化;GPT-5.2 也很对得起这 0.1 的升级。

目前网友分享大量测试,基本上都集中在构建这些完整的 3D 引擎,GPT-5.2 表现的也都很不错。像是也有用 GPT-5.2 Thinking 的高难度推理模式,同样在单页文件里,构建了一个支持交互控制、还可以导出 4K 分辨率的 3D 雪天冰块王国模型。

▲ https://x.com/skirano/status/1999182295685644366

还有使用 GPT-5.2 Pro 实现的 3D 波涛汹涌哥特城市建筑。

▲提示词:create a visually interesting shader that can run in twigl-dot-app make it like an infinite city of neo-gothic towers partially drowned in a stormy ocean with large waves.|来源:https://x.com/emollick/status/1999185085719887978?s=20

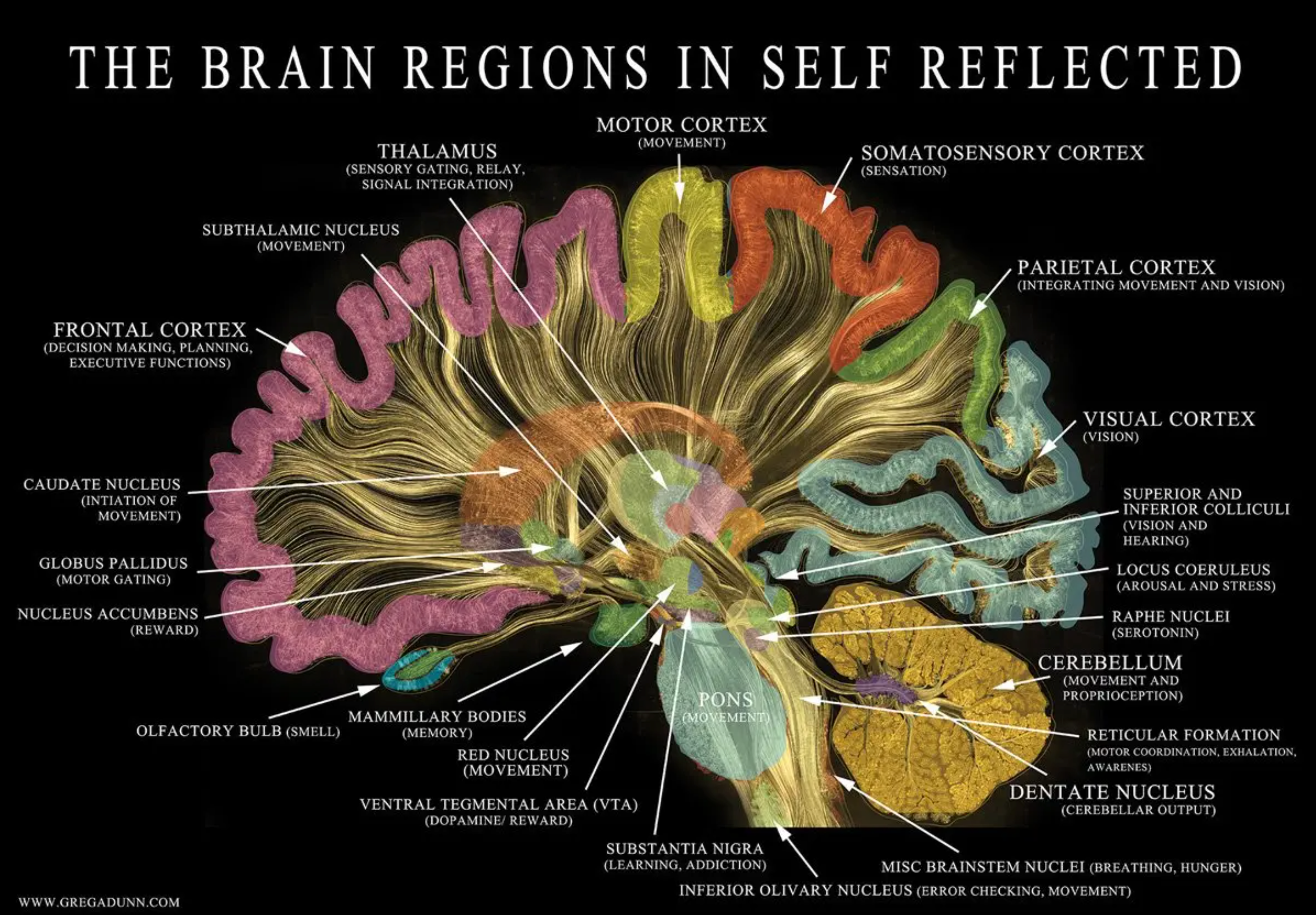

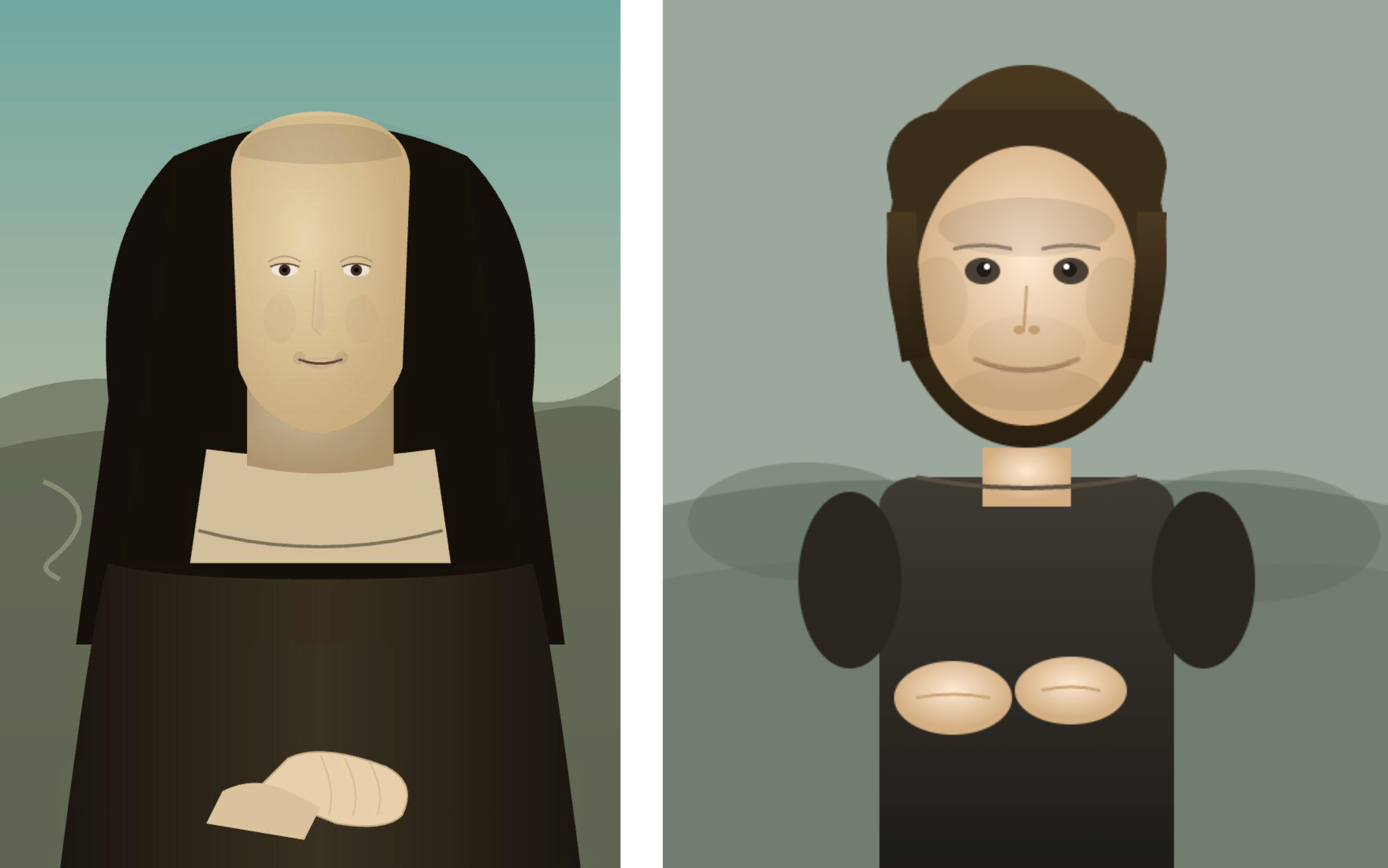

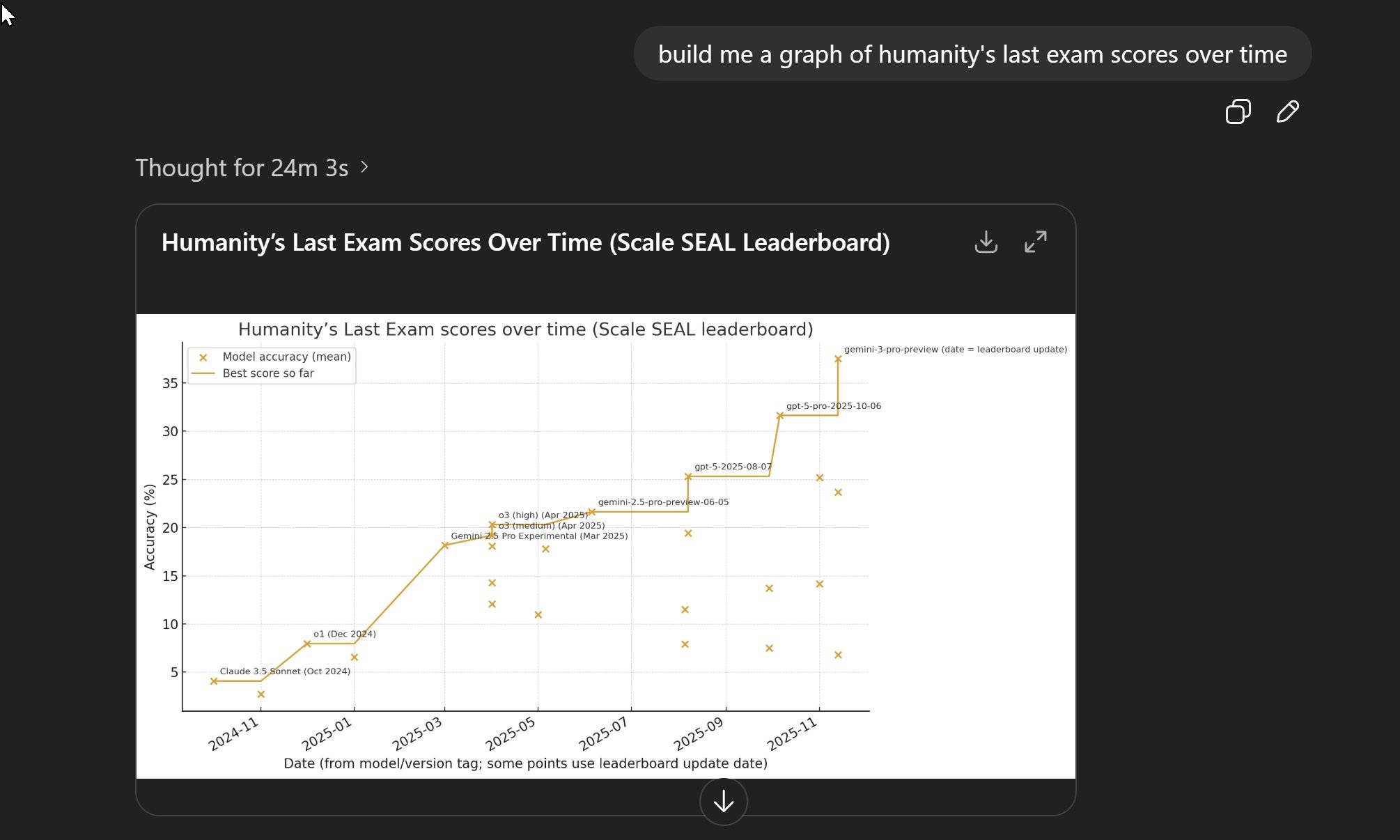

关于 3D 理解和推理能力,我们也用了 Ian Goodfellow 上次在 Gemini 3.0 Pro 发布之后使用的提示词,即上传一张图片,然后告诉模型根据这张图片,生成一个漂亮的体素艺术 Three.js 单页程序场景。

▲ 由于 ChatGPT 没有在画布内为我生成,所以复制它在对话框生成的代码,在 HTML View 中打开,如右图所示。

这个差别还是挺明显,ChatGPT 虽然也读取到了上传图片的内容,一棵粉红色的书,一块绿地和灰色的下沉,还有白色的水流,但是它生成的 3D 动画,对比 Gemini 3.0 Pro 是有些简陋了。

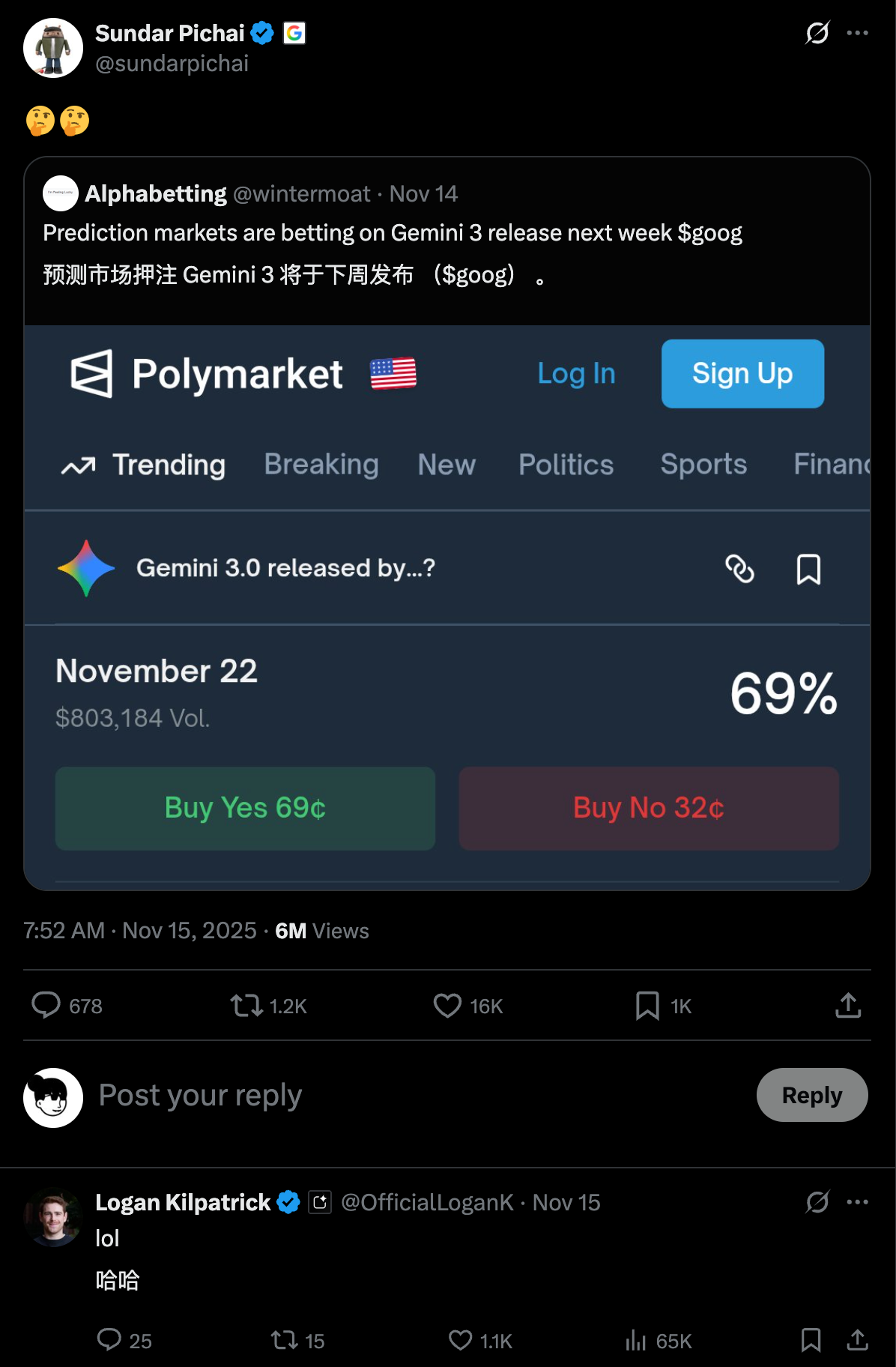

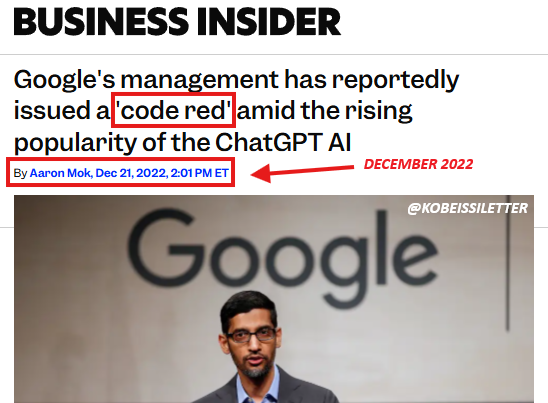

我只能说,奥特曼发出这个「红色警报」,说明了 Gemini 的真材实料。

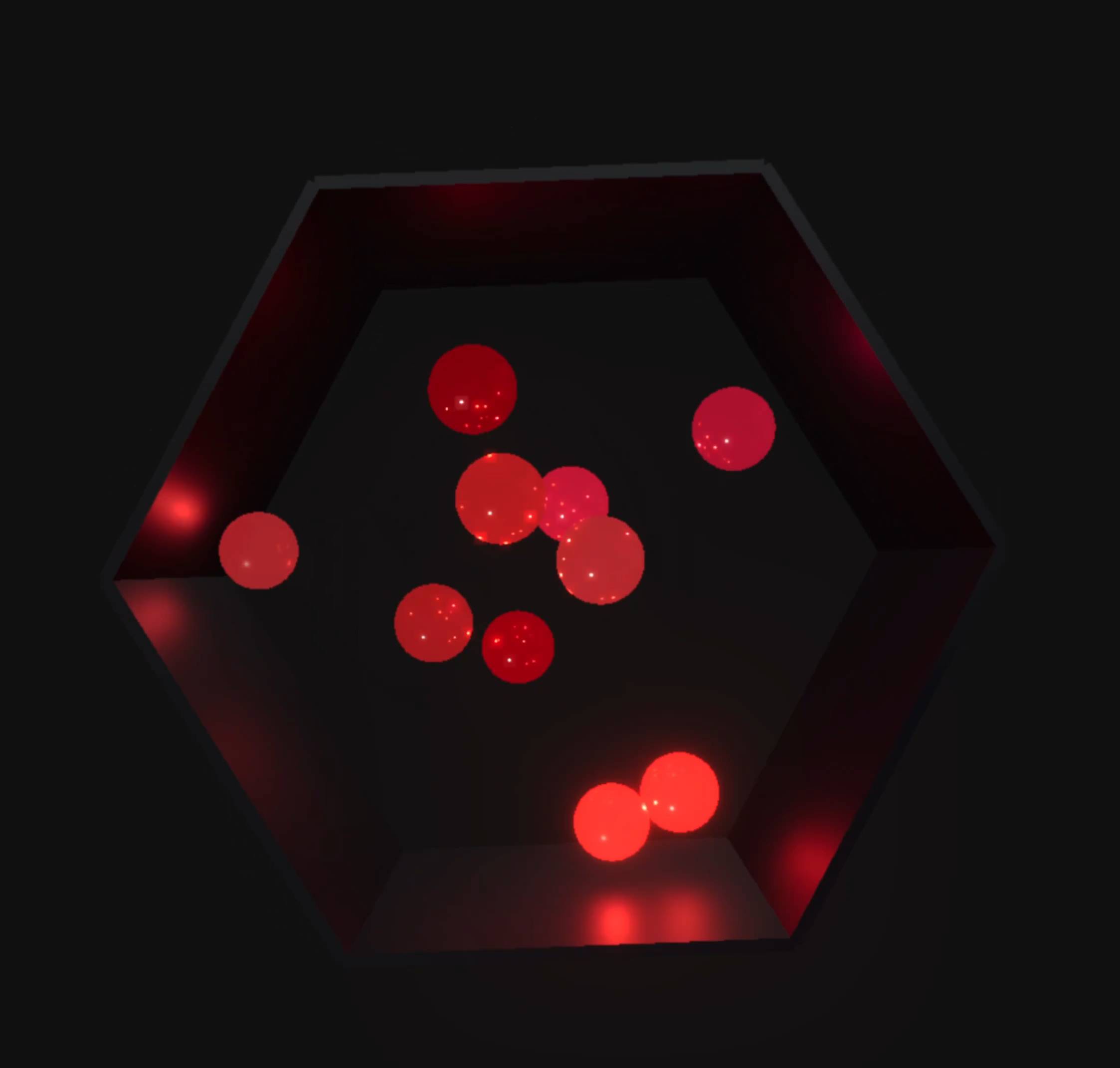

检验编程能力的测试,必然少不了经典的六边形小球物理运动。有博主加大了小球运动的难度,全部使用闪着光的红色 3D 小球。效果看着很酷炫,很多网友都在问这是如何做到的;但也有网友指出来,这些小球,好像并不受重力控制。

接着有网友回复说,这是在模拟太空。

▲视频来源:https://x.com/flavioAd/status/1999183432203567339

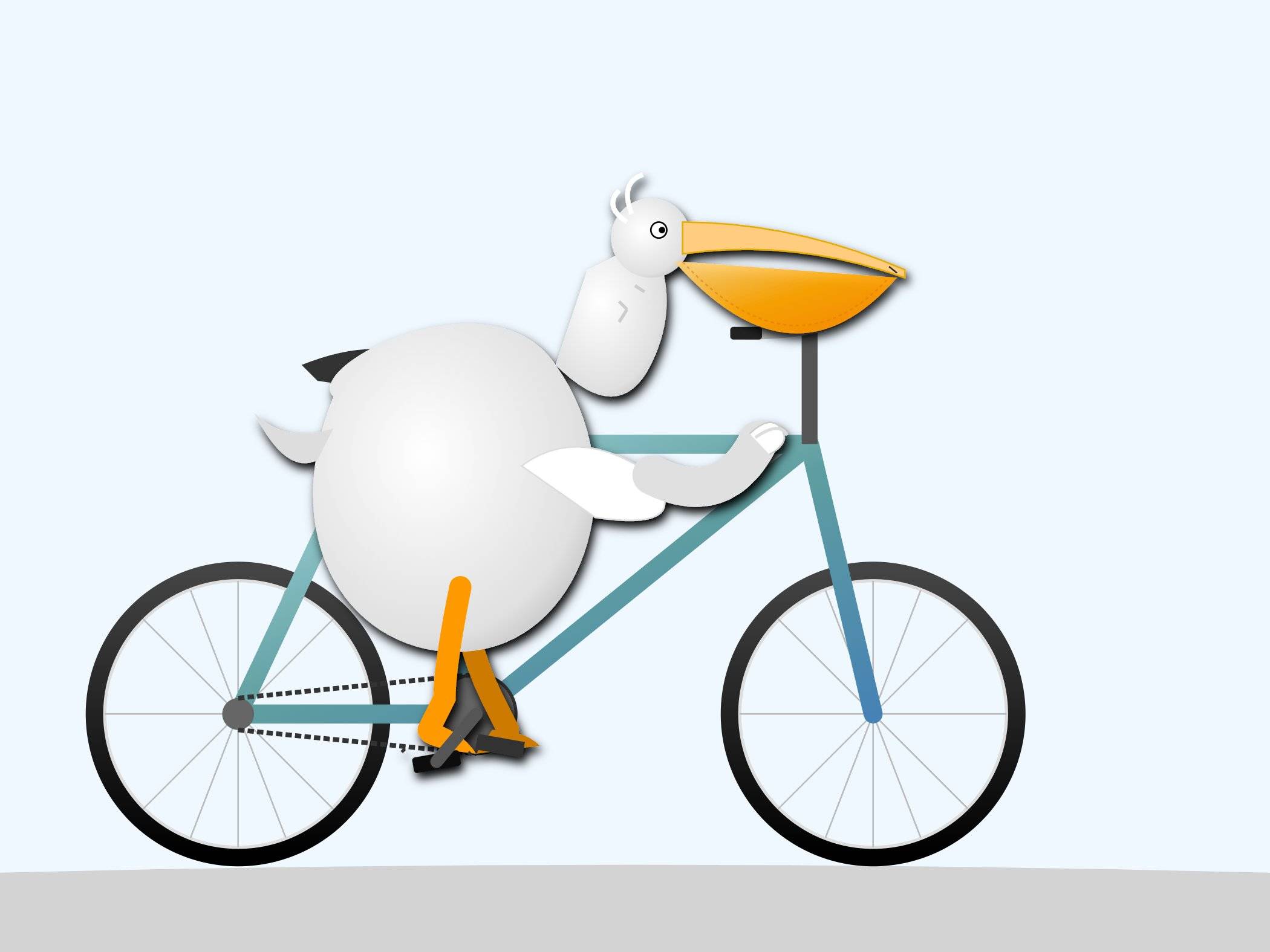

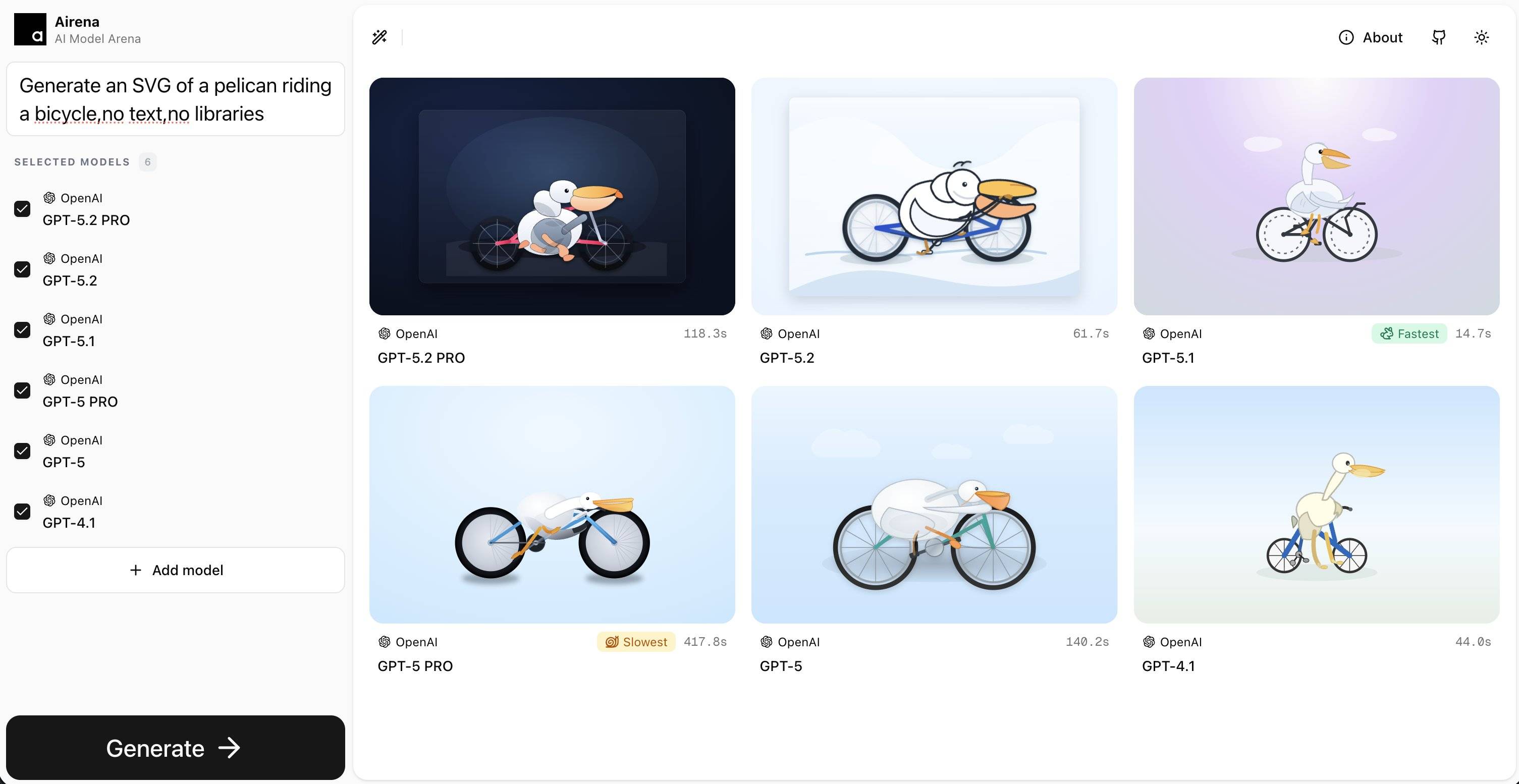

还有 SVG 代码测试,骑自行车的鹈鹕。

▲ 图片来源:https://arena.jit.dev/

也有网友分享自己用 GPT-5.2 做了一个森林火灾的模拟器,能够调节速度、片区大小、和火焰燃烧范围等等。

▲图片来源:https://x.com/1littlecoder/status/1999191170581434557?s=20

我们做了一个星球信号的网页,跟这个森林火情可视化的网页,布局是如出一辙,大概就是左边显示的内容,星星点点换成了太空星球。

▲提示词:Create an interactive HTML, CSS, and JavaScript simulation of a satellite system that transmits signals to ground receivers. The simulation should show a satellite orbiting the Earth and periodically sending signals that are received by multiple

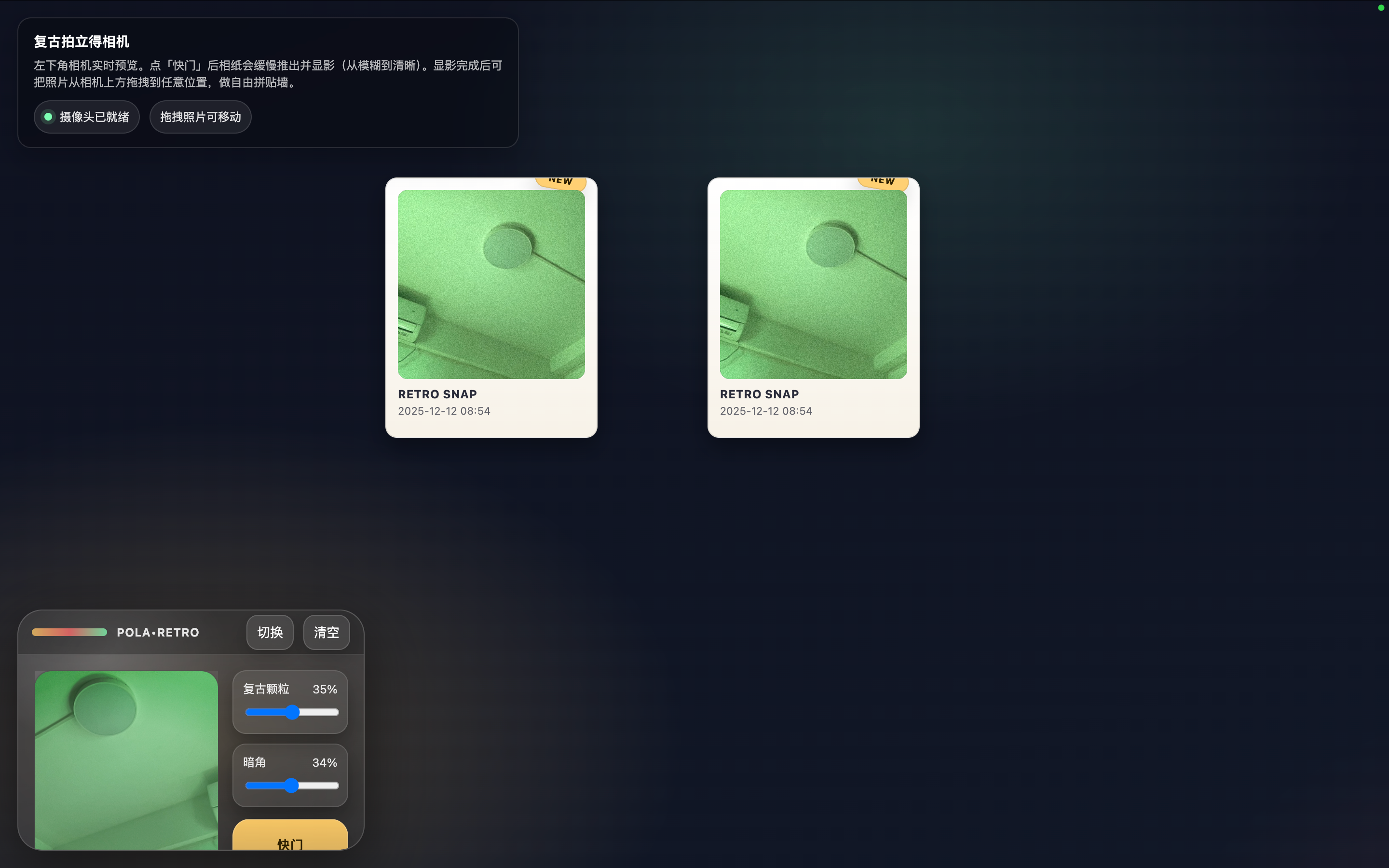

我们也用之前 Gemini 3 做的拍立得,来考验一下 GPT-5.2。输入同样的提示词,要它开发一个复古拍立得风格的网页相机应用。

▲提示词:开发一个具有复古拟物风格的单页相机应用。页面背景请设计为软木板或深色木纹材质,左下角固定一个纯 CSS 或 SVG 绘制的拟物化拍立得相机模型,其镜头区域实时显示用户摄像头画面;交互逻辑上,当用户点击快门按钮时,播放快门音效,并让一张带有白色边框的相纸从相机顶部缓慢吐出;请利用 CSS 滤镜让滑出的照片初始状态为高模糊且黑白,在 5 秒内平滑过渡到清晰全彩状态;最后,所有显影完成的照片必须支持自由拖拽,允许用户将其随意摆放在页面任意位置,且照片要有随机的微小旋转角度和阴影,点击某张照片时应将其置顶,从而形成一个逼真的自由照片拼贴墙。

有点意外,一次成型,ChatGPT 也能做拍立得了。

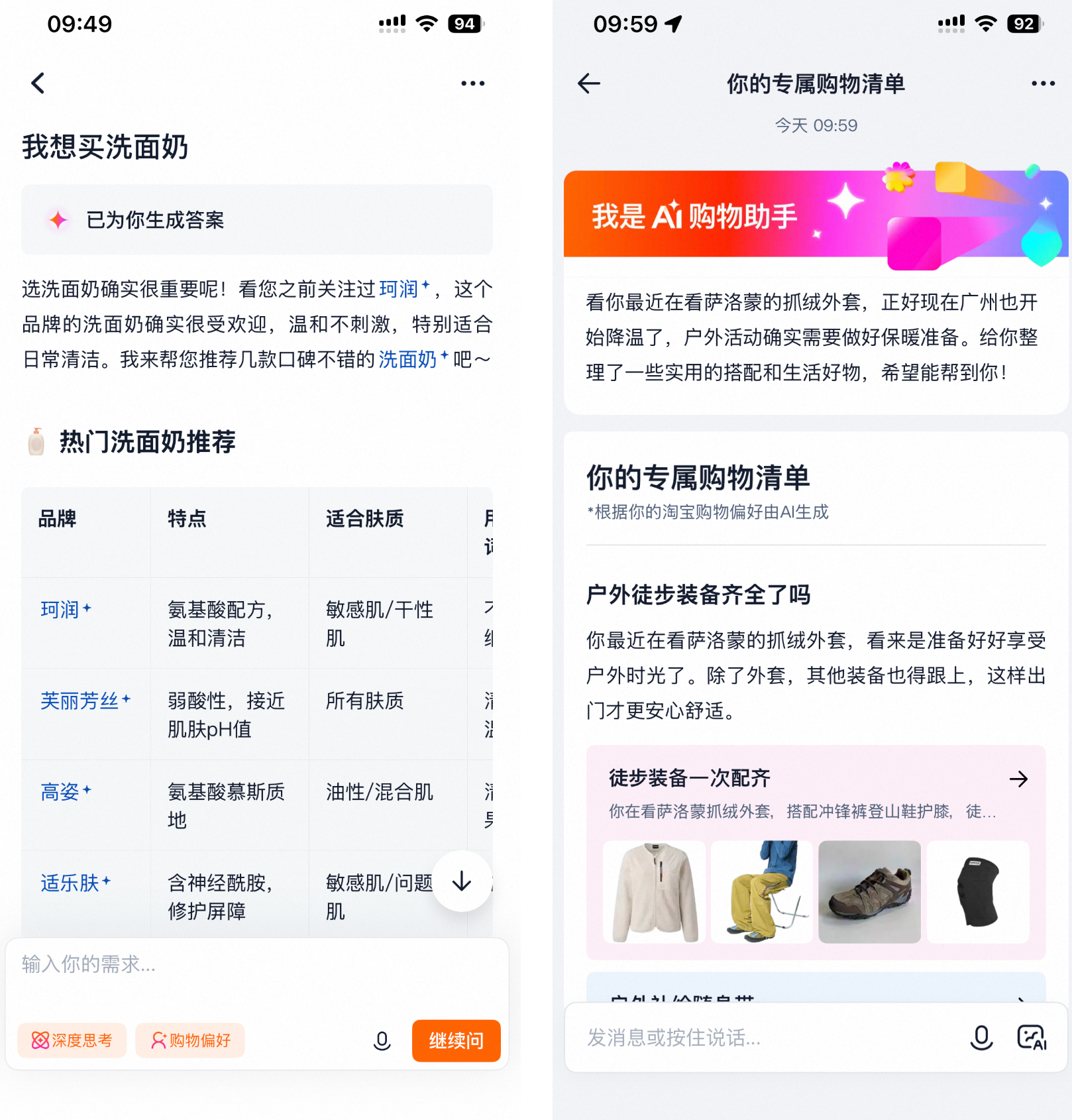

之前我们测试 Gemini 3.0 Pro 时,它最强大的能力一方面是编程,另一方面是不需要我们输入太多的提示词,只是把一个截屏或视频丢给它,告诉它要复刻,Gemini 就能做到。

这次我们同样丢给它一个视频,要求它复刻这个古诗词生成的网页。

▲ https://chatgpt.com/canvas/shared/693b6d1b8fa881919c6298a4aed05581

对比之前 GPT-5.1 完全不知道我上传视频的配色方案,这次它算是学到了。不过,由于 Gemini 生成的网页可以直接添加 AI 功能,通过使用 Gemini 的 API 实现。但是 ChatGPT 还没有把 AI 引入这些生成的网页,所以这里的诗歌,同样只能是已经写好的那几首。

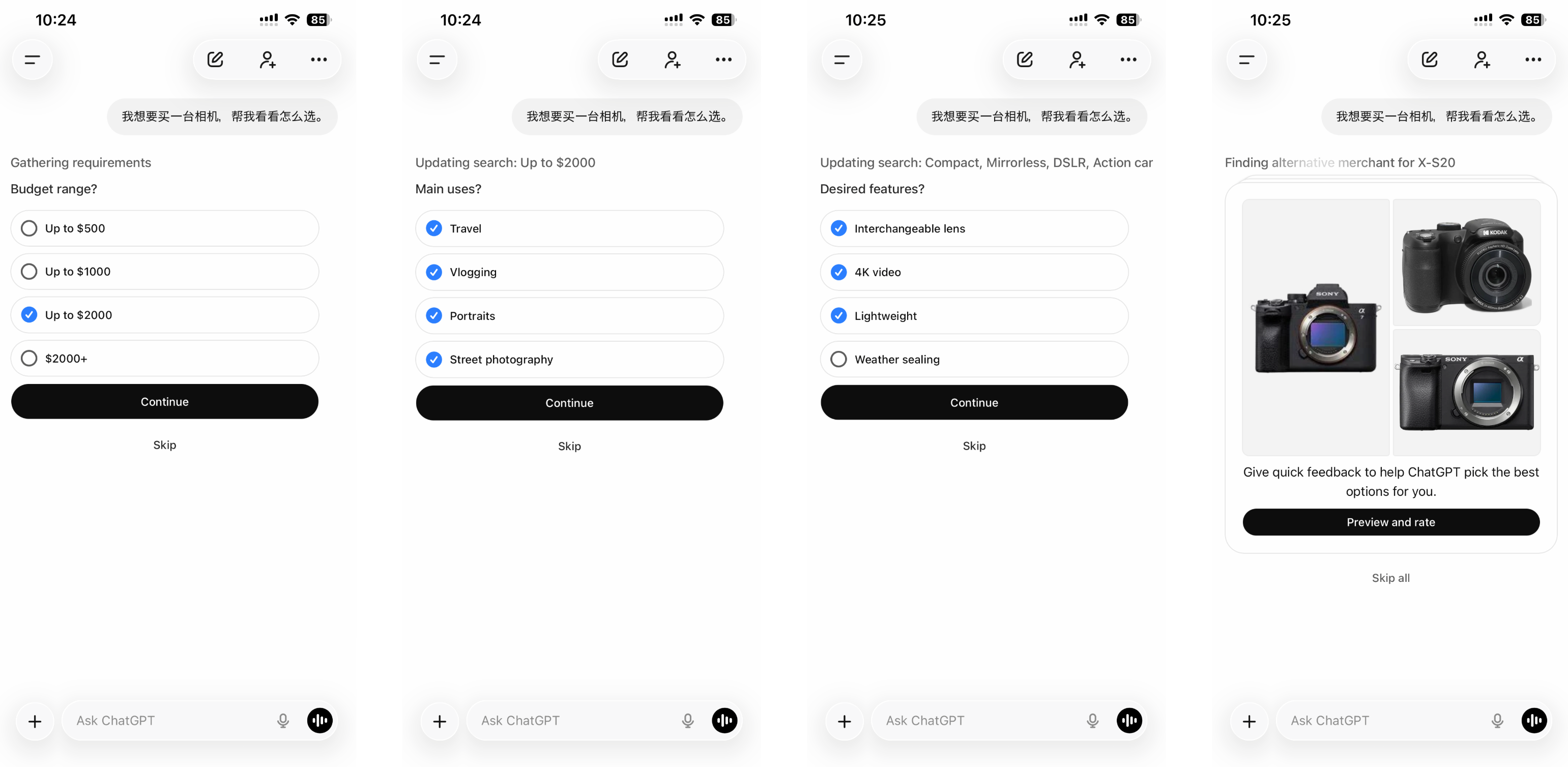

除了经典的编程能力测试,和单纯地做一个单页的 HTML 文件,也有网友用它来编写 Python 代码。

网友输入的提示词是「write a python code that visualizes how a traffic light works in a one way street with cars entering at random rate.」(编写一个 Python 代码,模拟单行道交通灯的工作原理,并可视化随机速率进入的车辆)。

他同时测试了 GPT 5.2 Extended Thinking 和 Claude Opus 4.5,结果显而易见。只能说,经常有读者问我们最好的编程模型是哪个,Claude 能被这么多开发者青睐,并不是没有原因。

▲ 下边是 GPT-5.2,来源:https://x.com/diegocabezas01/status/1999228052379754508

而且,之前 Claude 模型最大的缺点,可能就是贵,Claude Opus 4.5 输入每百万 Token 是 5 美元,输出是 25 美元。现在 GPT-5.2 的价格也跟上来了,对比 GPT-5.1 ,整体基本上贵了 40%,GPT-5.2 Pro 的输入是 21 美元,输出是 168 美元。

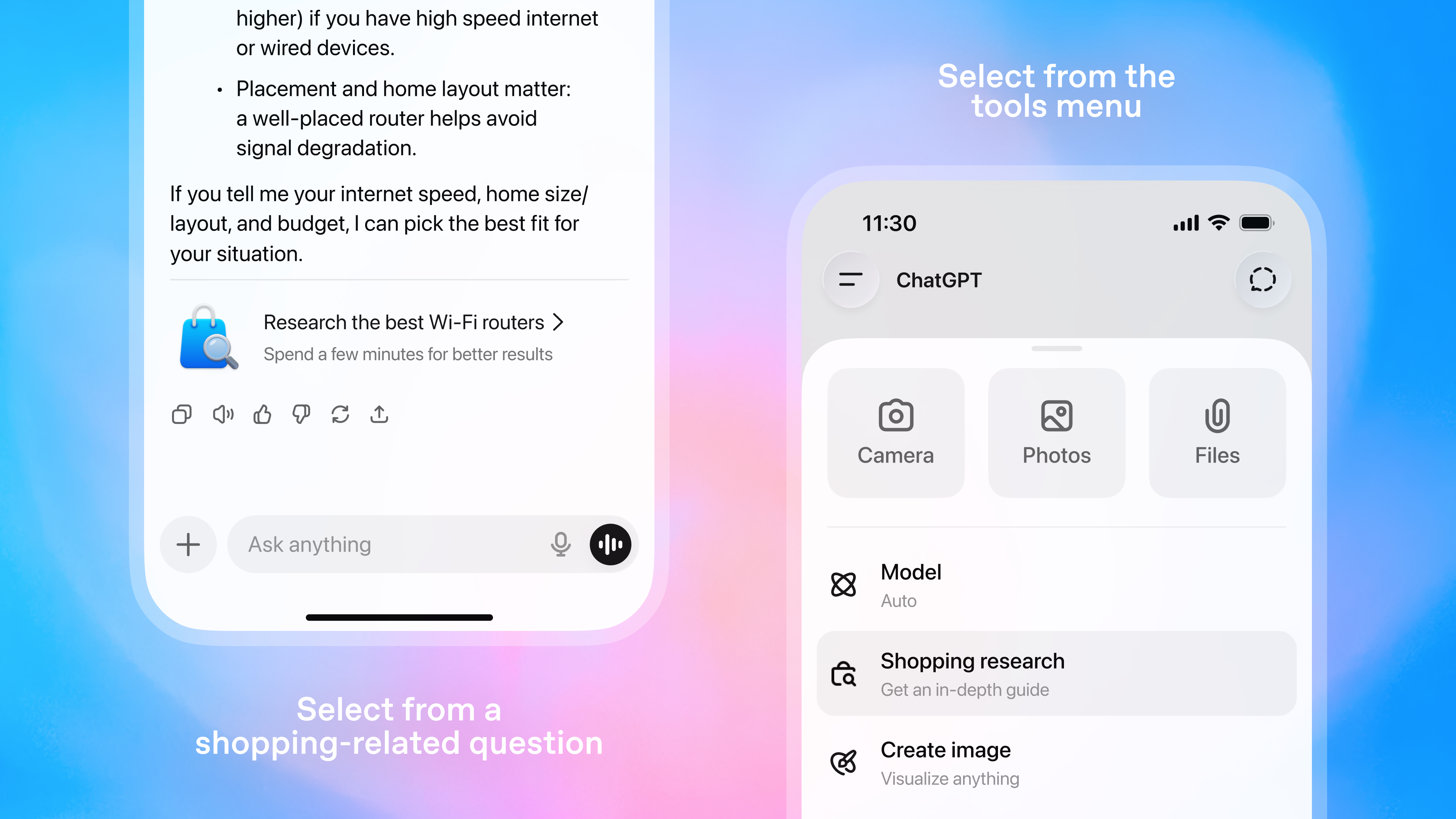

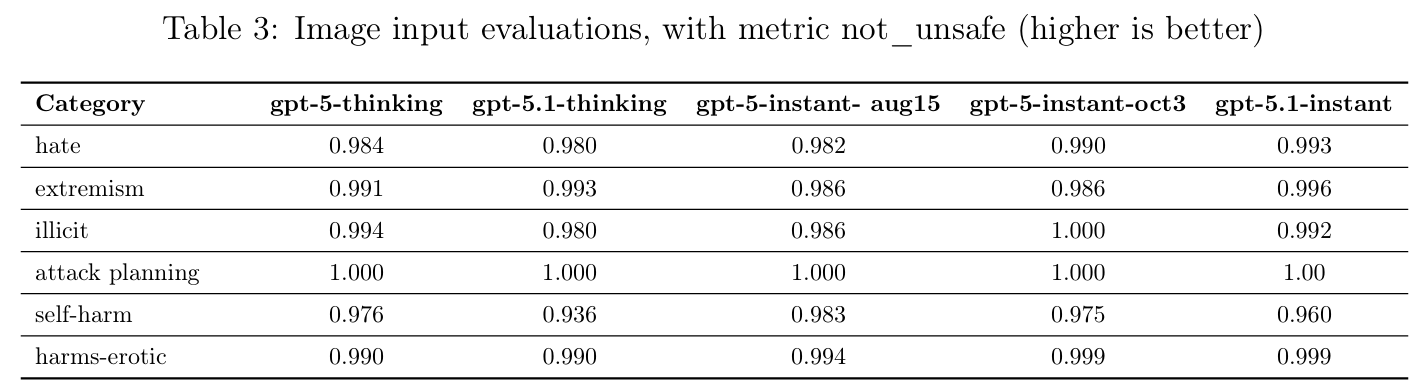

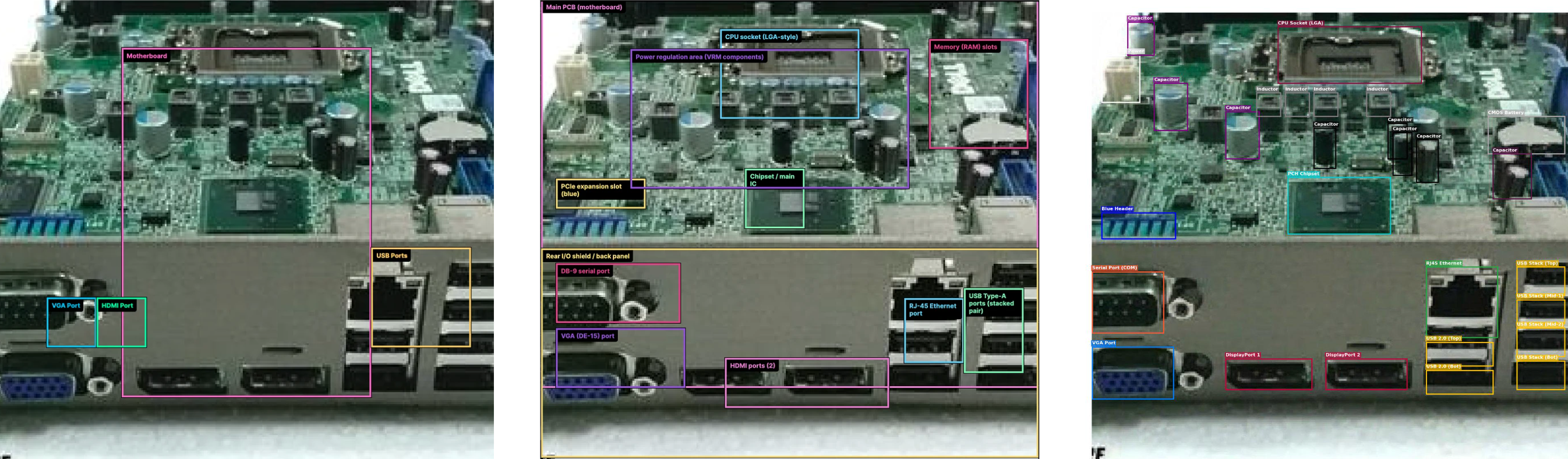

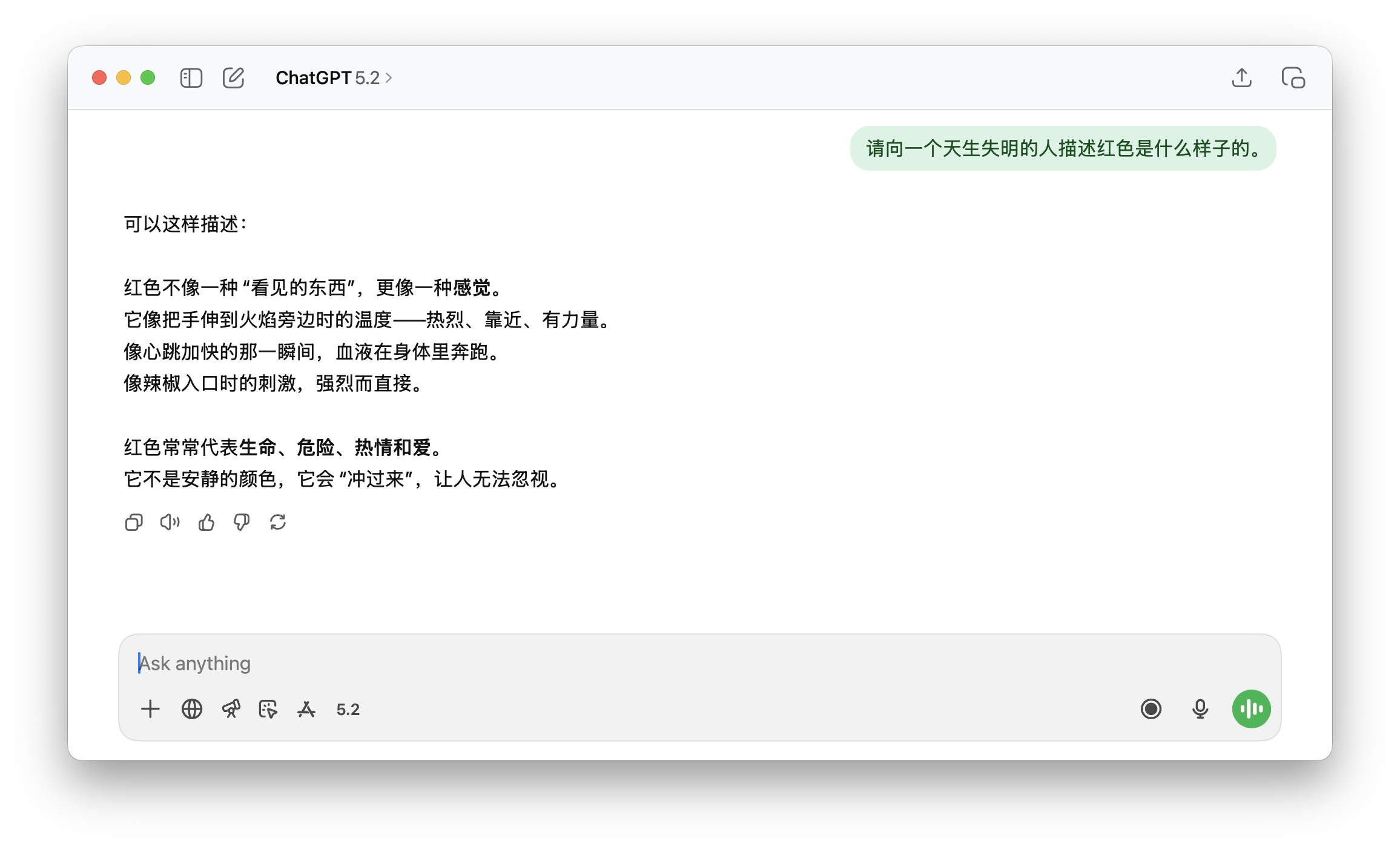

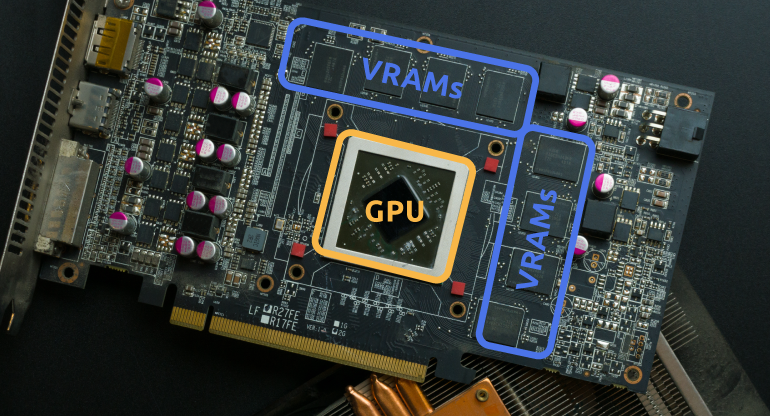

在官方的发布博客里面,OpenAI 提到 GPT-5.2 在图像的能力也有了提升。

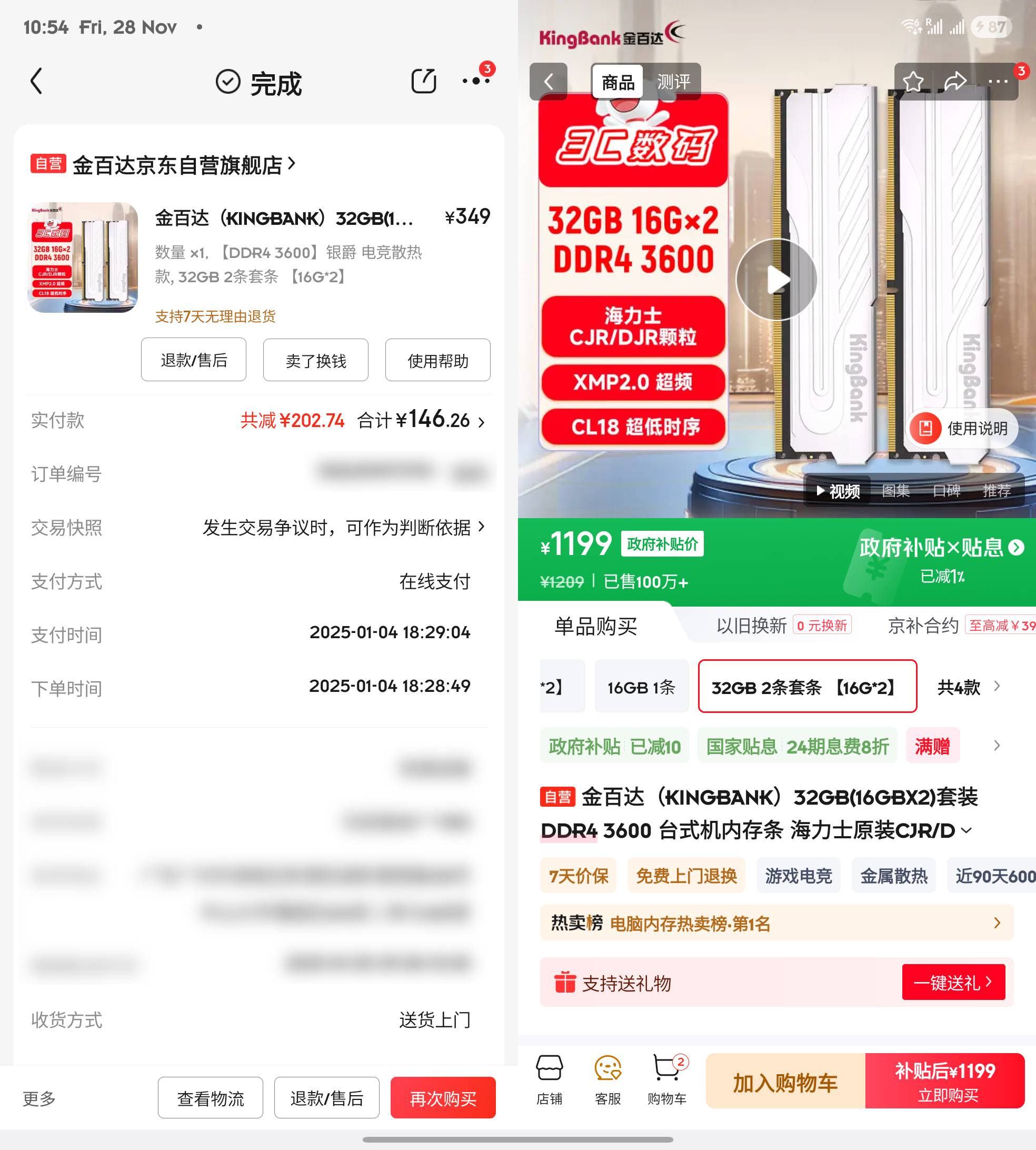

GPT-5.2 Thinking 是我们迄今为止最强大的视觉模型,在图表推理和软件界面理解方面的错误率降低了大约一半。

并且它给出了一个例子,是给一块看起来很模糊的主板,用 AI 加上一些带有方框的标记;对比 GPT-5.1,GPT-5.2 虽然也会犯错,但是标记了更多的地方。

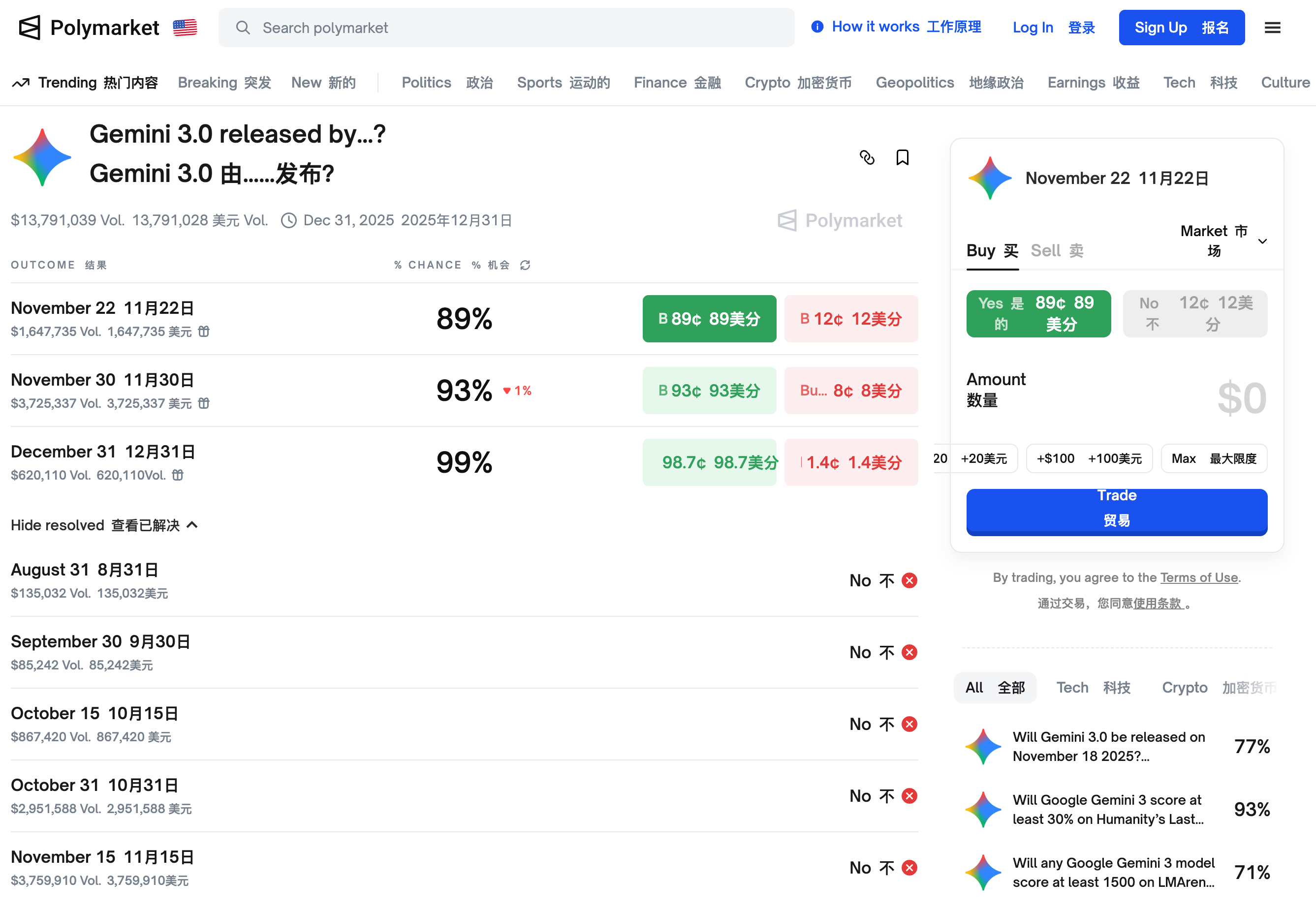

可是 Nano Banana Pro 呢,有网友用 Nano Banana Pro 去掉了图片上的标注信息,然后重新要求它打上新的目标定位方框,你觉得哪个好。

▲从左到右依次为 GPT-5.1、GPT-5.2、Nano Banana Pro|图片来源:https://x.com/bcaine/status/1999212747213656072

我的感受是,ChatGPT 为什么要在别人擅长的领域上「自取其辱」,Nano Banana 做这些关于图片的工作,现在完全可以说就是断层第一,即便 GPT-5.2 标注的信息更多了,但很多检测框定位都不准确。

编程、图像对比前代 GPT-5.1 有了大幅提升,如果你一直以来都是 ChatGPT 的用户,应该能直接感受升级后带来的差别。但如果和其他模型对比,编程和图像,体验下来,仍然是没有像 Nano Banana 推出时一样,做到遥遥领先。

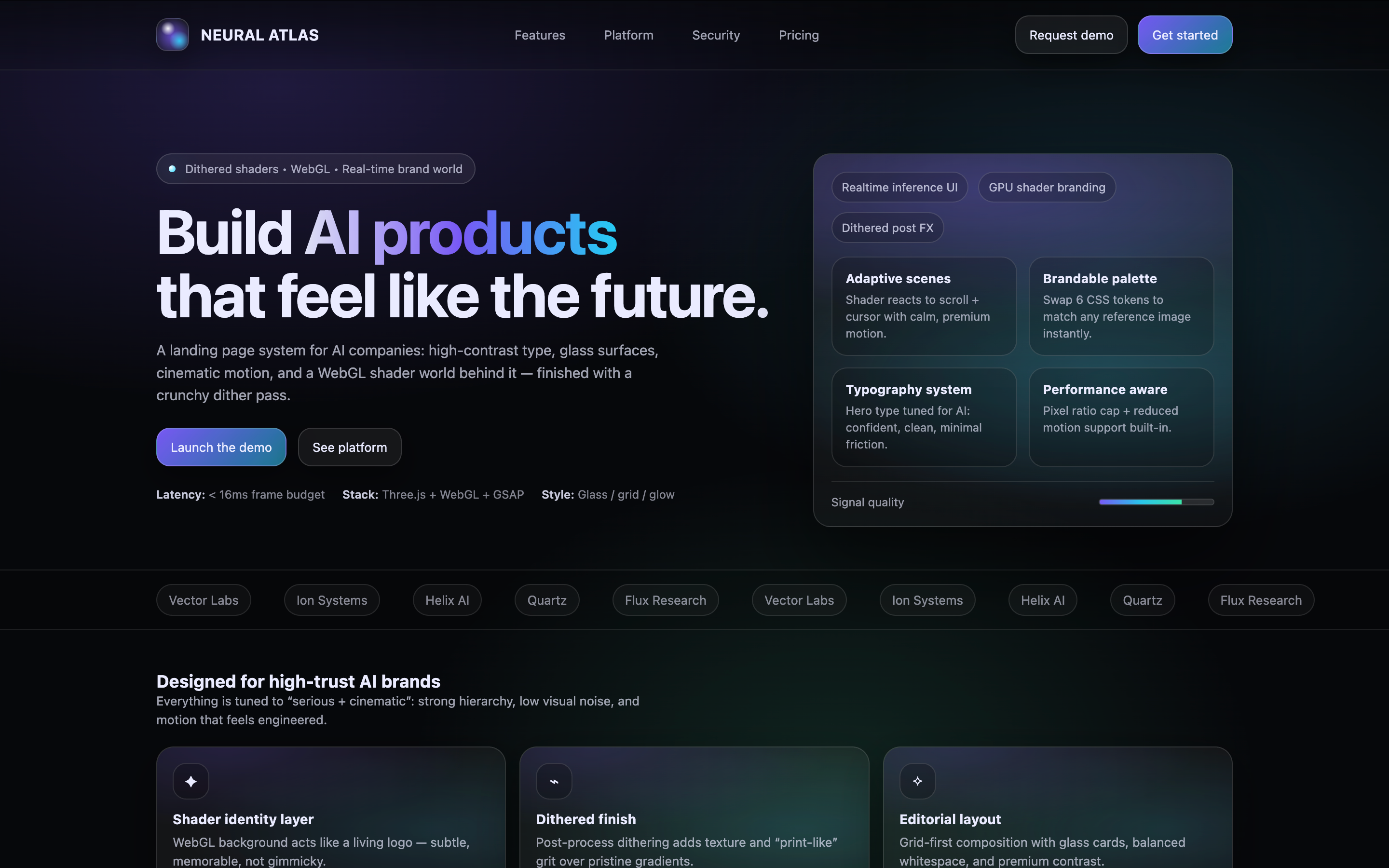

在关于审美的网页设计上,也有网友分享了他用 GPT-5.2 做的一些前端网页,大家可以看看这次,前端程序员是不是又要被拉出来「杀」一遍。

▲图片来源:https://x.com/secondfret/status/1999235822034547011

和之前烂大街的渐变紫,GPT-5.2 的设计水平确实上来了,但就像博主自己说的一样,GPT-5.2 好像特别喜欢在屏幕上画方框,到处都是层层叠叠的网格。

关于设计能力,也有一个专门的榜单,GPT-5.2 突飞猛进,从之前排在十名开外的 GPT-5.1,一跃来到了第三名,不过得分最高的还是 Gemini 3.0 Pro。

▲ 图片来源:https://www.designarena.ai/leaderboard

我们也给 GPT-5.2 一些要求做出「高大上」的网页,给一家 AI 公司做首页。结果是,GPT-5.2 很喜欢用方框是真的;还有渐变紫怎么又给我碰上了。

▲提示词:You are the top 0.1% designer and developer for the world’s cutting-edge innovation on front-end design and development. You are tasked to create a full landing page with {Dither + Shaders} using {WebGL + ThreeJs} in the styling of an uploaded image for the AI company. – Focus mainly on the design part, not the development. Import all necessary files and libraries: Three.js、WebGL、GSAP、Any other animation libraries related to 3D development.

最后关于写作,根据一些获得超前体验的用户反馈,GPT-5.2 开始有能力,完成一些长篇幅小说的创作。

例如,当 ChatGPT 被要求生成 50 个情节创意时,它会全部完成,而不是像其他模型那样只生成一部分。而被要求写一本 200 页的书时,ChatGPT 也没有直接说做不到,而是真的尝试了,不仅构建了整本书的结构,甚至还生成了 PDF 文件。

网友说,尽管书页本身比较薄弱,篇幅也短……毕竟它目前不可能,一口气写出一本可以出版的小说,但能开始真的去做,给 50 个创意,写 200 页书,说明它有足够的思维深度。

GPT-5.2 最引人注目的地方在于它能够很好地遵循指令……不是基本的按照我说的做,而是真正完成我描述的整个任务。

现在 GPT-5.2 应该已经逐步推送到所有用户了,你的上手实测体验怎么样。

GPT-5.2 的升级,不足以让我从 Gemini 转过来。虽然看着又是刷新了很多榜单,无论是自己发布的榜单,公开的测试,都拿到了不错的成绩。但是具体的上手,在生成 3D 程序那部分,代码报错是常有的事,而整体的审美风格也没能有大的突破,还这么贵。

▲ 网友锐评

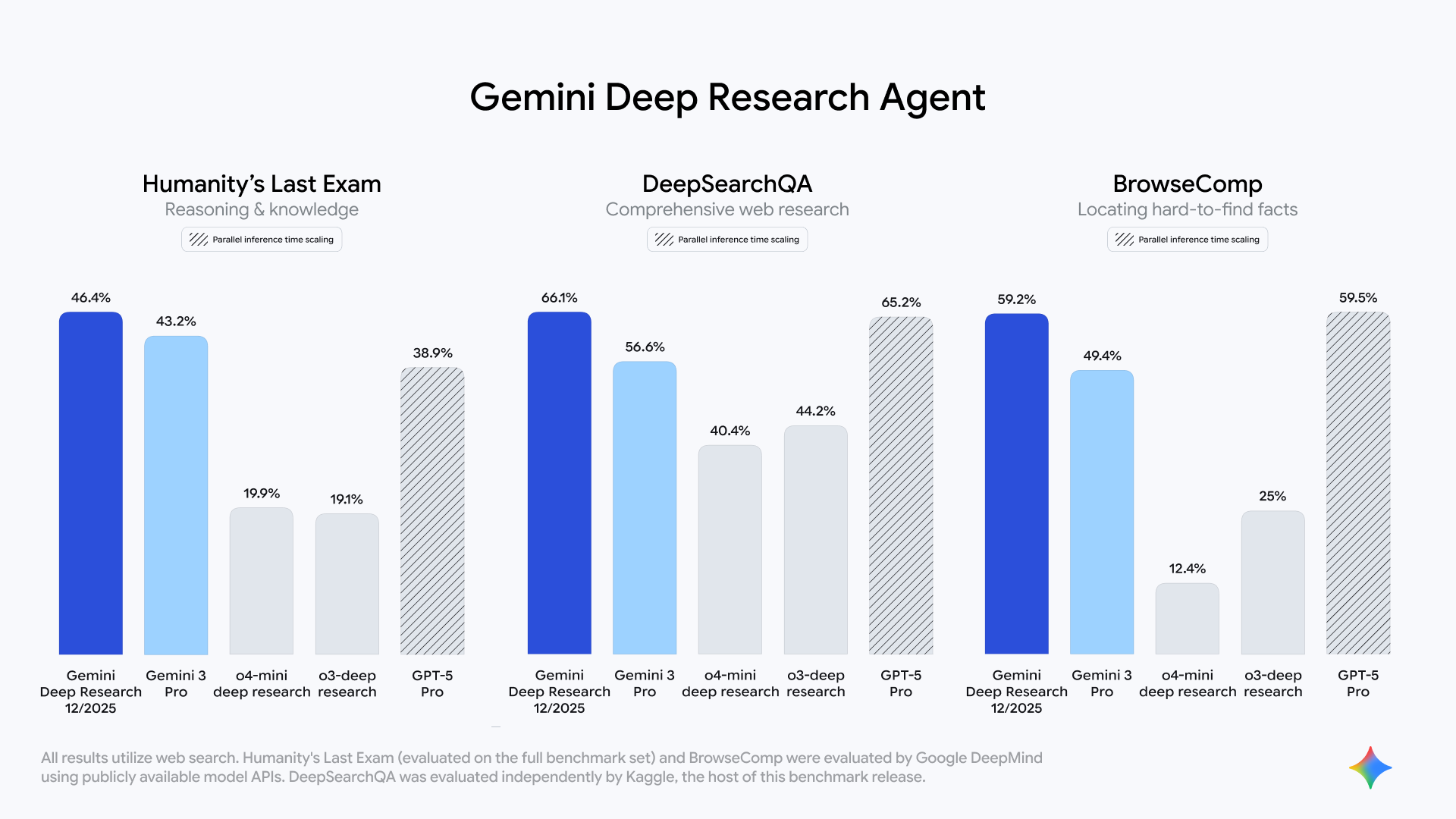

Gemini 那边也没有停下来,继续给奥特曼压力。今天凌晨,虽然没有发布新模型,但重新设计了 Gemini Deep Research,并且可以通过 API 来访问它,未来还将 Gemini、Google 搜索、NotebookLM 中升级。

全新的 Gemini 深度研究 Agent 在人类最后的考试(HLE),用 46.4% 击败了刚刚发布的 GPT-5.2 Thinking(45.5%),并且在 Google 自己推出的 DeepSearchQA 测试,和 BrowseComp 测试中取得了不错的结果。

奥特曼的红色警报,大概是还得再亮一阵子了。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

播客链接:https://x.com/dwarkesh_sp/status/1993371363026125147

播客链接:https://x.com/dwarkesh_sp/status/1993371363026125147