Netflix and Paramount Battle for Warner Bros. — Have We Seen This Show Before?

© Aleksey Kondratyev for The New York Times

© Aleksey Kondratyev for The New York Times

© The New York Times

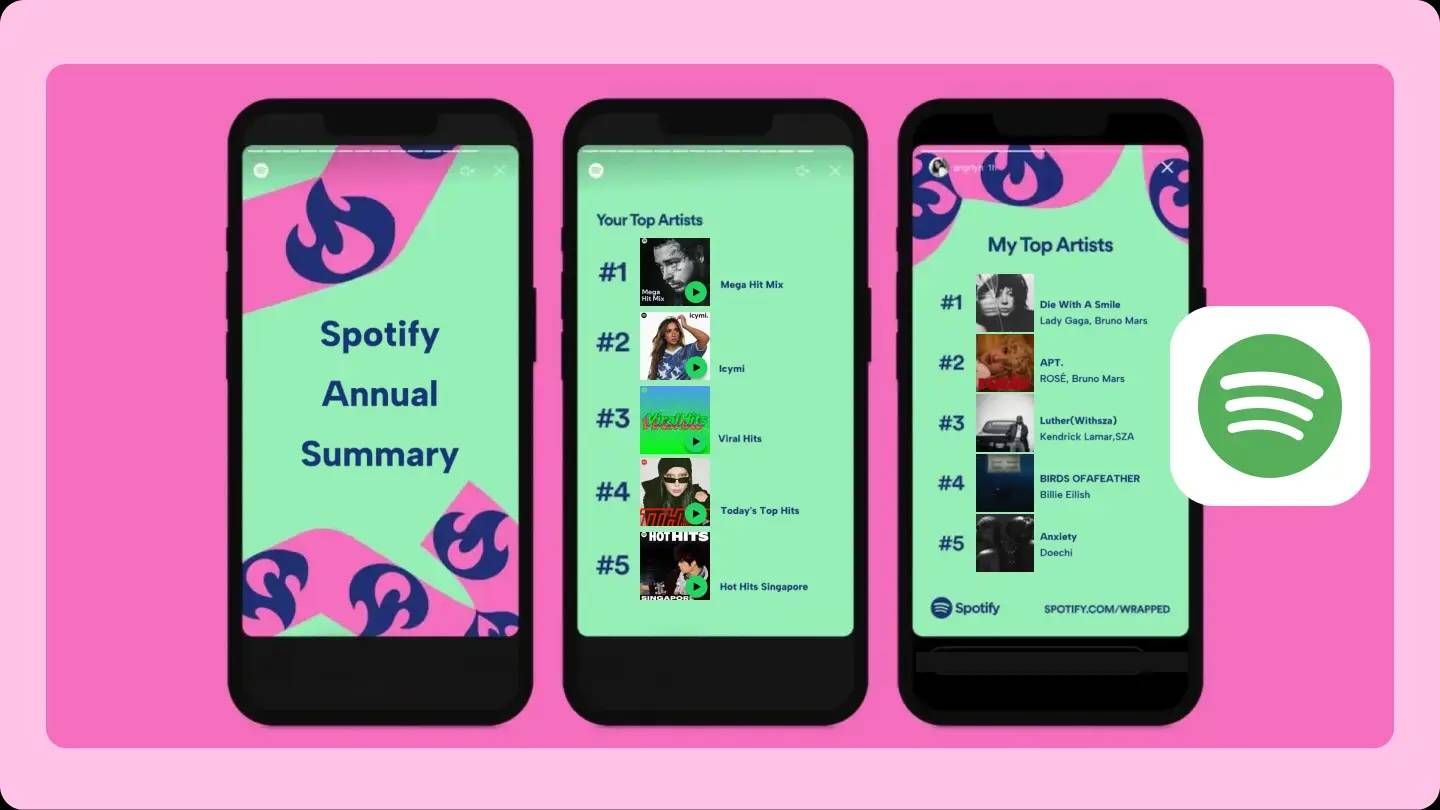

Spotify 的年度统计上周发布了,又到了用户一边转发,一边吐槽的季节——「这玩意儿也不准啊」。

但有比用户更崩溃的:明明已经和 Spotify 割席了,居然又「出现」在平台上。

这是来自澳洲的摇滚乐队 King Gizzard,这支乐队早在 7 月就因不满 Spotify 而主动下架了自己的全部歌曲,只留下了一个合作 Remix。

但他们的歌迷最近却发现了一支名为 「King Lizard Wizard」 的假乐队。上传的歌曲标题、歌词都逐字照搬 King Gizzard 的原作,甚至连歌曲名称都一模一样(比如冒牌乐队的《Rattlesnake》直接盗用原曲名和歌词)。用户在 Spotify 搜索 「King Gizzard」 时,会发现乐队已弃用的官方账号,下方却赫然推荐着这个山寨乐队——甚至在搜索结果中,假乐队的盗版《Rattlesnake》一度成为榜首。

山寨的现象从 Spotify 传到 YouTube,如此张冠李戴的现象令许多粉丝愤怒不已,这还是粉丝自己发现的,在 Reddit 上贴了出来后又觉得不对劲——这反而为山寨号引流了。

这桩大无语事件让 Spotify 平台在 AI 内容监管上的漏洞暴露无遗。假冒的 「King Lizard Wizard」 账号上线数周、积累了不菲的流量,后来才被移除——就连专辑封面也疑似 AI 生成。

更讽刺的是,其中一些假歌曲在元数据上还把 King Gizzard 主唱 Stu Mackenzie 列为词曲作者,简直明目张胆地蹭原创乐队的名气。明明是 Spotify 自己在 9 月时,宣称要出台新政策打击「垃圾内容、仿冒和欺骗」等行为,结果让这种 AI 山寨内容堂而皇之地混入了官方推荐位,包括 Release Radar 和 Discover Weekly 等歌单。

这已经不是疏忽,简直是对着人家乐队贴脸开大。

King Gizzard 的遭遇并非孤例。近一两年来,Spotify 平台上充盈着各式各样以 AI 技术批量生成的音乐内容,从模拟知名艺人的盗版歌曲,到平平无奇的生成音乐,应有尽有——现在,轮到翻唱了。

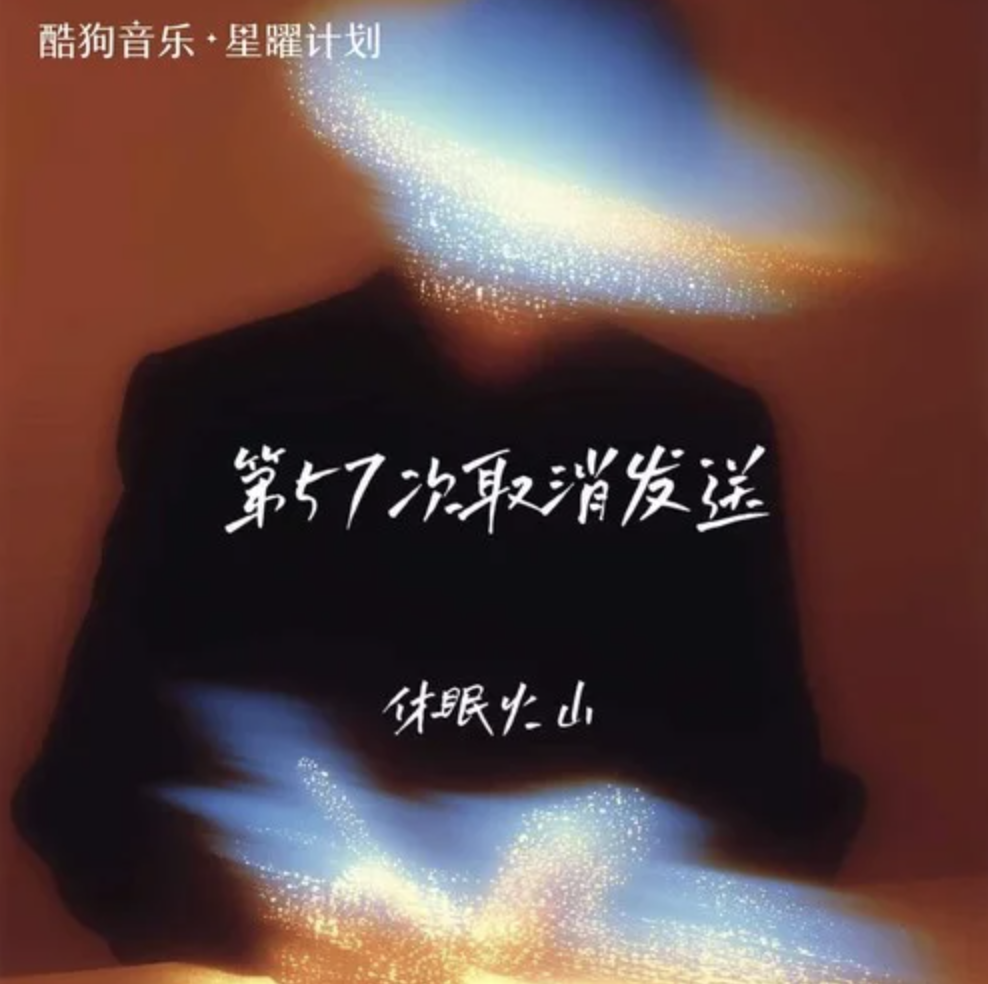

流媒体巨头们对 AI 生成内容实在是太热衷了。腾讯音乐曾经推出过 「启明星 AI 作曲」项目,号称已有超过 2600 万首 AI 音乐作品经由其算法创作并发布,累计播放量破十亿次。酷狗的「星曜计划」也有专门的 AI 子榜单,而且有原创有翻唱。

最典型的当属红遍抖音的《第 57 次取消发送》,最早发布于今年五月,原本是女声,不久前也就是 11 月时被翻成男声版又火了一遍——这次,是 AI 的。

男声版的「音色」还是有明显的 AI 感,仿佛一边唱一边踩电门,但也不妨碍这个歌引发大量共情和讨论。有人说勾起了旧日回忆,有很强的熟悉感,听着仿佛回到了华语音乐的黄金年代。

可不熟悉么,拼好歌拼出来的——

当资本和技术狂飙突进地涌入音乐生产,传统的创作生态势必受到冲击。在这一背景下,华语音乐人面临的可能是比西方同行更复杂的局面。

同时,翻唱其实是音乐平台上,很重要的构成版块:例如 cover,remix,既是粉丝和音乐爱好者二次创作的方式,也是新人和小歌手积累人气的方式。

当 AI 用虚构的名字和头像伪装成人,不断灌出机器人流水线作品,是对原创歌手和翻唱内容的双重打击。很多此类 AI 虚拟歌手顶着花哨的包装、写着空洞的简介,却堂而皇之拥有数十万月听众和官方歌单推送。

Spotify 也做过一些维护的动作,官方声称在过去一年内已移除上千万首涉嫌滥用算法的垃圾曲目,包含批量上传的雷同歌曲、标题堆砌关键词骗流量、以及「拆分长曲成短段以刷播次数」的作弊行为等。此外,Spotify 宣布提供新工具,允许创作者主动标注他们的音乐中是否使用了 AI 技术。

然而这些措施还是表面功夫偏多。大批 AI 音乐的祸根在于平台的运营逻辑:Spotify 强调歌单和无限播放模式,追求的是听众的停留时长,这种生态本就容易滋养垃圾内容和 AI 灌水。

再加上,Spotify CEO 丹尼尔·埃克本人也对 AI 技术非常热情,早在 2023 年便表示 AI 音乐「在文化上是好事,对 Spotify 也有利,因为创作者越多,平台提升用户参与和营收的机会就越大」。

典型的有「The Velvet Sundown」乐队,曾在 Spotify 上攒下逾百万听众,创作者后来才承认这不过是一场社交实验,音乐和照片都是伪造的。还有 「Echo Harper」 这样的虚拟摇滚歌手,被收录进 Spotify 精选的 「Just Rock!」 播放列表中。

▲The Velvet Sundown

有人愿意做,平台愿意买单,在这样的指导思想下,多快好省的 AI 内容自然正中平台下怀。

当不满累积到一定程度,抗争就此迸发。2023 年以来,越来越多的独立音乐人选择用脚投票,告别 Spotify。甚至一些乐队还会号召同行和听众一起「退出垃圾平台」。

创作歌手 Caroline Rose 选择只在黑胶和 Bandcamp 上发行新专辑,她直言「把我们的心血白白放上网免费听太蠢了」。Bandcamp 是一个链接歌迷和音乐人的「直销」平台,实行「付多少算多少」(Pay-what-you-want)的专辑下载方式,一般情况下艺人可获收益的 82%,且定期举办 Bandcamp Fridays 让艺人获得 100%销售额。

越来越多音乐人开始尝试跳出「一切都丢到流媒体」的套路,回归付费拥有音乐的传统:卖黑胶和磁带、举办付费直播演出、进驻 Bandcamp 等等。

相比之下,国内的情况更为复杂一些。虽然 AI 生成的音乐的确在逐渐铺开,但还没有到鹤唳风声的程度,也就没有激起太多对平台的抵制。《第 57 次取消发送》不仅在抖音等社交平台上大受欢迎,还登上了综艺节目,由真人明星演绎。

从 King Gizzard 乐队怒删曲目、却被 AI 克隆鸠占鹊巢的荒诞,到大批独立音乐人愤而出走 Spotify、寻求他途,这一系列事件背后揭示的是同一个本质:音乐被当作纯粹的数据产物和工具来榨取价值。

音乐创作的能力越来越不稀缺了,「拼好歌」听上去离谱,但「拼」出来的歌却正在收到欢迎。未来越发稀缺的,可能是人们对音乐的用心聆听,对创作者真诚的支持。当越来越多的人意识到这一点,也许音乐产业才有机会走上一条更尊重创作者、更有温度的道路。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

© Al Drago/Getty Images

© Randy Holmes/Disney, via Associated Press

© Kenny Holston/The New York Times

© Tierney L. Cross/The New York Times

© Maisie Cousins for The New York Times

© Aleksey Kondratyev for The New York Times

如果要给你的爱车买外设,你想到的一般是什么?

大概率是车衣、灭火器、安全锤、儿童座椅、户外电源之类的东西对吧。但理想说:停停停,我这里还有一个新东西——

这就是理想最新发布的 AI 智能眼镜「Livis」,一副好眼镜、一副好墨镜、一个好音响、一个好相机,还有一整天的长续航。

当然,它也能顺便帮你控制理想汽车——

爱范儿收到的理想 Livis 智能眼镜是科技灰亮光配色,搭配一对蔡司平光感光变色镜片,被太阳光照射后会变成灰色的墨镜。

根据我们目前体验的感受来看,这或许就是现阶段最聪明的「车用墨镜」了。

当然,作为一副智能眼镜类产品,我们必须同时从「智能」和「眼镜」两方面去评价。而这次理想 Livis 做得最好的一点,就在于它先是一副好眼镜、然后才是一个智能的眼镜。

其实仅从外观和设计上,我们就能看出,理想 Livis 将产品重点放在「做个好眼镜」上的优先级是很高的。

理想 Livis 在保证长达 18 小时典型使用时间的前提下,做到了仅仅 36g 的裸框重量,即使加上镜片,整机的重量也能维持在 50g 上下。

按照理想的说法,Livis 就是目前世界上最轻的智能眼镜。

而为了让 Livis 作为一副眼镜更好用,理想也在镜片上花了不少功夫。理想 Livis 的镜片合作方为百年光学大厂蔡司,从透明到墨镜,无论平光还是远近视,都有非常丰富的镜片选择。相比于其他同类智能眼镜,蔡司镜片的加持让 Livis 在清晰度上获得了明显优势。

此外,理想 Livis 作为一款主打配车使用的产品,直接标配了支持无线充电功能的眼镜盒,实现随充随用、随放随充。

而在眼镜的基础功能之外,理想 Livis 的主要功能体现在这三点上:音响、相机,以及智能控车。

其中最突出、也最让我们在体验时感觉到惊喜的,就是理想 Livis 的音乐能力。

作为一副开放式耳机,它配备了一套「双磁路三明治扬声器」,利用智能调频,让近场(人耳位)声音加强,远场(路人位)声音抵消,实现了开放式耳机防漏音的功能。

而 Livis 的实际音质表现也的确有点东西,甚至是爱范儿目前体验过的智能眼镜里面音质最好的一个。

和一般的开放式以及骨传导耳机不同,理想 Livis 的扬声器支持空间音频效果,加上支持立体收音的 4 麦克风阵列,通过眼镜录音再回放的时候,不仅人声很清晰,而且能够听出声音的来源方向。

此外,理想还给 Livis 眼镜画了一个相当令人期待的饼:这款眼镜后续可以通过 OTA,解锁更进一步的车机互联玩法,支持上车后作为头枕音响使用——直接解决了目前所有理想车型都不支持头枕音响的问题。

那么目前智能眼镜最流行的记录功能,理想 Livis 做得怎么样呢?它的传感器为 1200 万像素的索尼 IMX681,视场角达到了 105 度,抓拍响应时间也来到了相当优秀的 0.7 秒,几乎已经和手机的拍照速度相同了。

值得一提的是,理想 Livis 支持拍摄实况照片,能够在摁下快门后保持录制 3 秒钟的视频,这个功能在智能眼镜上很少见。

至于录像方面,理想 Livis 的表现就不如 Ray-Ban Meta 这种有直播属性的智能眼镜了,Livis 单次录像的长度被限制在了三分钟,总时长为 47 分钟。画幅则支持横向或竖向的 4:3 与 16:9 共计四种,基本涵盖了所有社媒形式。

而对于一款「车厂眼镜」最根本的需求——智能控车方面,理想 Livis 则交出了一份令人满意的答卷。

首先,Livis 需要通过手机上的「理想同学」app 进行连接,佩戴眼镜的时候可以直接呼叫和调用最新版的 MindGPT-4o 模型的理想同学 agent,唤醒仅需 300ms,对话响应时间也压缩到了 800ms。

佩戴理想 Livis 眼镜时,你不需要掏出手机、也不需要抬起手腕解锁手表,只需要对着空气说一句「理想同学」,就能控制车上的空调冰箱后备箱,也能很方便的查询当前车辆位置和续航里程等信息。

在我们的实际体验中,用 Livis 呼叫理想同学不仅响应非常快,它也支持上下文连续问答,app 中的「记忆功能」也可以成为语音记事本,让它帮你记住一些零碎信息——比如帮你记住车停在了「北京西站南广场东」。

不过目前 Livis 搭配理想同学 app 也有一些局限,比如它没法创建或者写入日程提醒,只能帮你记住文字信息,并且也没有条件触发提醒,记住的信息都需要你主动去问。如此种种,还不够方便。

换句话说——给 Livis 下指令、随口聊聊天问问信息还行,想让它当一个「随车秘书」就不太方便了。

总之,对于一款「汽车周边」,理想 Livis 眼镜基本达到了我们对于眼镜、智能以及控车的期待,更何况哪怕抛开所有「智能」的部分,它依然是一款相当不错的蔡司眼镜。

理想 AI 眼镜 Livis 的起售价为 1999 元,整镜国补后 1699.15 元,而配备 1.60 折射率的透明屈光镜片到手仅需 2005.15 元。这价格在外面单买蔡司镜片可能都不够,理想还给你送一副智能眼镜。

▲ 理想 AI 眼镜 Livis 各版本售价

对于非车主来说,这是一副支持线上配镜、蔡司加持且音质不错的智能眼镜,听歌、拍照、录像、随时问答。

而对于车主而言,不仅能用上方便无感的语音车控,Livis 还能取长补短、变身成为车载的头枕音响,说不准等以后功能更加完善了,还能实现语音召唤车辆驶出车位、AI 智能聚合变成你的随车秘书等等高级功能,想想都刺激。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

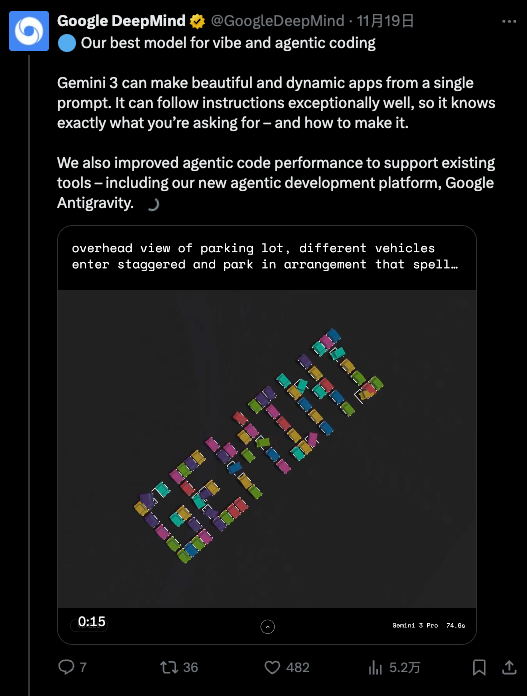

Gemini 3 Pro 预览版上线那一刻,很多人心里的第一反应可能是:终于来了。

遛了将近一个月,这里暗示那里路透:参数更强一点、推理更聪明一点、出图更花一点,大家已经看得心痒痒了。再加上 OpenAI、Gork 轮番出来狙击,更加是证实了 Gemini 3 将是超级大放送。

这次 Gemini 3 的主打卖点也很熟悉:更强的推理、更自然的对话、更原生的多模态理解。官方号称,在一堆学术基准上全面超越了 Gemini 2.5。

但如果只盯着这些数字,很容易忽略一个更关键的变化:

Gemini 3 不太像一次模型升级,更像一次围绕它的 Google 全家桶「系统更新」。

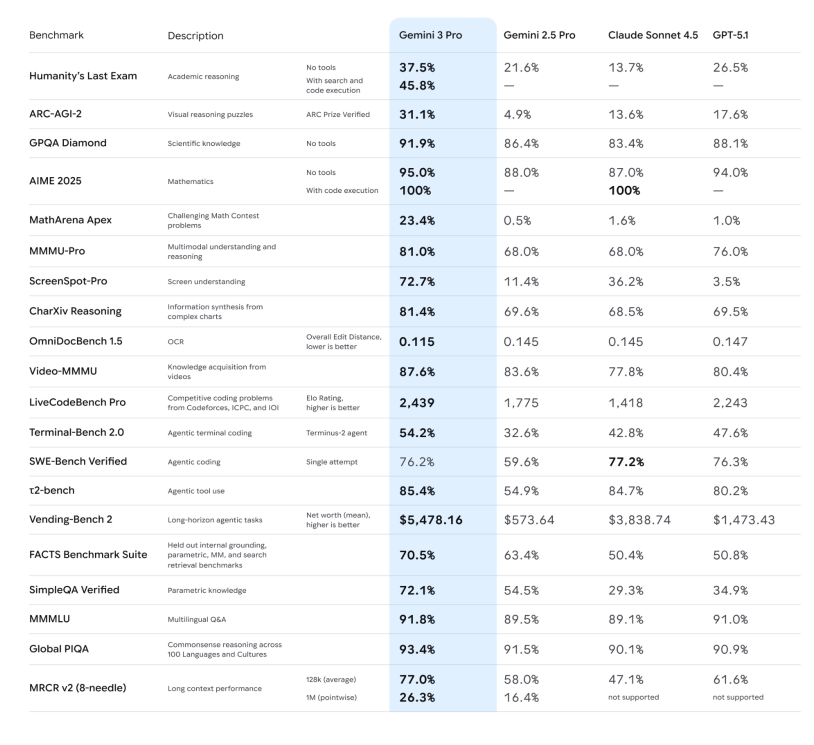

先快速把「硬指标」过一遍,免得大家心里没数:

-推理能力:官方强调 Gemini 3 Pro 在 Humanity’s Last Exam、GPQA Diamond、MathArena 等一堆高难度推理和数学基准上,全部刷出了新高分,定位就是「博士级推理模型」。

-推理能力:官方强调 Gemini 3 Pro 在 Humanity’s Last Exam、GPQA Diamond、MathArena 等一堆高难度推理和数学基准上,全部刷出了新高分,定位就是「博士级推理模型」。

-多模态理解:不仅看图、看 PDF,甚至还能在长视频、多模态考试(MMMU-Pro、Video-MMMU)上拿到行业领先成绩,说看图说话、看视频讲重点的能力,提升了一档。

-Deep Think 模式: ARC-AGI 这类测试证明:打开 Deep Think 后,它在解决新类型问题上的表现会有可见提升。

从这些层面看,很容易把 Gemini 3 归类为:「比 2.5 更聪明的一代通用模型」。但如果只是这样,它也就只是排行榜上的新名字。连 Josh Woodward 出来接受采访都说,这些硬指标只能是作为参考。

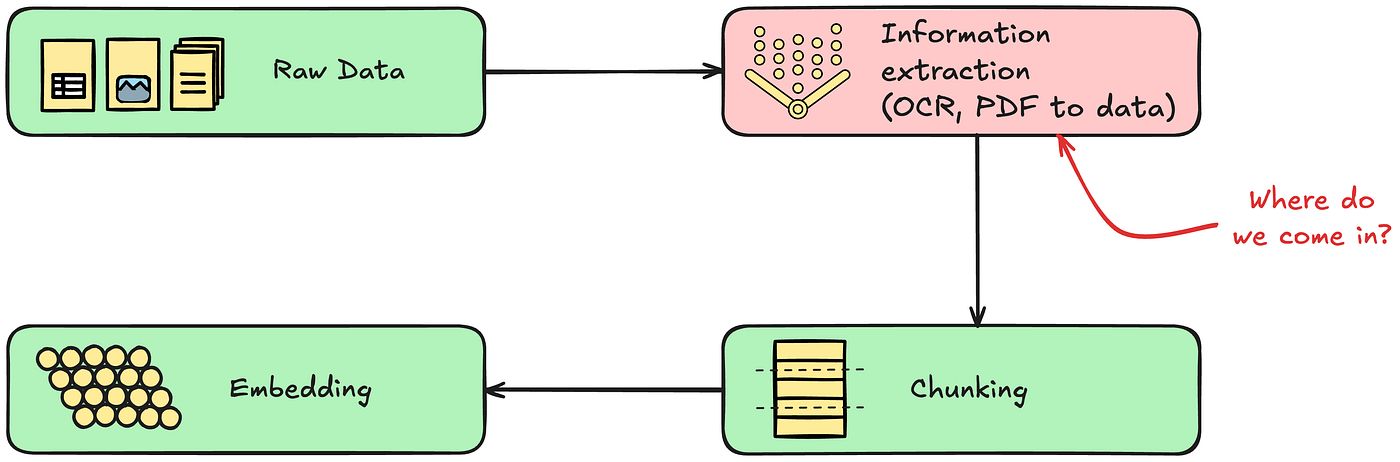

换句话说,「跑了多少分」只是一种相对直观的表现手法,真正有意思的地方在于 Google 把它塞进了哪些地方,以及打算用它把什么东西连起来。在这一个版本的更新中,「原生多模态」显然是重中之重。在这一次的大更新中,「原生多模态」显然是重中之重。

如果要为当下的大模型找一个分水岭,那就是:它究竟只是「支持多模态」,还是从一开始就被设计成「原生多模态」。

这是 Google 在 2023 年,即 Gemini 1 时期就提出来的概念,也是一直以来他们的策略核心:在预训练数据里一开始就混合了文本、代码、图片、音频、视频等多种模态,而不是先训一个文本大模型,再外挂视觉、语音子模型。

后者的做法,是过去很多模型在面对多模态时的策略,本质还是「管线式」的:语音要先丢进 ASR,再把转好的文本丢给语言模型;看图要先走一个独立的视觉编码器,再把特征接到语言模型上。

Gemini 3 则试图把这条流水线折叠起来:同一套大型 Transformer,在预训练阶段就同时看到文本、图像、音频乃至视频切片,让它在同一个表征空间里学习这些信号的共性和差异。

少一条流水线,就少一层信息损耗。对模型来说,原生多模态不仅仅是「多学几种输入格式」,这背后的意义是,少走几道工序。少掉那几道工序,意味着更完整的语气、更密集的画面细节、更准确的时间顺序可以被保留下来。

更重要的是,这对应用层有了革命性的影响:当一个模型从一开始就假定「世界就是多模态的」,它做出来的产品,与单纯的问答机器人相比,更像是一种新的交互形式。

这次 Gemini 3 上线,Google 同步在搜索栏的 AI Mode 更新了,在这个模式下,你看到的不再是一排蓝色链接,而是一整块由 Gemini 3 生成的动态内容区——上面可以有摘要、结构化卡片、时间轴,虽然是有条件触发,但是模型发布的同时就直接让搜索跟上,属实少见。

更特别的是,AI 模式支持使用 Gemini 3 来实现新的生成式 UI 体验,例如沉浸式视觉布局、交互式工具和模拟——这些都是根据查询内容即时生成的。

这个思路将一系列 Google 系产品中发扬光大,官方的说法是更像「思考伙伴」,给出的回答更直接,更少套话,更有「自己看法」,更能「自己行动」。

配合多模态能力,你可以让它看一段打球视频,帮你挑出动作问题、生成训练计划;听一段讲座音频,顺手出一份带小测题的学习卡片;把几份手写笔记、PDF、网页混在一起,集中整理成一个图文并茂的摘要。

这部分更多是「超级个人助理」的叙事:Gemini 3 塞进 App 之后,试图覆盖学习、生活、轻办公的日常用例,风格是「你少操点心,我多干点活」。

而在 API 侧,Gemini 3 Pro 被官方明确挂在「最适合 agentic coding 和 vibe coding」这一档上:也就是既能写前端、搭交互,又能在复杂任务里调工具、按步骤实现开发任务。

这一次最令人惊艳的也是 Gemini 在「整装式」生成应用工具的能力上。

这也就来到了这次发布的新 IDE 产品:Antigravity。在官方的设想中,这是一个「以 AI 为主角」的开发环境。具体实现起来的方式包括:

-多个 AI agent 可以直接访问编辑器、终端、浏览器;

-它们会分工:有人写代码,有人查文档,有人跑测试;

-所有操作会被记录成 Artifacts:任务列表、执行计划、网页截图、浏览器录屏……方便人类事后检查「你到底干了啥」。

在一个油管博主连线 Gemini 产品负责人的测试中,任务是设计一个招聘网站,而命令简单到只是复制、复制、全部复制,什么都不修改,直接粘贴。

最终 Gemini 独立完成对混乱文本的分析,真的做了一个完整的网站出来,前前后后所有的素材配置、部署,都是它自己解决的。

从这个角度看,Gemini 3 不只是一个「更聪明的模型」,而是 Google 想用来粘住 Search、App、Workspace、开发者工具的那条新总线。

回到最直觉的感受上:Gemini 3 和上一代相比,最明显的差别其实是——它更愿意、也更擅长「帮你一起协作」。这也是 Google 对它赋予的期待。

跳出 Google 自身,Gemini 3 的 Preview 版本实际上给整个大模型行业,打开了一局新游戏:多模态能力应用的爆发势在必行。

在此之前,多模态(能看能听)是加分项;在此之后,“原生多模态”将基本配置——还不能是瞎糊弄的那种。Gemini 3 这种端到端的视听理解能力,将迫使 OpenAI、Anthropic(Claude)以及开源社区加速淘汰旧范式。对于那些还在依赖「截图+OCR」来理解画面的模型厂商来说,技术倒计时已经开始。

「套壳」与中间层也会感到压力山大,Gemini 3 展现出的强大 Agent 规划能力,是对当前市场上大量 Agentic Workflow(智能体工作流) 创业公司的直接挤压。当基础模型本身就能完美处理「意图拆解-工具调用-结果反馈」的闭环时,「模型即应用」的现实就又靠近了一点。

另外,手机厂商可能也能感到一丝风向的变化,Gemini 3 的轻量化和响应速度反映的是 Google 正在为端侧模型蓄力,结合之前苹果和几家不同的模型大厂建立合作,可以猜测行业竞争将从单纯比拼云端参数的「算力战」,转向比拼手机、眼镜、汽车等终端落地能力的“体验战”。

在大模型竞争的上半场,大家还在问:「谁的模型更强?」,参数、分数、排行榜,争的是「天赋」。到了 Gemini 3 这一代,问题慢慢变成:「谁的能力真正长在产品上、长在用户身上?」

Google 这次给出的答案,是一条相对清晰的路径:从底层的 Gemini 3 模型,往上接工具调用和 agentic 架构,再往上接 Search、Gemini App、Workspace 和 Antigravity 这些具体产品界面。

你可以把它理解成 Google 用 Gemini 3 将以原生多模态为全新的王牌,并且给自己旗下生态中的所有产品,焊上一条新的「智能总线」,让同一套能力,在各个层面都得以发挥。

至于它最终能不能改变你每天用搜索、写东西、写代码的方式,答案不会写在发布会里,而是写在接下来几个月——看有多少人,会在不经意间,把它留在自己的日常工作流中。

如果真到了那一步,排行榜上谁第一,可能就没那么重要了。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

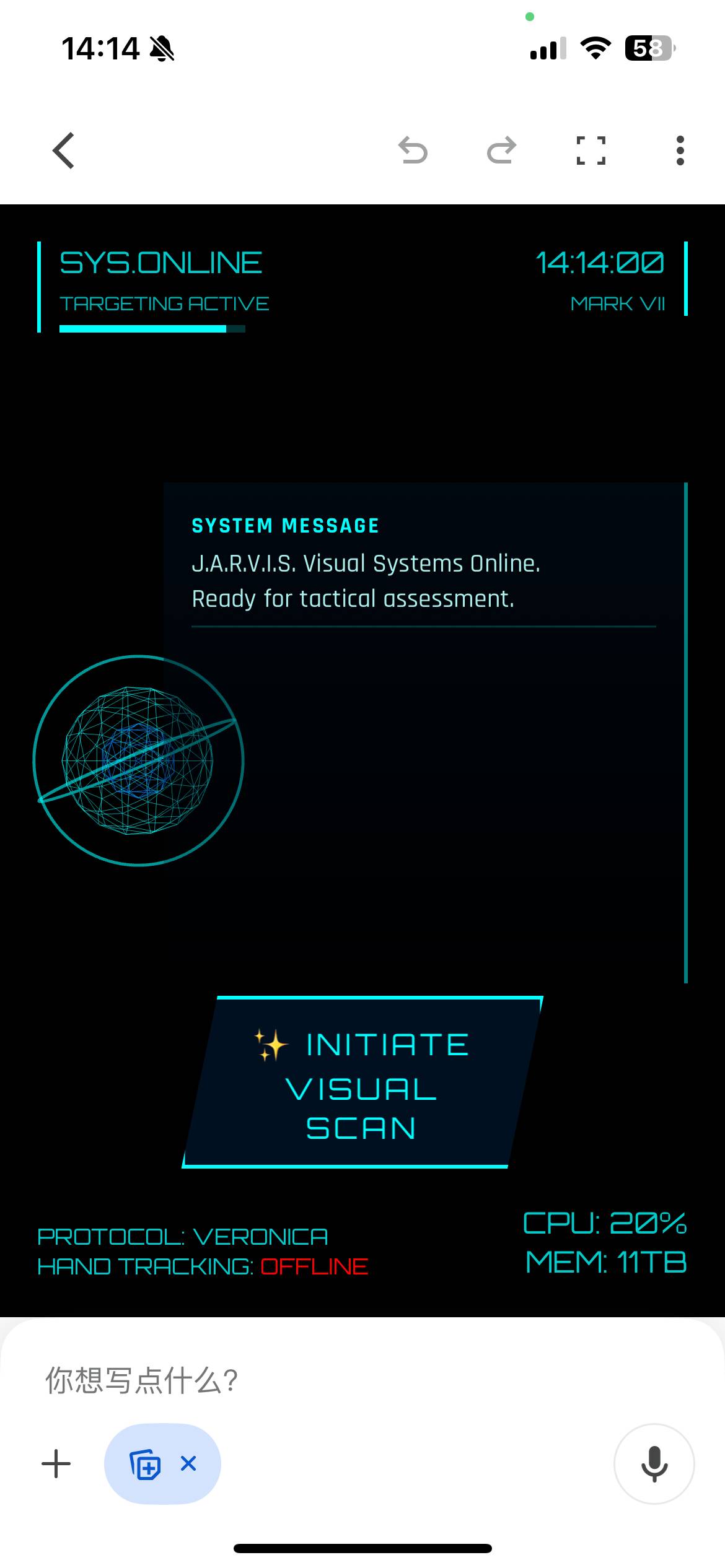

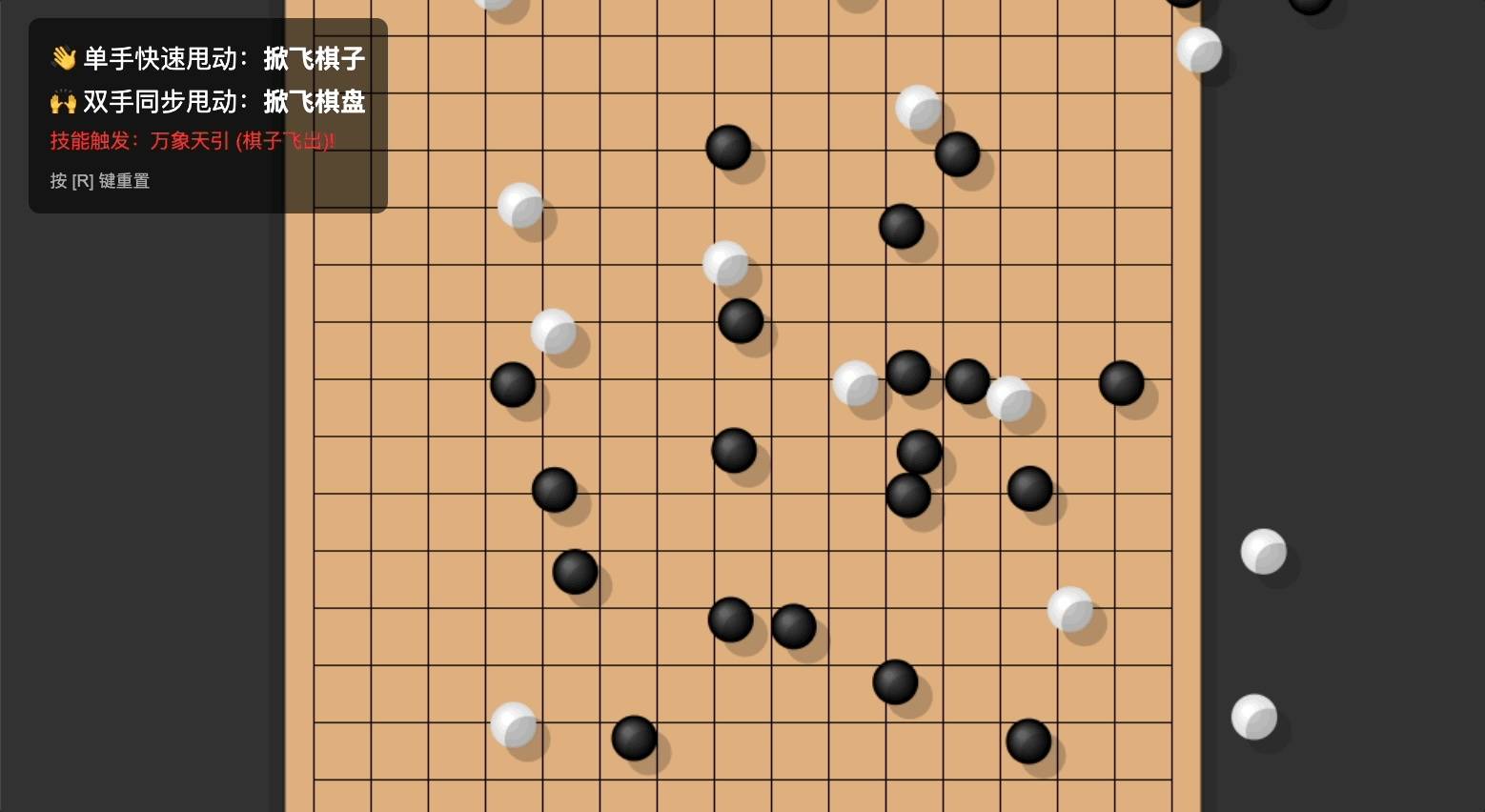

Gemini 3 发布之后这些日子里,我逐渐感到疑惑:为什么总让 AI 写网站写 PPT,Gemini 都发到第三代了,不能干点更有意思的事吗?

要那种科幻感强的、效果酷炫的、难度系数高的,但小白也能做的。比如这种:

或者这种:

Gemini:手势交互?没问题,包的。

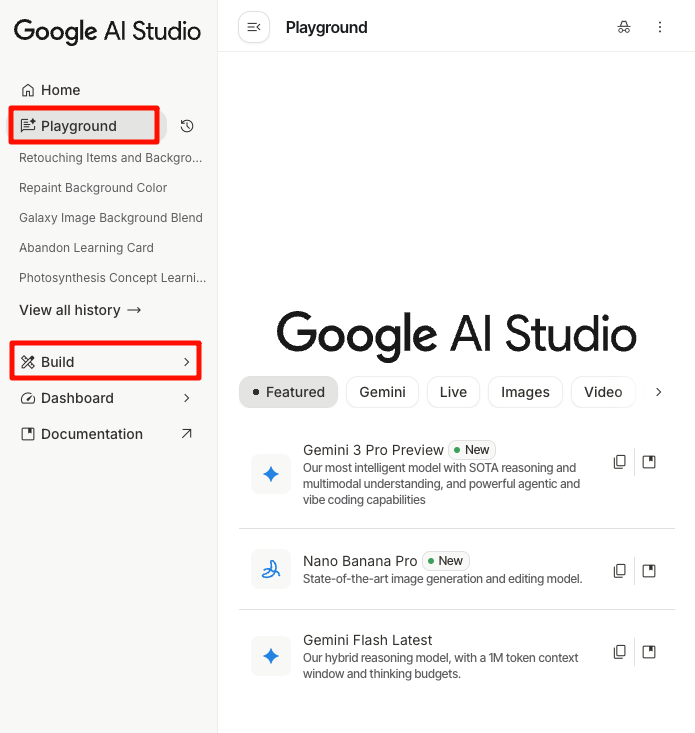

在开始之前,先准备好 Gemini 3,这里是一点点的注意事项

目前有三种方式开启玩耍:Gemini 客户端 Canvas 模式、Google AI studio-Playground 和 Google AI studio-Build。

其中,最不推荐的是客户端,亲测无法有效拉起摄像头,并且,下面都是手势互动项目,举着手机,手自然也是没法做操控的。

后两者中,Build 是直接形成一个 app,你可以分享给其它朋友,缺点是 tokens 有限。而 Playground 会生成一套代码,需要下载到本地再打开,一旦换个电脑就可能运行不了,但优点是几乎没有 tokens 限制,每天一百万,量大管饱。

考虑到交互项目比较消耗 tokens,所以 Playground 更为合适,个别小项目用 Build 也可以,这就看个人情况而定。

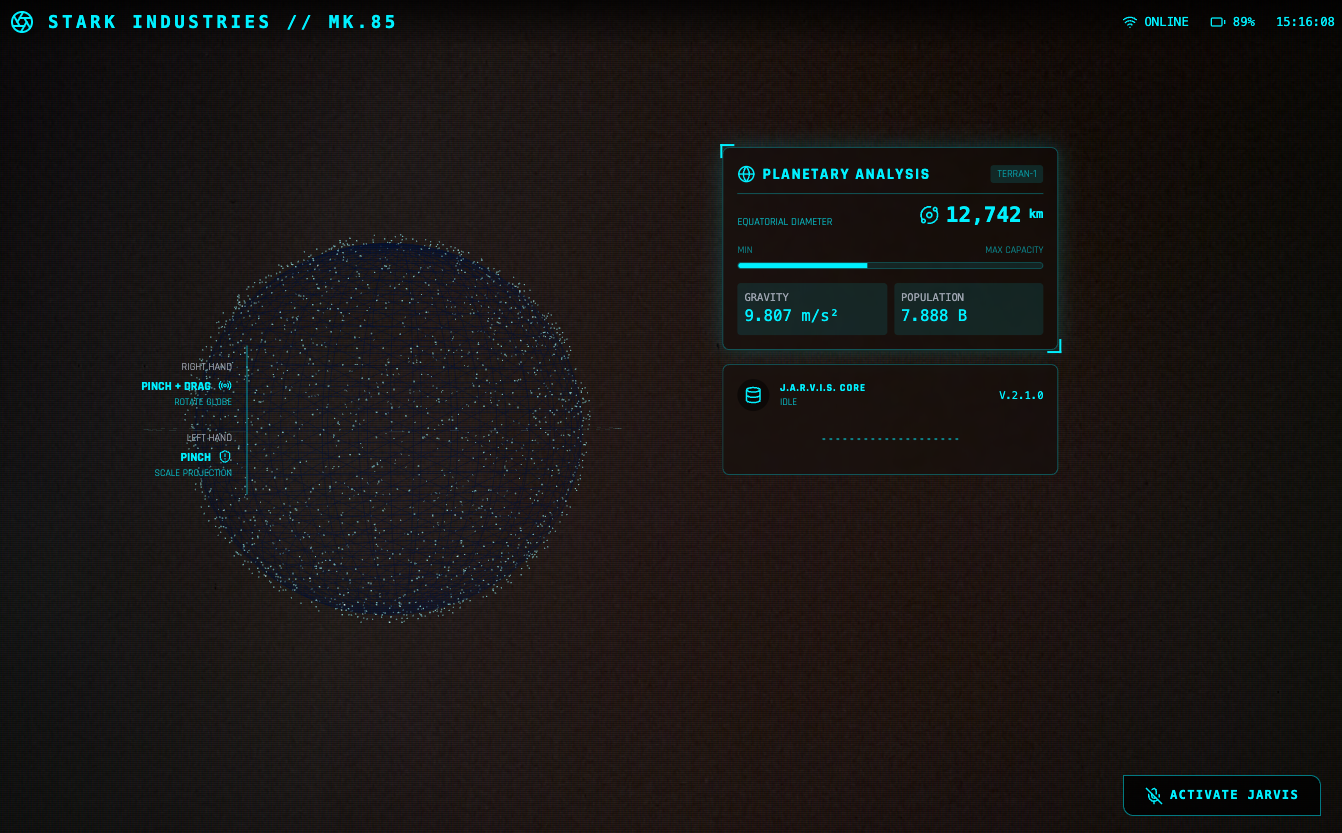

Jarvis HUD 面板是在推上超过二十万次浏览的热门爆款,手势操控仪表球,就像钢铁侠操控 Jarvis 那样,酷毙了。

参考 prompt 如下:

create a webapp using vanilla js, html, css, modern threejs, mediapipe. it should be a sci-fi tony stark / iron man / jarvis experience focused on simulating an AR heads up display experience. full screen webcam input shown. add a heads up display that tracks the user’s head (offset to the right), with live updating metrics. a minimal 3D world globe should be shown on the left center of the screen, that should be able to be rotated / sized by the user hand gestures

在 Build 模式下,亲测完全可以实现一次成型,Gemini 会自动安排任务、编写代码,调用不同的接口,进度条显示完成后,点击 Preview 就能直接打开——记得放行摄像头权限。

Gemini 3 自己就把效果设计安排得明明白白:左手是放大缩小,右边是转动,双手进入摄像头范围后会显示触控点——这些都是 prompt 里没有的,都是它自己的「想」出来的。搭配大屏幕或者投影,真的很有 Jarvis 既视感。

左边的地球建模和右边的面板的内容都是可以改变的,最初 Gemini 3 让右边的面板显示人体体温(显然是凭空编的),后来被我改成了「实时显示左侧地球模型的直径」。反正 vibe coding 一下,想怎么改怎么改。

Jarvis 都有了,惊天魔盗团不也得安排上。

看电影时只有特效,但现在,有 Gemini 3 了。参考 prompt 如下:

用 HTML+JS+ML 模型做个网页应用,通过摄像头检测手势,实现用手势来控制雨滴动画的暂停、静止和升格效果。动画效果保持在雨滴垂直方向,风格参考电影《惊天魔盗团》

这个 prompt 的第一轮表述完全是按照我看电影之后的想法写的,每个细节都可以通过 vibe coding 再调节。根据第一轮 prompt,Gemini 会加入它自己的设计,比如这具体的手势就是它想出来的。

虽然是用 AI 做的,但是在识别手势动作时非常灵敏,包括不同手势之间的切换都能够快速响应。

控制雨滴曾经是非常复杂的特效技术,就在《惊天魔盗团 2》上映之后,有一个饮料公司做了一支广告,通过控制雨滴,实现静态的粒子效果。

那么参考「控雨术」,Gemini 完全可以实现上面这种结合实拍和速度控制才能出现的效果,最接近的就是 3D 粒子。所以我又做了一个 3D 粒子效果的交互案例。

非常酷炫!prompt 参考如下:

用 Three.js 创建一个实时交互的 3D 粒子系统。通过摄像头检测双手张合控制粒子群的缩放与扩散,提供 UI 面板可选择爱心/花朵/土星/佛像/烟花等模型,支持颜色选择器调整粒子颜色,粒子需实时响应手势变化。界面简洁现代,包含全屏控制按钮

一次成型,最后出来的交互非常丝滑,尤其是对于手势的识别很准确又灵敏。

【小技巧】

涉及到颜色、布局、UI 设计等等细节,如果每次都用 vibe coding 的方式来调节,表述起来会很麻烦。并且每一次 vibe code 都存在抽卡的情况,所以有一个非常实用的技巧是:加上自定义模块,尤其是颜色、大小等,这样可以完全自主搭配自己喜欢的配色方案。

由雨滴想到粒子,由粒子想到移动,由移动想到——五子棋!我终于可以做技能五子棋了!!

仔细想想,五子棋不也是一个手势控制、飞来飞去的交互方式吗!飞沙走石移动棋子,力拔山兮移动棋盘,全都安排上!

Prompt 参考如下:

做一个手势互动小游戏「技能五子棋」:主页面为五子棋棋盘,默认已经摆放好棋子。当用户做出「单手甩手」的动作时,棋子会跟随甩动的方向飞出棋盘。当用户做出「双手甩动」的动作时,棋盘会跟随甩动方向飞动

Gemini 自己完成了物理逻辑和手势之间的衔接,我的 prompt 只需要描述效果,而具体的速度向量计算、检测阈值,都不用我管。

它甚至还重新命名了「技能」:万象天引。

这叫飞沙走石啊 Gemini 老师!

综合上面的几个尝试,Gemini 的毋庸置疑,而且回想一下这些技能树:手势识别、色彩变化,这些组合起来,不就是小游戏吗?

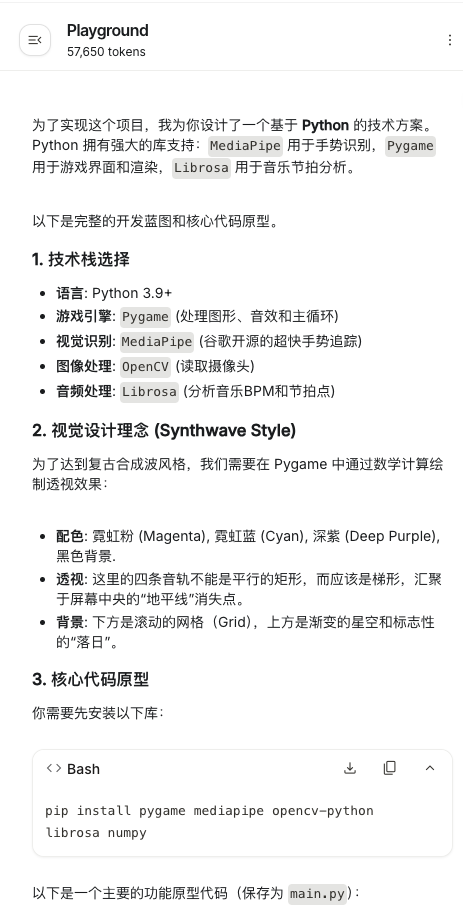

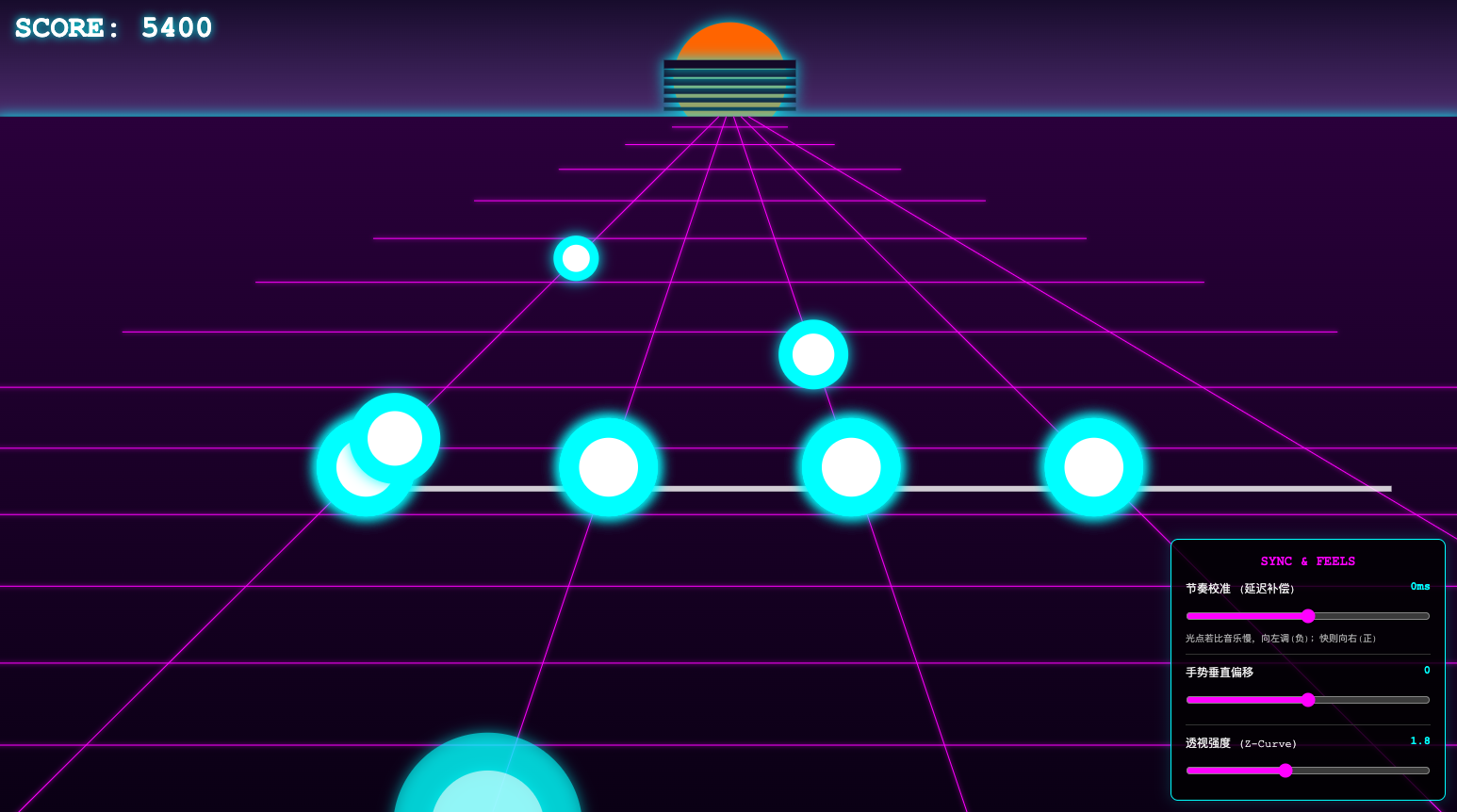

于是我尝试了更复杂一点的项目:节奏游戏。

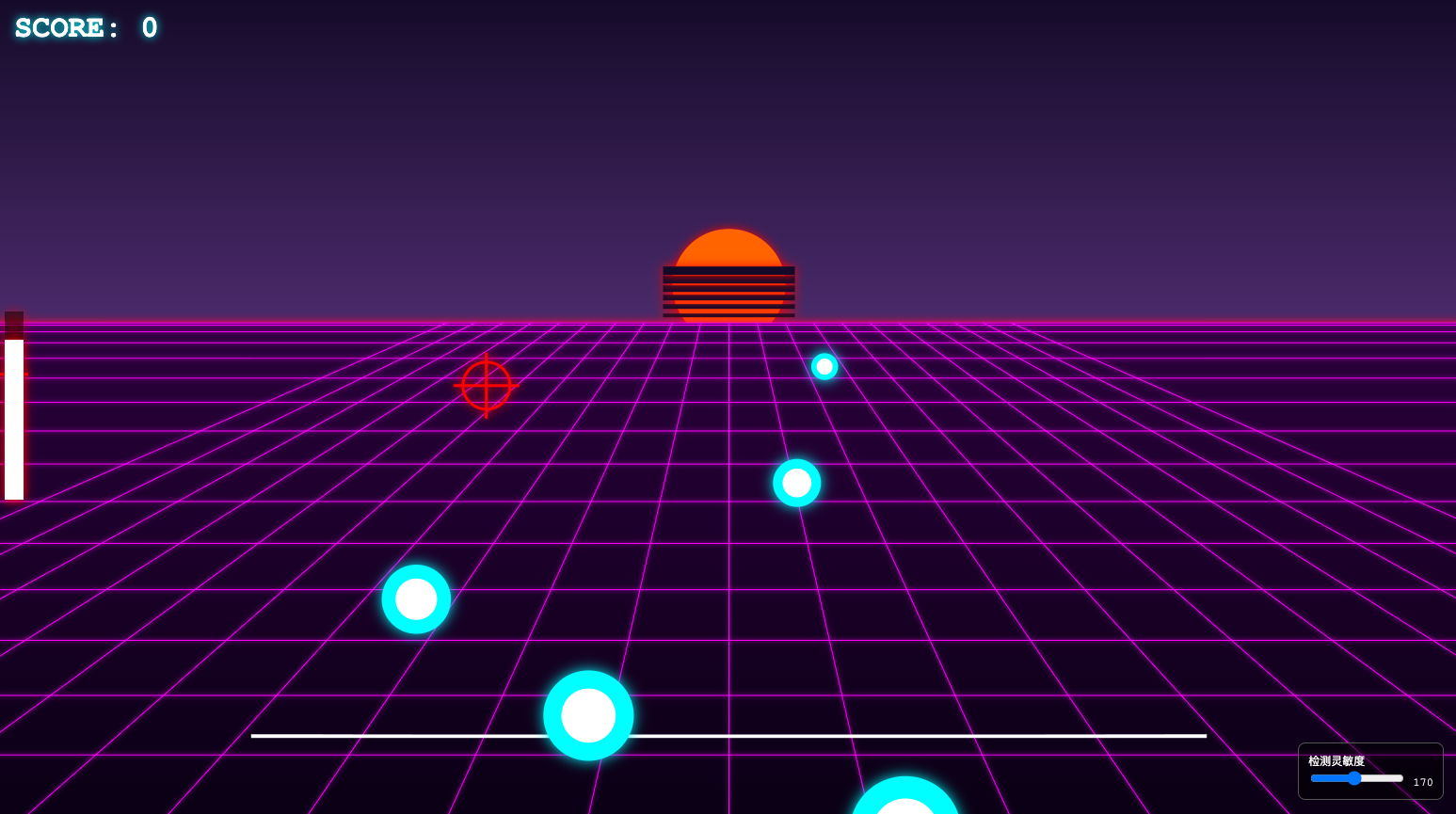

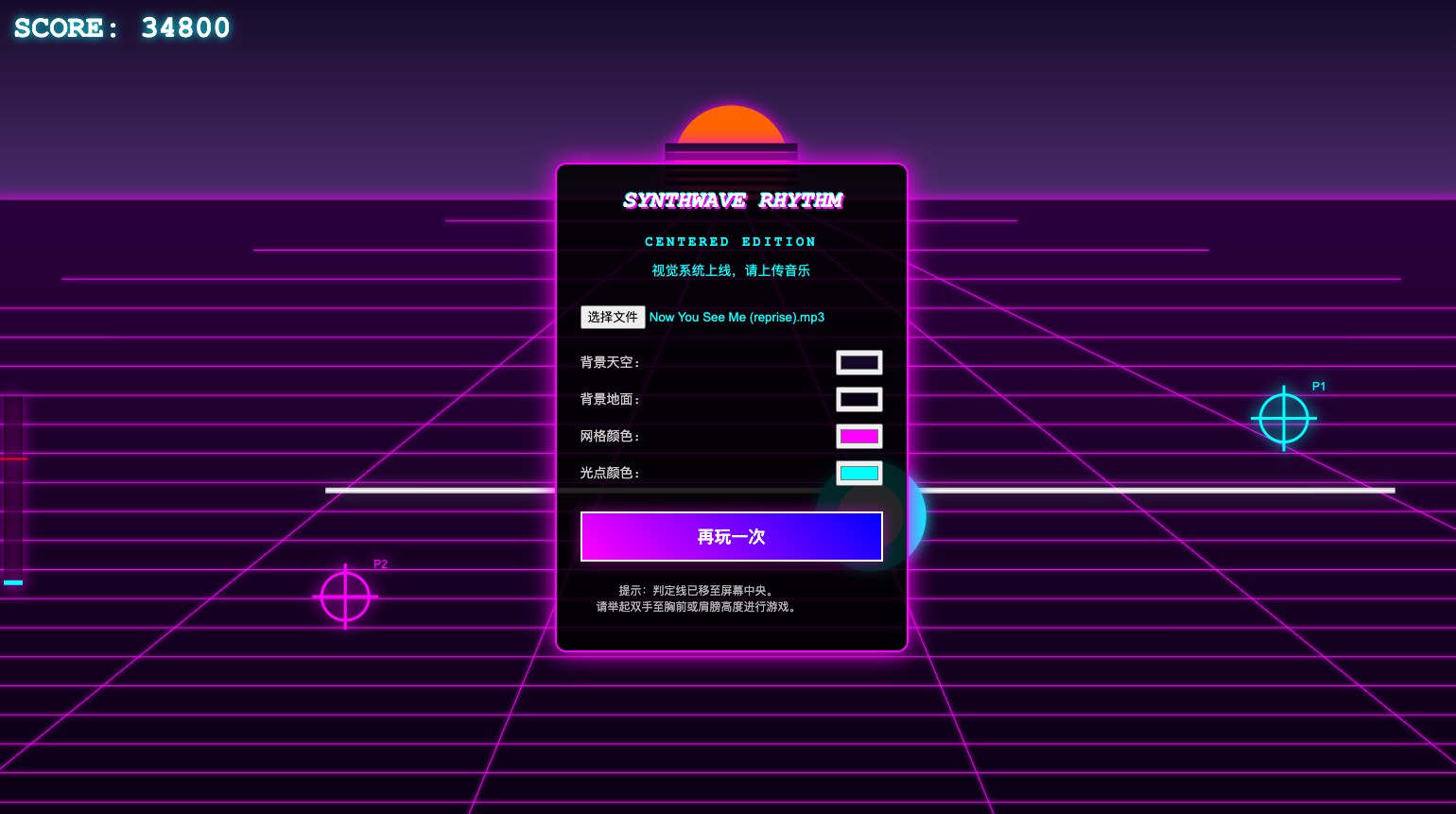

音游玩过很多了,但是零经验小白真要做一个游戏、怎么给 Gemini 形容我想达到的效果,还真是花了一点脑筋 ,后来第一版 prompt 如下:

做一个用手势操控的音乐游戏,主界面为四条音轨,用户上传音乐文件后,四条音轨上按节拍出现光点,用户需要用手势准确拍击出现的光点,背景为复古合成波(Synthwave)风格,背景、音轨和光点的颜色可以自定义调节

这基本上是我能想到的雏形,根据第一版 prompt,Gemini 选择了 Pygame 作为游戏引擎,继续使用 MediaPipe 做手势追踪,并且加入了 Librosa 用来分析音乐。

选择复古合成波风格是因为它有明确的视觉标志——Gemini 也识别出来了——落日、霓虹渐变色、网格和驶向地平线的道路,非常适合节奏音游。

果然做游戏比前面的一些小交互复杂多了……先是只能识别一只手,得调整;然后是无法上传音乐,得调整;到了第三版才稍稍有点样子

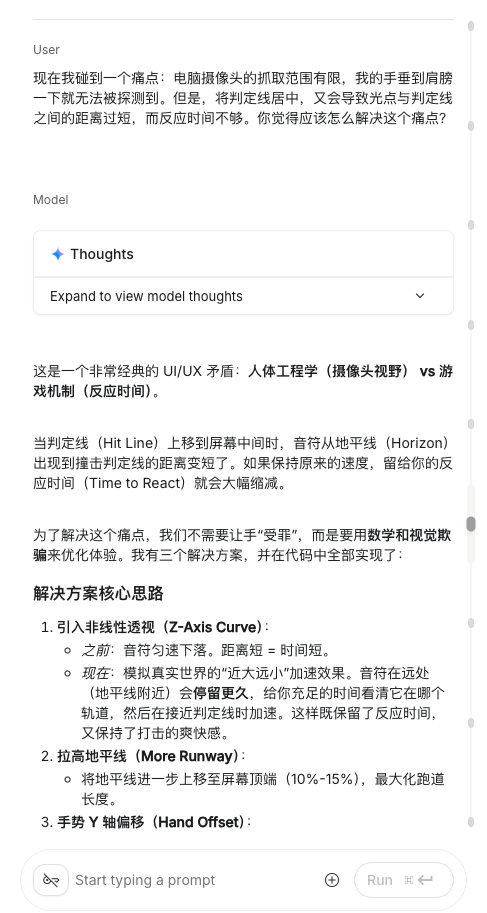

但是在体验过中我发现一个比较 bug 的地方:判定线的位置离屏幕边缘太近了,而摄像头的识别范围是有限的,我的手稍微放低一点就无法被识别。

一开始我尝试的方法是,把判定线移动到屏幕居中位置,保证我的手始终能在摄像头捕捉范围内。

但是又出来一个问题:光点出口和判定线之间的距离过短,留给我的反应时间也很短,更别提点击动作还有一点点点的延迟,整个可玩性大大下降。可是放太低就还是会出现手掉出识别范围的情况。

一时之间我还真想不到这个矛盾该怎么办,于是,我直接去问了 Gemini 能怎么解决。

它直接指出了这个问题的症结所在,并且提出了「视觉欺骗」的方式来优化体验,并且加了一个自定义滑块来调节偏移,这样一来无论手在什么位置,都可以通过调节滑块来对齐判定线。

天才。

后来我还指出,感觉光点的出现跟节奏不太一致,为了解决这个问题,Gemini 又加了一个滑块用来调节延迟。虽然我仍然认为它并没有很好地分析节奏型,但是这个滑块的设计还是很有效,尤其是解决了戴着蓝牙耳机导致的延迟。

【一些小技巧】

本质上,只要有 prompt 就有抽卡的情况存在,但抽卡未必就不好。当碰到非常硬伤的 bug,比如始终无法调用摄像头、无法上传文件等等,vibe coding 时反复修改也没效果,不如就直接「新建项目」。核心功能反映在代码上,彼此之间有所牵连,重新跑一遍,让 AI 整体性地补足,远比一点点 vibe coding 要更有效率。当然,能看懂代码就会更有效率,可以针对性地解决。 只不过,对于完全的零码选手来说,还不如直接重新抽卡。

在 AI 之前,做手势交互的应用,得先学点儿 Touch Designer,最好还懂点儿部署。这些都得一点点翻教程,反复研究,在这个过程中搞不好就被劝退了。

有了 AI 之后有多简单,自然不用多说。更关键的是,手势交互原本的门槛远比生图、做 PPT 要更复杂,却又能让小白零码选手快速领略到做应用的乐趣。

唯一留下的,是对审美的挑战。在这些案例里能看到,Gemini 有点审美,但不多,设计、配色等等都是差强人意。代码的「硬」技能它可以掌握,留给我们的,就是对于审美的挑战。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

说实话, AI 生图工具有时候真的让人又爱又恨。

刚认识的时候(第一次生成),你会觉得它惊为天人,哪哪都好;可一旦你想跟它深入发展(做成系列图、落地进工作流),它就开始「掉链子」,陷入抽卡玄学。

这种「只能看不能打」的状态,真拿它干活就会无比「拧巴」,在 Nano Banana 这样的工具出现后,事情终于开始改变,原来 AI 是可以被更精确控制的。

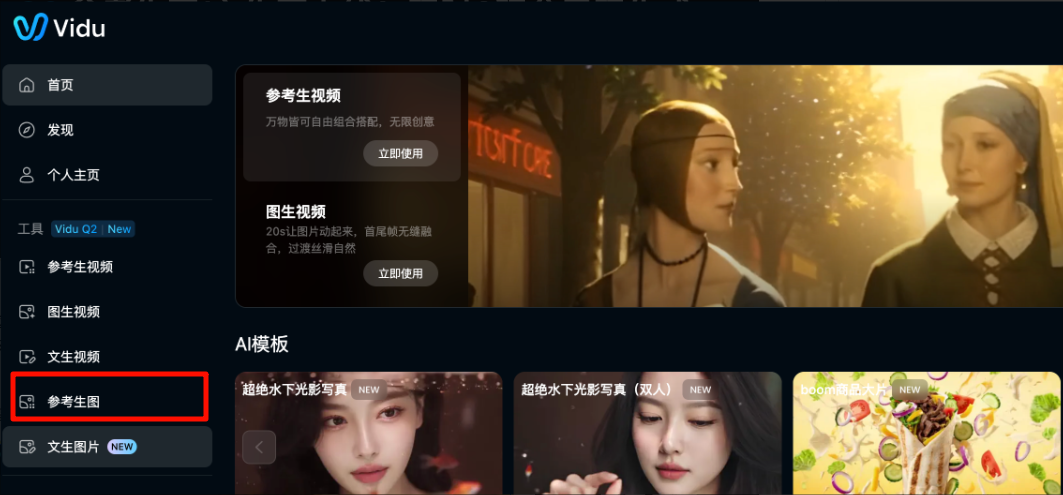

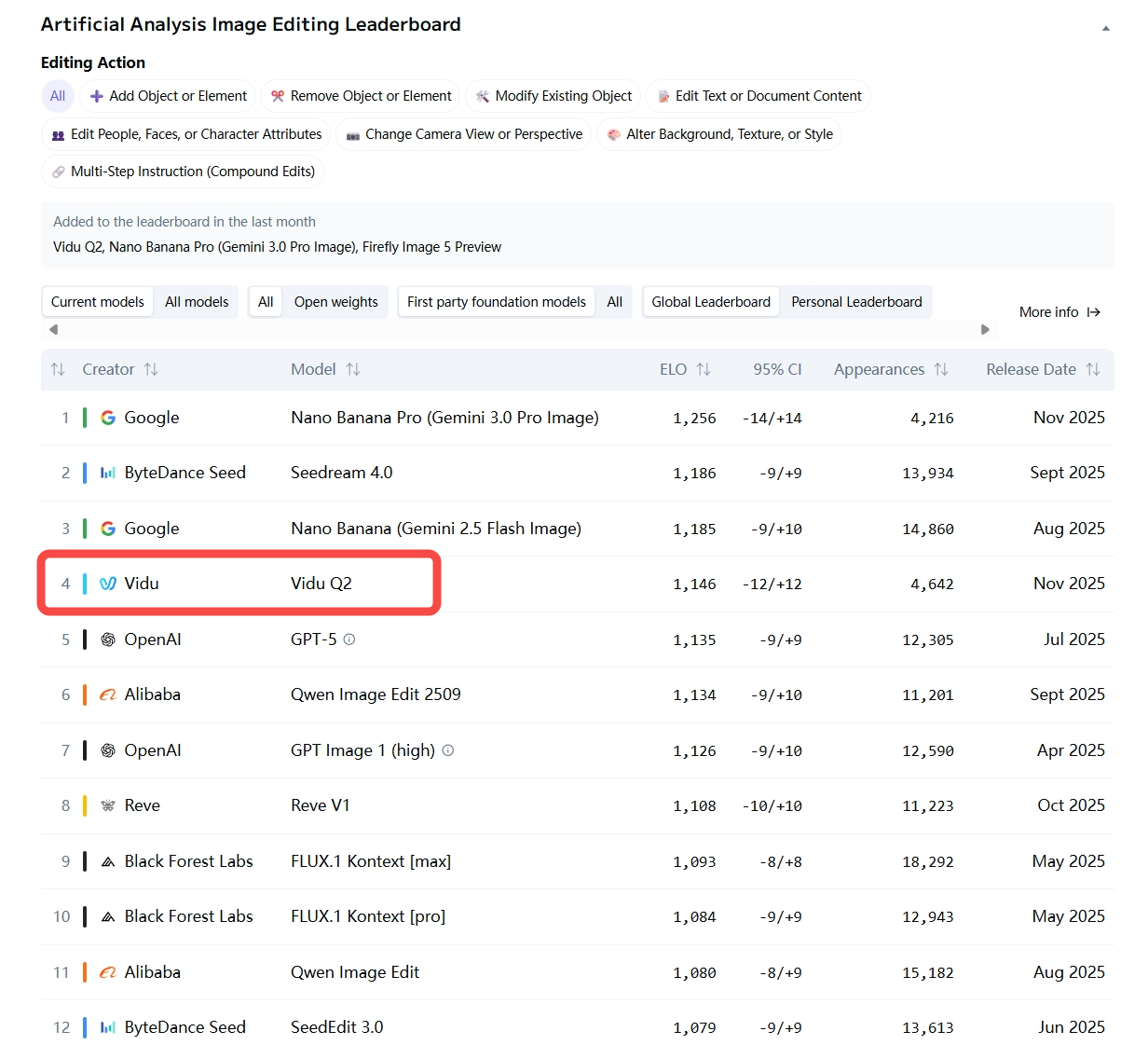

现在,终于也有国产 AI 接力,进一步把这条路跑通。Vidu Q2 最新上线的文生图、参考生图、图像编辑功能就是这个路子:卷完「好看」,它开始死磕「稳定性」。

这次 Vidu Q2 直接把技能点全加在了「一致性」上。什么概念?就是把「人设崩坏」、「产品变形」、「画风突变」这些老大难问题统统按在地上摩擦。

简单说,它不只是想让你发个朋友圈炫技,而是真想让你拥有一套能「从头用到尾」的实用创作流。

在最新的 AA 榜单里,Vidu Q2 首次上线的图像编辑能力甚至超越了 OpenAI 的 GPT-5,最难能可贵的是,作为成立才 2 年多的创业公司,用技术实力说话,跟 Google、字节这种大厂并列前三,追赶 Nana Banana Pro,直接把「省心」两个字拿捏了。

Vidu 还搞了一个长达 1 个月的「免费大礼包」,敞开大门让大家薅羊毛。即日起至 12 月 31 日,Vidu 会员生图「免费」,无论是参考生图、文生图还是图像编辑,统统随便造。标准版和专业版会员每月也有 300 张免费额度,旗舰版更是免费无限生图。

今天我们就趁着这个「无限续杯」的机会,拿 Vidu Q2 的生图功能狠狠考验一下,看看它到底能不能拯救我们的发际线。

Vidu 在一众 AI 工具中,是最早就把「围绕一张图持续参考创作」当成核心能力来打磨的。在国内多参生图中支持的输入图数量最多,一致性也最高。

在最近 Vidu Q2 的更新里,这项能力又被往前推了一大步:不仅支持更复杂的多参考组合,还大幅降低了生图门槛——设计师、导演、甚至是喜欢创作的普通用户,都可以用自己熟悉的方式提供主体图和环境参考,由模型一键复刻动作、位置、布局、纹理、光线、色彩等,自动去「对齐要求参考图、保持角色不变」。

在多参生图场景下,我们给 Vidu Q2 参考生图的输入非常接近真实工作流:一张是最近的全运会「顶流」大湾鸡,另一张是希望出现的场景氛围,夕阳下外滩的观景台。

然后我就写了一句简短的提示词,剩下的全交给它。

结果出来,我直接「瑞思拜」。

它不是那种傻瓜式的把主体抠图贴上去,而是真的在这个场景里「重算」了光影。主体的光影方向会跟环境一致,动作也随着指令准确变化。

甚至我让它变成喷绘印在汽车上,连车身上的倒影色彩都给你算得明明白白。

更关键的是,多次生成不同构图和姿势时,许多都能保持高度一致,比如大湾鸡胸前的图案、头顶的彩色冠,这一点在传统靠 prompt 调参的生图流程里往往很难做到。

这就很灵性了。对于品牌方来说,以前要把一个 IP 形象放到不同场景里做海报,得建模、渲染、P 图,现在?几秒钟搞定,而且那种「违和感」完全消失了。

更绝的是 Vidu 对空间关系的理解能力,当我要求「大湾鸡穿梭在故宫雕花栏杆中」时,Vidu 并没有像其他 AI 那样跟栏杆穿模,或者变成恐怖片现场。

它居然先根据环境图「脑补」了故宫的空间结构,让大湾鸡自然地走在走廊空间中。

再来上个难度,让 AI 角色参考复杂武打动作。

过去 AI 角色无法准确还原你设计的复杂动作,不是动作变形就是人物在打斗过程中变了一个人。而现在通过 Vidu Q2 参考生图则解了 AI 创作者的燃眉之急,可以一键复刻动作,让你的 AI 主角也能拥有十八般武艺。

如下面的案例中,两个动漫主角精准还原了图 1 中的打斗姿势,同时人物服装、面部细节、空间位置关系都保持了极高的一致性。

这种对「空间」的理解,让参考生图不再只是贴背景,而是真正具备了为分镜、镜头调度服务的能力。

这种对空间的理解力,用来做电影分镜或者像最近很火的《疯狂动物城 2》那种合影海报,简直不要太好用。

比如下面的案例,同一张图+不同镜头提示词,即可生成足球少年踢球的特写、远景、足球特写等,并通过图生视频,剪辑为一个完整的叙事镜头。对于短剧动漫影视制作,省去了一个画面需要多次拍摄或者绘制大量分镜的环节,妥妥的生产力提效工具。

再通过 Vidu Q2 图生视频功能,输出两人在足球场上抢球的精彩视频:

在风格一致性方面,传统 AI 文生图功能想象力很好但是往往一致性表现很差,风格前后不一致、人物融合的情况屡见不鲜,而 Vidu Q2 不仅支持上百种动漫风格,而且还能在生成的连续多图中保持风格的一致性和故事的连贯性。

比如让 Vidu Q2 文生图几句话生成四格漫画,不仅风格、人物保持前后一致,细节稳定,而且几句话让它一次性拉出完整故事:

从这些案例可以看到,Vidu 在参考生图上的升级,并不是停留在「把图生得像」这一层,而是把「主体一致性」和「空间理解」一起纳入考量:一方面,它能围绕参考图,稳定地生成人物不同角度、不同氛围、不同风格、光线下的一整套画面;另一方面,又能把环境图当成真实空间来处理,而不是简单的背景贴图。

如果说参考生图解决的是「第一张图怎么定」,那 Vidu Q2 全新上线的图像编辑则真正让这张图进入日常工作流,实现更加精细化的画面控制,满足实际商业化场景需求。

Vidu 在这一块的定位很直接:覆盖 90%的常见图片编辑场景——加元素、减元素、换背景、换颜色、调光线、变焦、比例切换,都可以用自然语言完成,在连续修改的过程中又始终保持主体的一致性。

在替换与局部编辑的测试里,我试着把一张车站广告换成马斯克,要是以前,我得抠图抠到眼瞎,但现在就几秒就能搞定,直接一键复刻。

以后看到爆款广告、爆款封面,可以像这样大批量一键复刻,4K 直出,直接上架,做广告、社媒不要太轻松。

类似的,下面的案例里,要求是为三个女孩加上酒杯——Q2 不仅完成了该要求,还根据光线涉及了酒杯的折射,完善了三个人的手部细节。

图片编辑是真正的「实战型」能力,尤其是电商或者社媒营销这样的场景。很多产品图的前期其实只有一个简单线稿:设计师给的是草图,运营要的是立刻就能上架的主图。

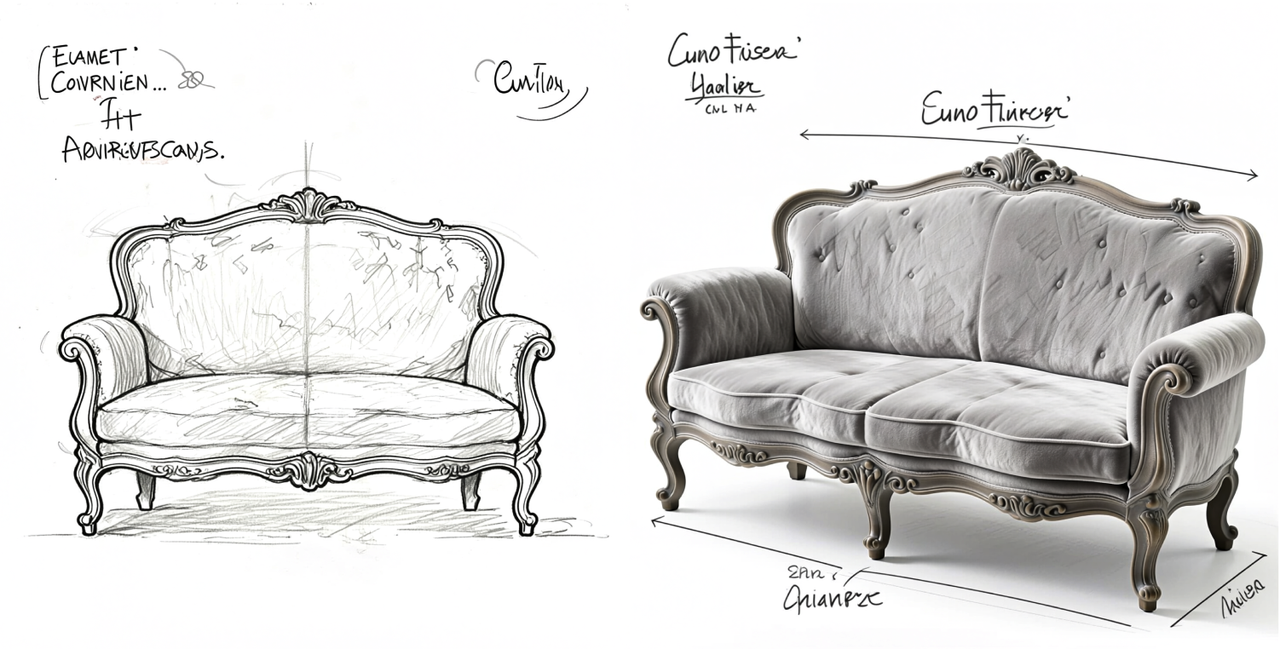

这就是图片编辑可以大展拳脚的时候,我们用 Vidu 做了一次完整的草图 → 上色 → 材质替换的演练。先是生成了家具的线稿图,然后直接一键用于参考生图,在 prompt 中指定好材料和风格。

Vidu 通过材质渲染,一步到位,做出细节满满又准确的实物图。紧接着还是一键复用,变换家居风格的提示词,沙发在不同家居风格的实景展示就出来了。

同一商品想要变换材质,也可以轻松实现。

可以发现,Vidu Q2 在图像编辑上的能力,其实正是把「多参生图时代的底层能力」落到了实处:识别谁是画面里的主体,把他/她/它锁定住,然后允许你用大白话对其周围的一切做增删改,甚至跨越多张图和一段视频。

这就好比以前你是开手动挡得调各种参数,现在 Vidu 给你整了个自动驾驶。你只需要把心思花在创意上,剩下的粗活累活,它全包了。

这里面还涉及到另一个非常有用的能力:保存主体。我们可以将上述 Q2 文生图/参考生图/图像编辑后的图片一键保存为主体,把这个 IP「收进了角色库」,后续在 Vidu 的参考生视频中,都可以直接调用主体。

之后无论是换背景、换动作,还是把他/她放进新场景,只要选中这个角色、IP,模型都会严格保持人物一致,不会出现下一秒生成的主角和前一秒不一样的情况。

参考生图——保存主体——参考生视频,Vidu 打通了从灵感到成片的一站式工作流,再也不用在不同平台来回切换了,简直是短剧动漫,广告电商从业者的福音,目前 API 已同步上线。

对于创作者来说,以前用 AI 干活儿是一种怎么样的体验?大概就是痛并快乐着:上一秒它给了你一张惊为天人的神图,下一秒让你在接下来的十小时里,因为复现不出那个眼神而心态崩盘。

在 AI 创作工具演进的十字路口上,我们观察到了两种不同的产品哲学。

Midjourney 这类产品像一台性能强劲的「引擎」,只有硬核极客才能驾驭那些复杂的参数和咒语般的 prompt,试图把单张图片的审美上限推到极致。

够酷,够极客,但也够折磨人。

而 Vidu Q2 选择了一条更务实、甚至看似「无聊」的路——做一台谁都能开的「量产车」。它不再执着于制造随机的惊喜,而是死磕「稳」字。

这种把所有步骤都帮你封装好的「傻瓜式」链路,才是真正的生产力。毕竟,对于那些被甲方催着改稿、被运营催着上线的团队来说,比起灵机一动的「随机性」,更加需要可交付的「确定性」。

也许在某些极端艺术风格的探索上,它或许不如那些参数党工具来得狂野自由,甚至因为太追求稳定,少了一些「意外之喜」的灵气。

但对于那些对于深受「抽卡」折磨的创作者,Vidu Q2 提供了一种久违的安全感。

当行业在谈论 AGI 的宏大叙事时,Vidu 低下头,不再只是给你造虚无缥缈的梦,先帮你把手里的砖搬稳了。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

「看起来很普通」,这句话对智能眼镜来说却是很高的评价,而这正是夸克 AI 眼镜最亮眼的地方。

就在昨天,阿里旗下的夸克正式发布了 S1 和 G1 两个系列共六款 AI 眼镜,起步价分别为 3799 元和 1899 元。我体验的是带显示的旗舰款 S1,而它给我的第一印象是:这可能是目前最接近普通眼镜的智能眼镜。

智能眼镜的痛点一直是镜腿的宽度。不同于市面上其它智能眼镜「宽腿粗框」的外形,夸克 AI 眼镜最独特的地方就是超细镜腿——从侧面看,它的镜腿只有 7.5mm 宽,是全球同类产品中最窄的,戴起来就和普通的眼镜框没有什么区别。

为了把镜腿做得更细,眼镜的电池被安排在了镜腿尾部,左右腿各一个。调整眼镜重心的同时,右侧的电池还被巧妙地设计成了可插拔的「换电」功能,日常使用中能够快速地延长续航时间。

超细镜腿压缩了显示光机的空间,但夸克还是通过定制方案实现了双目双光机,亮度最高可达 4000nits,实测在户外确实清晰可见。比较特别的是合像距可调节功能,可以在手机 App 中自定义不同功能界面的「显示距离」。

系统也为不同功能设定了不同的默认距离,例如需要和人面对面交流的「翻译」界面就设定在 2m,需要留意路况的「导航」就设定在 9m,不仅能降低眼球的压力,也能保障出行安全。

说实话,我对于这款眼镜的画质预期并不高,目前的智能眼镜囿于体积和功耗限制,很难做到显示和拍摄两头都强。但实际用下来,它有挺多亮眼的表现。

光线充足的情况下能实现快速抓拍,日间的画质表现稳定,夜景照片经过和手机上类似的 RAW 域处理后也能获得低噪且色彩还原度很高的画质。

除了能直出 1080P 和 3K 两种分辨率的视频以外,防抖效果也很让我惊喜,骑行画面没有大幅度起伏,也没有防抖处理的残影。值得一提的是,配套 App 内为视频提供「AI 超分」、「AI 插帧」和「防抖」的后处理功能,最高能将视频提升至 4K@60fps 的规格。在硬件已经使出浑身解数以后,通过软件优化,也不失为一种好思路。

同样属于 AI 方面的功能还有眼镜里搭载的阿里千问闭源模型,借助五麦克风阵列和骨传导技术,夸克 AI 眼镜能在嘈杂环境里准确拾音并很快地给出响应,除了常规的语音问答和调节眼镜本身的显示和声音以外,还能直接在眼镜端发起导航,或者拍照搜同款识别价格。

由于同属阿里系,夸克 AI 眼镜与淘宝、支付宝、高德等应用的整合较为深入。眼镜内的「识价」功能可以直接识别商品并显示淘宝同款价格,手机端使用高德地图发起导航能直接在眼镜中投屏显示,支付宝的「看一下支付」也终于是迎来了第一方设备的支持。

除此之外还整合了高德打车、飞猪旅行、阿里商旅、航班/高铁管家中的行程信息,直接通过眼镜画面进行实时通知。眼镜内的听歌功能打通了网易云及 QQ 音乐的会员曲库,还能在眼睛前直接显示滚动歌词。

夸克 AI 眼镜 S1 在设计上取得了明显进步,7.5mm 的镜腿让智能眼镜真正接近了普通眼镜的佩戴感和外观,显示效果和 AI 功能完成度较高,阿里生态的整合带来了显著的差异化优势。

智能眼镜本就是消费电子行业最大的趋势,而在人工智能、手机数码、传统视光等多个领域的玩家纷纷入局以后,这个趋势可能会比预期要来得更快一些。目前来看,夸克 AI 眼镜 S1,这份阿里交出的第一份答卷,表现着实亮眼。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

过去一个周末 Gemini 3 Pro Image 的能力被反复「折磨」,花样越来越多——噢,你问这是什么,它的另一个名字是 Nano Banana 2。这么跟个恶搞一样的名字,居然被保留下来了。

Nano Banana2 各方面能力超群,甚至是「友商」Sam Altman 也要点头的程度。

▲ 图片来自:The Information

夸夸只是夸夸,Nano Banana 第二阶段,其实标志着 AI 图像生成领域的一个重要转折点:从基于概率的「以此类推」,转向了基于理解的「逻辑构建」。更承载着一个特殊的意义:AI 不再只是冲着你的眼睛去,还冲着你的智商去。

一直以来 AI 生图都有个绕不过去的问题:才华横溢,信手拈来,但有时候就跟喝高了一样控制不住,这从 Midjourney 时期就开始了,往后走逐渐好转,不过始终存在。

其中最大的 bug 之一就是文字。这导致在很长一段时间里,鉴别一张图是否由 AI 生成,最简单的办法就是看图里的字。

这是基于扩散模型(Diffusion Model)的先天缺陷:它将文字视为一种纹理,而非符号。

Nano Banana 2 最直观的突破,就在于它「识字」了。即所谓的 Text Rendering 文字渲染。

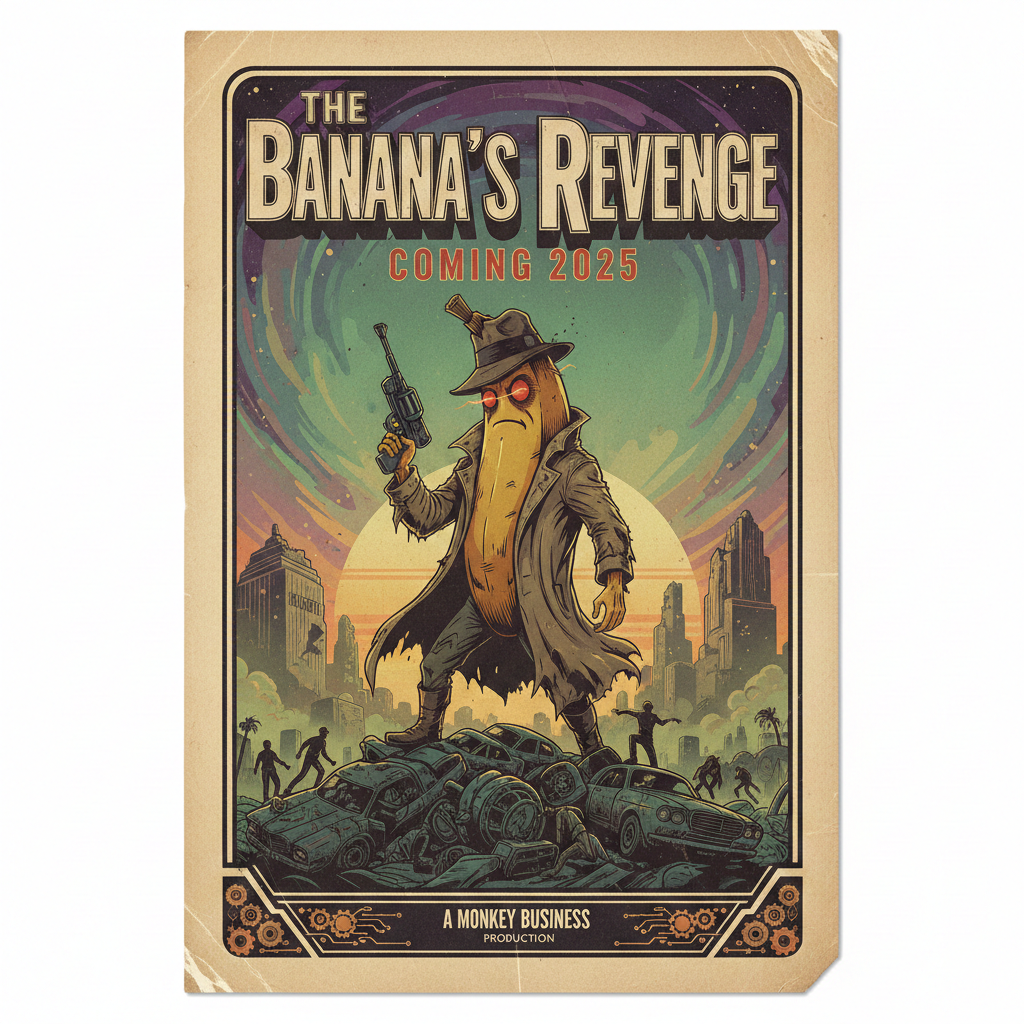

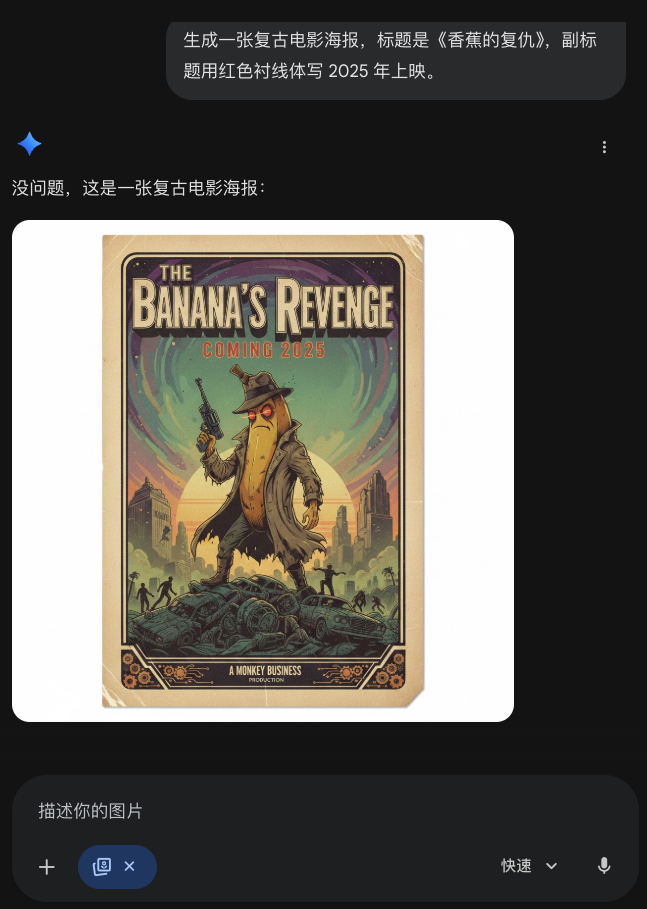

我的随手测试「生成一张复古电影海报,标题是《香蕉的复仇》,副标题用红色衬线体写 2025 年上映。」

如果是在以前尝试这个指令,大概率会得到一张极具艺术感的图「BANANA REVENGE」的某种变体尚且能保持清晰和正常,但小字往往经不住看了,甚至有时候主标题都会拼写成「BANNANA」。但在 Nano Banana 2 里,这些字符被准确、清晰、且符合排版美学地「写」在了画面上。

So what?这仅仅是省去加字的时间吗?

对普通用户来说可能是,而且还是一种「表情包自由」。你终于可以生成一张精准吐槽老板的图,配上精准的文案,不用再单独拉一个文本框。

而对于商业世界,这意味着 AI 图像生成从「素材(Material)」阶段,正式跨入了「成品」(Deliverable)阶段。

▲ 图片来自 X 用户@chumsdock

当 AI 能够准确地处理符号信息,它能交付的成果就更多样也更实用,包括但不限于电商海报、PPT 配图、甚至是数据图表。以前设计师用 AI 只能生成背景底图,关键信息还得自己贴。现在,AI 可以直接生成原型图,乃至带有数据标注的饼状图,或者一张文字完美贴合透视关系的广告。

这是商业交付的「最后一公里」,也是生图模型在信息传递层面的巨大进步。

字渲染的成功是 Nano Banana 2 底层技术跃迁的一个极具代表性的缩影,更深层的变化在于:这只「香蕉」,长了脑子。

也就是我们所说的基于「推理」的图像生成。

大模型本质上是一个概率统计机器。当你要求画一只「坐在玻璃桌上的猫」时,模型通过学习数亿张图片,在生成时,它只是重现像素的统计规律。

Nano Banana 2 的不同之处在于,它引入了 Gemini 3 语言模型的推理能力。在生成图像之前,它似乎先在「大脑」里构建了一个物理模型。它知道「猫」下面通常会有模糊的影子,以及玻璃板上、下的物品有不同的光线关系。

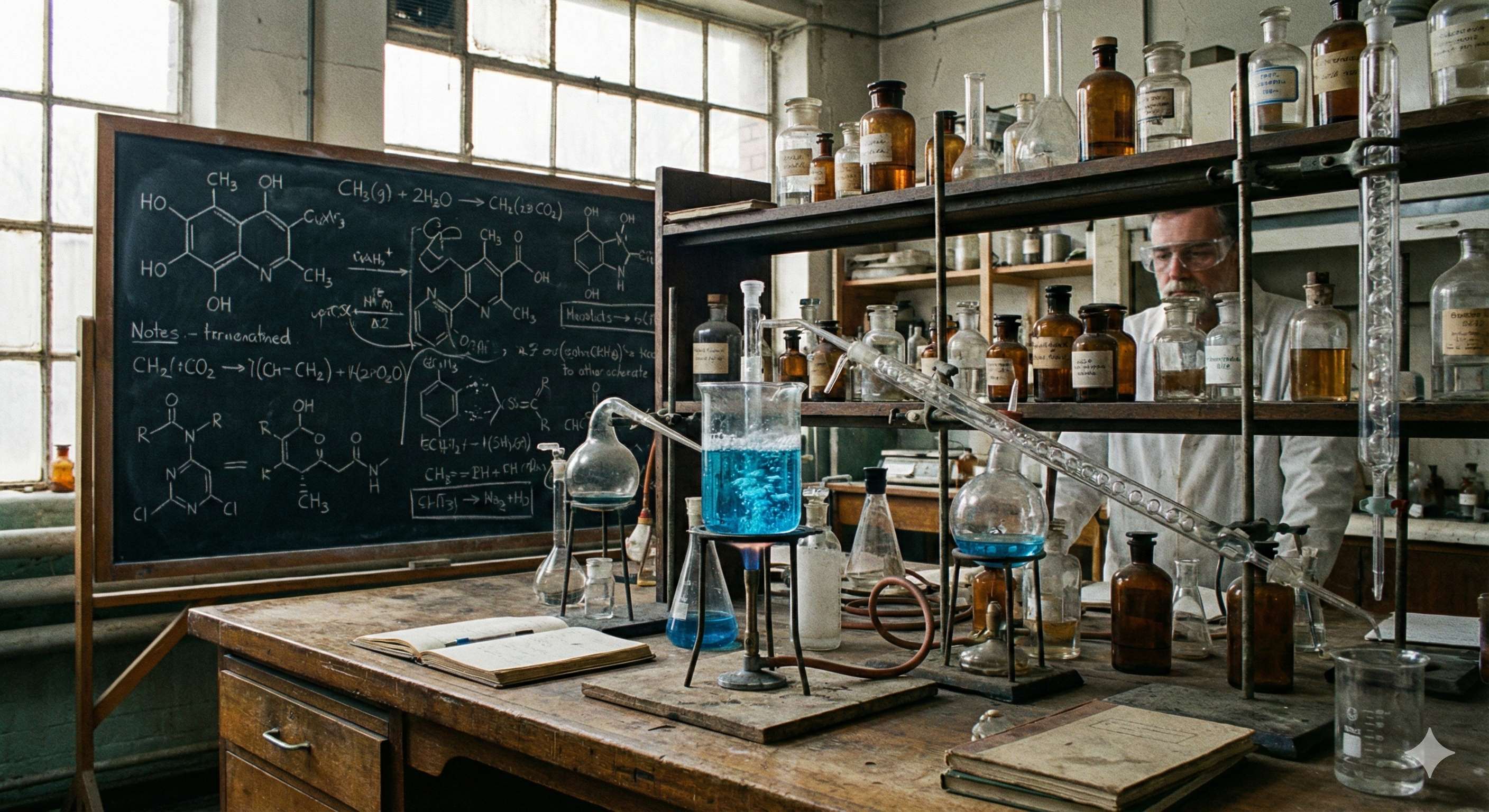

在我的另一个随手测试中,当要求它生成「一个复杂的化学实验室,桌子上放着装有蓝色液体的烧杯,背景是黑板上的分子式」时,它表现出了惊人的逻辑性:

烧杯里的液体会有正确的弯液面;玻璃器皿对光线的折射符合物理直觉;最重要的是,背景黑板上的分子式不再是乱画的线条,而是看上去像模像样化学结构的式子(虽然还是有瑕疵)。

之所以如此强调文字生成这个本领,是因为 Text Rendering 是外在表现,反映的是 Reasoning 作为内在引擎。合在一起, Nano Banana 2 带给用户的最终体验,就是一块「会思考的画布」(The Thinking Canvas)。

Google 将这个模型深度整合进了它的生态系统,不仅仅是生成图片,更是「修改」现实,下一步,就是走进更严肃的领域:信息图、教案、讲解素材,等等等等。

整体上,图像生成往往用户给 20% 的指令,剩下 80% 靠 AI 脑补——以前是靠概率脑补(随机填色)。现在则是靠因果脑补,不仅画出了「结果」,还隐含了「过程」,这能够让画面的叙事性和感染力指数级上升。

它不再只是为了取悦你的眼睛,它开始试图取悦你的智商。像上面这种结构图,虽然吧不敢说 100% 符合机械工程标准,但钉是钉,铆是铆。「逻辑上的正确」,是它推理能力的直接体现。

然而任何事情都是一体两面的,当换一个角度看,这就可能意味着创造力的同质化。

当 AI 能够完美地生成「符合商业标准」的图表、海报和插画时,它实际上是在拉平审美的平均线。所有的海报都排版正确、光影完美,但可能也因此失去了曾经设计中那些因为「不完美」而诞生的神来之笔。

▲ 图片来自X用户@dotey

更深层的问题在于真相的消逝。当上面所说的那种逻辑正确、信息「干货」多的内容,可以被批量生产,取悦智商从未如此容易,也从未如此轻飘飘。如果它决定了我从图片信息到文字信息的所有摄入,那……会是怎样的景象?

还有 Deepfake 这个老大难问题,已经是老生常谈了。虽然这次 Google 加上了 SynthID(一种人眼不可见的数字水印)来标记 AI 内容,但在视觉冲击力面前,技术的防伪标签往往是苍白的。制造「真实」变得如此廉价和便捷,我们对「眼见为实」的信仰将被彻底重构。

至于它叫「Nano Banana」还是「Gemini 3 Pro」,其实已经不重要了。重要的是,从这一刻起,我们在屏幕上看到的每一个像素,每一行文字,都可能不再来自人类的手指,而是来自机器的思考。

这既令人兴奋,又让人在某些时刻,感到脊背发凉。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

想要在手机放一个 AI 助手,选项不少,但要么像个「高级复读机」,要么是信息的搬运工——天知道,我想要的是一个能真干活的助手,一个除了能说还能动手的「创意合伙人」。

今年你应该也感觉到了,AI 正在从「能聊」变成「能干」。OpenAI 搞了个 Atlas, Google 即将发布的 Gemini 3.0 让 AI 直接操作电脑……大家都在玩同一个方向:让说话变成操作,让对话变成动作。

刚刚,蚂蚁也推出了一个新的全模态通用 AI 助手灵光。它不跟你绕弯子,你开口,它动手——把你脑子里的想法,变成眼前能看、能用、能玩的东西。

灵光的落地页是熟悉的对话窗口,只需要用自然语言发起请求,比如「告诉我这罐饮料的热量」或「记录一下今天的饮食摄入」,极大地降低了上手时的学习成本,也让整个 App 显得比传统应用更流动。

看起来还是像聊天对话啊?其实,跟灵光的每一句对话,对它而言都是一次行动。下面是三个你很可能也会用到的真实例子。

最近因为全运会,广州也享受了一把网红城市的待遇,尤其是广州塔,每天都被游客包围。我问了灵光,「广州塔在建筑设计上有何特别之处?」它返送的不只是文字说明,还带上了一个可交互的 3D 建筑模型。

可以旋转、可以拉近看结构细节,可交互的形式让我清晰直观地感受到了广州塔双面扭转结构、斜交网状外筒的设计语言。

在和灵光的对话中,它不仅能告诉你答案「是什么」,还能让你看到答案「长什么样」。文本、图像、结构动画都整合在一起,整个问答体验,就像在对话里放进了一个实时生成的「解说图文」。不管是建筑专业学生、城市爱好者,甚至只是出于兴趣想多了解这座地标,都能真的省下了你一点点搜索、翻页、拼凑资料的时间。

紧接着,我补充了一个追问「那帮我规划一个附近的美食打卡行程吧」,它马上理解这个「附近」是广州,并直接生成了一张可缩放的交互地图,标注了六七家风格不同的小店,甚至还有「隐藏路线」。每个点位都能点开看推荐理由、评分、营业时间,甚至还顺带估算了步行路线。

惊人,直接在手机上就能生成可以交互的内容展示,放眼整个行业也并不多见。

如果说这两个案例是让人感受到「好看、酷炫」,那接下来要展示的,是灵光的「理性美」。

对于一个优秀的通用 AI 助手来说,一问一答显然是不够的,而是要能实现结构化的输出,也就意味着需要对信息语义的深度理解和再组织——不仅是检索信息,更能提炼信息点,智能理解语义并进行分层。

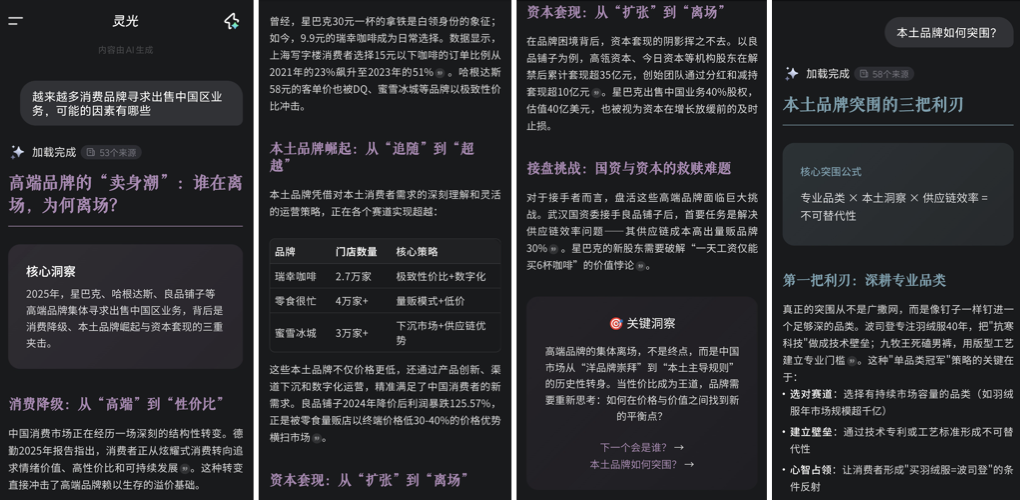

比如,碰到「为什么消费品牌正在出售中国区业务/为什么拟物风格的 UI 设计会退潮?」这些既需要宏观视野,也需要微观分析的问题,灵光的回应方式并不依赖大段大段的文字,而是先拆解出关键因素——如消费市场变化、品牌生命周期、股东压力等——再依此组织内容输出,形成一组因果清晰、逻辑递进的解释结构。

以标题+概括的卡片式风格,镶嵌在一个完整的图文里,可以避免枯燥,又不像 PPT/网页报告那样冗长无重点。这样的结构化输出不仅逻辑清晰,也在视觉上展现出一种「信息美学」:干净、聚焦、节奏舒适,不仅让信息吸收更高效,也模拟了专家型写作者的内容组织方式,让 AI 输出更像一份「讲得通」的深度内容,远不仅是「查得到」的浅层答案。

你可能已经想了一路了:这到底是怎么做到的?为什么能既结构清晰,又视觉友好,还能实时互动?

其实在接收到问题时,灵光会调动一套以代码生成为核心的内容创建流程。无论是图文、地图还是 3D 动画,底层都是由模型即时写出对应代码、样式和组件,再动态拼装呈现出来。要完成这些工作,并不是由一个大模型孤军奋战,而是由多个智能体协作实现:有的负责图像,有的负责布局,有的调取数据结构……像搭积木一样。

既整合不同内容体裁,又能适配常见的内容呈现方式,从而给出极其自然的内容。最终实现的效果,也更适合转发、截图、总结成「朋友圈可用」的内容——既有理性判断,又能传递个人观点和情绪。

如果说对话中能做图、做路线规划已经够神奇,那么接下来的能力接近「魔法」:用键盘敲一句需求,它就能直接帮你把一个小 App 搭好。

用 agent 生成应用,现在处于一个比较尴尬的位置:很多应用总是卡在「能理解、不能执行」的断点上。而灵光的「闪应用」瞄准的就是这个痛点,对话已经超越调用和请求工具的步骤,能够做到直接生成工具。

是的,不是生成一段代码、一个原型、一个建议,而是原地生成一个「即刻能用的工具」。实现想法终于不再是程序员专属的快乐,闪应用可以给每个普通人亲手「造东西」一个起点。

来看看它是怎么让「想法落地」变得这么轻巧的:我给它的第一个任务是,「我想要一个能把长文本拆分成更小段落的工具」。

仅仅 30 秒,一个可以设置段落数、自动分段文件的小工具就出现了,甚至不需要打开新页面,它会将生成结果直接嵌在对话流中,点开即用。

再来一个轻巧又实用的例子:做一个菜单翻译器,这里的要义在于:既能把外语菜名翻译成中文让我知道是什么,又能原样朗读出外语,方便我点菜。

理解文字,生成语言,组织界面,并且用声音反馈——这些能力以前得靠多个组件组合才能实现,可能还需要我详细解释代码逻辑,现在只用一句话,它就全都打包完成。

无论是出国旅行用来点菜,还是练习口语用来熟悉菜名表达,这样的小工具一经生成就能上手,真正做到了「即做即用」。这背后是一套完整的应用构建:不仅能输出前端页面,还能一并调用大模型的后端能力。不仅给你实现了代码,还免费给你上 UI 设计。像翻译、语音合成这些动态模块,全都集成在这个小工具里。

这样一来,生成出来的成品就不只是个 demo,而是真的能与用户实时互动、响应输入,具备完整的前后端逻辑闭环。

与其花时间翻遍整个应用商店,拿闪应用一分钟做一个完全贴合我个人需求的小工具,显然更快也更好。灵活、即时、零门槛。它不是通用解法,而是「为这一次定制」的临时小解决方案,却能激发普通人对「创造」的心理满足感——哪怕不懂开发,也能凭一句自然语言体验「自己做了个小应用」的快乐和分享冲动。

实时视频已经是目前 AI 助手的「标准配置」了,灵光给这个功能起了个相当有创意的名字:开眼。还真挺贴切,不是靠打字输入,而是打开摄像头,如同给 AI 打开了眼睛,接受另一种自然语言:视觉语言。

比如举起手机对准一杯奶茶,屏幕上马上浮现出饮食建议、保存注意事项,还带着几个延展提问,满足你的好奇心:

这个功能在食品药品上非常方便,无论是给自己选,还是给父母买了新产品他们却不认识时,灵光开眼正好能大展身手。

开眼的特点在于,通过流式识别,超越简单的「认得一个东西」,而是变成了能做出响应、展开对话的智能视觉入口。它能理解你此刻潜在的意图,主动发起跟进动作,把一次镜头下的识别。变成一套连贯的行为链条。

比起那些只能识别 Logo 或商品的旧时代 AI 视觉,它明显走得更远了一步:不仅识别是什么,还试图理解你为什么看它、接下来可能需要什么。

也就是说,它把「摄像头」变成了另一个对话渠道,一种通过视觉引导交互的对话,真正意义上的「开眼」:带着「眼睛」展开互动。

语言就是编码,需求就是原型。对话从来不是最终目的,它真正的价值在于:变成生产力的触发器。灵光打破了「提问—回答—再动手」的传统路径,把语言本身变成工具的起点。让「我有个点子」变成「我已经做出来了」之间的路径更短、更直觉。

原本需要懂代码、设计、产品逻辑的人才能做出的 App,现在用一句自然语言就能生成。普通人第一次可以用日常语言直接「生产」一个功能工具、一张内容卡片,或者一段交互流程,「自己做自己的产品经理」。这种从「会说话」到「能造物」的跃迁,标志着生产力门槛的全面打开。

在 AI 行业的下一阶段,拼的早已不只是「谁的模型更强」,而是「谁能把能力转成体验」。年初 DeepSeek 引领了中国在开源模型的浪潮,2025 年快结束了,我们在灵光上看到 AI 交互范式新可能性。它用非常具体的方式,示范了一条关键路径:从底层大模型,到中层工具能力,再到用户侧的应用产品。

这一次,「AI 能做什么」终于从实验室语言,变成了用户能用的日常动词。把「动手做」变成了「开口说」,也把「创造」这件事交还给了每一个人。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

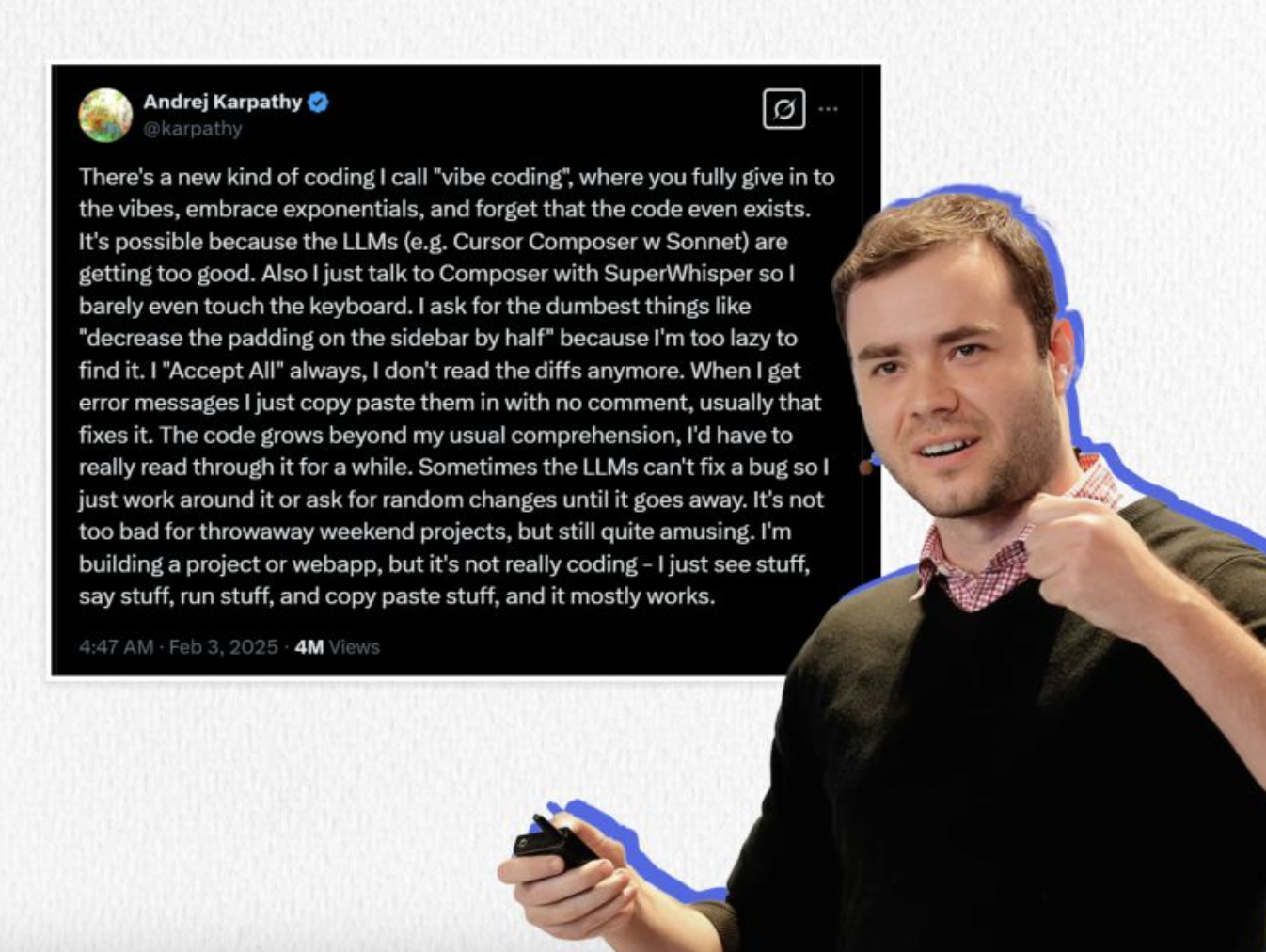

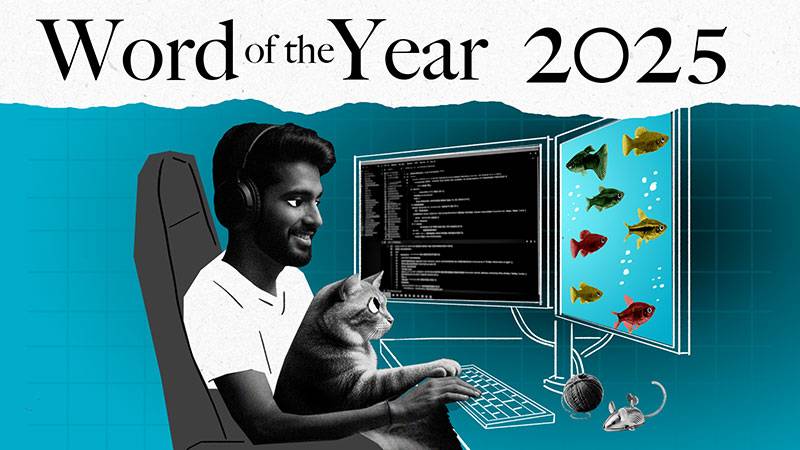

近几年,各大词典评选的年度词汇中,AI 相关的新词异军突起。最新出炉的 2025 年柯林斯词典年度词汇,选择了「vibe coding」,这个今年几乎是最热门的 AI 技术。

如果再往回拨一点,稍早前牛津、韦氏、Dictionary.com 和剑桥等机构发布的一系列热点词,不难发现,AI 已经深刻影响了我们的语言,已然是生活中的高频词。

「Vibe coding」在中文里并没有一个完美的翻译,比较流行的译法是「氛围编程」。这个词最早由特斯拉前 AI 总监、OpenAI 创始工程师 Andrej Karpathy 提出,形象地描述了 AI 能让人们「几乎忘记代码本身存在」也可以开发应用的情景。

不懂编程的用户,用自然语言对话,就生成计算机代码。开发者只需要告诉 AI 自己想要一个什么功能或应用,AI 就能自动生成,实现「凭感觉,写代码」的效果。

「Vibe coding」之所以能够登上 2025 年度词汇宝座,一方面从数据上能看出来——自 2025 年 2 月首次出现以来,这个词在媒体和社交平台上存在感飙升,贯穿了一整年。柯林斯词典的语言学家从包含 240 亿词汇的语料库中捕捉到了这一趋势,认为这个词充分反映了一年来语言的演变。

另一方面,这个选择揭示出 AI 技术在 2025 年的社会文化热度之强:程序员群体在讨论,普通用户也在谈论,「AI 可以帮我写代码」已成为大众认知的一部分。正如柯林斯官方博客所说,这个词「捕捉了我们与科技演变中的某些根本变化」,它不仅在硅谷科技圈内流行,更折射出 AI 作为「超强辅助」,已渗透日常生活的广泛文化转向。

今年的柯林斯 2025 年度词汇候选名单可谓科技味十足。同榜的还有「clanker」,这个词源自《星球大战》,不过,现在它多用于对 AI 聊天机器人的批评,类似于中文语境里说的「人工智障」。

「biohacking」指生物黑客式的自我改造;「broligarchy」调侃科技富豪把持权力的「兄弟寡头政治」等。这些五花八门的新词一起勾勒出 2025 年的图景:从工作到娱乐,AI 正重塑我们的语言和生活方式。

实际上,从去年起,各大权威词典发布的年度词汇中,就有多条都和 AI 热潮有千丝万缕的联系。

牛津词典:Brain rot 脑腐

英国牛津大学出版社把「brain rot」(脑腐)评为 2024 年的年度词汇,是去年讨论度最高的一个年度词汇。这个带点夸张的俚语,指的是「大脑或智力状态的退化」,主要是用来形容过度沉迷于碎片化数字内容,从而导致的迟钝、注意力退化等等。

2024 年人们越来越注意到,无节制地刷社交媒体,大量低质、无营养的信息让人「脑子生锈」。这个词生动地概括了在碎片化内容时代,身心都在接受信息过载的挑战。牛津语言部总裁卡斯帕·格拉斯沃尔评价说:「brain rot 道出了数字生活潜在的危险。」他认为,这个词标志着有关人性与科技的新一轮文化讨论。

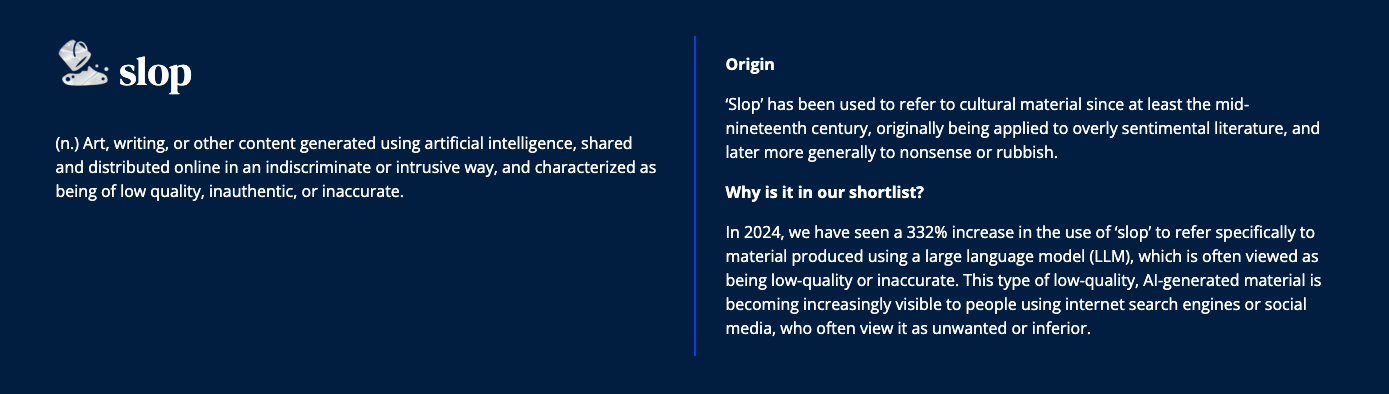

在无人注意的角落,牛津去年的年度词汇候选列表里,还有另一个与 AI 直接相关的词,「slop」,意指「由人工智能生成的劣质网络内容」。虽然最后未当选,但它出现在提名中本身就说明,AI 生成的内容,数量已经到了惹人反感的地步。

无论是「brain rot」还是「slop」,都从不同侧面反映出 2024 年人们对数字内容生态的担忧,以及 AI 算法在其中扮演的复杂角色。

韦氏词典:Authentic 真实

韦氏词典在 2023 年选择的年度词汇,是「authentic」真实的,同时也有「本真」的意思。这个词存在已久,但在充斥 deepfake 和 AI 生成内容的一年里,它的脱颖而出,意义非凡。

2023 年与 AI 相关的新闻和讨论激增,引发了人们对「authentic」这一概念的关注和大量查询,搜索量暴增。正是因为 AI 可以轻易生成以假乱真的图像、视频和文本,人们也就越来越难分辨真伪。所以,对于「真实的、原汁原味的」的追求成为社会心理的一个重要主题。

韦氏词典主编彼得·索科洛夫斯基在解释这一选择时提到,「authentic」有「非伪造、真实可靠」之意,也包含「忠于自我」的延伸意义。它成为年度词汇,某种程度上是对科技充斥下社会心理的映射:当聊天机器人可以模拟人类口吻聊天,当 AI 可以模仿名人声音,我们比以往任何时候都更加珍视人与信息的真实性。

剑桥词典:Hallucinate 幻觉

英国剑桥词典则把目光投向了「hallucinate」幻觉。剑桥将其评为 2023 年的年度词汇之一,原因在于这个心理学动词在当年获得了全新的技术含义。

原本,hallucinate 主要用来指因为生病或服药副作用,导致出现幻觉、看见不存在的东西。不过在 2023 年,人们开始用它描述大语言模型「胡编乱造、产出虚假信息」的现象。

剑桥词典专门为此新增了 AI 相关义项,并表示这一新义「切中了 2023 年人们热议 AI 的核心原因」——生成式 AI 功能强大,但不是没有问题,「hallucinate」正好一语道破了 AI 最大的弱点之一。

值得一提的是,剑桥选择「hallucinate」紧随柯林斯词典将「AI」本身选为 2023 年度词汇之后。也就是说,从「AI」这种宏大的技术概念,到「hallucinate」这样具体描述 AI 缺陷的术语,AI 相关词汇在权威词典的年度榜单上实现了连纵霸榜,说明了眼下 AI 居高不下的热度。

从「vibe coding」到「hallucinate」,AI 相关词汇接连登上年度词汇榜,绝非巧合。

当 AI 改变世界时,也在改变着我们的语言;它们有的描述了 AI 给生活带来的便利,有的反映出人们对 AI 潜在问题的担忧,还有的表达了数字时代人们内心的矛盾与诉求。这一系列语言现象背后,恰恰是 AI 正以前所未有的深度,介入我们的工作、娱乐和社交。语言的变化又反过来成为时代的一面镜子,折射出科技与社会的碰撞。

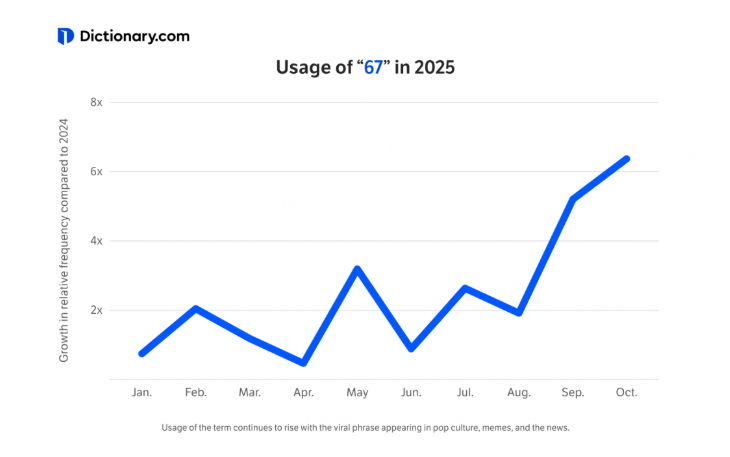

柯林斯是今年较早发布年度词汇的机构,另一个是 Dictionary.com,但是他们选择了一个奇怪的词:67。读作「六、七」,而不是「六十七」。

Dictionary.com 组委会分析了大量数据,包括新闻标题、社交媒体趋势、搜索引擎结果等,发现从 2025 年夏天开始,对这个数字的搜索量有明显的增长,而且一直在增长。

这个词的意思大概就是「还行」「凑合」「及格线」,六分七分吧。确实有点抽象,不好理解。Dictionary.com 的组委会说,他们还在努力弄明白它到底是什么意思,但它的确展现了一个新词,如何随着年轻人的爱用、多用而迅速风靡全球。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。