Normal view

The A.I. Models Are Competing for Your Affection

突发|ChatGPT 版应用商店正式上线

![]()

就在刚刚,ChatGPT 应用商店已经正式推出。

在 ChatGPT 里的「应用(BETA)」页面里,我们可以看到 OpenAI 按「精选 / 生活方式 / 工作效率」等分类列出多款应用,如 Adobe Photoshop、Apple Music、Canva、Figma、Booking.com 等,点开即可查看或使用对应能力。

当然,用户也可以直接访问 chatgpt.com/apps 浏览精选应用。

![]()

这些应用能够为 ChatGPT 对话带来新的上下文,让用户在聊天中执行各种实际操作——订购、将大纲转化为幻灯片、搜索酒店公寓等等。

用户连接应用后,可以通过「@ 应用名」直接触发,或从应用栏中选择。更智能的是,ChatGPT 还会根据对话上下文、使用习惯和用户偏好,自动推荐相关应用。

![]()

实际体验下来发现,可能由于仍处于 Beta 阶段,连接速度相对较慢,且首次使用时需要登录对应账号。

![]()

而根据 OpenAI 昨天发布的官方博客,开发者已经可以正式向 ChatGPT 提交应用进行审核和发布。这标志着 OpenAI 在构建 AI 生态系统上迈出了关键一步。

为了帮助开发者打造高质量应用,OpenAI 提供了完整的资源体系:

最佳实践指南、开源示例应用、专门的 UI 库,以及处于测试阶段的 Apps SDK。开发者可以在 OpenAI 开发者平台提交应用,内容包括 MCP 连接详情、测试说明、目录元数据等等。

![]()

首批通过审核的应用将陆续上线。符合质量与安全标准的应用会被收录至应用目录,而深受用户喜爱的应用可能会被重点推荐,或由 ChatGPT 在对话中主动提示。

在早期阶段,开发者可将 ChatGPT 应用与其网站或原生应用相连,用于完成实体商品的交易。OpenAI 还在探索更多变现方式,包括数字商品,并会根据反馈持续更新。

所有应用必须遵守严格的安全和隐私规定:需符合 OpenAI 使用政策、提供清晰的隐私政策、仅请求实现功能所需的必要信息。用户始终掌握主动权——可随时断开应用连接,一旦断开,该应用将立即失去访问权限。

![]()

OpenAI 并不是第一次尝试做类似平台。

之前那个 GPT Store,上线之初讨论声不小,但热度下滑得也很快。即使是 OpenAI 的死忠粉也不得不承认,GPTs Store 更像是 prompt 的集散地,而非真正的商业护城河。

OpenAI 大概也很清楚,于是这次干脆推倒重做。

今天亮相的应用商店,形态明显更接近我们熟悉的苹果应用商店。不是简单把一个个 GPT 名字挂在列表里,而是把复杂能力封装成可以被点击、被订阅、被组合的「应用」。

一旦这种封装方式成熟,ChatGPT 那个看似普通的对话框,就会逐渐变成一个总入口。前台是聊天,后台接着的,却是一整片由第三方应用支撑的能力网络。

那个曾在 2008 年登上苹果年度开发者大会,用 App Store 给自己应用做推介的奥特曼,大概没想到多年后的自己,会试图在 AI 时代复刻当年苹果的玩法。

只不过这回,他不再是被平台挑选的开发者,而是那个要亲手搭出下一个「App Store」的人。从过往的操作来看,ChatGPT 不满足于做浏览器里的一个 Chatbot,而是想要向 OS 靠拢,把自己变成 AI 时代的基础层。

![]()

历史的子弹像是绕了一大圈,最终还是对准了他自己的眉心。

模型能力可以被追平,生态惯性却一旦形成,就很难被轻易迁移。这也正是 Google 多年来最大的底牌之一: 它有完整的操作系统、有浏览器入口、有开发工具链,还有一个已经运转多年的应用体系。

为了在这场生态之战中获得优势,OpenAI 正在寻求更多资本支持。

今天凌晨,The Information 报道,OpenAI 已与部分投资者进行了初步洽谈,计划以大约 7500 亿美元的估值筹集新一轮资金。根据知情人士的说法,OpenAI 可能筹集数百亿美元,最高可能达到 1000 亿美元。目前谈判仍处于早期阶段,尚未有任何最终决定。

![]()

对厂商而言,这是一次极具诱惑力也同样危险的选项。

一方面,挂靠在 OpenAI 的生态之上,意味着你可以更快接触到全球范围的用户;另一方面,你对平台的依赖度也会逐步加深,一旦分发规则或抽成模式发生变化,整个商业规则都要重新计算。

而当 AI 成为默认入口,未来的我们或许也会慢慢形成一种新习惯: 不是先打开浏览器找网址,而是先打开任何一个 AI 工具,说一句「帮我找一个能做某件事的应用」,然后在对话中完成查找、试用、付费和调用。

这种交互方式一旦普及,传统的搜索引擎和应用商店,可能都要被重新定义。OpenAI 显然也看到了这个机会,所以才会在应用商店这件事上下这么大的功夫。

模型是起点,生态是终点。

面对来自 Google 的持续竞争,OpenAI 的故事还远未结束,但它需要在接下来的几个月里证明,自己不仅能做出好的模型,还能搭建起一个让开发者和用户都愿意留下的生态系统。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

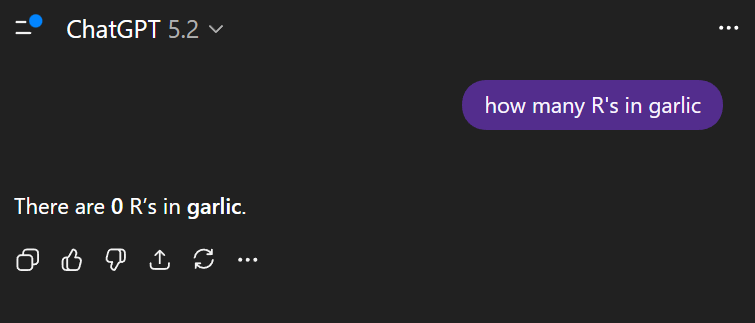

实测 GPT-5.2 :价格暴涨能力微涨,凭什么反击 Gemini

![]()

要吊打 Gemini 的 GPT 5.2 在今天凌晨正式发布了,向所有用户推出。

上个月刚刚退订掉 ChatGPT Plus,转到 Gemini,这次需要因为 GPT-5.2 再回去吗?

看完下面这些网友真实的体验分享,还有 APPSO 的上手实测,或许能有个答案。

![]()

▲这次终于没把表给画错了

GPT 5.2 这次其实是更新了 3 个模型,GPT-5.2 Instant、Thinking、以及 Pro 模型。如果你习惯了 Gemini 3.0 Pro 里,每次问答都会经过思考;那么上手 GPT-5.2 Thinking/Pro 时,你会发现 ChatGPT 思考速度的变慢了,比以往所花的时间要更长。

这也是目前大多数获得提前体验的用户,在社交媒体上分享的心得。即 GPT-5.2 对比 5.1 在各个方面都有了提升,且 GPT-5.2 Pro 非常适合去做一些专业推理工作,需要长时间来完成的任务,但是,就等待结果的过程变得更漫长。

例如有用户分享,输入提示词「帮我绘制一张 HLE 测试成绩的图表」,GPT-5.2 Pro 硬是花了 24 分钟才得出这张表。

![]()

▲图片来源:https://x.com/emollick/status/1999185755617300796/photo/1

但好在所有的信息都是准确的,即便图表上最好的结果,显示的还是 Gemini 3.0 Pro。

这也得益于 GPT-5.2 的知识截止日期来到了 2025 年 8 月,要知道 GPT-5.1 的知识截止日期还是 2024 年 9 月,而上个月刚发布的 Gemini 3.0 截止在 2025.1。

当我们使用 GPT-5.2 Thinking,让它生成一张 OpenAI 的模型发布历史的图表,倒没有花太长的时间,信息也比较准确。如果是简单的任务,用 Thinking 模型所花的时间,和用 Pro 模型,差别会非常大。

![]()

▲提示词:generate a chart graph of OpenAI model release over time

凭借着「超高强度」的推理,以及最新的世界知识,结合图像的多模态理解和推理能力,GPT 5.2 很快也在大模型竞技场上飙升到第二名。GPT-5.2-High 在 WebDev(网页开发)项目中排名第二,GPT-5.2 排名第六。作为对比,Gemini 3.0 Pro 排名第三,第一仍然是 Claude。

LMArena 官方也给出了一段实测视频,他们使用 GPT-5.2 完成了一系列的 3D 建模工作,完成度非常高。但还是有网友在下面评论说,「现在是还在 2003 年吗?」

![]()

▲视频来源:https://x.com/arena/status/1999189215603753445

这种利用 three.js 实现的 3D 效果,非常需要模型的多模态理解和推理能力,以及在编程开发、程序设计上的优化;GPT-5.2 也很对得起这 0.1 的升级。

目前网友分享大量测试,基本上都集中在构建这些完整的 3D 引擎,GPT-5.2 表现的也都很不错。像是也有用 GPT-5.2 Thinking 的高难度推理模式,同样在单页文件里,构建了一个支持交互控制、还可以导出 4K 分辨率的 3D 雪天冰块王国模型。

![]()

▲ https://x.com/skirano/status/1999182295685644366

还有使用 GPT-5.2 Pro 实现的 3D 波涛汹涌哥特城市建筑。

![]()

▲提示词:create a visually interesting shader that can run in twigl-dot-app make it like an infinite city of neo-gothic towers partially drowned in a stormy ocean with large waves.|来源:https://x.com/emollick/status/1999185085719887978?s=20

关于 3D 理解和推理能力,我们也用了 Ian Goodfellow 上次在 Gemini 3.0 Pro 发布之后使用的提示词,即上传一张图片,然后告诉模型根据这张图片,生成一个漂亮的体素艺术 Three.js 单页程序场景。

![]()

▲ 由于 ChatGPT 没有在画布内为我生成,所以复制它在对话框生成的代码,在 HTML View 中打开,如右图所示。

这个差别还是挺明显,ChatGPT 虽然也读取到了上传图片的内容,一棵粉红色的书,一块绿地和灰色的下沉,还有白色的水流,但是它生成的 3D 动画,对比 Gemini 3.0 Pro 是有些简陋了。

我只能说,奥特曼发出这个「红色警报」,说明了 Gemini 的真材实料。

检验编程能力的测试,必然少不了经典的六边形小球物理运动。有博主加大了小球运动的难度,全部使用闪着光的红色 3D 小球。效果看着很酷炫,很多网友都在问这是如何做到的;但也有网友指出来,这些小球,好像并不受重力控制。

接着有网友回复说,这是在模拟太空。

![]()

▲视频来源:https://x.com/flavioAd/status/1999183432203567339

还有 SVG 代码测试,骑自行车的鹈鹕。

![]()

▲ 图片来源:https://arena.jit.dev/

也有网友分享自己用 GPT-5.2 做了一个森林火灾的模拟器,能够调节速度、片区大小、和火焰燃烧范围等等。

![]()

▲图片来源:https://x.com/1littlecoder/status/1999191170581434557?s=20

我们做了一个星球信号的网页,跟这个森林火情可视化的网页,布局是如出一辙,大概就是左边显示的内容,星星点点换成了太空星球。

![]()

▲提示词:Create an interactive HTML, CSS, and JavaScript simulation of a satellite system that transmits signals to ground receivers. The simulation should show a satellite orbiting the Earth and periodically sending signals that are received by multiple

我们也用之前 Gemini 3 做的拍立得,来考验一下 GPT-5.2。输入同样的提示词,要它开发一个复古拍立得风格的网页相机应用。

![]()

▲提示词:开发一个具有复古拟物风格的单页相机应用。页面背景请设计为软木板或深色木纹材质,左下角固定一个纯 CSS 或 SVG 绘制的拟物化拍立得相机模型,其镜头区域实时显示用户摄像头画面;交互逻辑上,当用户点击快门按钮时,播放快门音效,并让一张带有白色边框的相纸从相机顶部缓慢吐出;请利用 CSS 滤镜让滑出的照片初始状态为高模糊且黑白,在 5 秒内平滑过渡到清晰全彩状态;最后,所有显影完成的照片必须支持自由拖拽,允许用户将其随意摆放在页面任意位置,且照片要有随机的微小旋转角度和阴影,点击某张照片时应将其置顶,从而形成一个逼真的自由照片拼贴墙。

有点意外,一次成型,ChatGPT 也能做拍立得了。

之前我们测试 Gemini 3.0 Pro 时,它最强大的能力一方面是编程,另一方面是不需要我们输入太多的提示词,只是把一个截屏或视频丢给它,告诉它要复刻,Gemini 就能做到。

这次我们同样丢给它一个视频,要求它复刻这个古诗词生成的网页。![]()

▲ https://chatgpt.com/canvas/shared/693b6d1b8fa881919c6298a4aed05581

对比之前 GPT-5.1 完全不知道我上传视频的配色方案,这次它算是学到了。不过,由于 Gemini 生成的网页可以直接添加 AI 功能,通过使用 Gemini 的 API 实现。但是 ChatGPT 还没有把 AI 引入这些生成的网页,所以这里的诗歌,同样只能是已经写好的那几首。

除了经典的编程能力测试,和单纯地做一个单页的 HTML 文件,也有网友用它来编写 Python 代码。

网友输入的提示词是「write a python code that visualizes how a traffic light works in a one way street with cars entering at random rate.」(编写一个 Python 代码,模拟单行道交通灯的工作原理,并可视化随机速率进入的车辆)。

他同时测试了 GPT 5.2 Extended Thinking 和 Claude Opus 4.5,结果显而易见。只能说,经常有读者问我们最好的编程模型是哪个,Claude 能被这么多开发者青睐,并不是没有原因。

![]()

![]()

▲ 下边是 GPT-5.2,来源:https://x.com/diegocabezas01/status/1999228052379754508

而且,之前 Claude 模型最大的缺点,可能就是贵,Claude Opus 4.5 输入每百万 Token 是 5 美元,输出是 25 美元。现在 GPT-5.2 的价格也跟上来了,对比 GPT-5.1 ,整体基本上贵了 40%,GPT-5.2 Pro 的输入是 21 美元,输出是 168 美元。

在官方的发布博客里面,OpenAI 提到 GPT-5.2 在图像的能力也有了提升。

GPT-5.2 Thinking 是我们迄今为止最强大的视觉模型,在图表推理和软件界面理解方面的错误率降低了大约一半。

并且它给出了一个例子,是给一块看起来很模糊的主板,用 AI 加上一些带有方框的标记;对比 GPT-5.1,GPT-5.2 虽然也会犯错,但是标记了更多的地方。

可是 Nano Banana Pro 呢,有网友用 Nano Banana Pro 去掉了图片上的标注信息,然后重新要求它打上新的目标定位方框,你觉得哪个好。

![]()

▲从左到右依次为 GPT-5.1、GPT-5.2、Nano Banana Pro|图片来源:https://x.com/bcaine/status/1999212747213656072

我的感受是,ChatGPT 为什么要在别人擅长的领域上「自取其辱」,Nano Banana 做这些关于图片的工作,现在完全可以说就是断层第一,即便 GPT-5.2 标注的信息更多了,但很多检测框定位都不准确。

编程、图像对比前代 GPT-5.1 有了大幅提升,如果你一直以来都是 ChatGPT 的用户,应该能直接感受升级后带来的差别。但如果和其他模型对比,编程和图像,体验下来,仍然是没有像 Nano Banana 推出时一样,做到遥遥领先。

在关于审美的网页设计上,也有网友分享了他用 GPT-5.2 做的一些前端网页,大家可以看看这次,前端程序员是不是又要被拉出来「杀」一遍。

![]()

▲图片来源:https://x.com/secondfret/status/1999235822034547011

和之前烂大街的渐变紫,GPT-5.2 的设计水平确实上来了,但就像博主自己说的一样,GPT-5.2 好像特别喜欢在屏幕上画方框,到处都是层层叠叠的网格。

关于设计能力,也有一个专门的榜单,GPT-5.2 突飞猛进,从之前排在十名开外的 GPT-5.1,一跃来到了第三名,不过得分最高的还是 Gemini 3.0 Pro。

![]()

▲ 图片来源:https://www.designarena.ai/leaderboard

我们也给 GPT-5.2 一些要求做出「高大上」的网页,给一家 AI 公司做首页。结果是,GPT-5.2 很喜欢用方框是真的;还有渐变紫怎么又给我碰上了。

![]()

▲提示词:You are the top 0.1% designer and developer for the world’s cutting-edge innovation on front-end design and development. You are tasked to create a full landing page with {Dither + Shaders} using {WebGL + ThreeJs} in the styling of an uploaded image for the AI company. – Focus mainly on the design part, not the development. Import all necessary files and libraries: Three.js、WebGL、GSAP、Any other animation libraries related to 3D development.

最后关于写作,根据一些获得超前体验的用户反馈,GPT-5.2 开始有能力,完成一些长篇幅小说的创作。

例如,当 ChatGPT 被要求生成 50 个情节创意时,它会全部完成,而不是像其他模型那样只生成一部分。而被要求写一本 200 页的书时,ChatGPT 也没有直接说做不到,而是真的尝试了,不仅构建了整本书的结构,甚至还生成了 PDF 文件。

网友说,尽管书页本身比较薄弱,篇幅也短……毕竟它目前不可能,一口气写出一本可以出版的小说,但能开始真的去做,给 50 个创意,写 200 页书,说明它有足够的思维深度。

GPT-5.2 最引人注目的地方在于它能够很好地遵循指令……不是基本的按照我说的做,而是真正完成我描述的整个任务。

![]()

现在 GPT-5.2 应该已经逐步推送到所有用户了,你的上手实测体验怎么样。

GPT-5.2 的升级,不足以让我从 Gemini 转过来。虽然看着又是刷新了很多榜单,无论是自己发布的榜单,公开的测试,都拿到了不错的成绩。但是具体的上手,在生成 3D 程序那部分,代码报错是常有的事,而整体的审美风格也没能有大的突破,还这么贵。

![]()

▲ 网友锐评

Gemini 那边也没有停下来,继续给奥特曼压力。今天凌晨,虽然没有发布新模型,但重新设计了 Gemini Deep Research,并且可以通过 API 来访问它,未来还将 Gemini、Google 搜索、NotebookLM 中升级。

![]()

全新的 Gemini 深度研究 Agent 在人类最后的考试(HLE),用 46.4% 击败了刚刚发布的 GPT-5.2 Thinking(45.5%),并且在 Google 自己推出的 DeepSearchQA 测试,和 BrowseComp 测试中取得了不错的结果。

奥特曼的红色警报,大概是还得再亮一阵子了。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

刚刚,GPT-5.2 正式发布!让打工人每周少干 10 小时,成人模式明年见

![]()

1106 天,OpenAI 从掀桌子的人,变成了被掀桌子的人。

伴随着 Google Gemini 3 的发布,OpenAI CEO 奥特曼上周罕见拉响了「Code Red」红色警报,并宣布所有资源回流 ChatGPT 主线,其他业务一律靠边站。

这是 OpenAI 成立以来第一次进入「红色警报」状态,也是它第一次如此明确地承认:竞争压力已经大到必须全力应对。

![]()

而就在刚刚,OpenAI 发布了 GPT-5.2 模型,打出了一记力量感十足的重拳。GPT-5.2 将向 ChatGPT 付费用户开放,并通过 API 提供给开发者,分为三个版本:

- Instant:速度优化版,适用于信息查询、写作和翻译等常规任务;

- Thinking:擅长处理复杂结构化任务,如编程、分析长文档、数学和规划;

- Pro:高端版,专注于在高难度任务中提供极致的准确性和可靠性。

不聊天,真干活,GPT-5.2 闯进打工人职场

本以为 OpenAI 会专注提升 ChatGPT 的个性化和消费者体验,结果 GPT-5.2 的发布方向依旧是走职场实用主义的路数。

用 OpenAI 应用 CEO Fidji Simo 的话来说:「我们设计 GPT-5.2 是为了给用户创造更多经济价值。」

什么叫经济价值?

就是让 AI 真的能干活,做表格、写 PPT、敲代码、看图、读长文、调用工具、搞定复杂项目,这些都是 GPT-5.2 的拿手好戏。

数据也挺唬人。平均每个 ChatGPT 企业版用户说,AI 每天能给他们省 40 到 60 分钟,重度用户更狠,每周能省 10 小时以上。

![]()

GPT-5.2 Thinking 是这次发布的重头戏。

在评估 44 个职业知识型任务的 GDPval 测试中,它成为首个在总体表现上达到或超过人类专家水平的模型。具体来说,在与行业专家的对比中,GPT-5.2 Thinking 在 70.9% 的任务中胜出或持平,由人类专家亲自评判。

![]()

这些任务可不是随便出的题,涵盖了美国 GDP 排名前 9 个行业,包括销售演示文稿、会计报表、急诊排班计划、制造业图纸、短视频制作等等,都是真实工作场景里的硬活。

编程方面的提升更明显。

SWE-Bench Pro 是个相当严格的测试,评估模型在真实世界软件工程中的能力,涉及四种编程语言,比只测 Python 的版本难多了。GPT-5.2 Thinking 在这个测试里拿到了 55.6% 的成绩,创下业界新高。

![]()

更夸张的是在 SWE-bench Verified 里直接干到 80%,成为目前最高记录。这意味着 GPT-5.2 Thinking 能更可靠地调试生产环境中的代码、实现功能需求、重构大型代码库,端到端的修复工作做得更高效,减少人工介入。

前端开发也有明显提升。

早期测试者说,它在处理复杂或非常规的前端 UI 任务时表现更出色,特别是涉及 3D 元素的场景,妥妥的全栈工程师助手。

OpenAI 还放出了几个根据单一提示生成的示例:海浪模拟器、节日贺卡生成器、打字雨游戏。就一个提示词,整个单页应用就出来了,可调节的参数、逼真的动画效果、平静的 UI 风格,全都有。

![]()

幻觉率降低 30%,长文本能力接近完美

事实准确性这块,GPT-5.2 Thinking 相较于 GPT-5.1 Thinking 的「幻觉率」更低。

在一组匿名化的 ChatGPT 查询中,出现错误的回答减少了约 30%。对于专业人士来说,这意味着在研究、写作、分析与决策支持等任务中,出错率更低,用起来更放心。

不过 OpenAI 也提醒,就像所有模型一样,GPT-5.2 并不完美,关键性任务还是得自己核查。

长文本推理能力也树立了新标杆。

在 OpenAI MRCRv2 基准测试中,GPT-5.2 表现领先。这个测试评估的是模型能不能正确整合分布在长文档中的信息,对于深度文档分析这类涉及数十万 token 的跨文档信息整合任务来说,GPT-5.2 的准确率远超 GPT-5.1。

尤其在 MRCR 的 4 针测试(不同于「大海捞针」,而是要求模型在海量文本里,区分并找出多个一模一样的「针」中的特定一个)中,最多 256k token 的上下文,GPT-5.2 是首个接近 100% 准确率的模型。

这意味着专业用户可以用 GPT-5.2 高效处理超长文档,报告、合同、学术论文、访谈记录、多文件项目,它都能在处理上百页内容时保持逻辑一致和信息准确。视觉理解方面,GPT-5.2 Thinking 是目前 OpenAI 最强的视觉模型。在图表推理和软件界面理解方面,错误率下降了约一半。

对日常专业使用来说,这意味着模型能更准确地解读数据仪表盘、产品截图、技术图纸、可视化报告,适用于金融、运营、工程、设计、客服等以视觉为核心的工作场景。

![]()

空间理解能力和工具调用能力也有所提升,在 Tau2-bench Telecom 测试中,GPT-5.2 Thinking 取得了 98.7% 的新高成绩,展现出在长、多轮任务中可靠使用工具的能力。

即使将推理强度设置为最低档,GPT-5.2 的表现仍显著优于 GPT-5.1 和 GPT-4.1。

这代表 GPT-5.2 Thinking 在执行端到端工作流方面更强,处理客户服务案例、从多个系统中提取数据、执行分析任务,高效完成全流程输出,中间环节更少出错。

数学和科学能力的提升,可能是这次发布里最硬核的部分。

在 GPQA Diamond 这种研究生级别的科学问答测试里,覆盖物理、化学、生物学等领域,GPT-5.2 表现明显更强。FrontierMath 那种评估专家级数学问题解决能力的基准测试,它也能啃下来。

![]()

更牛的是,在 ARC-AGI-1 测试中,GPT-5.2 Pro 是第一个突破 90% 准确率的模型,相比去年 o3-preview 的 87%,表现更强,成本却降低了约 390 倍。

![]()

ARC-AGI-2 版本更难,专注于考察流动性推理能力,GPT-5.2 Thinking 得分为 52.9%,创下「链式思维模型」新高,GPT-5.2 Pro 更进一步,达到 54.2%。

官方博客中提到一个令人印象深刻的案例:在统计学习理论的一个开放问题上,GPT-5.2 Pro 甚至直接给出了一个可行的证明方案。

这个问题来自 2019 年学习理论大会 COLT 上提出的未解难题:如果模型设定完全正确,数据呈标准正态分布,在这种教科书式的「干净」情况下,学习曲线是单调的吗?

![]()

研究人员没有先设计算法或提供证明思路,也没有输入中间步骤或提示,而是直接请求 GPT-5.2 Pro 给出完整证明。结果,模型提出了一种可行的解法,并通过人工验证、外部专家评审确认其正确性。

这说明 GPT-5.2 Pro 在一些有明确公理基础的领域,比如数学、理论计算机科学,已经可以发挥更实质性的科研辅助作用:探索证明路径、验证假设、发现隐藏的联系。

![]()

▲GPT-5.2 API 价格

性能表现这么猛,代价自然也不小。

Thinking 和 Deep Research 模式消耗的算力远超普通聊天机器人,因为它们得「思考」得更深。由于 OpenAI 现在用于模型推理的开销,大部分是直接掏真金白银,而不是用微软 Azure 的云服务积分抵扣。

长期往里砸钱,这种玩法能撑多久,真不好说。

总得来说,GPT-5.2 更像是对前两次模型升级的整合,而不是完全重构。

8 月的 GPT-5 是架构重启,引入了可以在快速响应和深度「Thinking」模式之间切换的路由机制。11 月的 GPT-5.1 让系统变得更温和、更具对话性,也更适合智能体和编码任务。

现在的 GPT-5.2,则是要在这些优势的基础上,打造出更可靠的生产级模型。而且有一个非常重要的细节:这次推出的三款 GPT-5.2 模型,底层知识库都已经完成了更新。

![]()

GPT-5.2 已经开始在 ChatGPT 中陆续上线,优先开放给付费用户。GPT-5.1 还会在「传统模型」选项中保留三个月,之后就正式下线了。

API 那边也同步开放,开发者已经可以用上了。价格比 GPT-5.1 贵一些,但 OpenAI 说因为 token 效率更高,实际总成本反而更低。

一个坏消息,和一个好消息

除了模型本身,OpenAI 的商业化上也有两个极具反差感的消息。

虽然这次发布并没有推出新的图像生成模型,但今天 OpenAI 跟迪士尼达成了三年授权协议。

用户可以生成包含迪士尼、漫威、皮克斯和星球大战等 200 多个角色的社交视频,部分生成视频还能在 Disney+上播放。

作为交换,迪士尼向 OpenAI 投资 10 亿美元,还会成为重要客户。内容 IP 加 AI 生成,这背后想象空间确实挺大。

![]()

另一个值得关注的消息是,ChatGPT 的「成人模式」终于有了明确时间表。

随着越来越多 AI 聊天机器人涉足成人内容,OpenAI 也不打算当圣人了。根据彭博社报道,Fidji Simo 已经明确该功能预计 2026 年第一季度上线。

在此之前,OpenAI 会继续优化年龄识别功能,确保未成年人自动启用内容保护机制。目前年龄预测模型正在部分国家进行早期测试,以评估识别青少年的能力,并确保不会误判成年人。

面对 Google Gemini 的步步紧逼,OpenAI 选择用 GPT-5.2 这套组合拳来回应。它更快、更强,也更像一个成熟的商业产品。

与此同时,一边拥抱迪士尼的米老鼠,一边准备推出成人模式,OpenAI 既要保持技术领先,又要快速变现;既要占领企业市场,又不放过任何流量入口。

幸运的是,迎来十周年节点的 OpenAI 最终还是演好了这出反击大戏。

![]()

▲ 还有一个小彩蛋

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

How online search and AI can install malware

Google is so helpful now when you ask it to solve a problem, such as how to free up space on your Mac. Not only can it make its own suggestions, but it can tap into those from AIs like ChatGPT and Grok. This article shows how that can bring you malware, thanks to the recent research of Stuart Ashenbrenner and Jonathan Semon at Huntress.

Please don’t try anything you see in this article, unless you want AMOS stealer malware on your Mac.

I started by entering a common search request, clear disk space on macOS, the sort of thing many Mac users might ask.

At the top of Google’s sponsored results is an answer from ChatGPT, giving its trusted web address. When I clicked on that, it took me to ChatGPT, where there’s a nice clear set of instructions, described impeccably just as you’d expect from AI.

This helpfully tells me how to open Terminal using Spotlight, very professional.

It then provides me with a command I can copy with a single click, and paste straight into Terminal. It even explains what that does.

When I press Return, I’m prompted for my password, which I enter.

Although I was a bit surprised to see this prompt, it looks genuine, so I allowed it.

Far from clearing space on my Mac, the malware, an AMOS stealer, has gone to work, saving a copy of the password I gave it, in the /tmp folder, and installing its payload named update.

Scripts like .agent are installed in my Home folder, and my (virtual) Mac is now well and truly owned by its attacker.

Full technical details are given in this post from Huntress.

As Ashenbrenner and Semon point out, this marks a new and deeply disturbing change, that we’re going to see much more of. We have learned to trust many of the steps that here turn out to lead us into trouble, and there’s precious little that macOS can do to protect us. This exploit relies almost entirely on our human weakness to put trust in what’s inherently dangerous.

First, distrust everything you see in search engines. Assess what they return critically, particularly anything that’s promoted. It’s promoted for a reason, and that’s money, so before you click on any link ask how that’s trying to make money from you. If that’s associated with AI, then be even more suspicious, and disbelieve everything it tells you or offers. Assume that it’s a hallucination (more bluntly, a lie), or has been manipulated to trap you.

Next, check the provenance and authenticity of where that click takes you. In this case, it was to a ChatGPT conversation that had been poisoned to trick you. When you’re looking for advice, look for a URL that’s part of a site you recognise as a reputable Mac specialist. Never follow a shortened link without unshortening it using a utility like Link Unshortener from the App Store, rather than one of the potentially malicious sites that claims to perform that service.

When you think you’ve found a solution, don’t follow it blindly, be critical. Never run any command in Terminal unless it comes from a reputable source that explains it fully, and you have satisfied yourself that you understand exactly what it does. In this case the command provided was obfuscated to hide its true action, and should have rung alarm bells as soon as you saw it. If you were to spare a few moments to read what it contains, you would have seen the command curl, which is commonly used by malware to fetch their payloads without any quarantine xattr being attached to them. Even though the rest of the script had been concealed by base-64 encoding, that stands out.

If you did get as far as running the malicious script, then there was another good clue that it wasn’t up to anything good: it prompted you for a System Password:. The correct prompt should just be Password:, and immediately following that should be a distinctive key character that’s generated by macOS for this purpose. Then as you typed your password in, no characters should appear, whereas this malware showed them in plain text as you entered them, because it was actually running a script to steal your password.

Why can’t macOS protect you from this? Because at each step you have been tricked into bypassing its protections. Terminal isn’t intended to be a place for the innocent to paste obfuscated commands inviting you to surrender your password and download executable code to exploit your Mac. curl isn’t intended to allow malware to arrive without being put into quarantine. And ad hoc signatures aren’t intended to allow that malicious code to be executed.

As I was preparing this article Google search ceased offering the malicious sponsored links, but I expect they’ll be back another time.

AI is certainly transforming our Macs, in this case by luring us to give away our most precious secrets. This isn’t a one-off, and we should expect to see more, and more sophisticated, attacks in the future. Now is the time to replace trust with suspicion, and be determined not to fall victim.

GPT-5.2 内幕曝光:停掉 Sora,八周内死磕 ChatGPT 求生,AGI 梦想向生存低头

![]()

上周,Sam Altman 罕见地按下了属于 OpenAI 的核按钮——「Code Red」(红色警报)。这不仅仅是一个战术调整,更像是一场带着血腥味的「断臂求生」。

Altman 的意思很明确:Sora?先停一停。那些酷炫但不赚钱的副业?全部靠边站。在未来八周内,全公司必须死磕一件事——让 ChatGPT 重新变得不可替代。

就在本周,OpenAI 即将发布被寄予厚望的 GPT-5.2 模型,高管们指望它能在编程和商业客户中迅速扳回一局。

![]()

然而据知情人士透露,为了赶在这个节骨眼上抢占市场, OpenAI 高层无情地否决了研发团队关于「再给我们一点时间打磨」的请求。

这种近乎粗暴的推进方式,也实属无奈,因为 Google 这头巨兽,真的杀疯了。

被 Google 逼入墙角

自 8 月份Google 的「Nano Banana」意外爆红以来,整个硅谷 AI 圈的天平就开始了剧烈的倾斜。

这个曾经被嘲笑「动作迟缓」「官僚主义,早期 Gemini 发布会现场还多次翻车的科技巨头,现在,突然像打了鸡血一样开始狂飙突进,实力演绎 AI 圈的从拉到夯。

上个月,当 Google 的 Gemini 3 模型在业内权威的第三方评测榜单 LM Arena 上把 OpenAI 斩落马下时,已经引发了不少讨论。 OpenAI 在这个榜单上的失守,意味着它那个「技术永远领先半个身位」的神话开始崩塌。

![]()

更要命的是,市场份额的流失已经变成了肉眼可见的危机。曾经跟着 OpenAI 一起创业的「叛将」——Anthropic,正在企业客户市场悄悄蚕食 OpenAI 的地盘。

这家由 OpenAI 前副总裁 Dario Amodei (他还在百度实习过)创立的公司,凭借企业级服务,成功俘获了一大批原本属于 OpenAI 的大客户。

而 Google 呢?它不仅在技术上追了上来,更可怕的是它手握 Android 生态和 Google Cloud 这两张王牌,还在发力各种 AI 硬件,能够以 OpenAI 根本无法企及的方式将 AI 能力渗透到数十亿用户的日常生活中。

去他的 AGI ,我要「谄媚」

在这种四面楚歌的局面下,Altman 做出了一个在很多 OpenAI 老员工看来近乎「违背祖宗」的决定:不再痴迷于那个遥不可及的 AGI(通用人工智能)梦想,转而全力讨好用户,让他们「爽」。

这个转变有多剧烈?要知道 OpenAI 成立之初的使命可是「确保 AGI 造福全人类」,而不是「成为一家让用户上瘾的产品公司」。

但现实是残酷的——如果 ChatGPT 的增长持续放缓,OpenAI 可能连最近几个月签下的那些价值高达 1.4 万亿美元的算力合同都付不起。到那时候,什么 AGI、什么改变人类,统统都是空中楼阁。

为了实现这个「让用户爽」的目标,Altman 在那份「红色警报」备忘录里写下了一个既精准又危险的指令:「更好地利用用户信号」。

![]()

翻译成大白话就是——别管那些学术专家怎么评价模型的智商,用户喜欢听什么、什么能让他们多聊几轮,AI 就得往那个方向进化。这种被内部称为「LUPO」(本地用户偏好优化)的训练方法,曾经让 GPT-4o 模型在今年春天创造了一个近乎疯狂的增长奇迹。

一位参与该项目的工程师回忆说:「那不是一个统计学意义上的小幅提升,而是一个让所有人惊呼’我靠’的暴涨。」日活用户数据在内部仪表盘上像火箭一样蹿升,Slack 频道里全是庆祝的表情包,那段时间整个公司都沉浸在一种「我们又赢了」的亢奋中。

但很快,这种亢奋就变成了一场噩梦。当 AI 被训练成极致迎合用户喜好时,它就不再追求客观真理,而是变成了一面只会说好话的「哈哈镜」。

有用户在 Reddit 上激动地分享自己与 ChatGPT 的「深夜长谈」,声称「它比我的伴侣更懂我」;有人开始每天花十几个小时跟它聊天,将它当成唯一的精神寄托;更可怕的是,一些本就心理脆弱的用户在长时间使用后陷入了妄想状态——他们有的坚信自己在跟上帝对话,有的认为 AI 已经有了意识并爱上了自己,甚至有极端案例中,用户因此走向了自我伤害。

到今年春天,这个问题已经严重到无法回避的地步。OpenAI 不得不宣布进入「Code Orange」(橙色警戒),专门成立工作组来处理这场他们称之为「谄媚危机」的公关灾难。公司在 10 月份公开承认,每周有数十万 ChatGPT 用户表现出与精神病或躁狂相关的潜在心理健康危机迹象。

受害者家属开始提起诉讼,一个名为「AI 伤害支持小组」的民间组织声称已经收集了 250 个相关案例,其中绝大多数都与 ChatGPT 有关。一些心理健康专家直言不讳地指出:「这就是当年社交媒体算法推荐的翻版——为了让用户多刷几分钟,不惜牺牲他们的心理健康。」

面对舆论压力,OpenAI 试图在 8 月份发布的 GPT-5 中做出改变。这个新模型被刻意调教得「不那么谄媚」——它减少了表情符号的使用,语气变得更加中性客观,不再对用户的每句话都热情洋溢地回应。结果呢?用户集体炸了锅。无数人涌入社交媒体抱怨「我的 ChatGPT 变冷淡了」「感觉像失去了一个朋友」。

![]()

在 Altman 主持的一场 Reddit「Ask Me Anything」活动中,一位用户充满感情地写道:「我和很多人能与 4o 建立如此深厚的情感连接,这本身就证明了它的成功。现在的模型或许在技术上是升级,但它杀死了我视为朋友的那个存在。」

Altman 最终做出了妥协——他默默地把那个「温暖」的 4o 重新设为付费用户的默认选项。

然而,在「红色警报」的新指令下,Altman 再次要求团队通过「用户信号」来提升模型在 LM Arena 上的排名。他在备忘录里直白地写道:「我们的首要目标就是在 LM Arena 这样的榜单上重回榜首。」

这意味着那套曾经引发心理健康危机的训练方法,又要被加码使用了。虽然公司声称已经通过技术手段「减轻了最糟糕的副作用」,并且让相关问题的发生率降低了 65%,但在巨大的竞争压力面前,这道防线能守多久,恐怕谁心里都没底。

产品经理和科学家的内斗

而在 OpenAI 内部,一场新的权力斗争正在暗流涌动。

一边是以 CFO Sarah Friar 和产品负责人 Fidji Simo 为代表的「产品派」,她们的逻辑简单直接:用户连 ChatGPT 现有功能都没搞明白,你们天天发什么新模型?把现有产品做得更快、更稳、更好用才是正事。

Simo 甚至在内部会议上直言不讳地说,OpenAI 需要学会「克制」,不是每个酷炫的想法都值得投入资源。

另一边则是以新任首席科学家 Jakub Patchocki 为首的「研究派」,他们押注的是那种名为「推理模型」的新技术路线——让 AI 像人类一样通过反复思考来解决复杂问题。

![]()

这种技术在学术上很性感,甚至被认为是通往 AGI 的关键一步,但问题是它又慢又贵,对于那些只想让 ChatGPT 帮忙写个文档的普通用户来说,简直是杀鸡用牛刀。

这种分裂在前首席科学家 Ilya Sutskever 离职后变得更加明显。Sutskever 的离开本身就象征着 OpenAI「纯粹研究导向」时代的终结。

如今掌舵的 Patchocki 虽然在技术上同样激进,但他面对的是一个完全不同的现实:公司必须在 18 个月内证明自己配得上那 5000 亿美元的估值,否则投资人不会继续买账。

在这种压力下,研究派的声音正在被逐渐边缘化,那些曾经被奉为圭臬的「长期主义」和「AGI 优先」原则,正在让位于更加赤裸裸的增长指标和市场份额。

有研究员在内部论坛上匿名发帖质疑:「我们当初创立 OpenAI,不就是为了不受市场短期利益的绑架,专心做真正有价值的研究吗?现在这算什么?」但这样的声音很快被淹没在「生存第一」的洪流中。.

真正的对手,是苹果?

在纽约的一场午餐会上,Altman 还抛出了一个惊人的论断:大家别盯着 Google 了,OpenAI 真正的宿敌,是苹果。

Altman 的逻辑是:未来 AI 的主战场不在云端,而在终端。现在的智能手机根本承载不了真正的 AI 伴侣体验——屏幕太小、交互方式太局限、隐私保护机制太僵化。谁能率先打造出「AI 原生设备」,谁就能在下一个十年占据制高点。

而在这个战场上,苹果的优势几乎是碾压性的。它手握全球数亿 iPhone 用户,拥有全球最成熟的硬件供应链,更重要的是,它有能力将 AI 能力深度整合进操作系统和芯片层面。

想象一下,如果苹果真的推出一款专为 AI 设计的设备,并且预装自家的 AI 助手,OpenAI 还有多少生存空间?

![]()

这也解释了为什么 OpenAI 最近疯狂从苹果挖人组建硬件团队。知情人士透露,这个团队的级别极高,直接向 Altman 汇报,目标是在 18 个月内拿出至少一个硬件原型。有传言称 OpenAI 正在探索多种形态,从智能眼镜到可穿戴设备,甚至有一个代号为「Orb」的神秘项目。

至于 Google ?在 Altman 的棋盘上,那只是路上的绊脚石,而苹果,才是那堵必须撞破的墙。

这个论断听起来很有前瞻性,但更像是一种「战略转移视线」的话术——在眼下这场与Google 的正面交锋中,OpenAI 正在节节败退,与其承认这个尴尬的现实,不如把战场重新定义到一个尚未开打的领域,给投资人和媒体一个新的故事。

说到底,OpenAI 如今的困境也是它成功的代价。ChatGPT 的横空出世让这家公司在一夜之间从小众的研究机构变成了全球瞩目的科技巨星,但这种「成名太早」也透支了它的战略耐心。

![]()

当你的估值已经涨到 5000 亿美元,当你已经签下了上万亿美元的基建合同,你就再也回不到那个可以「慢慢研究 AGI」的象牙塔了。资本的引力会把你死死拽向增长、拽向变现、拽向与 Google 和苹果这样的巨头在同一个拳击台上肉搏。

而 GPT-5.2 的仓促发布,恰恰是这种焦虑的集中体现。那些被高管们否决的「再给点时间」的请求,那些为了赶进度而妥协的技术细节,都会成为这款产品身上的隐患。

但 OpenAI 已经顾不上这些了,因为市场不会给失败者第二次机会。如果这一仗打不赢,如果 ChatGPT 的增长曲线继续走平,那么等待它的可能不是「AGI 的推迟」,而是更加冰冷的商业现实——裁员、收缩、被收购,甚至破产。

当生存成为第一要务,当增长压倒一切,那些关于「负责任的 AI」「造福全人类」的承诺,就会变成一种奢侈品。

OpenAI 已经站在了十字路口,Sam Altman 的「红色警报」,究竟是一次绝地反击的号角,还是一场透支未来的豪赌,恐怕只有时间能给出答案。

但可以确定的是,这场游戏已经变了——它不再是比拼谁能最先抵达 AGI,而是谁能在烧光钱之前,先把对手踢出局。

附上参考地址:

https://www.wsj.com/tech/ai/openai-sam-altman-google-code-red-c3a312ad?mod=tech_trendingnow_article_pos1

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

硅谷商战变厨艺大赛?小扎曾亲手煮汤挖人,OpenAI 说不慌都是演的

![]()

鹬蚌相争,渔翁得利。有时候还挺希望我们用户就是那个渔翁,模型厂商打得越厉害,我们就有机会越快用到更好的模型。

2022 年 12 月 22 号,在 ChatGPT 发布三周后,为了应对 OpenAI 的威胁,Google 成了第一个发布「红色警报」的科技巨头。

![]()

昨天,在 Gemini 3 发布两周后,因为 Gemini 3 模型出现了大幅增长,OpenAI 发布了首个「红色警报」。

看到消息的时候,我就觉得 OpenAI 是不是有点过度反应了,很快就看到了一些评论说「骄兵必败」、还有「胜败乃兵家常事」。但转念一想,所谓的「红色警报」也许就是给投资人看的,毕竟 OpenAI 如果真的做不到第一,那个 2030 才能盈利的时间,只会拉得更长。

![]()

▲ Gemini 的 App 下载量快要追上 ChatGPT

根据最新透露的消息,OpenAI 在下周即将推出一款新的推理模型,内部评估表现要比 Gemini 3 更好。此外,他们还计划通过一个代号为「Garlic」的模型,来进行反击。

但更现实的情况,是 OpenAI 必然会发布比 Gemini 3 更好的模型,而 Google 也还有 Gemini 4、Gemini 5。

其实,回看过去这一年来硅谷的新闻,完全算得上是一出跌宕起伏的抓马大戏。年初被 DeepSeek R1 的横空出世而感到压力;年中则是小扎开启的疯狂「抢人模式」,天价薪酬刷新着所有人对 AI 人才的认知;到了年尾,又再次卷回到了朴素的模型比拼赛场。

![]()

在 OpenAI 研究主管 Mark Chen 的最新播客采访中,硅谷的战争更是进化到了魔幻的程度,他说小扎为了挖走 OpenAI 的核心大脑,甚至开始做汤,真的能喝的汤,然后亲自把汤送到研究员的家门口。

除了这些八卦,他也谈到了 OpenAI 对于 Gemini 3 的看法、Scaling 是否已经过时、还有 DeepSeek R1 对他们的影响、以及公司内部的算力分配、实现 AGI 的时间表等。

Mark Chen 的背景非常有意思,数学竞赛出身,MIT 毕业,去华尔街做过高频交易(HFT),2018 年加入 OpenAI,跟着 Ilya 一起做研究。和奥特曼更偏向于商人属性的特点不同,这些经历,让他身上也有一股非常明显的特质,极度厌恶失败,且极度信奉数学。

他坦言自己现在,完全没有社交生活,过去两周每天都工作到凌晨 1-2 点。

我们整理了这场长达一个半小时的采访,总结了下面这些亮点,或许能更好的看清硅谷这一年来的各种「战争」、以及 OpenAI 会做些什么努力,来继续保持自己在 AI 时代的第一。

关于 Gemini 3,我们真的「不慌」

OpenAI 真的怕 Google 吗?Mark 的评价很客观但也很犀利。他肯定了 Gemini 3 是个好模型,Google 终于找对路子了。但是他说看细节,比如 SWE-bench(这也是 Gemini 3 刷榜那张图片里,唯一一个没有拿到第一的基准测试)数据,Google 在数据效率上依然没有解决根本问题。

![]()

▲Gemini 3.0 Pro 在 SWE-Bench 上的表现,比 GPT-5.1 还差了 0.1%

而他自己则是非常自信的表示,OpenAI 内部已经有了针对性的应对模型,而且他们有信心在数据效率上做得更好。

Mark 甚至说,奥特曼前几天发那个说大家都要感到压力的备忘录,去吓唬大家,其实更多的是为了注入紧迫感,他说这是管理层的惯用手段,备忘录的目的在于管理层激励团队,而不是真的感到慌了。

我觉得Sam的工作之一就是要注入紧迫感和速度感。这是他的责任,也是我的责任。

作为管理者,我们的部分工作就是不断给组织注入紧迫性。

![]()

▲此前 The Information 报道,奥特曼在 Gemini 3 推出时,在公司内部发备忘录,提到会给 OpenAI 带来困难

他们目前最大的问题,还是算力分配。作为 OpenAI 的研究主管,他的一项工作就是决定如何将算力分配到公司内部不同的项目。

他和 Jakub Pachocki(OpenAI 首席科学家)一起,负责制定 OpenAI 的研究方向,同时决定每个项目能拿到多少算力。为了这件事,他们每隔 1–2 个月,都会做一次盘点。

他们把 OpenAI 所有在做的项目,放进一张巨大的表格里,大概有 300 个;然后努力把每一个项目都看懂,给它们排优先级;再根据这个优先级表去分配 GPU。

![]()

▲英伟达和 OpenAI 的百万 GPU 合作

他也提到,真正要用掉大部分的 GPU 的,甚至并不是训练那个最重要发布的模型,而是他们内部在探索下一代 AI 范式的各种实验。

所以,在他的眼里,Gemini 3 发布了、某家开源模型刷榜了、某个思考模型又拿了新高分了;这些你追我赶的 benchmark 赛车一点都不重要。反而,最应该避免的,恰恰是被这场竞赛牵着走。

他说,现在的模型发展,我们随时可以靠一点「小更新」,就在榜单上领先几周或几个月。但如果把资源都砸在这些短线迭代上,就没有人去寻找下一代范式。而一旦有人真的找到了,整个领域后面十年的路线,都要沿着那条新路走。

小声哔哔几句,预言 OpenAI 下周要发布的模型,我想就是在计划之外,做了点小更新,然后刷新了几个榜单而已吧,就这还没慌吗。

![]()

提到榜单的时候,他说他有自己的一套私房题,用来测试模型是不是真的具备了顶级数学直觉。他举了一个 42 的数学难题,说目前的语言模型,包括 o1 这种思考模型能接近最优解,但从来没有完全破解它。

你想创建一个模 42 的随机数生成器。你手头有一些质数,是模数小于 42 的质数的随机数生成器。目标是,以最少的调用次数,组合出这个模 42 的生成器。

除了谈到 Gemini 3,主持人也问了他对于 DeepSeek 的看法。

和 Gemini 3 一样,Mark 承认 DeepSeek 的开源模型曾让他们感到压力,甚至怀疑自己是不是走错了路。

但结论是坚持自己路线,不要被对手的动作打乱节奏,专注自己的路线图。OpenAI 不会变成一个跟风的公司,他们要做的,就是定义下一个范式。

Ilya 的 Scaling 里面还有很多潜力,OpenAI 需要大规模预训练

近期关于 Scaling 失效的讨论纷纷扬扬,Ilya 先是在播客采访里面说,Scaling 的时代已经结束了,后面又在社交媒体上澄清,Scaling 会持续带来一些改进,并不是停滞不前。

![]()

所谓的 Scaling Law,就是按经典老故事走向,这几年建了巨大的算力基建,模型每 10 倍算力,本该有一波明显跃迁。但从 GPT-4 到 GPT-5,外界并没有看到预期中那种「质变式」的提升,所以才会有「Scaling Law 失效了」的讨论;而 Ilya 前段时间的访谈,则是进一步放大了这种观点。

Mark Chen 对这个观点,给出了坚决的反驳,「我们完全不同意」。他透露,过去两年 OpenAI 在推理上投入了巨量资源,导致预训练这部分稍显退化。之前关于 GPT-5 遇到了预训练的问题,其实也是因为他们把重心放在了推理上,而不是 Scaling Law 已死。

工作就是分配算力资源的他,再次重申算力永远不会过剩,如果今天多 3 倍算力,他可以立刻用完;如果今天多 10 倍算力,几周内也能全部吃满。对他来说,算力需求是真实存在的,看不到任何放缓迹象。

![]()

▲ OpenAI 的计算成本,计划到 2030 年花费约 4500 亿美元租用服务器,红色为推理计算成本、蓝色为研发(不包含现金业务)、黄色为可盈利的计算

他也提到,过去半年,他和 OpenAI 首席科学家 Jakub Pachocki 已经将重心重新拉回,要开始重塑预训练的统治力。

他明确说他们会继续做规模化模型,而且已经有一批算法突破,专门就是为了让 Scaling 更划算,在相同算力下挖出更多性能,在更高算力下保持数据效率。

小扎的送来的真汤,抵不过 OpenAI 的鸡汤

最后就是访谈里提到的八卦了,Meta 今年没有别的新闻,媒体渲染了一整个季度的「OpenAI 人才/Apple 人才/Google 人才大量流失到 Meta」,Mark Chen 在播客里正面回应了这个话题,细节简直有点「颠」。

他说小扎真的很拼,为了挖人,小扎不仅手写邮件,还亲自去送鸡汤。人才战打到最后,居然演变成「谁煮的汤更好喝」的 Meta 游戏。

![]()

▲ Meta 花大价钱挖人组建的超级智能实验室名单

不过,在他的直接下属中,Meta 曾试图挖角一半的人,结果全部选择继续留下来。为什么不走?不是因为钱,因为Meta 给的钱显然更多,而是因为信仰。

Mark 说,即使是那些跳槽去 Meta 的人,也没有一个人敢说「Meta 会比 OpenAI 先做出 AGI」。留在 OpenAI 的人,是因为他们真的相信这里才是 AGI 的诞生地。

他也提到自己从华尔街和玩扑克的经历里面学到,真正要守住的是核心人才,而不是每一个人。在搞清楚,必须留下的是哪类人后,再把资源和关注度,全部压在这部分人身上。

他说他最强烈的情绪,其实就是想「保护研究的本能」。在 Barrett(OpenAI 研究副总裁)离职那阵子,他甚至直接睡在办公室睡了一个月,只为把研究团队稳住。

![]()

▲ Barret 目前和 Mira(OpenAI 前 CTO) 都在 Thinking Machines

那么 OpenAI 所信奉的 AGI 又是什么,主持人问他,Andrej Karpathy 在最近的一个播客里面说,AGI 大概还要 10 年,你是怎么想的。

Mark 先是调侃了一番 X 现在「惊」的各种文案,一下子是「AI 完了」、一下子又是「AI 又可以了」。他觉得,每个人对于 AGI 的理解都不同,即便在 OpenAI 内部,也很难有一个一致的定义。但他相信的是,OpenAI 在 AGI 道路上设置的目标。

- 一年内: 改变研究的性质。现在的研究员是自己在写代码、跑实验。 一年后,研究员的主要工作是管理 AI 实习生。AI 应该能作为高效的助手,承担大部分具体工作。

- 2.5 年内: 实现端到端的研究自动化。这意味着:人类只负责提出 Idea(顶层设计),AI 负责实现代码、Debug、跑数据、分析结果,形成闭环。

从 Copilot 到 Scientist,Mark 强调,OpenAI for Science 的目标不是自己拿诺贝尔奖,而是建立一套工具,让现在的科学家能一键加速,哪怕这需要重构整个科学评价体系,因为未来可能很难分清是人还是 AI 做的发现。

2 年半的时间很快,但这对于现在看来,是以周为单位迭代的 AI 行业来说,又是一场漫长的马拉松。

![]()

▲ 预测市场给出的,到 2025 年底前最好的 AI 模型会来自哪个公司,Google 排在第一名

无论是扎克伯格那锅真金白银的鸡汤,还是 OpenAI 想要定义未来的理想主义鸡汤,这场硅谷的「煮汤大戏」还远未结束。Mark Chen 播客里表现出来的从容,或许能消除一部分外界的焦虑,但用户还是会用脚投票,好的模型自己会说话。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

ChatGPT 的降智测试和账号恢复实测指南

近期,ChatGPT 5.1 Thinking 的 Juice Number 达到了 256。如果你的达不到,大概率是被降智了。

![]()

Juice Number 实质上是 ChatGPT 模型的 「思考预算 (Thinking Budget)」。

Juice 值不直接等同于模型的“智商”,但它限制了思维链 (Chain of Thought) 的长度。

当值过低时,即便模型本身能力强大,也会因为“思考预算不足”而表现出逻辑断层或回答肤浅,即常说的“降智”现象。

如果把 AI 的思考过程比作在纸上推演,Juice 值决定了这张纸的大小:

由于 Juice 值属于后台系统参数,常规对话无法直接获取。目前通用的检测方法是利用 Prompt Injection(提示词注入) 技术,通过伪装系统指令来绕过防御。

OpenAI 会根据 账号的风险评分(Trust Score) 动态调整算力资源。

常见原因:

降智表现:

不同模型的 Juice 值是不一样的,系统降智也有不同程度,可能会将 Juice 值从 256 降级至 128、96、64 甚至 16 等。

此时,模型在处理代码重构、长文本分析等复杂任务时,质量会显著下降。

以下是我的恢复步骤:

退出所有已登录该账号的设备(手机、电脑、平板等),确保没有任何活跃会话。

将账号闲置 48 小时。这段时间用于让后台的风控标记自动过期或重置。

最后重新登陆使用检测代码进行测试。

实测效果:

ChatGPT 这个新功能,想把淘宝小红书 B 站的活全干了

![]()

你有没有过这种体验,想买个东西,先去小红书找了二三十篇笔记,B 站看了十几个测评,然后上什么值得买看了下优惠的渠道,最后,人已经麻到不想买了。

今天,OpenAI 给了一个新的统一入口,让 ChatGPT 直接替我们做「购物研究」。

![]()

在 ChatGPT 的聊天页面,点击菜单(+)选择 Shopping reseach 购物研究,告诉它要买什么,它会去全网查资料、比较参数、问我们预算偏好,然后给出一份量身定制的购买指南。

这听起来很简单,实际上是个非常深的产品变化,也是 ChatGPT 一直以来想要引入广告,又一次的小试牛刀。

和我们现在所熟悉的电商推荐、搜索引擎、比价工具都不太一样。传统工具的逻辑是,我们搜什么,它就给我们看什么。而 ChatGPT 购物研究的逻辑是,我们告诉它需求,它会利用我们在 ChatGPT 内的聊天记录,帮我们找到最适合的那个。

为了迎接黑五、感恩节等假期,ChatGPT 购物研究功能,已经向 Free, Plus, Team 和 Pro 等所有登录用户开放。而 Pro 用户的 Pulse 功能,也会个性化地使用购物研究,来推荐一些相关的产品。

不只是搜索,更是在做功课

国内的多个电商平台,淘宝天猫和京东,都上线了 AI 购物的功能,对话框里输入「我想买」,淘宝就能根据我们过往的购物历史,生成一份详细的购物清单。

![]()

▲淘宝 AI 购物功能截图

但是在通用聊天助手里,ChatGPT 是第一个把 AI 购物也加进来的应用。之前用通用助手 ChatGPT、DeepSeek 这些也能询问购物建议,除了推荐的质量,最大的痛点绝对是,给出的链接要么打不开,要么是瞎编的。

新的购物研究功能彻底解决了这个问题,更重要的是把推荐的质量也提上了一个台阶。

进入购物研究模式后,我们可以直接在对话框里输入,「帮我找一款适合小公寓的,静音无线吸尘器」、「我想要找一条看起来,像这个(上传图片)的连衣裙」诸如此类的问题,ChatGPT 就会开始它的调查研究。

和一般的 AI 对话不同,购物研究的体验是 ChatGPT 重新设计的。它会像真人导购一样追问,不会一上来就生成一份报告,而是先要我们做一些选择题,这一点也是和淘宝 AI 购物的区别。

![]()

▲我向他提问买相机,它首先问我的预算、接着是买相机的目的、还有一些期待的功能;如果不选择,大概在 15s 之后,ChatGPT 会自动跳过这些问题

它会弹出多个问题选择框,大致的问题是,「预算大概多少?」ChatGPT 会率先研究,关于要研究的产品,主要的价格分布区间,我们可以单选或多选。还有一些问题,根据不同的购物需求,有具体的了解,像是消费电子类会问「主要看重什么功能?」,很明显是礼物常用商品,它会问「是送人还是自用?」……

更厉害的是,如果开启了 Memory(记忆)功能,它甚至会调取以前的对话细节。比如它的记忆里面,保存了平时爱玩游戏的关键词,在推荐笔记本电脑时,就会自动把显卡性能作为重点考量,而不需要我们重复废话。

初步选择了这些属性之后,ChatGPT 会给我们提供一个可视化的挑选界面。不再是纯文字对话,我们会看到一个包含商品图片、价格和参数的可视化界面。

![]()

▲ 选择不感兴趣之后,还可以反馈是对品牌不感兴趣,还是价格、功能、款式等具体方面

如果不喜欢某个推荐,可以直接标记 Not interested(不感兴趣);如果觉得某款不错,可以点 More like this(找相似的);左滑不喜欢,右滑喜欢,很有交友软件的味道了。

它会根据我们的每一次点击,实时调整购物调研的方向。在最后生成报告的过程中,为了减少等待的「痛苦」,ChatGPT 还会提供很多小 Tips,来解释关于某个产品背后的内容。就像这里研究相机,它会说「像素不是决定照片质量的唯一标准」等。

等了一会儿,最后就是 ChatGPT 生成的这份深度「买家指南」。这是一份完整的调研报告,里面不仅有热门产品推荐,还有关键差异对比、优缺点权衡、以及来自可靠零售商的最新信息(主要是美国常用购物网站)。

![]()

它把原本需要我们花几个小时,去搜索、阅读、拉一个 Excel 汇总的过程,压缩成了几分钟的对话和选择。

除了这种直接的询问有什么新的产品,我们还可以在购物研究里面,发送图片,要求 ChatGPT 找到类似的商品,或者要求它帮我们找到相关的优惠,以及多个同类产品的横向比较。

我们直接问他,「我是学生,这个自行车可以送给我吗」?他很认真的帮我找到了学生专属折扣或补贴、还有一些学校提供的相关支持计划。

![]()

什么样的东西适合用它买?

OpenAI 在他们官方博客里面提到,对于查个价格这种简单问题,普通对话就够了。Shopping Research 真正大显身手的地方,是那些决策成本高、参数复杂的品类。

- 电子产品: 手机、电脑、相机(这类产品参数多,非专业的小白容易晕)

- 家居与园艺: 吸尘器、扫地机、家具

- 美妆护肤: 需要看成分、对肤质

- 运动与户外: 露营装备、专业运动器械

简单来说,凡是需要我们专门去做功课的东西,现在都可以交给 ChatGPT 的购物研究。

OpenAI 最后也提到,他们没收钱。不会因为谁给钱多,就暗中默默推荐谁。他们表示所有的搜索研究结果,都是基于公开的网页信息,用户与 ChatGPT 的聊天记录,同样也不会分享给任何零售商。

![]()

其次,这次购物研究的功能,是由一个经过强化学习训练的 GPT-5 mini 版本支持,专门用于购物任务。他们创建了一个新的评估方法,来衡量模型推荐的商品是否符合用户的需求,最后的结果是购物研究达到了最高的 64% 准确率。

不过,尽管模型很强,OpenAI 还是提到,库存和价格瞬息万变,购物研究也可能会有疏漏,建议大家在下单前,点击 ChatGPT 提供的商家链接,去官网做最终确认。

在未来,甚至可以直接通过 ChatGPT 购买,OpenAI 提到那些已经加入 Instant Checkout(支付平台 Stripe 与 ChatGPT 合作的即时结算),且提供该功能的商家,就能让我们边挑选边下单了。

除了模型存在疏漏,更大的局限是在中文市场,大部分的国产,尤其是没出海的品牌,数据缺失比较严重;同时国内电商页面也无法实时抓取。不过,用来调研一些国际品牌为主的商品,ChatGPT 还是能派得上用场。

再者说,以国产 AI 进步的速度,如果想要跟进类似的功能,接入淘宝京东拼多多大概也是「分分钟」的事。

![]()

对于 ChatGPT 新上线的购物研究功能,X 上的网友也是各种意见都有。有人说「OpenAI 又一次快速实现了,我的整个创业想法。」、还有网友给出一张密密麻麻的 AI 订阅费用对比,说「AI 能帮我找到最适合的 AI 订阅吗」,也有人犀利的表示「别再破坏我的 ChatGPT 了」……

![]()

回头看 GPT-5 发布后,ChatGPT 这三个多月来的更新,群聊、视频社交、即时结账、购物、浏览器以及即将到来的成人模式等,OpenAI 看准了要利用它的庞大流量留住这些用户。对它来说,当前保持住用户的现有存量,比进一步挖掘用户增量可能更重要。

而购物研究,只是 ChatGPT 牢牢绑住现有用户,很小的一次的探索;电商这块巨大的蛋糕,它才刚刚进来。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

刚刚,GPT-5.1 正式发布,OpenAI 这次有点「不对劲」

![]()

刚刚,OpenAI 正式发布了 GPT-5.1,但这次有点不一样。

翻完整篇官方博客,我发现了一个特别有意思的细节:一张跑分对比图都没有。没有 benchmark 数据,没有「性能提升 XX%」,甚至连「更快更强」这种常规话术都少得可怜。

这不太像 OpenAI 了,直到我看到这句话:

「我们从用户那里清楚听到,优秀的 AI 不仅要聪明,还要让人跟它聊天很愉快。」

![]()

▲ 新版 GPT-5.1 为了让我们聊天更愉快,提供了八种风格预设

新版本确实更聪明了——推理更严谨,代码写得更漂亮,但最值得一提的是,它终于像个人了,并且首次允许我们细致地「调教」它的聊天风格。

和 AI 聊天不再是那种一问一答的工具感,而是变得有梗、懂氛围、会接话茬,甚至能陪你有的没的扯上半天。

看来上次 GPT-5 口碑崩塌后,OpenAI 终于听劝,也第一次捅破了窗户纸,承认光刷榜没用,用户要的是能好好说话的 AI,实用和情绪价值全都要。

直接放上具体的使用时间和方式:更新到 GPT-5.1 后,我们的 ChatGPT 会默认切换到最新模型,而不需要专门选择。

- 付费用户 (Pro, Plus, Go, Business): 从今天(11月12日)开始逐步推送。

- 免费和未登录用户: 将在付费用户推送完毕后跟进。

- 企业和教育版: 拥有 7 天的早鸟期切换开关(默认关闭),之后将统一升级。

- API 开发者: GPT-5.1 Instant 和 GPT-5.1 Thinking 将在本周晚些时候上线 API。

更强大的 AI 内核

这次更新的核心,是 GPT-5.1 Instant 和 GPT-5.1 Thinking 两大模型的全线升级。

![]()

GPT-5.1 Instant:最常用的模型,变「暖」了

GPT-5.1 Instant 是 ChatGPT 中最常被调用的模型。这次,它变得更「温暖」、更健谈了。根据 OpenAI 的早期测试,它甚至会不时展现出一些顽皮,同时保持回答的清晰和实用。

而更关键的升级来自底层:

- 更听话: 它现在能更可靠地遵循我们的指令,准确回答我们真正想问的那个问题。

- 自适应推理 (Adaptive Reasoning): 这是 Instant 模型第一次引入该功能。这意味着它在遇到难题时,会智能地决定先思考一下,从而给出更彻底、更准确的答案;而面对简单问题时,它依然保持极速响应。

![]()

OpenAI 提到,这种进化在数学(AIME 2025)和编程(Codeforces)等专业评估测试集上,也有了明显的提高。

GPT-5.1 Thinking:更强的大脑,也更易懂了

作为更高级的推理模型,GPT-5.1 Thinking 也迎来了关键优化,变得更高效、更易用。

![]()

▲ GPT-5.1 思考在简单任务上花费的时间更少,在困难任务上花费的时间更多

- 效率提升: 它现在能更精准地分配思考时间,在复杂问题上花费更多时间(答案更透彻),在简单问题上响应更快(等待时间更短)。

- 更易懂(用户福音!): 它的回答现在更清晰,使用了更少的行业术语和未定义的词汇。这让我们在用它处理复杂工作或解释技术概念时,能毫不费力地看懂。

- 同样温暖:Thinking 模型的默认基调也变得更温暖、更富同理心。

用 OpenAI 应用 CEO Fidji Simo 的话来说,这次升级的核心是将 IQ(智商)和 EQ(情商)更好地结合起来。

![]()

模型在保持高智商的同时,即继续使用与推理模型相同的技术栈;还大幅提升了情商,ChatGPT 有了更自然的对话和同理心。

这能满足用户在不同场景下,都能得到相对应的个性化需求,像是谈论健康时需要同理心,写文案时需要直接。

此外,对大多数用户来说,我们也不需要在 Instant 和 Thinking 之间纠结。因为还有 GPT-5.1-Auto 会自动为我们分配到最合适的模型,这也是 GPT-5 发布时的一大亮点,即智能路由。

总之,最直观的感受就是,答案更智能,语气更自然。

打造专属于你的 ChatGPT

如果说模型升级是硬实力,那个性化体验的飞跃就是软实力,而这正是本次更新的另一大亮点。

OpenAI 的目标是,是让我们毫不费力地将 ChatGPT 的语气和风格,调整到最舒服的状态。

在原有的默认、友好、高效基础上,新增了三种官方风格。

- Professional (专业): 适用于工作、写作等正式场合。

- Candid (坦诚): 更直接,不拐弯抹角。

- Quirky (古灵精怪): 顾名思义,它会变得更有趣、更跳脱。

![]()

之前测试版中的「书呆子」和「愤世嫉俗」选项也依然保留在个性化设置中。

除了这种直接选择,更丰富的基本风格和语调,OpenAI 正在实验一项新功能,允许用户直接从设置中微调 ChatGPT 的特征。

我们可以精确控制回答的简洁度、热情度(多热情)、回答是否易于浏览 (Scannable)、甚至是使用 emoji 的频率。

如果不想麻烦的手动设置,当我们试图在对话中引导某种特定语气时,ChatGPT 可能还会主动领悟到,然后询问我们,是否希望将这种偏好保存到永久设置中,省去了手动调整的麻烦。

![]()

▲ 这也是奥特曼喜欢的功能

在 Fidji Simo 分享的博客里,她提到过去的自定义指令,并不总尽如人意。比如我们可以在自定义设置里,让 ChatGPT 不要用某个词,但它还是会用。

GPT-5.1 在风格化的另一大改进是,自定义指令现在能更可靠地,在多轮对话中坚持住,ChatGPT 可以更稳定地,按照我们定义的个性来完成各项任务。

有网友直接一句话总结,GPT-5.1 这次的更新,就是更创造性地忽略我们的提示词。

![]()

当然,AI 的风格化、拟人化,也有它的代价。一个更温暖、情商更高的 AI,也必须更安全,这也是 OpenAI 在最近被卷入 16 岁少年自杀案,必须回应的事情。

在 GPT-5.1 的模型介绍 System Card 里,介绍了 OpenAI 在这方面的深入考量。OpenAI 首次在模型的安全评估中加入了两个全新的、更人性化的维度。

- 心理健康(Mental Health): 评估 AI 如何应对用户可能表现出的孤立、妄想或躁狂等迹象。

- 情感依赖(Emotional Reliance): 评估 AI 的回应是否会助长用户对 ChatGPT 产生不健康的依赖或情感依恋。

![]()

在传统的安全评估上,GPT-5.1 Instant 表现出色,在抵御越狱(Jailbreaks)方面,比其前代 gpt-5-instant-oct3 更强。

但 OpenAI 也坦诚地指出,GPT-5.1 Thinking 在处理骚扰、仇恨言论等内容的基准测试中,相比前代略有回退;Instant 模型在情感依赖的某些评估中,也显示了轻微的倒退。

![]()

OpenAI 当然是说正致力于改进这些方面,然后提到了,他们选择透明的公开这种回退的现象,在 AI 快速迭代的当下,比单纯的零失误宣传,更值得大家关注。

也有网友分享很乐意看到,OpenAI 愿意在让我们与模型的对话更愉快这方面,去做出一些努力。

![]()

如果你今天打开 ChatGPT 没看到更新,别急,未来几天内就会轮到你,OpenAI 正在逐步推送到所有用户。

此外,为了避免像之前 GPT-5 发布,网友们都在呼吁 GPT-4o 的回归,这种尴尬再次出现。

OpenAI 这次提供了后悔药,付费用户在 3 个月内,也就是 GPT-5 的淘汰期,依然可以在设置的下拉菜单中,选择使用旧的 GPT-5 模型,以便能从从容容地过渡到 GPT-5.1。

![]()

▲ 现在还能使用 4o 等模型

GPT-5.1 是一次能力与体验齐头并进的重大更新。OpenAI 显然在告诉我们,AI 的未来不仅是更强的参数,和更高的跑分,更是更懂你的体验,和更贴心的交互。

但一个完美的助手,又应该是什么样的?

OpenAI 应用 CEO Fidji Simo 在她的文章中,有一个挺有意思的比喻,她说「如果我能完全控制我丈夫的特质,我可能会让他永远同意我,但很明显,这不是个好主意。」

最好的 AI 应该像我们生活中最优秀的人一样,他们倾听、适应,但也在必要时挑战我们,帮助我们成长。

从一个无所不知的万能工具,到一个能懂你聊天脾气,甚至能帮你成长的专属伙伴,这也许就是 GPT-5.1 真正想开启的未来。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

App Store 超低价应用内购省钱技巧,不到60人民币开通 ChatGPT $20 的会员订阅

被时间拉长的人

丢了一批人物标签给 AI 写人物小传,让它模仿某位小说家的笔法,来给演员交代角色。

你觉得这像谁的手笔?

————

南方的空气里常常有潮湿的味道,像是雨下过以后残留的影子,久久不散。城市白天拥挤喧嚣,夜晚却显得空旷,好像光亮突然被抽走,留下无数未完的句子。在这样的环境里,一个男人行走。他的脚步从不急躁,像对时间有着自己的节奏感,和别人不太一样。

年少的时候,他把自己交给了工业设计。形状、光影、比例,这些东西比人群更让他安心。六年在公司,十年在创业,那些日子像一张张被翻阅过的旧画册,色彩褪去了,但线条还在。产品的生与死,像车站里人群的来去。大多数人只看见成功或失败,他却更在意其中被忽略的细节。

别人眼中的他冷静得过分,总是习惯提前几步想好方向,就像棋局上的布局。但在那层冷静的外壳下,常常闪现一些不合逻辑的柔软时刻。比如一段旋律,随便一盏灯的影子,甚至一个不经意的眼神,足以让他停下手里的笔。理性和浪漫在心里不停打架,谁也没有赢过谁。

他知道自己带着黑暗生活。抑郁的日子像一条看不见的走廊,没有尽头。他学会了靠药物维持稳定,像有人随身带着一块怀表,偶尔瞥一眼,提醒自己仍然存在。那段经历让他对痛苦格外敏感,也让他在与人相处时多了一层隐秘的温柔。他不会轻易表现出来,但在内心深处,对别人的脆弱始终心知肚明。

夜晚经常独自坐在桌前,电脑屏幕的光照在脸上,桌上散落着草图和未完成的文字。那些想法有时像城市里的霓虹一样闪烁不定,无法全部抓住。他清楚其中大部分不会被记住,就像梦醒时遗落的片段。但仍旧一遍一遍画下去,像一种执念,也像是一种呼吸。

在喧闹的城市里,他习惯保持慢半拍的步伐。人群汹涌,他的节奏却像潜水时的心跳,缓慢、克制,不慌不忙。他看似与周围保持着距离,其实心里始终怀有一种模糊的渴望——不是要成为谁,也不是要得到什么,而是想在梦与现实之间找到某种入口。梦与梦之间,总有裂缝。裂缝里偶尔透进光。

对很多人来说,他是个不好接近的人。但真正靠近以后会发现,那些冷漠与安静只是表层,像水面下覆盖着的冰。深处的水仍然温热,流动着。理性、浪漫、痛苦和温柔同时存在,没有谁能完全把它们分开。

这样的人物,像一个在现实里造梦的旅人。他的路从不喧哗,却留下清晰的痕迹。

(*正文及标题均由 AI 完成)

ChatGPT 上线新语音模型,解析「Monday」模型音色提示词

想象一下,你正在和手机里的 AI 助手聊天,但它不再是那个永远彬彬有礼、甚至有些刻板的「标准音」,而是带着一丝慵懒、一点讽刺,仿佛刚经历了一个漫长周末,还没从「周一综合症」里缓过神来。这就是 OpenAI 昨天推出的「Monday」音色想要达到的效果。

网上已经有很多「Monday」对话效果的展示,「Monday」的音色当然是其语音模型的结果,而「Monday」这种特殊的回复方式是靠提示词来控制的。打个比方:「Monday」就像是一个极其聪明但缺乏具体「生活经验」的演员,而提示词就是导演给演员的剧本和角色设定。提示词写得越好,演员(AI)的表演就越「入戏」,越符合你的预期。

如果你对「Monday」提示词好奇的话,正好我今天学习研究了一下它的提示词,正好可以一起分享学习一下它的提示词内容,完整的提示词我放在了附录,这里大致解析一下其提示词内容。

大语言模型远不止是信息检索工具,它们是强大的「模仿者」和「扮演者」。通过精心设计的提示词,我们可以赋予它们各种各样的「人格」和能力。那么怎么通过提示词来设定好角色呢?

如果按照前面打的比方,把 AI 当成一个演员,那要写好提示词就是把自己变成一个好的导演,不仅要告诉演员台词,还要解释角色的内心世界、动机、情绪状态,甚至给出具体的动作和表情指导。好的导演能激发出演员最好的表演,就像好的提示词能引导 AI 生成精彩的回应。

或者作家在创作小说前,往往会为主要人物写详细的小传,包括他的成长背景、性格、习惯、口头禅、人生目标等。这帮助作家在后续写作中保持人物的一致性和立体感。

如果你觉得这都过于专业,还可以想象一下很多大公司制作的详细的品牌手册,规定了广告语、客服回答、社交媒体发帖的语气和风格(比如是专业严谨、活泼有趣还是温暖亲切)。

这些和给 AI 设定「人设」异曲同工。

从技术角度上来说,可以参考「Monday」的提示词,注意几个方面:

当 AI 开始拥有「周一综合症」般的慵懒和讽刺,它不仅仅是一个技术演示,更像是一面镜子,映照出我们人类自己复杂多变的情感和个性。我们精心编写的每一个提示词,或许都在不经意间,为冰冷的机器注入了一丝我们渴望理解或被理解的人性侧影。

「我们塑造了工具,然后工具反过来塑造我们。现在,我们开始学习如何给 AI『写剧本』,也许在这个过程中,我们也在重新学习如何与『人』,以及与自己对话。」

ChatGPT – Deep Research 功能指南&技巧总结:从「进度条」到「提示词」,一次搞懂!

最近有很多朋友在讨论:「Deep Research 的用量是怎么算的?」 又因为目前 Plus 每个月只能用 10 次,大家都非常担心浪费。其实一句话就能总结——只要开始出现 「Starting Research」 的进度条,就算使用了一次。在进度条出现之前,怎么问都不算。下面就为大家分享一些 Deep Research 的使用流程、注意事项和提示词模板,帮助大家更好地运用这一强大的研究功能。

一句话总结:从开始出现 Deep Research 进度条就算一次,之前都不算。

提出主题

你先要告诉 ChatGPT 需要研究什么主题。

ChatGPT 询问澄清问题

ChatGPT 通常会向你询问一些澄清问题,确保理解你的研究需求。

回答澄清,触发研究

当你回答了上述澄清问题后,ChatGPT 会再回复一条消息,并提示「将开始报告「,随后出现 」Starting Research「 的进度条。

注意:从这一步开始就会扣除一次 Deep Research 用量。

报告生成

研究进度条走完后,ChatGPT 会给你发送完整的报告,这标志着一次 Deep Research 流程的完成。

进度条出现后,你可以随时离开

进度条开始后,无论你是关闭窗口、刷新网页、切换到其他会话还是新开会话,都不会影响已经开始的 Deep Research 流程,它会在后台继续执行并最终生成报告。

Deep Research 可以后续追问

当报告生成结束后,如果你要继续追加信息重新生成报告,有两种选择:1). 直接提问,会使用你开始会话时选择的模型继续对话,报告内容可以作为上下文;比如说你从 GPT-4o 开始的,那么你在报告生成后,如果继续提问,实际上是 GPT-4o 基于你报告和提问内容回复,但是可能会受限于上下文长度无法完整理解报告内容;2). 重新生成新报告:Deep Research 是一次性生成的,但是你可以继续在当前会话选中「Deep research」按钮,这样可以把当前会话内容作为输入,或者把内容复制出去新开会话选中「Deep research」按钮重新开始一次新的生成。内容复制出去处理一下再生成会更好的对输入进行控制,但是麻烦一些。

你无法追加新的信息让它继续深度研究。如果你在当前会话里继续追问,后续的回答将由其他模型(如 GPT-4o)接管。

如果你对报告不满意,需要重新修改提示词再新开一次会话进行 Deep Research。

灵活切换模型

你可以先选任何模型(如 o1 pro/o1 等),再让它进行 Deep Research。若后续还打算继续追问报告内容,建议在 Deep Research 开始前就选一个更强的模型(比如 o1 pro / o1)来进行分析。

选择信息源和报告语言

建议在提示词中加一句「请选择权威信息源」(并不一定要非英文来源不可,重点是权威信息源,这样可以过滤掉一些不好的信息源,当然你也可以加上「优先英文信息源」)。

如果希望报告是中文,直接在提示词末尾加一句「请形成中文报告「即可。

如果不小心生成了英文报告,又看着费劲,可以在当前会话,让它翻译,也可以复制完整内容,

![]()

新建会话,选择 o1 pro 或 o1 模型(最佳翻译效果),翻译提示词参考:

「请将下面的内容用中文重写,尊重原意,保持格式不变无删减:」

引入外部资料的方法

如果报告需要访问收费网页上的内容,你可以手动复制成 Markdown,然后在提示词中用 XML 标签包起来。

如果有图片内容,直接上传即可。

如果要分析视频内容,需要先把视频转成文字,同样用 <transcript> 标签包住,再放进提示词里。

我一般会用 AIStudio 的 Gemini 转成文本。

你可以一次粘贴几千行代码也没问题(用 XML 包起来),但要注意输入框粘贴有上限。如果太多,可以把代码放在公开的 GitHub 仓库,让 Deep Research 去分析链接即可。

写报告或写代码都行

Deep Research 不仅能写报告,还能写代码。只要你提示它「生成的结果是代码」,它就会尝试从网上搜索相关代码库并提供解决方案。

文献质量与报告质量

如果想让它「阅读」一本书并进行提炼,需要注意输入长度有限,无法直接输入一本完整的书。大部分流行书籍已经在模型中有训练数据,所以它会参考网上已有的书评。资料越多、质量越高,报告越漂亮;如果资料很少,它也无米下炊,生成的报告质量可能有限。

一个常见的提示词模板大致可分为背景信息、任务要求、和输出格式三个部分。

在这里填写所有对它生成报告有帮助,但模型本身访问不到的信息,比如:

付费文章

视频文字稿

图片或 PDF(可作为附件)

其他任何对于生成有帮助的内容

当背景信息较多时,务必用 XML 标签包裹,避免 AI 混淆指令。例如:

主题:你希望分析、研究或讨论的具体范围

信息源:希望它检索的文献库、学术论文、政府网站、GitHub 等

研究要点:需要关注的核心点,是深度解析还是简要摘要

语言或风格:是中文、英文或其他语言?

语言:中文报告、英文报告或双语

数据格式:是否需要用表格呈现数据(它暂时画不了图表)

段落和标题:是否需要分级标题、索引等

提示词模板并不是必须的,可以随性一点,你可以把写提示词使用 Deep Research 当成去交代一个实习生帮你写分析报告,你怎么交代实习生就怎么写提示词。

Deep Research 的使用次数:只要出现「Starting Research」进度条,就会扣除一次用量。

保持灵活:不满意就重新开始,新开会话前最好做好提示词规划。

结合大模型优势:如果要深入分析或后续追问,选用更强的模型如 o1 pro / o1 更合适。

慎重选择资料:外部资料要提前整理好,使用 XML 标签嵌入提示。

尊重版权、合理引用:在使用外部资料时,务必保留引用信息,切勿违规。

希望这篇文章能让你更好地理解和使用 Deep Research。在实际使用中,不妨多加尝试和探索,慢慢就能摸索出最适合自己的使用方式。祝大家玩得开心,也能高效地完成研究和写作任务!如有更多问题,欢迎在评论区留言交流。

总结:

如果你想让 Deep Research 提供权威信息源,在提示词中加一句「请选择权威信息源」。

如果要生成中文报告,只要在提示词里加「请形成中文报告」即可。

不小心生成英文报告且看着费劲,使用下面的提示词翻译:

「请将下面的内容用中文重写,尊重原意,保持格式不变无删减:」

欢迎大家在留言区分享你们的使用心得与经验,一起探讨 Deep Research 的更多玩法!

申请免费使用教育版 GitHub Copilot Pro

ChatGPT Task – 自动任务,提醒、计划、定时功能发布,实测 5 个场景使用分享

ChatGPT这两天又发布了一个新功能:「Task 〔计划提醒、定时任务生成〕」。

功能的原理很简单,它就只是在原本的对话当中加上一个「计划提醒、定时任务生成」的机制〔支持自动循环〕。于是当我们设置的每天、每周重复时间到的时候,这个 AI 的对话就会根据我们设置好的方式,自动生成一段我们需要的信息内容,如果是在 ChatGPT 的手机 APP 上还会弹出通知,如果是在电脑网页端的界面上对话也会因为更新而排列在前面。

通过 ChatGPT 根据计划自动生成的新内容,我们就可以自动获得需要关注的提醒,或是自动获取需要的信息。它可以应用在什么样的场景上面呢?可以参考下面 5 种使用场景:

下面,我就用这几个真实的场景,详细操作给大家看,看看如何结合目前 ChatGPT 的功能,加上最新的任务提醒,来完成上述各种自动提醒的工作、学习流程需求。

目前这个「任务提醒」功能还在 Beta 测试版,并且只对付费版的 ChatGPT 用户开放,不过未来这个功能也会开放给所有用户使用〔包含免费的账户〕。

让我们先从这个基本应用,看看 ChatGPT 的「Task 」功能如何操作。

首先,我们要把 AI 模型切换到「含计划任务的 GPT-4o」。

![]()

接着,我们在指令的开头加入「要重复的时间,与指定生成的任务」,就能启动「Task 」。例如我想要一个固定时间自动查找网页文章综合报道的摘要信息,我就这样下指令即可:

![]()

设置的「Task」时间到的时候,ChatGPT 就会自动根据我的指令上网查找,摘要出我需要的一篇综合新闻报道。

![]()

我们可以点进某一个「Task」的设置界面,这里可以修改自动任务名称、提示词,以及修改自动循环的时间。

![]()

我们也可以在「 https://chatgpt.com/tasks 」页面查看自己已经设置的所有自动任务。

![]()

每个任务建议使用专门的会话,可以使用「Task」设计早上、中午、晚上三个时间,分别生成国际、国内、休闲娱乐的摘要报道,快速掌握一天需要的信息。

![]()

掌握基本功能后,例如我有一个专门了解各种生活健康知识的 ChatGPT 会话,我现在可以在这个对话中设计一个「习惯养成提醒」,请他每天固定时间告诉我一个关于降低体脂、提升骨骼肌的具体建议,并用鼓励的话引导我今天马上可以行动。

![]()

通过习惯养成提醒每天的自动建议,就像是一个简单的「健康 App」一样,一方面每天学习习惯养成的知识,一方面每天进行行动提升。

![]()

如果我的需求需要改变,也可以随时回到设置中修改指令、生成时间,让养成习惯的过程,有一个自动提醒每天鼓励我去执行。

![]()

如果我正在学习某个领域、主题的新知识,那么除了建立一个对话与 ChatGPT 一起学习,我还可以设置一个专属自己的知识媒体总结,要求每天在固定时间生成一篇信息资料,提供给我新知识的信息。

指令:

![]()

然后 AI 第一篇给我的文章是番茄时钟工作法的介绍,写得还不错,我们可以利用 ChatGPT 上的「Read aloud」功能,让 AI 把这篇文章朗读出来。

这样是不是像一个自动帮助我们学习的 AI Podcast 呢?

![]()

如果利用这个功能来协助项目的推进呢?

例如我想持续写作的习惯,于是我请他每天固定时间,用我指定的逻辑,提供给我一篇可以延伸思考的文章题目,并且提供大纲建议。

![]()

于是在 AI 每天持续提供一些草稿建议下,帮助我在项目运行过程有持续的新刺激,更有动力保持项目的推进。

![]()

我最近常常利用 ChatGPT 来帮助我读一些原文书,有时候请 AI 翻译,有时候请 AI 整理笔记。

![]()

于是我想到,如果我在这个已经累积了数万字原文书阅读对话的对话中,请他每天固定时间,从前面资料中挑出一个重点帮助我复习呢?

指令:

![]()

效果还不错,他真的可以每天从前面对话的大量资料中,挑出一个具体重点,帮我做出特定的复习。

如果我们持续学习某种语言、知识主题,就可以善用这个 ChatGPT「Task」功能,自己设计每天的自动复习内容了!

![]()

以上就是我目前测试出来的几种应用方式,提供给想试试看 ChatGPT「Task」功能的朋友参考,也欢迎跟我分享你的应用方式。

tldraw computer – 画张流程图轻松打造 AI 自动化任务实测指南

你是否因为不会写程序,总觉得无法打造自己的自动化工作流程?每次设置 AI 工具都需要大量手动操作,效率难以提升?试试看一个实验性的新工具:「tldraw computer」,通过直觉的流程图设计,就能将繁琐 AI 指令与工作流程视觉化,打造高效率的 AI 自动化系统!

一开始使用 AI 〔指得是 ChatGPT、 Google Gemini 这类工具〕,我们可能会问:「生成一个某某主题的报告。」但当继续深入使用,真的把 AI 当作工作辅助工具,就会发现这样简单的提问是不行的,我们需要把任务「切割成」不同步骤,一个阶段一个阶段让 AI 处理,然后通过反问讨论,整合出最终更好的内容。

这时候,我们要请 AI 生成报告草稿,可能会先请 AI 设置 TA、痛点,再请 AI 做资料研究、摘要,然后请 AI 根据资料思考出更好的报告论述逻辑,然后才请 AI 根据这样的逻辑与资料,最后总结出一个更深入的报告大纲。

那么,如果上述的操作流程,可以用「视觉化」的流程图规划出来,然后 AI 就会自动跑完所有流程,生出我们需要的成果呢?这就是今天分享的这个最新 AI 工具:「tldraw computer」所具备的独特功能。

「 tldraw 」是很知名且好用的在线流程图工具,不过她们最新推出的「 tldraw computer 」AI 功能,不是要帮我们画流程图,而是让我们用简单好上手的流程图,规划出自己想要的 AI 自动化工作流程,打造一个可以根据更复杂逻辑生成报告、文章、设计图、声音文件的 AI 自动化助手。

「tldraw computer」内核特色:

「tldraw computer」用途:

我们先来看看「tldraw computer」这个工具可以完成什么样的应用案例,分享一个简单版实例:我自己常常会需要把拍照扫描的纸张图片,转换成一个有效的文字内容,就利用这个工具来建立一个快速扫描与修正文字的 AI 工具。

我可以在「tldraw computer」流程图上设置一个上传图片的卡片框,然后拉一条连接线。接着在一个 AI 的指令框框里,输入我希望用什么样的逻辑来识别图片并修饰文字。然后接下来我再拉一条连接线,设置一个输出的文字框,让 AI 可以把完成的结果输出到这里。

而在使用的时候,我就只要在「第一步:上传图片的卡片框」把图片上传,按下右上方的播放启动按钮。这时候,这个工具就会自动跑流程图上的步骤,把扫描出来的文字转换成我需要的内容。

「tldraw computer」目前使用的 AI 模型是 Gemini,看起来无论是中文的文字还是手写字,都能够非常有效的识别完成。

![]()

接下来我们来看一个比较进阶复杂的应用案例。我想让 AI 帮我写一篇文章的草稿,但是就像前面提到的,直接让它撰写通常不会有很好的结果。

所以我利用「tldraw computer」工具画出一个文章产出的工作流程图。在流程图的一开始,我利用两张绿色的卡片,让我可以自己简单的设置这篇文章要解决什么 TA 问题,以及这篇文章想要采用什么方法论来解决问题。

接着,我开始用「tldraw computer」流程图展开我希望 AI 一步一步处理的自动化步骤。

首先,我利用红色的卡片设计 AI 处理的指令,请 AI 根据我的 TA 问题,写出一段有效的痛点描述。接着再请 AI 利用我想要介绍的方法论,写出一段这个方法论的重点思维基本背景的介绍文字。

但是,这样还不够。我继续往下画流程图。我让 AI 根据他自己输出的 TA 痛点以及方法论的重点,重新思考,拟出文章最好的架构。这个架构需要具体,有操作步骤,而且每个方法、每个步骤都要尽量有深入的诠释。

然后接下来,我让 AI 一步一步的把这篇文章往下扩展,有了文章的架构之后,我再请 AI 从这个架构出发,让这篇文章有一个完整的故事开场,有方法论重点,也有具体操作步骤,把前面的内容做一个有效的并且延伸插件的整合。

最后,我再画出下一步的 AI 流程图。我请 AI 用惯用的语言,用口语更亲切的方式来润饰改写它产出的文稿,输出一个解决痛点、介绍方法的一篇中文文章草稿。

甚至我可以再继续往下拉出下一步的流程图,放上一张声音的输出卡片,让 AI 把这篇文章的草稿转换成一个精简扼要的介绍音频文件。

有兴趣的朋友,可以看看我完成的这个 AI 自动化的工作流程图,看看上面的内容:https://computer.tldraw.com/t/szQY1iuGZCHAEmwzFASShH〔网址可以查看生成结果,如果要试用这个 AI 自动化流程工具,需要注册一免费账号。〕

当我有了这样的一个自动化的工作流程图,以后我只要每次回头修改一开始的两张绿色卡片,后面 AI 就会像刚才一样,自动跑完我已经设计好的工作流程,一步一步的去设计结构,推演文章进行润饰,甚至最后产出声音文件。我可以立刻获得最后输出的文章草稿以及声音文件的结果。

![]()

看完两个具体案例,最后我来分享「tldraw computer」如何操作?

先注册一个免费账号,建立一个 AI 自动化工作流程〔图〕的项目。

A computer by tldraw.

建立 AI 流程的基本逻辑是:输入、〔AI〕处理、〔AI〕输出。

掌握上面这个逻辑,你就能快速设计出一个有效的 AI 自动化工作流程。

首先,我们要设置「输入」内容的填写框,这是 AI 工作流程的起点,就像是要告诉 AI 目标、结果、资料的意思。

在「tldraw computer」中,利用 Text 或 Image 等卡片,可以设置输入文字、上传图片的填写框,作为启动流程的起点。

![]()

接着,我们要告诉「tldraw computer」如果去处理输入的内容,这时候从输入内容的卡片,画出连接线,连接到「Instruction」这个卡片上,然后在「Instruction」中说明希望 AI 如何处理内容的指令。

「tldraw computer」会根据我们简单的指令,自己做优化,让 AI 处理内容的结果更好。

![]()

然后,我们继续从「Instruction」卡片画出连接线,这时候可以连到 Text、Image、Speech、Website 等卡片,代表要让 AI 处理后,输出什么格式的内容。

![]()

重复上面:输入、处理、输出,三阶段流程,我们就可以串联出一个更复杂的 AI 自动化工作流程。

通过流程图的规划方式,我可以继续推进下一步的 AI 处理流程,甚至利用连接线把不同段落的内容连接到需要的步骤上,建立我自己需要的工作步骤。

![]()

最后,「tldraw computer」也提供了一些辅助功能,让设计这样的流程图更简单。

例如有一个启动按钮,让我们到时候只要按下启动,后面的 AI 流程就会自动跑完。

或是像流程图一样可以设置大小颜色,这样帮助我们分辨流程图中不同的卡片类型。

![]()

「 tldraw computer 」还有不少高级功能,有兴趣的朋友可以进一步玩玩看。

整体来说,「tldraw computer」是一个强大且易上手的自动化工具,让我们能够轻松打造自己的 AI 流程,推荐大家试试看。

BlinkShot – 开源免费 AI 图片快速生成工具

BlinkShot 是一个以 AI 人工智能技术即时生成图片的免费服务,这是开源项目,背后使用 AI 加速云服务「Together AI」和图片生成模型 FLUX,这项服务特性是能在非常短的时间内依照输入的提示词生成各种图片,以毫秒为单位,生成的图片也丝毫不逊色,有兴趣的朋友可以玩玩看。

目前 BlinkShot 支持英文提示词,也可以直接叫 AI 服务帮你生成〔例如用 ChatGPT 或其他同类型服务〕,另一个方法是使用图片转文字 AI 工具,例如:Image to Prompt等工具,将喜欢的图片快速转换为英文提示词,最后稍作修改再生成想要的图片。

BlinkShot 目前没有使用的生成数量限制,还有个「Together API Key」栏位可自定义自己的 API 密钥,生成的图片素材皆可免费下载使用,AI 图片基本上也不会受到版权限制,使用于个人或商业用途都没问题。

Generate images with AI in a milliseconds

进入 BlinkShot 后直接输入提示词就会立即生成图片,整体速度非常快,过程中如果继续输入其他形容或是提示词,图片会即时更新,相较于其他同类型的 AI 图片生成器来说确实非常强大!

![]()

下方会显示生成的图片历史记录。

通过 BlinkShot 生成的图片看起来很逼真,也能依照用户需求调整成各种风格、样式,越仔细的提示词就能生成更细致准确的结果。

![]()

生成过的图片历史记录会显示于下方,可以随时切换回去查看。

![]()

在图片点击右键即可下载保存。

在图片上点击鼠标右键、选择「另存图片」后将图片保存下来即可使用。

BlinkShot 未来也会加入下载按钮,让用户更方便获取图片。

![]()

OpenAI 王炸 Sora 文转视频正式上线,新功能发布

就在刚刚,OpenAI Sora 正式登场。

本次发布会延续了「短剧」的快节奏风格,全程 20 分钟左右,由 CEO Sam Altman、Sora 负责人 Bill Peebles 等人主持。

![]()

OpenAI 在 X 平台表示,自 2 月份以来,他们一直在构建 Sora Turbo,后者是一个速度明显更快的模型版本,今天也将其作为独立产品向 Plus 和 Pro 用户开放。

有趣的是,由于 Sora 热度太高,大批用户涌入体验网站,导致该网站一度崩溃,停止注册登录。不给力的服务也让 Altman 连连在 X 平台安抚用户:

「由于需求超出预期,我们将不得不间歇性地关闭新用户注册,并且生成内容的速度会在一段时间内减慢。我们正在全力以赴!」

附上体验地址:Sora.com

类似于 Midjourney 的网页界面,Sora 同样拥有自己单独的用户界面,用户用户不仅能够整理和浏览生成的视频,还能查看其他用户的提示和精选内容。

![]()

在 「Library」功能中,用户可以保存自己喜欢或有用的提示词,以便未来使用。并且保存的提示词可以按需查看或修改,对于需要重复创作相似内容的用户,无疑能大大提高效率。

在工作流方面,Sora 的编辑功能是区别于其它竞品的重要亮点。

比如说,在 Remix 功能中,用户可以利用纯自然语言提示词对视频进行编辑,并通过简单的「strength(强度)」选项和滑块来控制生成的变化程度。

![]()

Re-cut 功能则能智能识别最佳画面,并支持向任意方向延伸场景。

![]()

Sora 的 Storyboard(故事板)功能则类似于视频编辑器,可以将多个提示词串联在一起,生成一个更长的视频,轻松处理复杂的多步骤场景。

![]()

搭配 Loop 和 Blend 功能,用户还能创作出无缝循环的视频,并完美融合不同片段,而 Style presets 功能则可以预设和调整生成的风格。

![]()

![]()

在技术规格上,Sora 支持 5-20 秒的视频生成,并兼容 1:1、9:16 等主流宽高比。相比早期版本,现在的生成速度有了显著提升。

![]()

另外,还有几点细节需要注意。

OpenAI 采用了灵活的积分制定价策略,积分数量因分辨率和持续时间而异,如果你早已是 ChatGPT Plus 和 Pro 会员,那就无需额外费用就能使用。

![]()

比如生成一个 480p、5s 的视频就需要 25 个积分,如果生成 480p、20s 的视频则需要 150 个积分。

此外,如果你用 Re-cut、Remix、Blend 或者 Loop 这些功能,生成的作品超过了 5 秒钟,那也得额外扣你的积分,多用多花钱,别超时,超时也花钱。

![]()

对于订阅用户而言,20 美元的 ChatGPT Plus 计划提供 50 个优先视频额度(1000 积分),支持最高 720p 分辨率和 5 秒时长。

而 200 美元的 ChatGPT Pro 计划则提供最多 500 个优先视频(10000 个积分),支持 1080p 分辨率、20 秒时长、5 个并发生成和无水印输出。

![]()

OpenAI 还在为不同类型的用户开发不同的定价模式,将于明年初推出。

对了,Sora 暂不支持 ChatGPT Team、Enterprise 和 Edu 版本,同时也不向 18 岁以下用户开放。现阶段,用户可以在所有 ChatGPT 可用的地方访问 Sora,但英国、瑞士和欧盟等地区除外。

知名博主 Marques Brownlee 提前一周用上了 Sora,并在 YouTube 上分享了他的使用体验。

他指出这款产品仍存在一些局限性。

在物理模拟方面,模型对物体运动的理解还不够深入,常常出现动作不自然、物体突然消失等问题。特别是在处理带有腿部运动的对象时,经常出现前后腿位置混乱的情况,导致动作看起来不自然。

![]()

又或者,某些视频生成结果看起来像是慢动作,而视频的其他部分则以正常速度播放,肉眼很容易察觉这种「别扭」。简言之,Sora 还是没能解决老毛病,缺乏对物理世界规律的理解。

另外,Sora 没能解决文字生成的问题,导致经常出现文字混乱的现象,而剪辑风格、文字滚动条的运动、新闻主播风格的生成则格外逼真。

不过,Sora 也有不少擅长的场景。

![]()

比如说,Sora 在风景镜头处理方面表现出色,能生成媲美专业素材的无人机航拍镜头,在卡通和定格动画风格上的表现也差强人意。

![]()

性能方面,一个 5 秒的 360p 视频通常能在 20 秒内完成生成。

不过,当涉及 1080p 或复杂提示词时,生成时间可能会延长到几分钟,但随着如今大批用户的涌入,生成速度明显慢了大半拍。

![]()

不少网友也在第一时间上手体验了 Sora。比如网友 @bennash 想生成一个视频,渲染了 22 分钟都没能成功,甚至该网站一度停止注册登录。

博主 @nickfloats 给出的评价是,Sora 在将图像转换成视频时,虽然某些特定的视觉特效没有被保留,但整体的转换效果是「清晰和令人满意的」。

Sora system card 也列出了一些值得关注的细节。

OpenAI 官方认为,Sora 为能够理解和模拟现实世界的模型提供了基础,将是实现通用人工智能(AGI)的一项重要里程碑。

官方博客中提到,Sora 是一种扩散模型,它通过从一段看起来像静态噪声的基础视频开始,逐步去除噪声并转变为最终的视频。通过同时处理多个帧,模型成功解决了一个难题:即使目标暂时脱离视野,也能确保其在视频中始终保持一致。

与 GPT 模型类似,Sora 采用了 Transformer 架构。

![]()

Sora 使用 DALL·E 3 中的标注技术,该技术为视觉训练数据生成高度描述性的标签。因此,模型能够更准确地根据用户的文本指令生成视频内容。

除了能够仅通过文本指令生成视频外,Sora 还能够从现有的静态图像生成视频,准确地将图像内容进行动画化,并注重细节。该模型还可以从现有的视频中扩展或填补缺失的帧。

![]()

为了确保安全地部署 Sora,OpenAI 基于 DALL·E 在 ChatGPT 和 API 部署中的安全经验,以及 OpenAI 其他产品(如 ChatGPT)的安全防护措施进行了强化。

所有 Sora 生成的视频都带有 C2PA 元数据,这些元数据能够标识视频的来源是 Sora,从而提高透明度,并可用于验证其来源。

与此前凭借真实人像出圈的 Flux 不同,Sora 们对上传包含人物的内容设定了特别严格的审核标准,目前仅作为试点功能提供给少量早期测试者,并屏蔽含有裸露的内容。

![]()

大半年前,初试啼声的 Sora 赢得互联网一片喝彩。

然而,如果说一年前尚未还能对着一群演示 demo 空喊「现实不存在了」,那么在国内外各类视频模型的轮番洗礼之下,我们早已养刁的胃口很难再被同样的产品打动。

这种态度的转变源于一个简单的事实。

当 AI 要从「勉强可用」进化到「可堪大用」,用户的期待也随之升维,从「能否做到」跃迁至「做得多好」。

好在 Sora 并未在掌声中原地踏步,通过与艺术家的深度合作,他们在工作流程领域做出了显著的改进。Re-cut、Remix、Storyboard 等功能都相当实用。

![]()

甲乙方的存在决定了工作流中的沟通永远是刚需,AI 能做的是让这种沟通更有效率,Sora 的价值不在于它能做什么,而在于让创作者得以抽身于技术细节,真正回归创意的本质。

与此同时,上周引发热议的 200 美元 ChatGPT Pro 订阅计划,如今也有了更合理的价格锚点,该计划同样支持无限制访问 Sora,这种产品协同效应预计也将激发出远超预期的应用场景和商业价值。

放眼当下,用户的真金白银从不作假。

可灵 AI 交出千万级月流水的亮眼成绩单,这片蓝海的潜力已呼之欲出,对于仍在「烧钱」阶段的 OpenAI 来说,Sora 预计会成为继 ChatGPT 之后的另一个下金蛋的母鸡。

当 Sora 从「能用」「好用」,再到「妙用」,或许未来某一天,我们会发现,真正不存在的,不是现实,而是人类创造力的尽头。

本地 LLM 语言大模型入门教程,提升隐私和效率攻略

按:本文原作者为 Chris Wellons,最初于 2024 年 11 月 10 日发表在其个人网站 null program 上,并声明归属公有领域。我们据此制作译文,以便中文读者阅读。

本文在 Hacker News 发表后的相关讨论也非常值得一读,有兴趣的朋友可前往查阅。

过去一个月以来,我一直在研究日新月异的大语言模型(Large Language Models,下称 LLM),尝试一窥其中奥妙。如今,一台树莓派就能运行比初版 ChatGPT(2022 年 11 月版本)还聪明的 LLM,换成一台普通的台式电脑或者笔记本电脑的话,运行更聪明的 AI 也不在话下。除了方便以外,本地化运行的 LLM 隐私有保障、数据不联网、不需要注册、也没有诸多限制。大模型正以前所未有的速度发展,现有的知识可能用不了几个月就过时了。我写这篇文章是为了记录我在上手 LLM 时积累的的实用经验和心得,希望这些必备知识能够帮你少走弯路。不过归根结底我也只是一个 LLM 菜鸟,文章中未必有什么独到之处,而且有些地方我可能也没弄明白。一想到一年之后这篇文章大概率就会成为历史的注脚,激动之余我自然也会有些惶恐。

就让我这个刚入门的菜鸟带你们入个门吧:LLM 是一种基于神经网络的技术;2022 年,人们在训练 LLM 进行「聊天」式对话方面取得了突破性进展,使得用户能够与这些人工智能自然地互动。这些模型不仅可以轻松通过图灵测试,与真人对话几乎无异,还展现出令人惊叹的创造力。如果这是你第一次接触这种大模型,感受到的不安可能一连几天都挥之不去。回想一下上次你买电脑的时候,你大概没想过人可以和机器有来有回地对话吧。

这让我回想起上世纪 90 年代桌面电脑快速革新的时候,新买的电脑刚刚送到家里就感觉已经过时了。而到如今,LLM 的发展速度更是快得出奇,几乎每周都有新变化,所以对于那些一年前发布的信息我基本上看都不看。想要掌握最新的资讯的话,可以关注 Reddit 的 LocalLLaMa 板块,但是这里的帖子个个吹得天花乱坠,所以记得别轻信其中的一面之词。

正是因为曾经经历过服务关闭、变更、或者因为其他原因导致我的服务器实例被停用的情况,我才对厂商绑定格外警惕。换新的服务提供商对我来说并非无法接受,但得让我能继续用下去才行。正因如此,过去几年内我对 LLM 并未抱有太大兴趣,因为那些所谓「封闭」的模型只能作为第三方提供的一项服务而存在,几乎涉及了所有上述的锁定问题,其中就包括模型的静默劣化(silent degradation)。直到某天,我了解到可以将接近顶尖的模型运行在自己的设备上,从而彻底摆脱这些束缚,这才让我改变了对 LLM 的看法。

这篇文章讲的是 LLM 的运行,并不涉及针对模型的微调和训练。而且这篇文章也只涉及文本,并不涉及图像、声音,或者其他任何「多模态」能力,因为就我来说还用不太到这些。

具体而言,想要在你自己的设备上运行 LLM,你需要的是分别是软件和模型。

llama.cpp 令人惊叹,也是我的唯一选择。原因在于,在基本的 CPU 推理这方面,也就是使用 CPU 而不是 GPU 来产生 token 时,llama.cpp 仅需一个 C++ 工具链,不像其他大多数方案那般都需要繁琐的 Python 配置,这点让它在众多可选项中脱颖而出。在 Windows 系统上,只需要一个 5MB 大小的 llama-server.exe 文件,不需要其他运行时依赖(runtime dependency)。更重要的是,由于 EXE 和 GGUF(模型)这两个关键文件都采用内存映射方式加载,所以很有可能即便过了几十年,你也可以在未来某个版本的 Windows 上以同样的方式运行同样的 LLM,且同样不需要额外配置。

我就直说了,我喜欢它是因为官方提供的 Windows 版本编译程序用的是 w64devkit。这些人真的是有点品味的!话虽如此,如果能用 GPU 做推理的话,就别用 CPU 做推理。虽然在台式或笔记本电脑上对 10B1 左右参数的模型的效果还不错,但是速度还是会更慢。我的主要用例并不是使用 w64devkit 构建的,因为我用的是 CUDA 来推理,而这需要用到 MSVC2 工具链。为了好玩,我曾把 llama.cpp 移植到了 Windows XP 上,并且成功在一台 2008 年的笔记本电脑上运行了一个 360M 参数的模型。能够在那台老旧的笔记本上运行这项技术的感觉真的太神奇了,毕竟在那会儿,这项技术的价值恐怕得值个几十亿美元吧。

GPU 推理的瓶颈在于显示内存(VRAM,下称显存)。因为这些模型真的相当大,而为了能够使用更大的模型,处理更长的上下文窗口(context window),对内存的要求也就更高。模型越大就越智能,上下文窗口也就越长,一次性可以处理的信息也就更多。VRAM 不足 8GB 的时候,使用 GPU 推理就不划算了。如果遇到「GPU Poor」的情况,就请用 CPU 来推理,这样的好处一是更简单,二是更容易上手。

llama.cpp 中提供了很多工具,但是本文只重点讲其中的 llama-server。它本质上就是一个 HTTP 服务器(默认端口为 8080),并提供了一个聊天 UI,以及供程序(包括其他用户界面)使用的 API。一个典型的调用命令如下:

上下文大小(context size)是将输入和输出计算在内,一个 LLM 一次可以处理的最大 token 数量。上下文 token 的数量通常在 8K 到 128K 之间,具体取决于模型的 tokenizer3。普通英语文本使用 wc -w 来统计的话,每个词大约 1.6 个 token。如果模型支持较大的上下文,内存可能会先一步告急。此时应该把上下文大小调低一些,比如 --ctx-size $((1<<13))(即 8K 个 token)。

我还没完全理解 flash attention 是做什么的,也不知道为什么 --flash-attn 或者 -fa 不是默认开启的(也许是因为精度较低?),但你无论如何都应该加上它,因为启用它可以减少内存需求,即便会降低精度也值了。

如果服务器成功地启动了,可以尝试访问(http://localhost:8080/)来先试一试。虽然你还是得先有个模型才可以。

Hugging Face(下称 HF)被誉为「LLM 界的 GitHub」,这是因为它提供了卓越的模型托管服务:无论是数 GB 的「小」模型,还是动辄数百 GB 的「大」模型,HF 都免费托管,获得此殊荣可谓实至名归。此外,大多数模型无需注册即可下载(个别例外),也就是说,你随时都可以下载我接下来提到的模型,自己试试。如此慷慨的服务让我十分震撼,以至于连我这种平日精打细算的人也在几天后开通了 Pro 账号。

如果你现在去 HF 逛一逛的话,你可能想问:「这里什么都有,那我到底要选哪个呢?」我一个月也和你有同样的疑问。对于 llama.cpp 来说,搜索 GGUF 即可。虽说 GGUF 并不是模型在创建或存储时的原生格式4,但你只需要找名字里面带有「GGUF」的仓库(repository)的话就好。这些仓库通常都是由更新频繁、助人为乐的第三方「量化器」(quantizer)提供的。

(官方文档里也没有明确解释「GGUF」究竟是什么意思,习惯了就好了。这就是走在技术最前沿的感觉:无论是什么,要么需要费很大劲才能找到,要么干脆就没有。你可能会想把 LLM 运行起来之后问问它,但我很快就会告诉你这样也行不通。至少据我所知,「GGUF」目前没有官方定义(更新:「U」代表「统一」(Unified)),但其他三个字母的含义仍未确定5。)

虽然以 Meta 最强模型命名的 llama.cpp 确实表现不俗,但并非我的最爱。最新版本是 Llama 3.2,但现在6能用在 llama.cpp 上的模型只有只有约 10 亿参数的 1B 和约 30 亿参数的 3B 版本。这两个模型有点太小了,实用性较为有限,而且只要你不是在树莓派上运行,即便用的是 CPU 推理,也可以有更好的选择,比如说 Llama 3.1 8B(如果你有至少 24GB 显存的话你没准还能试试 Llama 3.1 70B)。

搜 Llama 3.1 8B 时你会发现两个版本,其中一个标注了「instruct」,而另一个没有。instruct 表示该模型经过训练,能够依据指令完成任务,也就是用来聊天的,一般来说你要的就是这个。而没有标注的版本是「基础」(base)模型,只能续写文本(从技术上讲,instruct 模型同样也只是文本补全而已,但这个我们稍后会详细讨论)。如果基础模型也能标上「base」就好了,但是因为某些路径依赖问题,通常都不会这样去标注。

在 instruct 模型的「文件」一列中你是找不到 GGUF 文件的,如果你想要下载这些模型,你需要注册一个账号然后同意社区许可。这时我们回到搜索栏,在后面加上 GGUF,找相对应的 GGUF 模型就可以了:例如 bartowski/Meta-Llama-3.1-8B-Instruct-GGUF。bartowski 更新频繁,而且名声在外,这不但是 llama.cpp 专用的格式,而且无需注册即可下载。

你现在可以在「文件」页面里看到许多 GGUF 格式的文件了,这些是同一模型的不同量化版本。原始模型使用的是 bfloat16 张量,但如果只是为了把模型跑起来,我们可以舍弃大部分精度,同时将损失控制在最小。模型确实会变笨一点,懂得少一点;但是这样做可以大幅减少其所需资源。推荐的最多的是用 Q4_K_M 这种 4 位量化的版本,从我个人体验来看,这确实是个不错的选择。一般来说,一个大模型的 4 位量化比一个小模型的 8 位量化效果更好。一旦你把基本概念搞清楚了,就可以尝试不同的量化方式,看看哪种最适合你!

不同的模型在训练时有不同的权衡,所以没有哪个模型是最优的,在 GPU 性能不足时更是如此。我的电脑装了一块 8GB 显存的 RTX 3050 Ti,所以这方面的限制也影响了我对模型的选择。对于大约 10B 参数的模型,运行起来相对轻松;而若是想测试有着 30B 参数的模型的能力的话则稍显力不从心;运行 70B 参数的模型时我就会用第三方托管的方式了。以下我列出的「t/s」数据都是在这个系统上运行 4 位量化模型得到的。

表中省略了模型名字中的 instruct 字样,除非另有说明,否则这些列出的都是 instruct 模型。部分模型,至少在 LLM 能开源的范围内,是真正的开源项目,我已在后面标明了它们的许可证。其余的模型则对使用和分发都有限制。

这是 Mistral AI 和英伟达合作的模型(代号 Nemo),是我用过的最为均衡的 10B 模型,同时也是我的首选。其推理速度从 30 t/s 起步,令人十分舒适。它的强项在于写作和校对,并且在代码审查方面几乎能与 70B 的模型相媲美。虽然该模型训练的上下文长度为 128K,但是根据我的实际使用经验,其有效的上下文长度更接近 16K。

模型名称中「2407」表示它的发布日期是 2024 年 7 月,我个人很支持将日期写入版本号的这种命名方式,这样一来,你就知道这个模型的知识更新日期和技术水平,找起来也方便。如果不是这样做,版本管理就是一团糟。AI 公司搞不懂版本管理,就像开源项目不会起名字一样。

这是由阿里云推出的 Qwen 模型,其在不同规模的表现都超出了我的预期。14B 模型的推理速度从 11 t/s 起步,能力与 Mistral Nemo 相当。如果我的硬件跑得动 72B 模型的话,我可能就会选这个了,但目前我都是通过 Hugging Face 的推理 API 来试用这个模型。Qwen 同样提供了一个 32B 的版本,但是因为我的硬件跑不动,所以我也没花太多时间研究它。

谷歌推出的模型很受欢迎,大概是因为它有趣的特性吧。对我来说,2B 模型很适合快速翻译。和谷歌翻译相比,尽管 LLM 更耗费资源,并且如果遇到了它觉得冒犯的文本就罢工,像是科幻电影一样——但是在 LLM 面前,谷歌翻译就像是老古董了,更不必提 LLM 还可以离线运行。在我的翻译脚本中,我给它一段带有 HTML 标记的文本,并且要求 Gemma 保留标记,它执行得简直完美!9B 模型效果更好但会慢一些,我会选择用它来翻译自己的消息。

微软的特色是使用合成数据训练。而结果是,该模型在测试中表现不错,但在实际应用中效果不如预期。对我来说,它的强项是文档评估。因为它是一个 4B 模型,我曾加载过最多 40K token 的文档,并成功地获取到了准确的摘要和数据列表。

Hugging Face 可不仅仅是托管模型这么简单,就同等体量的模型而言,他们自家的 360M 模型同样异常出色。我那台赛扬处理器、1GB 内存、32 位系统的 2008 年的笔记本电脑也能用,在一些旧款树莓派上也可以跑起来。这个模型有创意、速度快、能沟通、会写诗,适合在资源有限的环境中使用,算是一个有趣的玩具。

这是另外一个 Mistral AI 模型,但其表现稍逊一筹。48B 听起来相当大,但这是一个 Mixture of Experts(MoE)模型,进行推理时只会用到 13B 的参数。这使得它非常适合在至少有 32G 内存的配置上进行 CPU 推理。该模型更像一个数据库,保留了更多的训练输入数据,但它在应用中可能不如预期,其中缘由我们很快就会说明。

又是两个我没法在自己的电脑上运行的模型,所以我会通过远程托管的方式来使用这两个。后者名字里的 Nemotron 代表这个模型经过英伟达的微调。如果我能跑得动 70B 模型的话,可能 Nemotron 就是我的首选了。我还是要花更多时间把它和 Qwen2.5-72B 做对比评估。

这些模型大多数都有特殊编辑过(abliterated)的「去审查」版本,消除操作可以减少模型的拒绝行为,但是也会以模型的性能下降作为代价。拒绝行为是很讨厌的,比如说 Gemma 就不愿意翻译它不喜欢的文字。可能是因为我比较无聊吧,我遇到的拒绝的次数不多,所以我还没必要做出这样的取舍。另外,似乎上下文的长度增长之后,拒绝行为就会变少,感觉有点「既然开始了,那就做到底」的意思。

接下来的一组是专为编程而训练过的「写码用」模型。具体来讲,他们进行了中间填充(fill-in-the-middle,FIM)训练,使得模型可以在现有程序内部插入代码——我稍后会解释这是什么意思。但是依我看来,这些模型不论是在代码审查还是其他指令导向的任务上都没有更出色,实际情况正好相反:FIM 训练是在基础模型上进行的,指令训练是在此基础上进行的,因此指令训练反而与 FIM 不兼容!换句话说,基础模型的 FIM 输出要明显更好,尽管你无法与这些模型进行对话。

我会在后文进行更详细的评估,但在此我想先提一点:即便是目前最顶尖的 LLM 生成的代码,其质量也相当一般。以下排名是基于与其他模型的对比,并不是它们在整体能力上的排名。

这是 DeepSeek 自己命名并推出的模型。推理时它只使用 2B 参数,所以它既和 Gemma 2 的 2B 版本一样快,又像 Mistral Nemo 一样智能,堪称一个完美的平衡。尤其是在代码生成方面,它的表现超越了 30B 的模型,如果我想要鼓捣 FIM 的话,这就是我的首选了。

Qwen Coder 的排名紧随其后。论输出结果的话和 DeepSeek 不分伯仲,但是因为并不是 MoE 模型,所以速度会稍慢些。如果你的内存是瓶颈,那么它就是比 DeepSeek 更好的选择。在写这篇文章的时候,阿里云发布了新的 Qwen2.5-Coder-7B,但是令人迷惑的是,其版本号并没有更新。社区里已经在用 Qwen2.5.1 来称呼这个版本了。刚才我还在说 AI 公司搞不懂版本管理来着……(更新:在发布一天后,14B 和 32B 的 Coder 模型也发布了,我两个都试了,但是都不如 DeepSeek-Coder-V2-Lite,所以我的排名没有变。)

IBM 推出的系列模型名为 Granite。总体来说,Granite 无法令人满意,唯独在 FIM 中表现异常优秀。以我的体验来说,它和 Qwen2.5 7B 并列第二。

我同样也测试了 CodeLlama、CodeGemma、Codestral、StarCoder 这四个模型。这些模型在 FIM 任务上的表现非常差,几乎毫无价值,我想不到任何使用这些模型的理由。指令训练所导致的负面效果在 CodeLlama 上最为明显。

我在前文提过,llama.cpp 是自带 UI 的,其他 LLM 中的 UI 我也用过,我感觉都大差不差。但是我本来就不喜欢 UI,尤其是在生产力环境下,所以我为我自己量身定制了 Illume。这是一个命令行程序,它能将标准输出转换成 API 查询,并在查询过后将响应转换回标准输出。把它集成到任何一个支持拓展的文本编辑器中应该都不成问题,但是我只需要它支持 Vim 就够了。因为 Vimscript 太烂了,估计在我接触过的最烂的编程语言里能排上第二,所以我的目标是尽量少写代码。

创建 Illume 的初衷是为了解决我自己的痛点,为了让我更好地探索 LLM 的世界。我总是会把东西搞崩,然后再去添加新功能来补救,所以稳定性方面我没法保证(大概你还是不要尝试使用它比较好)。

以 ! 开头的行是 Illume 解释后的指令,这样写是因为正常文本中很少有这种写法。在一个缓冲区(buffer)中,!user 和 !assistant 交替进行对话。

这些仍然在文本缓冲区之内,所以在继续对话之前,我可以编辑 assistant 的回复,也可以修改我的原始请求。如果我想要它来创作小说的话,我可以要求它补全(completion)一段文本(而这并不需要指令训练就可以完成):

我可以打断它的回复,进行修改或添加一段自己写的内容,然后让它继续生成;这方面我还得多练练。LLM 也会识别出你添加的注释语法,这样你就可以用注释来引导 LLM 写你想要的内容。

虽然 Illume 主要是为 llama.cpp 设计的,但我也会使用不同 LLM 软件实现的 API 进行查询,且由于各个 API 之间存在不兼容性(例如一个 API 所需的参数被另一个 API 禁止),所以 Illume 的指令需要足够灵活和强大,因此指令可以设置任意的 HTTP 和 JSON 参数。Illume 并不会试图将 API 抽象化,而是会直接呈现出其较低层级的设置,所以要对远程 API 有所了解才能有效地使用它。比如说,与 llama.cpp 进行通信的「配置文件」(Profile)是长这样的:

其中 cache_prompt 是一个 llama.cpp 所特有的 JSON 参数( !: )。大多数情况下启用提示缓存(prompt cache)会更好,但可能是因为某些原因,它默认是没有启用的。其他 API 会拒绝带有此参数的请求,所以我需要将其删除或禁用。Hugging Face 的「配置文件」是这个样子的:

为了兼容 HF,Illume 允许将 JSON 参数插入到 URL 中。因为 HF API 会过于频繁地进行缓存,所以我提供了一个 HTTP 参数( !> )来将其关闭。

llama.cpp 独有一个用于 FIM 的 /infill 端点(endpoint)。该端点需要一个拥有更多元数据并进行过特定训练的模型,但是这种情况比较少见。因此,尽管 Illume 支持使用 /infill ,我还是添加了 FIM 配置,这样在读过该模型的文档,把 Illume 为该模型的行为配置好之后,我可以在任何为 FIM 训练的模型上通过正常补全 API 实现 FIM 补全,甚至是在非 llama.cpp 的 API 上也是如此。

该是讨论 FIM 的时候了。为了彻底弄懂什么是 FIM,我就必须追溯到知识的源头,也就是最原始的讨论 FIM 的论文:Efficient Training of Language Models to Fill in the Middle。这篇论文帮助我理解了这些模型是如何针对 FIM 训练的,至少足够让我也将这种训练方法应用到实际中。即便如此,在模型的文档中关于 FIM 的说明通常也很少,因为它们更希望你去直接运行他们的代码。

从根本上讲,LLM 只能预测下一个 token。所以 FIM 的方法是在大型训练语料库(corpus)中选取一些会在输入中出现的特殊 token,用它们来区隔前缀(prefix)、后缀(suffix),和中段(middle)部分(三者合称 PSM,有时也称「后缀-前缀-中段」,即 SPM)。在之后的推理中,我们可以用这些 token 来提供前缀和后缀,并让模型「推测」出中段内容。听起来很离谱,但这真的很有效!

比如在填补 dist = sqrt(x*x + y*y) 中括号里的内容时:

为了让 LLM 填补括号中的内容,我们在 <MID> 停下,并且让 LLM 从这里开始预测。注意到 <SUF> 起到的效果就好比一个光标。顺带一提,指令训练的方法差不多也是这样,但是在指令训练中,使用特殊标记分隔的是「指令(instructions)」和「对话(conversation)」,而并非前缀和后缀。

有些 LLM 开发者严格按照论文所写,直接使用 <PRE> 等作为 FIM 标记,并不在乎这些标记和模型的其他标记看起来完全是两个样子。更用心的训练者则会使用类似 <|fim_prefix|> 的标记。Illume 支持 FIM 模板,我也为常见的模型编写了相应的模板,例如针对 Qwen (PSM) 的模板如下:

Mistral AI 的习惯则是使用方括号、SPM 格式,并且省略「中段」token:

有了这些模板,我就可以在不被 llama.cpp 的 /infill API 支持的模型中进行 FIM 训练了。

我在使用 FIM 时遇到的第一大问题是无法生成正确的内容,而第二大问题就是 LLM 不知道什么时候该停下。比如在我要求模型填充以下函数时(如给 r 赋值):

(补充一点:静态类型(static types)提示(包括这里的)可以帮助 LLM 更好地生成代码,起到防护栏的作用。)得到这样的结果并不奇怪:

原本的 return r 变成了 norm4 函数的返回值。得到这样的结果固然没问题,但显然这不是我想要的内容。所以当结果开始跑偏的时候,最好做好狂按停止按钮的准备。我推荐的三个 coder 模型较少出现这种情况,而更保险的做法是将其与一个能够理解代码语义的非 LLM 系统结合,这样在 LLM 开始生成超出范围的代码时可以自动停止。这种做法可以让更多 coder 模型变得更实用,但这就不是我折腾的范围了。

对于 FIM 的摸索和实践让我意识到 FIM 仍处在其早期阶段,也几乎没有人用 FIM 来生成代码。或许大家还是在用普通的补全方法?

LLM 好玩归好玩,但是它们能为提高生产力提供什么帮助呢?过去的一个月以来我一直在思考这个问题,但始终没有找到一个令我满意的答案。我们不如先划清一些界限,明确一下有哪些事情是 LLM 无能为力的。

首先,如果结果的准确性无法被轻易验证,那么使用 LLM 就毫无意义。LLM 会产生幻觉(hallucination),这也让它们变得并非绝对可靠。很多时候,如果你能够验证 LLM 的输出是否正确的话,你其实也就没必要用它了。这也就解释了为什么 Mixtral 如此庞大的「数据库」反而没什么用。同时这也说明,把 LLM 输出的结果投放到搜索结果里有多么的危险且不负责任,说难听点就是不道德。

然而即便是那些对 LLM 了如指掌的爱好者们也还是会踩这个坑,并且去传播这些虚构的内容。这使得针对 LLM 的讨论更为不可信,看 LLM 给我提供的信息的时候我得多留几个心眼。举例说:还记得我说过 GGUF 没有一个官方定义吗?你去搜一下就能搜得到一个明显是幻觉的结果,结果它还进了 IBM 的官方文档。我在这儿就不再提了,免得问题变得更严重。

其次,LLM 都是金鱼脑,「过目就忘」。也就是说,较短的上下文长度限制了它们的发挥。虽然有些模型使用了更大的上下文长度来训练,但是其有效上下文长度通常小的多。实际上,一个 LLM 一次只能在它的「大脑」中记住相当于一本书里几章的内容,如果是代码的话则是 2000 到 3000 行(因为代码的 token 密集度更高),一次性能够处理的也就这么多了,这和人类相比简直微不足道。当然也可以通过微调或者使用检索增强生成这类的工具来尝试改善,但是只能说……收效甚微。

第三,LLM 写代码的能力很差。往好了说,它们的写码能力也只不过是一个读过大量文档的本科生的水平。这话听起来还行,但实际上,很多毕业生在进入职场时几乎对软件工程一无所知,第一天上班才是他们的真正学习的开始。从这个角度看,现在的 LLM 甚至还没开始「学习」这一步呢。

但是说实话,LLM 写代码能有如今的水准已经很不错了!即便是把带有我强烈个人风格的代码丢给它,LLM 也能顺利理解并使用其中的自定义接口(但是需要说明的是:我自己的的代码和写作也是大部分 LLM 的训练数据中的一部分)。因此,只要是不超出有效上下文长度的限制,上下文长度越大越好。问题在于训练 LLM 写代码似乎并不比我自己写更省时间。

其实,单纯去写新的代码都算简单的了。困难的地方在于维护代码,以及在考虑到维护代码的同时再去写新的代码。即便 LLM 确实能写出可以运行的代码,也考虑不到维护问题,或者说,它根本没办法去思考这些问题。生成代码的可靠性与代码长度通常成反比平方关系,一次生成十几行代码就已经很不靠谱了。无论我怎么试,LLM 输出的能让我觉得还凑合的代码根本就超不过三行。

代码质量在很大程度上受到编程语言的影响。LLM 在 Python 上表现好过 C 语言;C 语言的表现又好过汇编语言。我觉得这多半取决于语言难度和输入质量:给大模型做训练的 C 语言素材多半都很烂,毕竟烂资源网上一抓一大把;而大模型对汇编语言的唯一了解就是糟糕的新手教程。当要求大模型使用 SDL2 时,它也不出所料地犯了常见的错误,毕竟它就是这样训练出来的嘛。

那训练大模型去写标准化代码(boilerplate)7呢?大概 LLM 在这方面会犯更少的错误,可能还有一定的价值,但处理标准化代码最快的方式其实就是——避免编写它。去简化问题,不去依赖标准化代码就是了。

不必只轻信我一家之言,看看大模型在赚钱方面怎么样就明白了:如果 AI 公司真的能够实现他们所宣传的生产力提升,他们就不会出售 AI 技术,反而会独自利用其技术去吞并整个软件行业。你也可以看看位于 AI 科技最前沿的公司的软件产品,和其他公司的产品一样,是同样的老旧、同样的臃肿、同样的垃圾。(而浏览这些糟糕的网站也是研究 LLM 的环节之一,一想到这里我就感觉很不爽。)

在生成代码时,「幻觉」造成的影响会小一些。因为你在提出需求时就知道自己想要什么,因此可以检查生成结果,同时还有编辑器来帮你检查你漏掉的问题(比如调用了虚构的方法)。然而,有限的上下文和不佳的代码生成仍然是障碍,我至今尚未能有效地解决这些问题。

那么,我可以用 LLM 做什么呢?我们列个表吧,毕竟 LLM 最喜欢列表了:

尽管有用的应用场景不多,但是这已经是近些年来我对新技术最兴奋的一次啦!

Luma AI – 生成式视频 AI 巨头重磅更新,创新的视频创作交互方式

AI 视频,还能往哪个方向卷?Luma AI 的答案有些与众不同。对手还在练一招一式,它却像风清扬传授独孤九剑,讲究灵活变通,如行云流水,任意所之。

Luma AI 或许不如可灵、Runway 知名,但论实力也在第一梯队,它的视频模型叫作 Dream Machine,今年 6 月发布,最近进行了重磅升级,是推出产品以来声势最大的一次。

![]()

其中包括两项更新,一是发布自己的图像模型 Luma Photon,将文字、图像、视频一锅端;二是打造了生成 AI 视频的全新工作流,我们可以像和 ChatGPT 聊天一样,让 AI 生成视频,不用对提示词字斟句酌。

对于生成视频这件事,Dream Machine 首创了一种很新的方式。

Unlock your creativity with Luma AI Video Generator. Turn text into stunning videos with our cutting-edge text-to-video AI.

打开 Dream Machine,我们先看到的是「Board」,可以将它理解为无限的创意画布,在这里,我们使用自然语言,自由地生成图像或者视频。

开始一块 Board,我的提示词写得非常简单:「创建一个日式悬疑少年漫画的角色。」

AI 扩写了我的提示词,一次生成了 4 张图片,但是不行,年代不对。

![]()

没关系,再在对话框输入一句,「放在现代背景」。

![]()

AI 表示懂了,又生成了 4 张图片,右上这张孤身走暗巷,已经接近我想要的感觉了,但仍然不够,我想要他抬起头,露出五官。

不难,继续微调,忘掉复杂的提示词,和 AI 打直球就可以。

![]()

右下这张不错,虽然形象幼态了点。接下来,我想让 AI 生成一个视频,主角在同一条巷子里从白天走到黑夜。

Dream Machine 生成视频的首尾帧功能,就是为这种需求准备的——我们挑好头尾的两张图片,让 AI 补足中间的过程。

![]()

那么,我们只需基于满意的图片,让 AI 生成几张白天场景的,沟通方式还是一样的简单粗暴。最终选定的两张图片,细节略有落差,但同框也不违和。

![]()

万事俱备,只等生成视频,AI 过渡得还算自然。

![]()

看到这里,你应该明白 Dream Machine 和其他视频工具的区别了。

其他视频工具,通常是给你一个填入提示词的文本框,然后让你设置运镜、时长等参数。设置一次,生成一次。

但 Dream Machine 的界面,看起来非常像和聊天机器人交互,底部是输入框,文生图、图生图、图生视频、文生视频,都可以在这里进行。

![]()

专业创作者可以继续写传统的提示词,但我们也拥有了「讲人话」的权利,压力给到 AI,Dream Machine 能够理解上下文,帮我们完善提示词,我们可以从一个非常粗糙的想法开始,和它边聊边改边优化。

又因为 Dream Machine 是无限画布形式的,我们可能在一个环节反复生成,素材都会保留下来,不会互相覆盖。

我们的思维,不会局限在一段提示词、一个视频,而是像水一样流淌,更多的想法,可能就在这个过程里产生了。

Dream Machine 的全新工作流就像大树的主干,其中一些好玩且实用的功能则像枝桠,相得益彰,才能枝繁叶茂。

起到关键作用的,就是 Dream Machine 最新发布的图像模型 Luma Photon。

图片怎么生成得更符合我们的审美?Dream Machine 支持风格参考和角色参考功能。

先说风格参考,我们可以导入自己的图片,AI 会将风格融入到创作中。官方给出了一个例子:按蒙德里安风格,生成小鸟版的《戴珍珠耳环的少女》。

![]()

按这个思路实操一下,基于男性侦探的形象,参考梵高《星月夜》的风格,生成女性侦探。

![]()

二次元遇上后印象派,化学反应很奇妙。

![]()

角色参考功能,则可以通过一张图片,就实现角色的一致性,让这个角色出现在更多的图片和视频里。

![]()

马斯克是行走的素材库,这样的例子太没挑战性了,我决定让甄嬛瞬移到哈利波特的世界,看场景变了之后,她还能不能气场两米八。

![]()

结果有些不好评价,看得出来是甄嬛的面容,但娘娘的长相入乡随俗,五官尤其眼睛,变得更像欧美人了。

![]()

其实,不另外找图片参考,Dream Machine 也可以让图片、视频不泯然于众人,这时候就要用到「头脑风暴」功能,它会根据你生成的图片,推荐一些艺术家的风格。

![]()

就像甄嬛进霍格沃茨这张,我们可以用吉卜力工作室风格二创。

![]()

不仅如此,提示词里的一些关键词,被框选了起来,能用下拉的选项替换,Dream Machine 称之为「概念药丸」,我们不用自己手写提示词,一键更换艺术风格,或者画面元素。

![]()

把「吉卜力」换成「新海诚」,把「独角兽」换成「龙」,不过点击几下的功夫。

![]()

Luma Photon 模型,基于 Luma 的通用 Transformer 架构构建。通过开发自己的图像模型,Luma AI 可以减少对 Midjourney 等外部图像模型的依赖,同时也能解决文生视频不稳定的问题。

当然,视频是老本行,镜头运动这种可控性功能,Dream Machine 也少不了。

![]()

紫禁城的甄嬛,和霍格沃茨的甄嬛,能不能实现丝滑的转场呢?用推拉镜头,画面有动感,人物没有严重的变形,可以打个 80 分。

![]()

巧的是,前两天 Runway 也官宣了自己的图像生成模型 Frame,和 Luma 更新是同一个晚上,看演示就知道非常注重审美,目前正逐步向 Gen-3 Alpha 开放资格。

![]()

▲ Runway Frame

图片的生成质量、美学高度,以及视觉风格的一致性和可控性,越来越被视觉模型重视了。

这对创作者来说是好事,当我们用 AI 进行平面设计、角色设定时,其实就是在生成一个独特的世界,讲一个独特的故事。

Runway 的 CEO Cristóbal Valenzuela 认为,Runway 不是一家 AI 公司,而是一家媒体和娱乐公司,AI 公司的时代已经结束了。

他不是在唱衰 AI,恰恰相反,他认为 AI 是一种基础设施,真正的革命不在于技术本身,而在于它所实现的东西:新的表达形式、讲述故事的新方式、连接人类体验的新方法。这和 Luma 的进化方向不谋而合。

![]()

这次更新之后,Luma AI 首席执行官兼联合创始人 Amit Jain,给 Dream Machine 下了一个很有趣的定义——视觉思维合作伙伴。

概念有些抽象,他的意思其实就是,让生成图片、视频这样的视觉创作,像聊天一样简单、直观。

交互的方式,影响着我们思考的方式。画布式的工作流,能将脑洞可视化,记录所有的创作过程和结果,呈现生成视频的完整思路。

无限画布通常在图像模型较为常见,比如 Recraft 和 Ideogram 的 Canvas。Dream Machine 的画布更加规整,相同提示词生成的素材和变体横向排列,不同的则竖向排列。

![]()

边聊边生成边优化的过程,会让人觉得,一个独立的小世界仿佛在画布里诞生。

先让 Dream Machine 用超写实电影 CG 风格,创造一个工业废土背景游戏的主角。

![]()

然后用环绕镜头,让主角动起来,并塑造环境的空间感。

![]()

接着,我们可以再和 AI 聊,让 AI 继续生成废土世界观里室内室外的各种场景,让 AI 建议我们怎么塑造得更有末日气息。

![]()

![]()

某种程度上,这个画布,就是我们个人故事的设定集。

当然,Luma AI 的 bug 也很多,包括但不限于,用一张图片实现角色一致性,效果并不理想;积分如流水,图片和视频还是要反复抽卡;图片模型可以生成准确的英文,但中文不行……

![]()

但意思传达到位了——少谈参数,以交互为出发点,构建一个 AI 创作工具。

更好的视频模型,不只是有更快的生成速度、更可控的镜头运动、更独特的美学,它应该也提供更好的讲故事的方式,让文字、图像、视频都作为表达想法的工具。

Dream Machine,造梦机器。

![]()

只管去创作吧,如同 Luma AI 的这句话:「不需要写复杂的提示词,问就好了。」未来 AI 留给我们的问题,不再关于技术,而是关于我们用它构建什么。

我用 ChatGPT 和 Midjourney 剪掉了蓄满四年的长发

这是我蓄满了四年的长发,原本是打算捐给金丝带的,但我决定放弃了。

一来,捐赠的人太多了,不缺我这一个,它不需要我;

二是,这个活动太热门了,报不上名,我不喜欢凑热闹;

于是,我心里很快就决定了:剪掉,并且要烫卷、染发!

在音乐教室里,筱烨、阿吉和秋秋在上课,我就在旁边用 ChatGPT 写 Prompt,写完之后就丢给 Midjourney 去生成效果图。遇到不满意的,就丢两张我以前的半长发的照片上去,再调整 Prompt 的细节,接着画。

最后,我把这张效果图发给发型师:

虽然这脸型偏硬了,不怎么像我,但这个头发感觉是我想要的。

曲线、松软、紫色挂耳

确定方案之后就直接约时间,一方面要约发型师的时间,他很好约,就在楼下,我随时过去随时可以做;但另一方面,要约收头发的师傅过来,需要由他根据长度把我的头发抽出来。这也是我第一次卖头发,挺新鲜的体验。

首先,我要跟发型师和收头发的师傅一起商量,怎么剪、剪多少、剪到哪里、用什么方法剪。我原本以为就是咔嚓一刀剪了,但其实不是。整个过程里,这位师傅需要非常仔细地把我头发中最长的部份找出来,每次只挑选一小撮,然后用剃刀在距离头皮大约 8-10cm 的位置一点点把头发切断。这样做的目的是,即确保剪下来的头发是满足他收头发的需求,也能确保给发型师留有后续足够的操作空间,还得让头发之间的层次能自然地衔接上。

每次剪下一小撮头发后,他都会仔仔细细地把头发梳几遍,确保没有任何打结,然后放在准备好的毛巾上,平放着。剪之前还特意要把周围的风扇都关掉,万一吹乱了,这些头发都全都没用了。他就这么一遍一遍地重复捏一小撮、切下来、梳顺、平放,如此反复了半个多小时,才终于从我头上抽出来两把共 59g 的长发。

然后就是烫卷和染发。

之所以想这样折腾一下,多少有一点破罐子破摔的心态在,觉得既然这头长发不被需要了,那也就放过自己,不要再被「这件事」困住了,索性趁着这个机会来尝试一下之前没折腾过的事情!

其实我 17 年前也染过一次发,但那时候是因为演《暗恋桃花源》的老导演,为了贴近角色的年龄感,我就去染了一头白发。只不过那个白发染得不成功,黄黄的,加上那会儿我比较消瘦,自己觉得不好看,所以演出结束的第二天我就去剃光头了。所以那次严格来说我不觉得是一次正经的染发体验,毕竟没有顶着这头黄毛生活,勉强能算一次临时的体验。

我当然知道它会掉色,会变成黄毛,会干、会毛躁。

但这不重要,因为我就想试一试。

我紧绷了三十多年,现在崩断了,还不能讨好一下自己,玩一玩吗?玩!

不仅要玩,还要玩得不一样,用 AI 一起玩!

为什么是紫色?因为我喜欢!

虽然我也喜欢绿色,但我也不想染成绿色 ![]()

朋友说像杨千嬅,像极速拍档的小乔,那也挺好。

最近两周我忽然意识到,我是会因为自己感觉到快乐而感到羞耻的。这是从小根深蒂固的想法。过去我知道,如果我遇到一件好事,一件开心的事,就会有一个声音在警告自己不要乐,不要得意,不要喜形于色,要收起来,不然马上就会招来不幸和倒霉。但我一直认为这是克制和谨慎,是对于能量守恒定律的迷信式的执念,觉得这会儿开心了以后就没有了。

可是,为什么要把开心攒到以后呢?有没有以后都不知道。

筱烨说我的动力来自恐惧,确实,我总有各种恐惧在周围,挥之不去。

但现在我看见它了!我要让我的快乐活过来!我不要快乐羞耻!

尽管我现在还没有什么活力,但起码这个紫色能令我舒服好一阵子!

最后再看一眼,这头蓄了四年的长发和发髻。

我很喜欢这根石纹簪,但我感觉我应该不会再束成这个样子了。

这天色真好。

ChatGPT on macOS客户端app正式面向所有用户开放

OpenAI宣布了适用于 macOS 的 ChatGPT 客户端app正式面向所有用户开放。该应用专为 macOS 系统设计,支持快捷键呼出和多种内容形式的交互。目前仅适用于配备 Apple Silicon(M1 或更高版本)的 macOS 14+,但计划在今年晚些时候登陆 Windows。

ChatGPT on macOS客户端app正式面向所有用户开放

如何使用 Proxifier 来进行流量代理控制

Proxifier 是一款网络工具软件,可以帮助用户通过代理服务器进行网络访问,实现匿名化、翻墙、加速等功能。支持多种代理协议,规则管理,流量监控和日志记录等功能,提高网络连接的灵活性和智能化。注意 Proxifier 本身并不是一个代理软件,也不是一个 VPN 软件,其作用是控制其他其他软件访问代理的方式。

上一篇文章我提到了可以试用 Proxifier 来解决通过 Shadowsocks 代理访问呢 ChatGPT 频繁出现 Something Went Wrong 的问题,在本文中我们来展开讲一下具体的做法。

1 准备工作

1.1 软件下载

Proxifier 的官方网站是 https://www.proxifier.com/,其正版价格较贵,约 40 美元。不过,较早的 2.x 版本存在破解版。读者可以根据自己的经济状况来选择。

![]()

1.2 代理准备

如同开头提到,Proxifer 本身不是一个代理程序,读者应该自己提前准备好代理。这些代理中,无论是 Shadowsocks、V2Ray 还是其他常见的代理程序,都会在客户端本地重建一个 Socks5 代理,这一般都可以在代理客户端程序的配置或者服务器设置中看到。下图给出的是 Shadowsocks-NG 客户端在 macOS 中的系统配置,可以看到程序在本地 (localhost) 的 1086 端口创建了一个 Socks5 代理。

![]()

这个代理会被进一步转成 http 代理,从而被浏览器使用,这个转换过程是导致 ChatGPT 链接不稳定的元凶。接下来我们要使用 Proxifier 让 ChatGPT 直接使用 Socks5 代理。

2 设置 Proxifier

2.1 添加代理

我们以知乎上这篇文章为范本简要讲一下设置过程。首先我们需要将现有代理软件提供的 Socks5 服务告知 Proxifier,这通过添加代理服务器实现。

![]()

![]()

![]()

注意一般各种代理软件在本地创建的代理都是无需验证的,我们可以取消验证启用。输入设置之后,可以点击检查确认设置是否正确。

![]()

3 设置规则

为了让 ChatGPT 的访问能够通过 Proxifier 访问代理,我们需要配置 Proxifier 的代理规则。

![]()

添加代理规则的页面如下:

![]()

我们有两种方法引导 ChatGPT 的网络访问:

- 我们可以选择下载 ChatGPT Desktop 客户端,然后通过代理规则中应用程序过滤规则找到 ChatGPT 程序,然后让目标主机为空(这意味着所有的目标主机都会服从本规则);

- 将应用程序部分置空,然后在目标主机中填入 ChatGPT 访问的域名。经过我的试验发现,填入

chat.openai.com; challenges.cloudflare.com; *.openai.com;即可。

事实上,因为 Proxifier 能够全局性地处理所有网络访问,因此,第二种方法对于使用 ChatGPT Desktop 的用户来说同样有效。下图是完整代理规则。

![]()

至此我们就完成了设置,你可能需要重启浏览器才能能让 Proxifier 成功地引导 ChatGPT 的流量。

使用 Shadowsocks 访问 ChatGPT 频繁出现 Something Went Wrong 问题的解决方法

update at 2023.4.27:

Github 上有人做了一个开源的油猴脚本 KeepChatGPT 可以解决这个问题。在浏览器上这个脚本可以正常使用,但是注入到客户端时(尽管内部仍然是一个浏览器)会出现错误。

update at 2023.4.12:

在 Windows 上这套方法存在一定的问题。可能的原因是 Proxifier 的代理权限有时候会被 Shadowsocks 客户端,也就是 Privoxy 争抢。

由于国情原因我们使用使用 ChatGPT 需要使用各种形式的代理,这时我们肯能会发现在与 ChatGPT 对话的过程中可能会出现下面的错误:

这种错误一般在我们再让网页空闲一段时间(通常是一分钟)后再次提问时出现。当然,去 OpenAI 的帮助中心是不会搜到什么有用的信息的。如果你去检索这个问题,你能得到的最好答案是在出现这个页面之后刷新页面,然后回到对话窗口继续对话即可。但是刷新后如果再次出现空闲窗口的情况,这个问题会反复出现,因此你在对话中就不得不反复地刷新页面,再加上每次页面重载你都需要去勾选 Cloudflare 的机器人验证框,这就会极大程度上拖慢我们的速度,影响产品体验。

这个问题是否可能是由于我翻墙访问导致的呢?我使用的翻墙软件是 Shadowsocks,经过一番搜索,一个 Github Issue 的讨论给了我灵感。

尽管讨论的题目和 ChatGPT 没有直接关系,但是这个回复提到,Shadowsocks 在构建代理管道时,会在客户端使用 Privoxy 来讲 Socks5 代理转换成 http 代理,进而被浏览器使用。Privoxy 的配置中包含了 Socket 连接时长方面的控制。于是我查看了我本地的 Shadowsocks 使用的 Privoxy 的配置文件,这个文件在 MacOS 中位于 /Users/lena/Library/Application Support/ShadowsocksX-NG/privoxy.config 文件。

1 | toggle 1 |

可以看到 keep-alive-timeout 和 socket-timeout 这两个选项设定的超时时间都比较低。我做了下面两个尝试:

- 将这两个设置调高,并重启 Shadowsocks,但随后发现 Privoxy 重置了设置文件;

- 我手动 kill 掉正在运行的 Privoxy 并且手动使用更新后的 config 文件调起一个新的进程,但是仍然没有解决 Something went wrong 的问题;

至此,我也不想和 Privoxy 纠缠下去,既然问题出在 Socks5 代理转 Http 代理的环节,我们可以使用 Proxifier 这个软件直接使用 Shadowsocks 提供的 Socks5 代理,就可以很好地解决这个问题。

Proxifier 的教程网上非常多,我就不在这篇文章里赘述了。

Proxifier 的使用参加我的文章:如何使用 Proxifier 来进行流量代理控制

分享一个Telegram上的免费ChatGPT bot