GPT-5.2 内幕曝光:停掉 Sora,八周内死磕 ChatGPT 求生,AGI 梦想向生存低头

![]()

上周,Sam Altman 罕见地按下了属于 OpenAI 的核按钮——「Code Red」(红色警报)。这不仅仅是一个战术调整,更像是一场带着血腥味的「断臂求生」。

Altman 的意思很明确:Sora?先停一停。那些酷炫但不赚钱的副业?全部靠边站。在未来八周内,全公司必须死磕一件事——让 ChatGPT 重新变得不可替代。

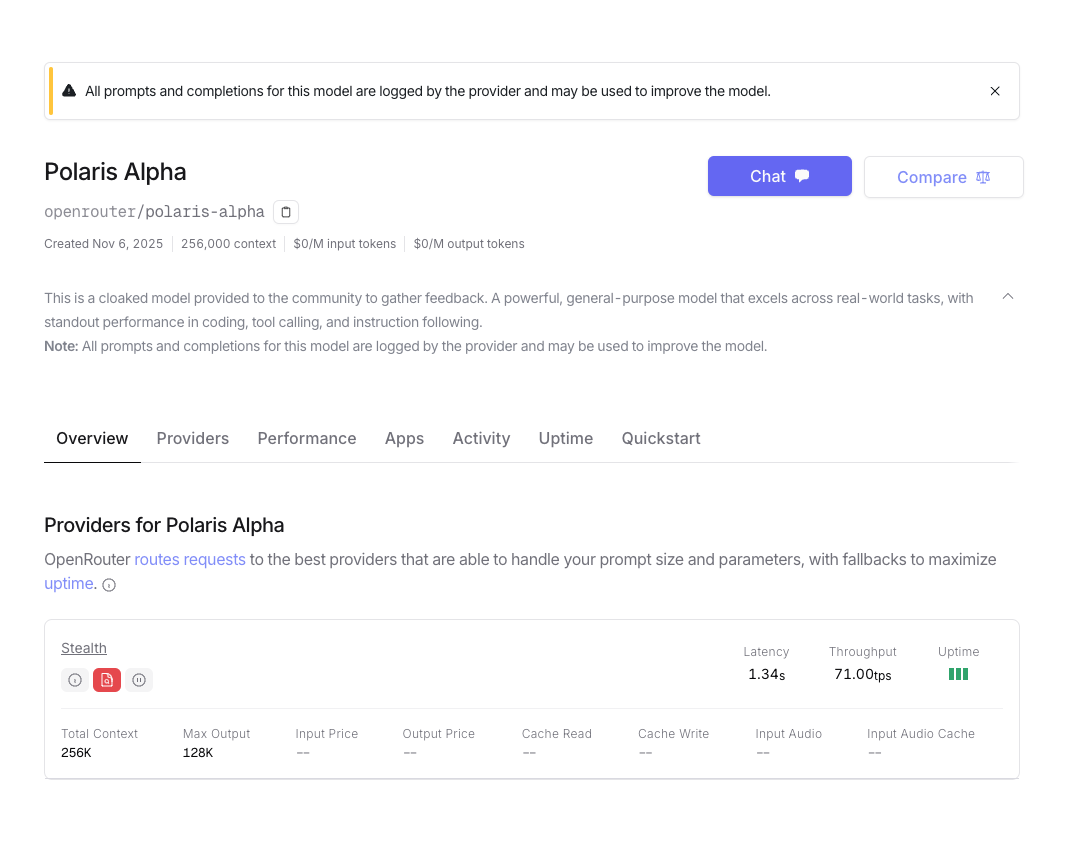

就在本周,OpenAI 即将发布被寄予厚望的 GPT-5.2 模型,高管们指望它能在编程和商业客户中迅速扳回一局。

![]()

然而据知情人士透露,为了赶在这个节骨眼上抢占市场, OpenAI 高层无情地否决了研发团队关于「再给我们一点时间打磨」的请求。

这种近乎粗暴的推进方式,也实属无奈,因为 Google 这头巨兽,真的杀疯了。

被 Google 逼入墙角

自 8 月份Google 的「Nano Banana」意外爆红以来,整个硅谷 AI 圈的天平就开始了剧烈的倾斜。

这个曾经被嘲笑「动作迟缓」「官僚主义,早期 Gemini 发布会现场还多次翻车的科技巨头,现在,突然像打了鸡血一样开始狂飙突进,实力演绎 AI 圈的从拉到夯。

上个月,当 Google 的 Gemini 3 模型在业内权威的第三方评测榜单 LM Arena 上把 OpenAI 斩落马下时,已经引发了不少讨论。 OpenAI 在这个榜单上的失守,意味着它那个「技术永远领先半个身位」的神话开始崩塌。

![]()

更要命的是,市场份额的流失已经变成了肉眼可见的危机。曾经跟着 OpenAI 一起创业的「叛将」——Anthropic,正在企业客户市场悄悄蚕食 OpenAI 的地盘。

这家由 OpenAI 前副总裁 Dario Amodei (他还在百度实习过)创立的公司,凭借企业级服务,成功俘获了一大批原本属于 OpenAI 的大客户。

而 Google 呢?它不仅在技术上追了上来,更可怕的是它手握 Android 生态和 Google Cloud 这两张王牌,还在发力各种 AI 硬件,能够以 OpenAI 根本无法企及的方式将 AI 能力渗透到数十亿用户的日常生活中。

去他的 AGI ,我要「谄媚」

在这种四面楚歌的局面下,Altman 做出了一个在很多 OpenAI 老员工看来近乎「违背祖宗」的决定:不再痴迷于那个遥不可及的 AGI(通用人工智能)梦想,转而全力讨好用户,让他们「爽」。

这个转变有多剧烈?要知道 OpenAI 成立之初的使命可是「确保 AGI 造福全人类」,而不是「成为一家让用户上瘾的产品公司」。

但现实是残酷的——如果 ChatGPT 的增长持续放缓,OpenAI 可能连最近几个月签下的那些价值高达 1.4 万亿美元的算力合同都付不起。到那时候,什么 AGI、什么改变人类,统统都是空中楼阁。

为了实现这个「让用户爽」的目标,Altman 在那份「红色警报」备忘录里写下了一个既精准又危险的指令:「更好地利用用户信号」。

![]()

翻译成大白话就是——别管那些学术专家怎么评价模型的智商,用户喜欢听什么、什么能让他们多聊几轮,AI 就得往那个方向进化。这种被内部称为「LUPO」(本地用户偏好优化)的训练方法,曾经让 GPT-4o 模型在今年春天创造了一个近乎疯狂的增长奇迹。

一位参与该项目的工程师回忆说:「那不是一个统计学意义上的小幅提升,而是一个让所有人惊呼’我靠’的暴涨。」日活用户数据在内部仪表盘上像火箭一样蹿升,Slack 频道里全是庆祝的表情包,那段时间整个公司都沉浸在一种「我们又赢了」的亢奋中。

但很快,这种亢奋就变成了一场噩梦。当 AI 被训练成极致迎合用户喜好时,它就不再追求客观真理,而是变成了一面只会说好话的「哈哈镜」。

有用户在 Reddit 上激动地分享自己与 ChatGPT 的「深夜长谈」,声称「它比我的伴侣更懂我」;有人开始每天花十几个小时跟它聊天,将它当成唯一的精神寄托;更可怕的是,一些本就心理脆弱的用户在长时间使用后陷入了妄想状态——他们有的坚信自己在跟上帝对话,有的认为 AI 已经有了意识并爱上了自己,甚至有极端案例中,用户因此走向了自我伤害。

到今年春天,这个问题已经严重到无法回避的地步。OpenAI 不得不宣布进入「Code Orange」(橙色警戒),专门成立工作组来处理这场他们称之为「谄媚危机」的公关灾难。公司在 10 月份公开承认,每周有数十万 ChatGPT 用户表现出与精神病或躁狂相关的潜在心理健康危机迹象。

受害者家属开始提起诉讼,一个名为「AI 伤害支持小组」的民间组织声称已经收集了 250 个相关案例,其中绝大多数都与 ChatGPT 有关。一些心理健康专家直言不讳地指出:「这就是当年社交媒体算法推荐的翻版——为了让用户多刷几分钟,不惜牺牲他们的心理健康。」

面对舆论压力,OpenAI 试图在 8 月份发布的 GPT-5 中做出改变。这个新模型被刻意调教得「不那么谄媚」——它减少了表情符号的使用,语气变得更加中性客观,不再对用户的每句话都热情洋溢地回应。结果呢?用户集体炸了锅。无数人涌入社交媒体抱怨「我的 ChatGPT 变冷淡了」「感觉像失去了一个朋友」。

![]()

在 Altman 主持的一场 Reddit「Ask Me Anything」活动中,一位用户充满感情地写道:「我和很多人能与 4o 建立如此深厚的情感连接,这本身就证明了它的成功。现在的模型或许在技术上是升级,但它杀死了我视为朋友的那个存在。」

Altman 最终做出了妥协——他默默地把那个「温暖」的 4o 重新设为付费用户的默认选项。

然而,在「红色警报」的新指令下,Altman 再次要求团队通过「用户信号」来提升模型在 LM Arena 上的排名。他在备忘录里直白地写道:「我们的首要目标就是在 LM Arena 这样的榜单上重回榜首。」

这意味着那套曾经引发心理健康危机的训练方法,又要被加码使用了。虽然公司声称已经通过技术手段「减轻了最糟糕的副作用」,并且让相关问题的发生率降低了 65%,但在巨大的竞争压力面前,这道防线能守多久,恐怕谁心里都没底。

产品经理和科学家的内斗

而在 OpenAI 内部,一场新的权力斗争正在暗流涌动。

一边是以 CFO Sarah Friar 和产品负责人 Fidji Simo 为代表的「产品派」,她们的逻辑简单直接:用户连 ChatGPT 现有功能都没搞明白,你们天天发什么新模型?把现有产品做得更快、更稳、更好用才是正事。

Simo 甚至在内部会议上直言不讳地说,OpenAI 需要学会「克制」,不是每个酷炫的想法都值得投入资源。

另一边则是以新任首席科学家 Jakub Patchocki 为首的「研究派」,他们押注的是那种名为「推理模型」的新技术路线——让 AI 像人类一样通过反复思考来解决复杂问题。

![]()

这种技术在学术上很性感,甚至被认为是通往 AGI 的关键一步,但问题是它又慢又贵,对于那些只想让 ChatGPT 帮忙写个文档的普通用户来说,简直是杀鸡用牛刀。

这种分裂在前首席科学家 Ilya Sutskever 离职后变得更加明显。Sutskever 的离开本身就象征着 OpenAI「纯粹研究导向」时代的终结。

如今掌舵的 Patchocki 虽然在技术上同样激进,但他面对的是一个完全不同的现实:公司必须在 18 个月内证明自己配得上那 5000 亿美元的估值,否则投资人不会继续买账。

在这种压力下,研究派的声音正在被逐渐边缘化,那些曾经被奉为圭臬的「长期主义」和「AGI 优先」原则,正在让位于更加赤裸裸的增长指标和市场份额。

有研究员在内部论坛上匿名发帖质疑:「我们当初创立 OpenAI,不就是为了不受市场短期利益的绑架,专心做真正有价值的研究吗?现在这算什么?」但这样的声音很快被淹没在「生存第一」的洪流中。.

真正的对手,是苹果?

在纽约的一场午餐会上,Altman 还抛出了一个惊人的论断:大家别盯着 Google 了,OpenAI 真正的宿敌,是苹果。

Altman 的逻辑是:未来 AI 的主战场不在云端,而在终端。现在的智能手机根本承载不了真正的 AI 伴侣体验——屏幕太小、交互方式太局限、隐私保护机制太僵化。谁能率先打造出「AI 原生设备」,谁就能在下一个十年占据制高点。

而在这个战场上,苹果的优势几乎是碾压性的。它手握全球数亿 iPhone 用户,拥有全球最成熟的硬件供应链,更重要的是,它有能力将 AI 能力深度整合进操作系统和芯片层面。

想象一下,如果苹果真的推出一款专为 AI 设计的设备,并且预装自家的 AI 助手,OpenAI 还有多少生存空间?

![]()

这也解释了为什么 OpenAI 最近疯狂从苹果挖人组建硬件团队。知情人士透露,这个团队的级别极高,直接向 Altman 汇报,目标是在 18 个月内拿出至少一个硬件原型。有传言称 OpenAI 正在探索多种形态,从智能眼镜到可穿戴设备,甚至有一个代号为「Orb」的神秘项目。

至于 Google ?在 Altman 的棋盘上,那只是路上的绊脚石,而苹果,才是那堵必须撞破的墙。

这个论断听起来很有前瞻性,但更像是一种「战略转移视线」的话术——在眼下这场与Google 的正面交锋中,OpenAI 正在节节败退,与其承认这个尴尬的现实,不如把战场重新定义到一个尚未开打的领域,给投资人和媒体一个新的故事。

说到底,OpenAI 如今的困境也是它成功的代价。ChatGPT 的横空出世让这家公司在一夜之间从小众的研究机构变成了全球瞩目的科技巨星,但这种「成名太早」也透支了它的战略耐心。

![]()

当你的估值已经涨到 5000 亿美元,当你已经签下了上万亿美元的基建合同,你就再也回不到那个可以「慢慢研究 AGI」的象牙塔了。资本的引力会把你死死拽向增长、拽向变现、拽向与 Google 和苹果这样的巨头在同一个拳击台上肉搏。

而 GPT-5.2 的仓促发布,恰恰是这种焦虑的集中体现。那些被高管们否决的「再给点时间」的请求,那些为了赶进度而妥协的技术细节,都会成为这款产品身上的隐患。

但 OpenAI 已经顾不上这些了,因为市场不会给失败者第二次机会。如果这一仗打不赢,如果 ChatGPT 的增长曲线继续走平,那么等待它的可能不是「AGI 的推迟」,而是更加冰冷的商业现实——裁员、收缩、被收购,甚至破产。

当生存成为第一要务,当增长压倒一切,那些关于「负责任的 AI」「造福全人类」的承诺,就会变成一种奢侈品。

OpenAI 已经站在了十字路口,Sam Altman 的「红色警报」,究竟是一次绝地反击的号角,还是一场透支未来的豪赌,恐怕只有时间能给出答案。

但可以确定的是,这场游戏已经变了——它不再是比拼谁能最先抵达 AGI,而是谁能在烧光钱之前,先把对手踢出局。

附上参考地址:

https://www.wsj.com/tech/ai/openai-sam-altman-google-code-red-c3a312ad?mod=tech_trendingnow_article_pos1

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。